数据挖掘-Logistic模型探讨

浅谈Logistic回归

在经典的线性回归基础上,我们知道,经典的线性回归是解决因变量是连续的变量的问题。而在现实生活中,因变量是离散变量更为常见一些。为了解决因变量是离散的问题,即分类问题,线性回归模型进行调整,得到了经典的logistic回归模型,这个模型可以很好的解释各个特征是如何影响因变量的,并且该模型的预测能力较强,可以较好的解决许多分类问题。

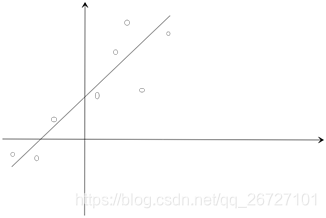

经典的线性回归的本质上,是想通过一条直线或一个超平面来表示特征与因变量之间的关系,类似的含义如下图,点代表数据真实值,直线代表模型。

而对于logistic回归而言,其本质也是通过一条直线或一个超平面来表示特征与因变量之间的关联,但因变量不是分类变量,而是由概率的函数即对数比率来进行表示的,这个在上一篇博文已经讲述过,此处不再赘述。

当遇到更为普遍的多分类问题时,使用logistic模型时,其处理步骤比传统的二分类logistic模型要多了一步分解步骤。即需要将某一种类别作为基准正例,另外其他的类别作为反例。

举个例子,现在需要识别猫、狗、鸡、鸭四种动物。我们使用logistic模型来进行训练。

(1) 首先将猫视为正例“1”,其他三种动物视为反例“0”,训练得到一个函数记作G1(x)

(2) 再将狗视为正例“1”,其他三种动物视为反例“0”,训练得到一个函数记作G2(x)

(3) 然后将鸡视为正例“1”,其他三种动物视为反例“0”,训练得到一个函数记作G3(x)

(4) 最后将鸭视为正例“1”,其他三种动物视为反例“0”,训练得到一个函数记作G4(x)

训练出上述四个函数后,将新的预测数据代入训练好的logistic模型,得到一个包含了四个元素的列向量,对该列向量进行判断,通过比较列向量元素是否超过阈值0.5,将超过的那个元素对应的类标记为预测的类;如果有多个元素都超过了阈值0.5,那么将选择最大的元素对于的类标记为预测的类。延续上一个例子,具体预测值如下:

当某个预测值为[0.21,0.35,0.47,0.67],那么只有第四个元素超过了0.5,所以认为这个预测值应该归属于第四类,即判断为鸭子。

当某个预测值为[0.11,0.25,0.84,0.59],那么第三个元素和第四个元素都超过了0.5,而第三个元素的值超过了第四个元素的值,所以认为这个预测值应该归属于第三类,即判断为鸡。

综上所述,多分类的logistic回归模型和二分类的logistic回归模型是有区别的,多分类的logistic回归模型是更适用于实际情况的,但是其原理是起源于二分类的经典logistic模型的。所以了解多分类logistic模型的细节和原理是有利于解决现实的分类问题的。而logistic模型本质上是把多分类问题转化为多个二分类问题,而当多个二分类问题之间存在线性不可分的情况下,那么可以使用基于核技巧的支持向量机来进行处理。