神经网络学习-初探BP神经网络

理解BP神经网络

众所周知,从上世纪80年代开始,有关神经网络的研究就早已开始。而BP神经网络作为经典的神经网络代表,是经常被各个领域的学科所使用的,比如预测股票、预测房价等。BP神经网络其实应该被称之为反向传播神经网络,由于最初在神经网络出现的时候,预测效果较为一般,神经网络本身无法受实际预测情况进行调整,所以出现了反向传播的思路。反向传播指的是当通过神经网络的预测值和真实值存在差异时,需要把这个差异回传到神经网络的各层神经元中,以便于后续的参数调整和优化。

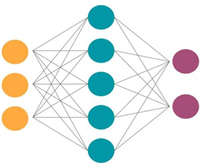

首先我们来看下神经网络的基本结构,即在直观上分为输入层、隐藏层、输出层。下图中左边黄色的可以看作输入层、中间深绿色的可以看作隐藏层、右边浅紫色的可以看作输出层。输入层是数据的输入,即特征或者影响因素;输出层是因变量,也是使用者需要研究的对象;而中间的隐藏层则是需要训练的参数。

从本质上来说,神经网络就是一个黑盒,使用者无法知道具体是什么因素影响了最终的结果,也不知道哪个因素更为显著或者更加重要。因为所谓的影响因素、特征只是使用者自己主观认为的因素,可能会有没有发现、没有被观测、无法测量的因素潜藏。神经网络本身里的隐藏层中的每个神经元都可以理解为一个所谓的影响因素,多层隐藏层进行叠加后,最终的预测效果会比一般机器学习模型要准确,但是使用者确实找不到里面的某个神经元代表哪个影响因素。

BP神经网络最核心的思想是,将信息(信号)进行正向传播、而将差异值(误差)进行反向传播。并且通过追求整个神经网络的误差平方和最小,并且使用最速下降法进行参数的快速迭代和优化,不断调整参数和阈值,从而最终生成最优的神经网络,用以进行实际问题的预测。

为什么神经网络会比一般的线性回归预测效果要好呢?由于神经网络有激活函数这个概念,而激活函数会使得神经网络区别于传统的线性回归的模型,通过使用激活函数让模型具有非线性特征,增强模型的拟合能力。为什么有激活函数我们会在后面的文章进行说明,如果没有激活函数的话,其实神经网络只是一个多层的线性回归组合。而正式有了这个激活函数,使得神经网络的预测准确率大大提升。

从本质上来说,BP神经网络只是一种最简单的、经典的神经网络架构。后面的各种神经网络的结构会在这种反向传播神经网络上进行修改和提升,用以处理不同的问题。比如CNN可以处理图像问题、RNN可以处理文本问题、GAN可以用于图像生成。BP神经网络从2013年的深度学习开始兴起后,又被人们想起,并在这上面延伸出各种新的神经网络结构。上个世纪这种理论刚出来的时候,由于计算能力太弱,所以没有被人们所重视。而到了现在的大数据时代,算力有了极大的提升,因此神经网络理论又开始被重新使用和改进。但是神经网络也有自己的优缺点,它本身的预测效果非常好,但是容易过拟合。同时神经网络是一个黑箱,通常使用者很难去进行解释,模型的迁移性也较差。

总的来说,由于神经网络是从人类的神经运作以及神经信息传递而得到启发的,所以本人认为,在未来的AI时代,不同类型的神经网络进行组合,得到的将会一个较为“完整”的机器智能。因此神经网络的学习者必须要了解神经网络的运作原理以及它的特性,从实际问题出发去使用神经网络去解决问题,这样可以理解的更为透彻一些。