主要在此文基础上精简,按自己理解表达下【直观详解】信息熵、交叉熵和相对熵

- 熵,热力学中表征物质状态的参量之一,用符号S表示,其物理意义是体系混乱程度的度量。

- 信息熵,描述信源的不确定度。

信息熵越大,越无序,越随机,信息量(的期望)越大,要消除不确定性所需信息量越大。

考虑把信息量存储下来需要多大空间/存储代价

(用存储空间表示信息熵(不确定性越高所需存储空间越大))

举例:表示天气情况的

P=[p1,p2,p3,p4]

,通常做法表示为[00,01,10,11],共2bit

S=∑i=14(Pi×F(Pi))

F(Pi)

表示存储空间,

Pi

表示事件i的概率,公式表示各个事件需要的存储空间期望和

概率越大,存储空间越小(哈夫曼编码)

F(Pi)=1Pi;F(Pi)=loga(1Pi)

取对数:消除乘除法、约束为正态分布/更稳定

所以,信息熵公式为

H(P)=∑iloga1P(i)=−∑iP(i)logaP(i)

因此,对于不同天气概率时,信息熵如表所示。如Q,信息熵为1.75,需要存储空间1.75/天,与P的2相比,Q可以通过编码节省空间。类似于哈夫曼编码,Q中分别编码为[10,110,0,111],则存储空间为

14∗2+18∗3+12∗1+18∗3=74=1.75

| 天气[阴晴雨雪] |

信息熵 |

|

P=[14,14,14,14]

|

H(P)=2

|

|

Q=[14,18,12,18]

|

H(Q)=1.75

|

|

Z=[18,116,34,116]

|

H(Z)=1.29

|

|

W=[0,0,0,1

|

H(W)=0

|

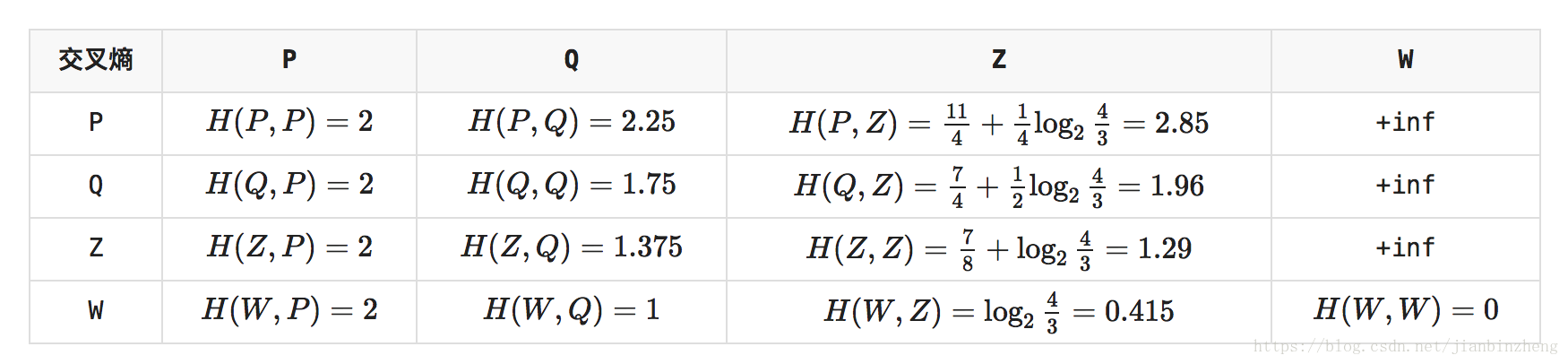

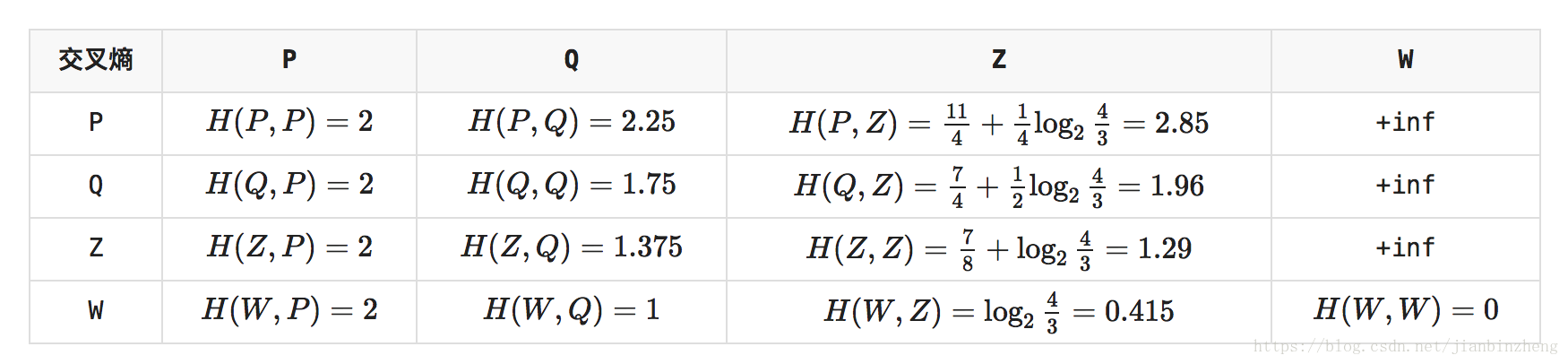

交叉熵,用来衡量在给定的真实分布下,使用非真实分布指定的策略消除系统的不确定性所需要付出努力的大小;

就是用预估的存储策略,来存储未知变量,得到在此策略下消耗的存储空间,在P和Q分布一致下,交叉熵=信息熵

H(P,Q)=∑iP(i)loga1Q(i)

H(P,Q)>=H(P)

交叉熵可以作为损失函数,衡量p和q的相似性

相对熵,衡量两个概率分布之间的差异,也称为KL散度,值越低,训练出来的概率Q接近样本概率P,越准确,两者一致就是0

DKL(P||Q)=H(P,Q)−H(P)=∑iP(i)logaP(i)Q(i)

底数a,使用2进制编码用2,用正态分布用e,10是万金油。。。