信息是对接收者来说是一种不确切 的知识,可以认为是一种不确定性的 度量。比如下面的例子,假设随机变量 X= ‘出生年份’:

1) I will be one year older next year. ----> No information

2) I was born in 1993. ----> little information

3) I was born in 1990s. ---->More information

可见,信息量 与随机变量可能值的数量 相关。随机变量能取到的值越多,代表事件的不确定度 越大,包含的信息越多。不确定度越大,信息量越多

例如,一个班有30个学生,我们要用一个二进制序列区分他们,需要多少bits?

l

o

g

2

30

=

4.907

b

i

t

s

log_2 30 = 4.907 bits

l o g 2 3 0 = 4 . 9 0 7 b i t s

所以至少需要5个bits才能代表每个学生

在通信系统中,信息熵用来表示平均每符号携带多少比特(bit)信息 ,信息熵的单位是 bit/symbol(比特每符号)。其背景如下:

我们需要把一个信源符号,转化成一个0-1的二进制比特形式,那么需要多少个二进制比特位,才能表达这个通信符号的所有信息呢?

上文说到,信息代表不确定性,与事件的概率相关。那么假设一个信源有5种可能的符号,记为

x

1

,

x

2

,

x

3

,

x

4

,

x

5

x_1,x_2,x_3,x_4,x_5

x 1 , x 2 , x 3 , x 4 , x 5

P

(

x

1

)

,

P

(

x

2

)

,

P

(

x

3

)

,

P

(

x

4

)

,

P

(

x

5

)

P(x_1), P(x_2),P(x_3),P(x_4),P(x_5)

P ( x 1 ) , P ( x 2 ) , P ( x 3 ) , P ( x 4 ) , P ( x 5 ) 熵 (平均每比特携带的信息量)为:

H

(

X

)

=

E

[

l

o

g

2

P

(

X

)

−

1

]

=

∑

i

=

1

5

P

(

x

i

)

∗

l

o

g

2

P

(

x

i

)

−

1

H(X) = E [ log_2 P(X)^{-1} ] = \sum_{i=1}^{5}P(x_i) *log_2P(x_i)^{-1}

H ( X ) = E [ l o g 2 P ( X ) − 1 ] = ∑ i = 1 5 P ( x i ) ∗ l o g 2 P ( x i ) − 1

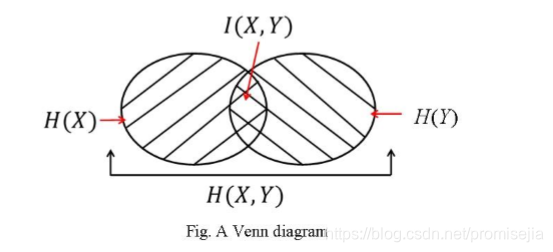

联合熵上与联合分布 相关。联合熵表示为:

H

(

X

,

Y

)

=

−

∑

x

ϵ

X

∑

y

ϵ

Y

P

(

X

,

Y

)

l

o

g

2

P

(

X

,

Y

)

H(X,Y ) = - \sum_{x\epsilon X}\sum_{y\epsilon Y}P(X,Y) log_2 P(X,Y)

H ( X , Y ) = − ∑ x ϵ X ∑ y ϵ Y P ( X , Y ) l o g 2 P ( X , Y ) 条件分布 及联合分布 相关。条件熵表示为:

H

(

X

∣

Y

)

=

−

∑

x

ϵ

X

∑

y

ϵ

Y

P

(

X

,

Y

)

l

o

g

2

P

(

X

∣

Y

)

H(X|Y ) = - \sum_{x\epsilon X}\sum_{y\epsilon Y}P(X,Y) log_2 P(X|Y)

H ( X ∣ Y ) = − ∑ x ϵ X ∑ y ϵ Y P ( X , Y ) l o g 2 P ( X ∣ Y )

链式法则:

H

(

X

,

Y

)

=

H

(

X

∣

Y

)

+

H

(

Y

)

=

H

(

X

)

+

H

(

Y

∣

X

)

H(X,Y ) = H(X|Y ) + H(Y) = H(X) + H(Y|X)

H ( X , Y ) = H ( X ∣ Y ) + H ( Y ) = H ( X ) + H ( Y ∣ X )

互信息为熵 减去条件熵 。

I

(

X

,

Y

)

=

H

(

Y

)

−

H

(

Y

∣

X

)

=

H

(

X

)

+

H

(

X

∣

Y

)

I(X,Y ) = H(Y) - H(Y|X ) = H(X) + H(X|Y)

I ( X , Y ) = H ( Y ) − H ( Y ∣ X ) = H ( X ) + H ( X ∣ Y ) 熵 的和 减去 联合熵

I

(

X

,

Y

)

=

H

(

Y

)

−

H

(

Y

∣

X

)

=

H

(

X

)

+

H

(

X

∣

Y

)

I(X,Y ) = H(Y) - H(Y|X ) = H(X) + H(X|Y)

I ( X , Y ) = H ( Y ) − H ( Y ∣ X ) = H ( X ) + H ( X ∣ Y )

上诉过程可以用图加深理解:

相对熵和交叉熵