以前在学习通信原理,信息论时都学习过这样的原理,但是不能从根本理解这样的公式有什么用,能解决什么问题。例如,笔者最近在看用信息论里条件熵来检测图像视频的显著性,一直就不明白这两样东西怎么就放在一块了。后面在《数学之美》,在书中看到了这些公式能够解释什么问题时,才有所领悟~~~

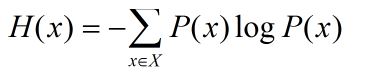

1,信息熵(Entropy)

公式大家都不陌生吧:

P(x)是变量出现的概率;以前我们可以就学到此就为止了,那个信息熵在感性来看来表达的是什么东西呢?

信息熵越大,变量中包含的信息量就越大。同时,也说明了变量的不确定性也越大。

书中写到“一个事物内部会存在随机性,也就是不确定性,而从外部消除这个不确定性唯一的办法是引入信息。如果没有信息,任何公式或者数字的游戏都无法排除不确定性。几乎所有的自然语言处理,信息与信号处理的应用都是一个消除不确定性的过程。”

合理利用信息,而不是玩弄什么公式和机器学习算法,是做好搜索的关键。

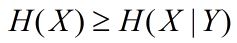

2,条件熵(Conditional Entropy)

知道的信息越多,随机事件的不确定性就越小。

书中定义:在Y条件X的条件熵:(二元模型)

可以证明:

也就是说,引用了其他信息后,信息的不确定性降低了,“=”表示引入的信息对于X无关的,所以信息的不确定性不会改变。

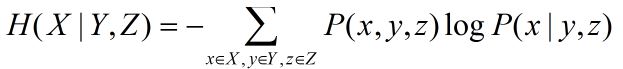

(三元模型)

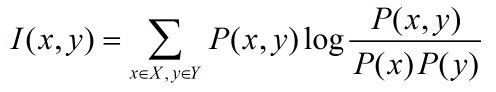

3,互信息(Mulual information)

也就是用来衡量两个信息的相关性大小的量。

4,相对熵

相对熵也是用来衡量相关性的,但和变量的互信息不同,它用来衡量两个取值为正数的函数的相似性。

结论:

1)对于两个完全相同的函数,它们的相对熵为0;

2)相对熵越大,两个函数的差异越大,反之 ,相对熵越小,两个函数差异越小;

3)对于概率分布或者概率密度函数,如果取值均大于0,相对熵可以衡量两个分布的差异性。

启示:

1)去计算一个变量的不确定性,可以考虑信息熵;在研究显著性时,可以用信息熵去计算一个区域的信息量的大小,近而来判断其为显著性区域或者像素点的可能性;

2)计算两个变量之间的相关性,可以考虑条件熵;