文章目录

-

- 一、Gated Attention Networks(GaAN)

- 二、Commute Times Layer(CT-Layer)

- 三、Symbolic Deep Learning

- 四、Heterogeneous Molecular Graph Neural Network(HMGNN)

- 五、Multiplex Molecular Graph Neural Network(MXMNet)

- 六、Pseudoinverse Graph Convolutional Network

- 七、TaxoExpan

- 八、Point-GNN

- 九、Instruction Pointer Attention Graph Neural Network(IPA-GNN)

- 十、Hierarchical Entity Graph Convolutional Network(HEGCN)

一、Gated Attention Networks(GaAN)

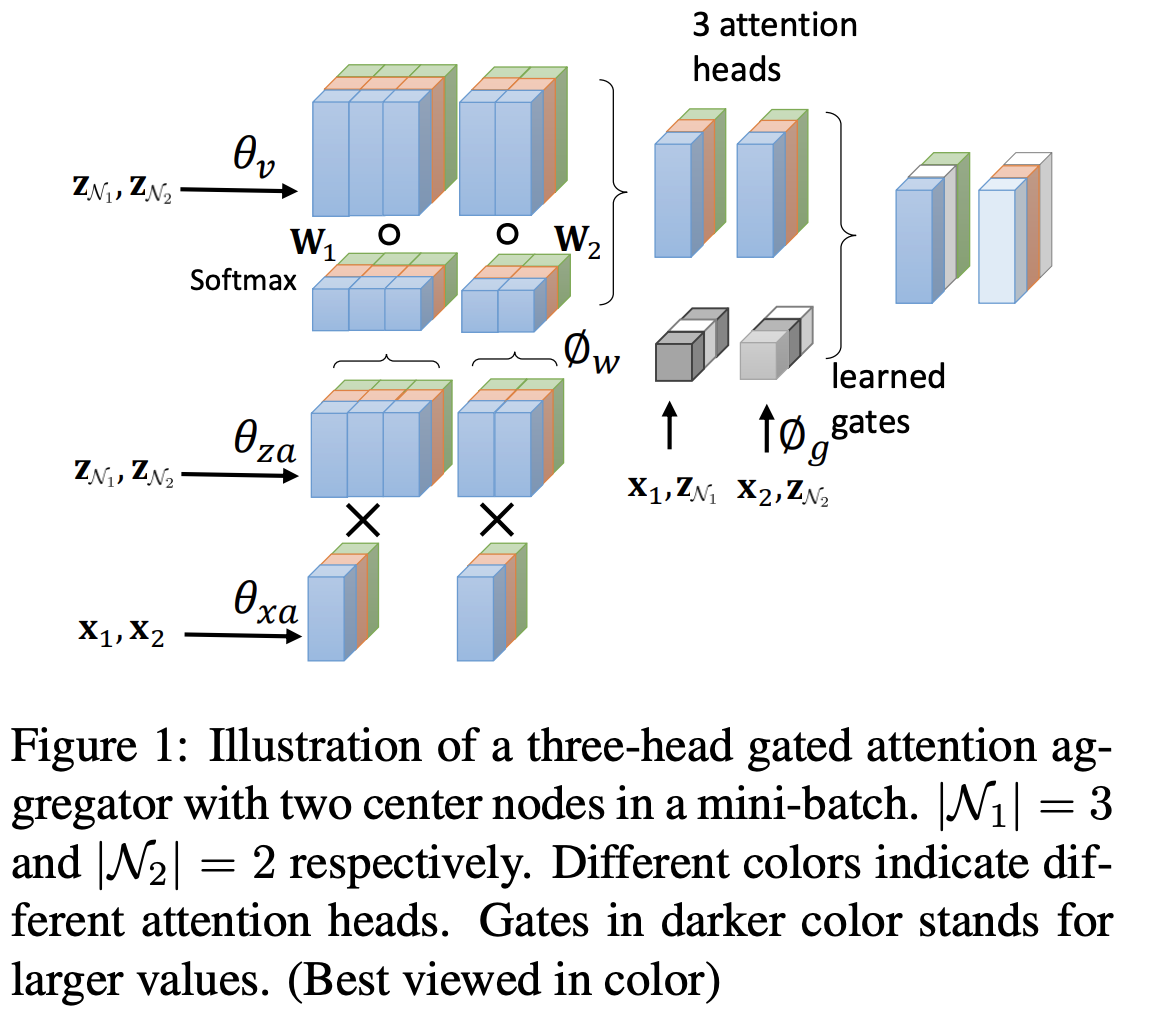

门控注意力网络(GaAN)是一种用于图学习的新架构。 与平均消耗所有注意力头的传统多头注意力机制不同,GaAN 使用卷积子网络来控制每个注意力头的重要性。

二、Commute Times Layer(CT-Layer)

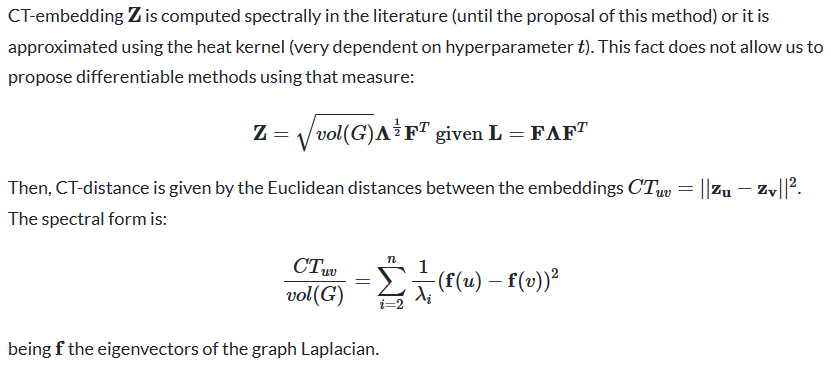

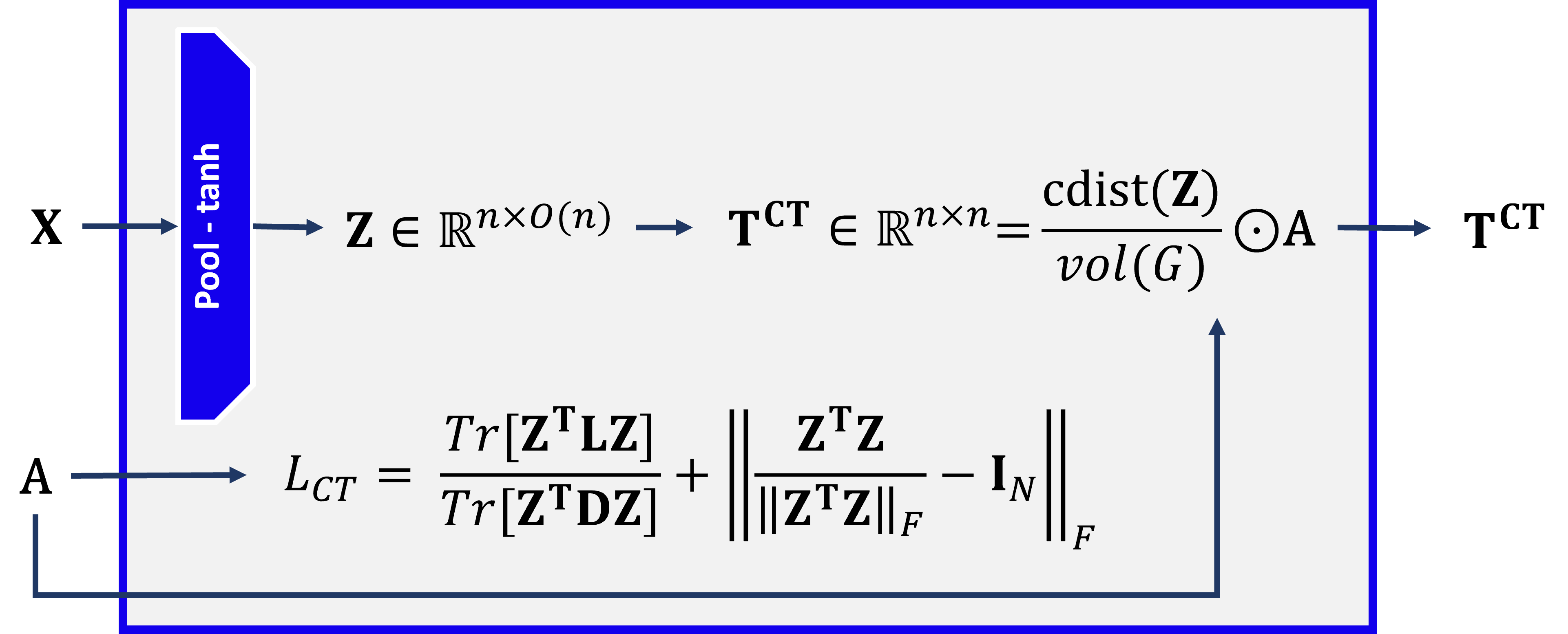

TL;DR:CT 层是一个 GNN 层,它能够根据通勤时间距离(或有效电阻)以归纳、无参数的方式重新连接图形。 我们通过学习一种可微的方法来计算图的 CT 嵌入来解决这个问题。

概括

CT-Layer 能够以可微分的方式(而不是常见的谱版本)以及无参数的方式(这不是热内核的情况)来学习节点之间的通勤时间距离(即有效电阻距离)。 这种方法允许将其作为 GNN 内部的优化问题来解决,从而产生一个新层,该层能够学习如何以最佳归纳方式重新连接给定图。

此外,CT-Layer 还能够学习通勤时间嵌入,然后以归纳方式计算任何图。 通勤时间嵌入还与图的拉普拉斯算子的特征值和特征向量有关,因为 CT 嵌入只是缩放后的特征向量。 因此,CT-Layer也能够学习以可微分的方式计算拉普拉斯的频谱。 因此,这种嵌入必须满足正交性和正态性。

最后,最近发现了通勤时间距离和曲率(不可微分)之间的联系,建立了它们之间的等价关系。 因此,CT-Layer也可以看作是曲率重连的可微分版本。

我们正在快速概述该层,但我建议您参阅论文以获取详细说明。

能谱 CT - 嵌入的缺点:

这种嵌入和距离为我们提供了图的理想属性,例如对结构的理解,或者基于最小化狄利克雷能量的频谱的嵌入。 然而,谱计算是不可微分的。

CT 层作为优化问题:可微分、可学习和归纳 CT 层

三、Symbolic Deep Learning

这是将神经网络转换为解析方程的通用方法。 该技术的工作原理如下:

鼓励稀疏的潜在表示

应用符号回归来近似输入/潜在/输出层之间的转换

编写符号表达式。

在论文中,我们表明我们发现可以从神经网络中提取正确的已知方程,包括力定律和哈密顿量。 然后,我们将我们的方法应用于一个重要的宇宙学示例(详细的暗物质模拟),并发现了一个新的解析公式,可以根据附近宇宙结构的质量分布来预测暗物质的浓度。 使用我们的技术从 GNN 中提取的符号表达式也比 GNN 本身更好地推广到分布外数据。 我们的方法为解释神经网络并从他们学习的表示中发现新的物理原理提供了替代方向。

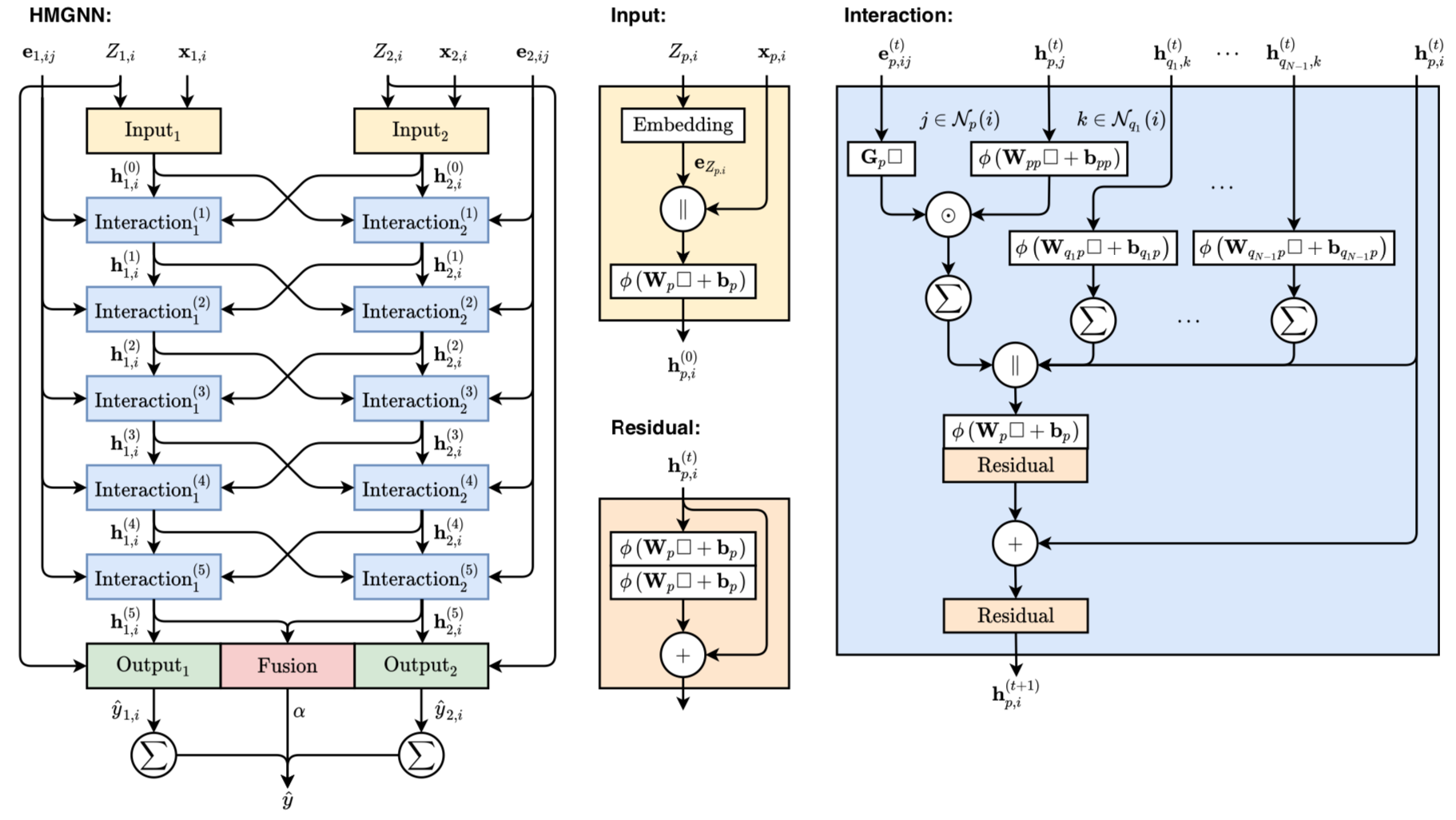

四、Heterogeneous Molecular Graph Neural Network(HMGNN)

由于它们在模拟复杂相互作用方面具有巨大潜力,基于图神经网络(GNN)的方法已被广泛用于预测分子的量子力学特性。 大多数现有方法将分子视为分子图,其中原子被建模为节点。 他们通过模拟每个原子与分子中其他原子的成对相互作用来表征每个原子的化学环境。 尽管这些方法取得了巨大的成功,但有限的工作明确考虑了多体相互作用,即三个或更多原子之间的相互作用。 在本文中,我们引入了一种新颖的分子图表示形式,即异构分子图(HMG),其中节点和边具有各种类型,以模拟多体相互作用。 HMG 具有携带复杂几何信息的潜力。 为了利用 HMG 中存储的丰富信息来解决化学预测问题,我们基于神经消息传递方案构建了异构分子图神经网络 (HMGNN)。 HMGNN 将全局分子表示和注意力机制纳入预测过程。 HMGNN 的预测对于原子坐标的平移和旋转以及原子索引的排列是不变的。 我们的模型在 QM9 数据集的 12 项任务中的 9 项中实现了最先进的性能。

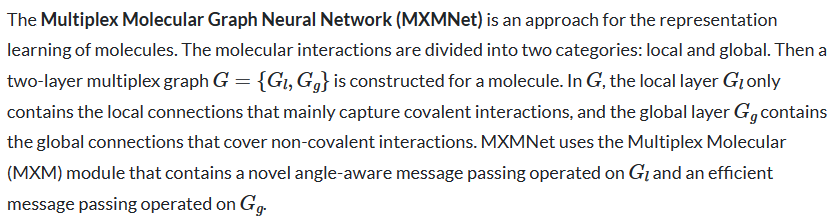

五、Multiplex Molecular Graph Neural Network(MXMNet)

六、Pseudoinverse Graph Convolutional Network

一种 GCN 方法,针对密集图和超图的独特谱特性,通过高效的数值线性代数实现。

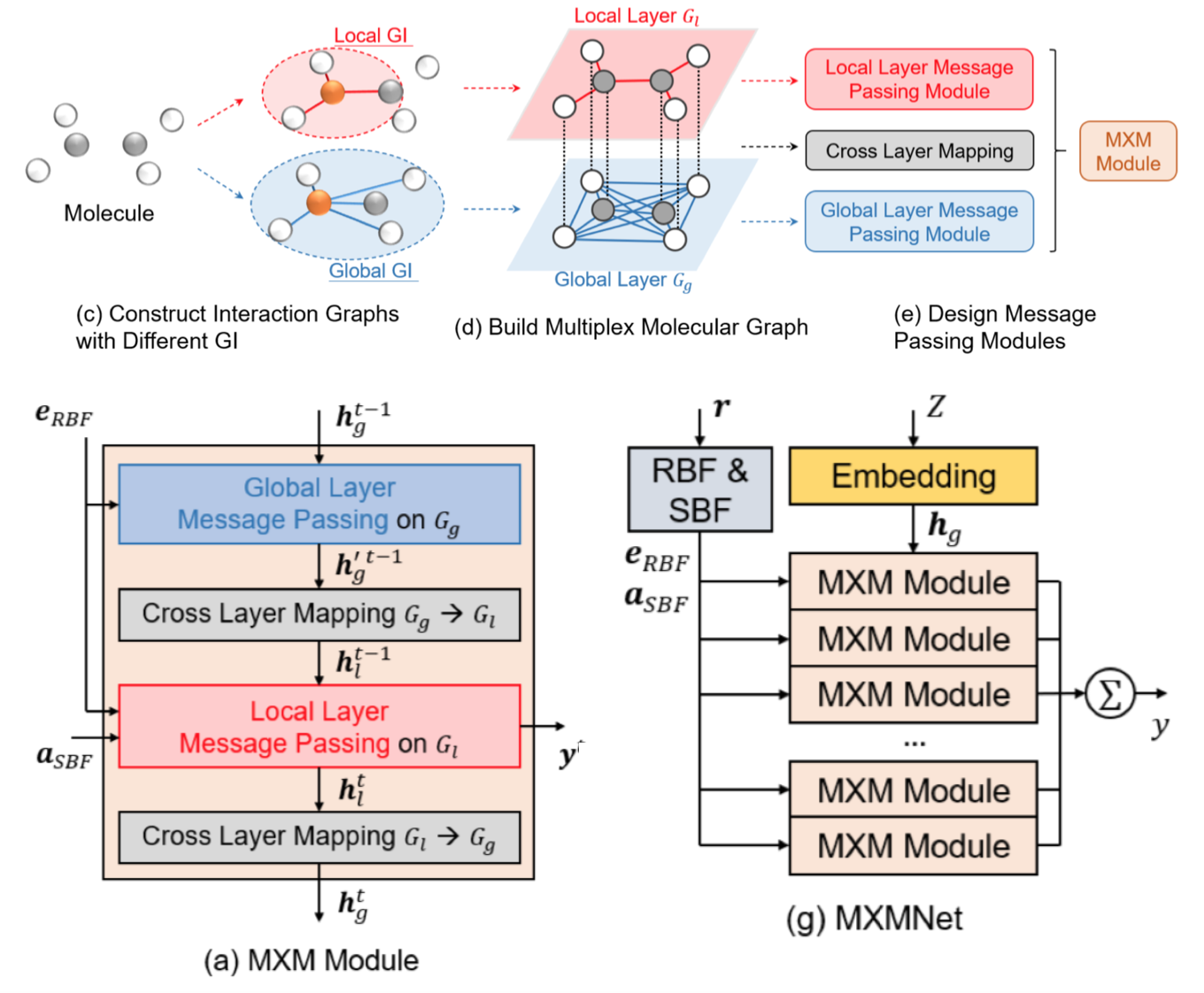

七、TaxoExpan

TaxoExpan 是一个自我监督的分类扩展框架。 它从现有分类法中自动生成一组<查询概念,锚概念>对作为训练数据。 使用此类自我监督数据,TaxoExpan 学习一个模型来预测查询概念是否是锚概念的直接下义词。 TaxoExpan 的特点:(1)位置增强图神经网络,对现有分类中锚概念的局部结构进行编码;(2)抗噪声训练目标,使学习模型对标签噪声不敏感。 自监督数据。

八、Point-GNN

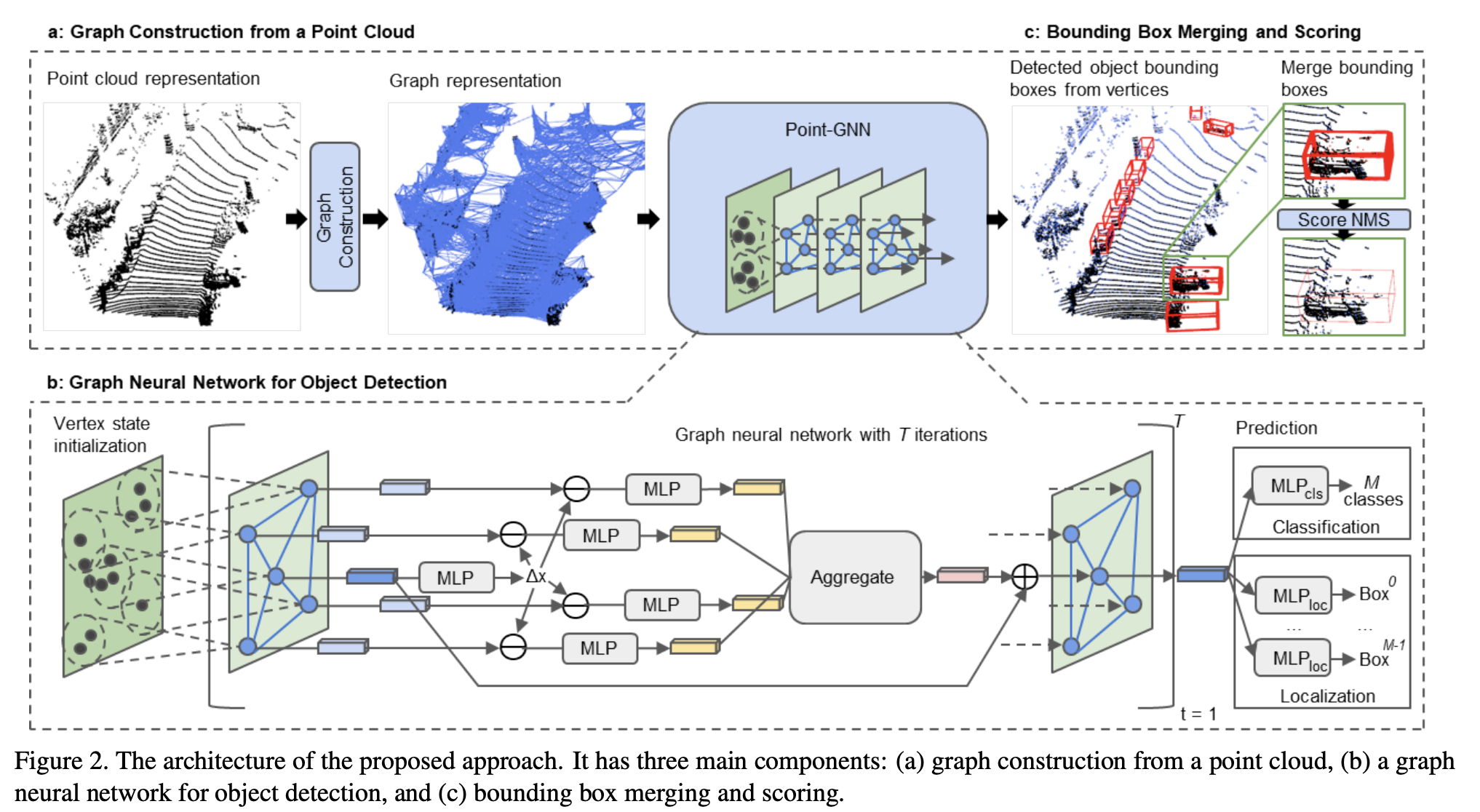

Point-GNN 是一种用于从 LiDAR 点云中检测对象的图神经网络。 它预测图中每个顶点所属的对象的类别和形状。 在Point-GNN中,有一个自动注册机制来减少平移方差,以及一个框合并和评分操作来准确地组合来自多个顶点的检测。

九、Instruction Pointer Attention Graph Neural Network(IPA-GNN)

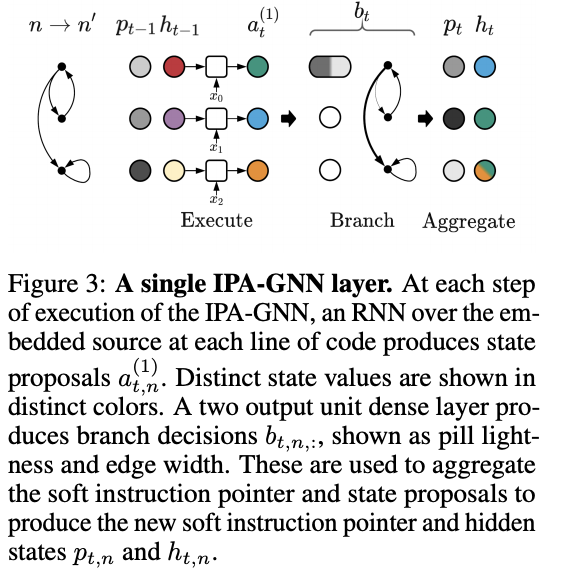

指令指针注意力图神经网络(IPA-GNN)是一种基于 GNN 的学习解释器神经网络(LNN),用于学习执行程序。 它在学习使用控制流图执行程序的任务上实现了改进的系统概括。 该模型是通过考虑在程序轨迹上运行的 RNN 并将分支决策作为潜在变量而产生的。 IPA-GNN 既可以被视为 RNN 模型的连续松弛,也可以被视为更适合执行的 GNN 变体。

十、Hierarchical Entity Graph Convolutional Network(HEGCN)

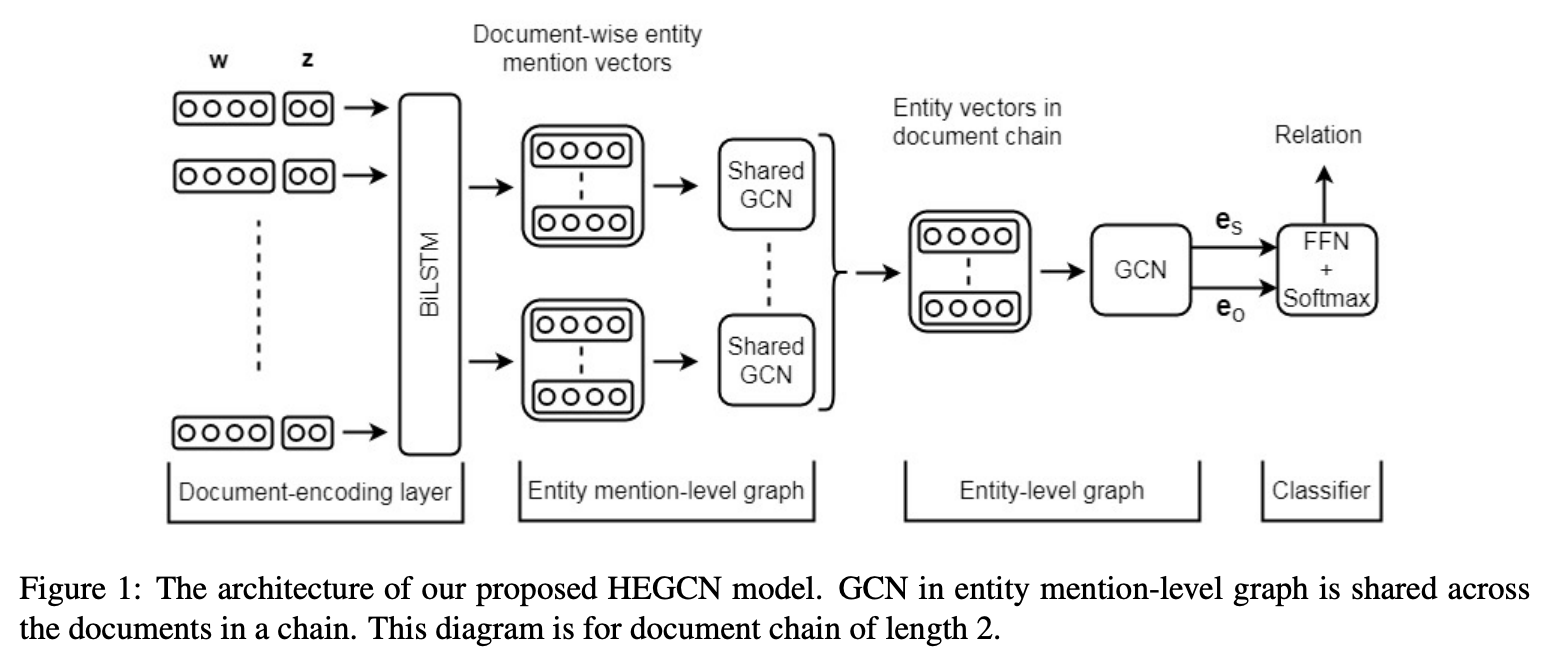

HEGCN(分层实体图卷积网络)是跨文档多跳关系提取的模型。 文档链中的文档使用双向长短期记忆 (BiLSTM) 层进行编码。 在 BiLSTM 层的顶部,使用了两个图卷积网络 (GCN),一个接一个地按层次结构排列。

在 GCN 层次结构的第一级中,使用该文档中提到的所有实体在链的每个文档上构建一个单独的实体提及图。 文档中对实体的每次提及都被视为图中的一个单独节点。 图卷积网络(GCN)用于表示每个文档的实体提及图,以捕获文档中实体提及之间的关系。 然后跨链中的所有文档构建统一的实体级图。 该实体级图的每个节点代表文档链中的唯一实体。 链中两个文档之间的每个公共实体由图中的单个节点表示。 GCN 用于表示该实体级图,以捕获跨文档的实体之间的关系。

主体实体和客体实体的节点表示被连接并传递到使用softmax的前馈层进行关系分类。