文章目录

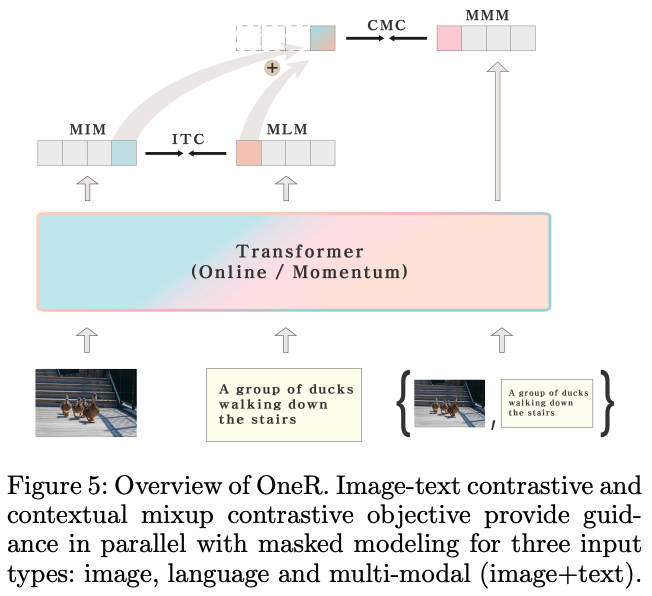

一、Pixel-BERT

Pixel-BERT 是一种预训练模型,经过训练可以将图像像素与文本对齐。 端到端框架包括基于 CNN 的视觉编码器和用于视觉和语言嵌入学习的跨模态转换器。 该模型由三部分组成:一个以图像像素作为输入的全卷积神经网络、一个基于 BERT 的词级标记嵌入、以及一个用于联合学习视觉和语言嵌入的多模态转换器。

对于语言,它使用其他预训练工作来使用掩码语言建模(MLM)来预测带有周围文本和图像的掩码标记。 对于视觉,它使用随机像素采样机制来弥补预测像素级特征的挑战。 该机制也适用于解决过度拟合问题并提高视觉特征的鲁棒性。

它应用图像文本匹配(ITM)来分类图像和句子对是否匹配以进行视觉和语言交互。

需要图像字幕来理解 VQA 等跨模态任务的语言和视觉语义。 从 Faster RCNN 等对象检测模型中提取的基于区域的视觉特征用于在新版本的模型中获得更好的性能。

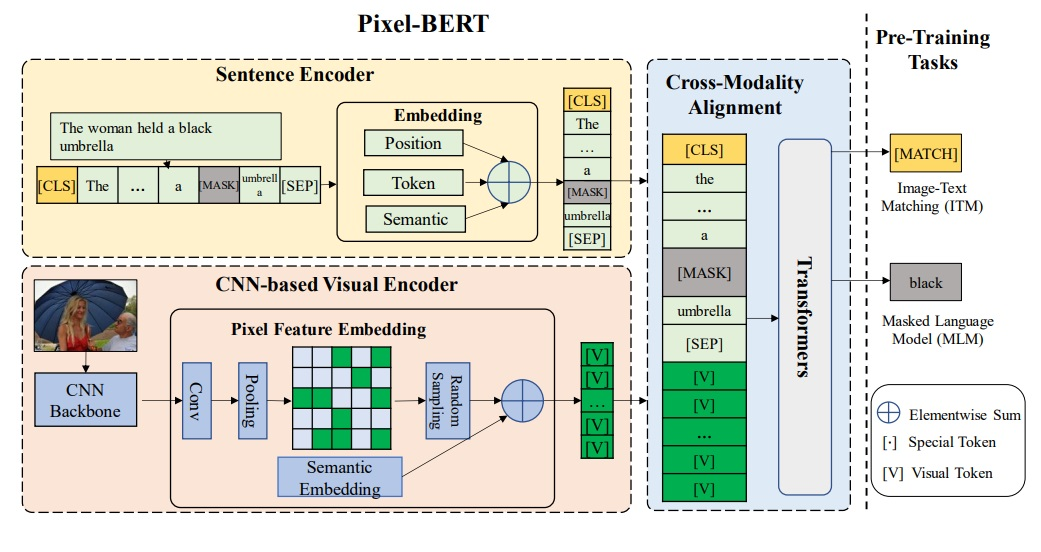

二、Kaleido-BERT

Kaleido-BERT(CVPR2021)是专注于解决电子商务领域PTM的开创性工作。 与通用领域发布的许多模型相比,它实现了 SOTA 性能。

三、AltCLIP

在这项工作中,我们提出了一种概念上简单而有效的方法来训练强大的双语多模态表示模型。 从OpenAI发布的预训练多模态表示模型CLIP开始,我们将其文本编码器更换为预训练的多语言文本编码器XLM-R,并通过由教师学习和对比学习组成的两阶段训练模式来对齐语言和图像表示。 我们通过评估广泛的任务来验证我们的方法。 我们在 ImageNet-CN、Flicker30k-CN 和 COCO-CN 等一系列任务上设置了新的最先进性能。 此外,我们在几乎所有任务上都使用 CLIP 获得了非常接近的性能,这表明人们可以简单地改变 CLIP 中的文本编码器以获得扩展功能,例如多语言理解。 我们的模型和代码可在 https://github.com/FlagAI-Open/FlagAI 获取。

四、FashionCLIP

FashionCLIP 是基于时尚数据(超过 80 万对)进行微调的 CLIP 模型。 这是时尚的第一个基础模型。

五、Pathology Language and Image Pre-Training(PLIP)

病理语言和图像预训练(PLIP)是通过对病理图像进行微调 CLIP 创建的视觉和语言基础模型。

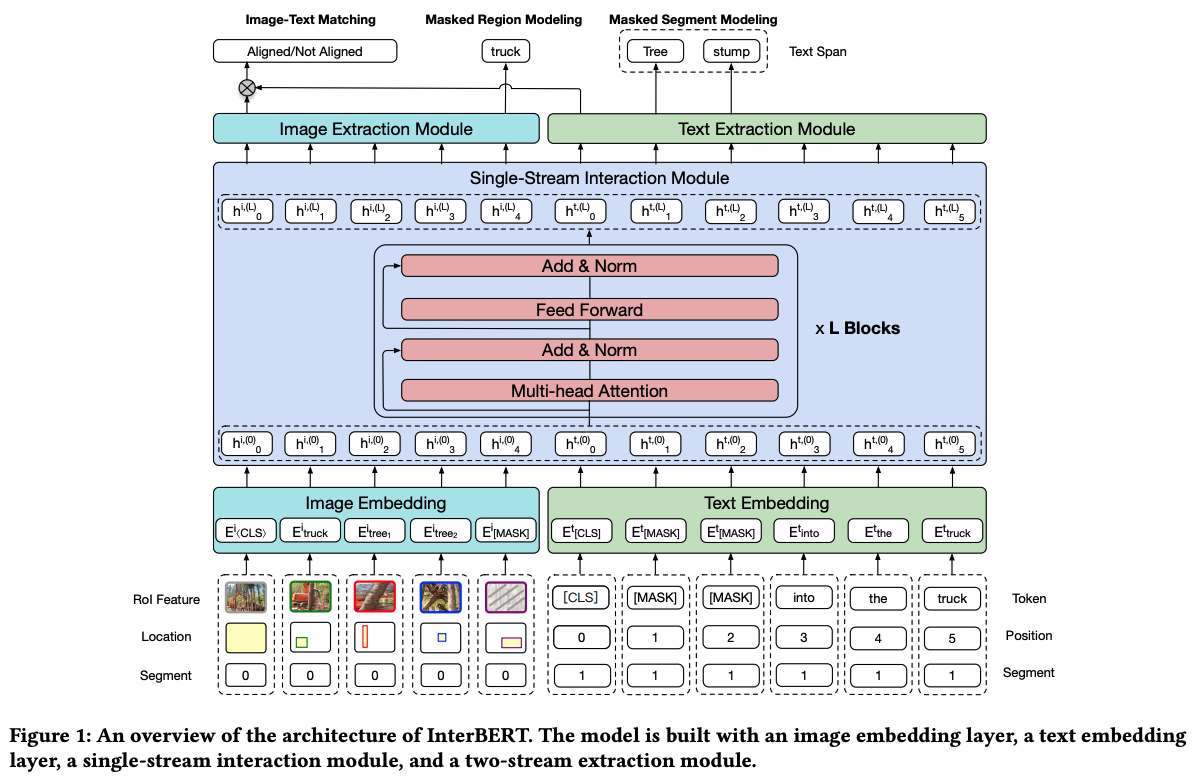

六、InterBERT

InterBERT 旨在对不同模态的信息流之间的交互进行建模。 这种新的架构构建了多模态交互并保留了单模态表示的独立性。 InterBERT 由图像嵌入层、文本嵌入层、单流交互模块和双流提取模块构建。 该模型通过三个任务进行预训练:1)屏蔽段建模,2)屏蔽区域建模,3)图像文本匹配。

七、Unified VLP

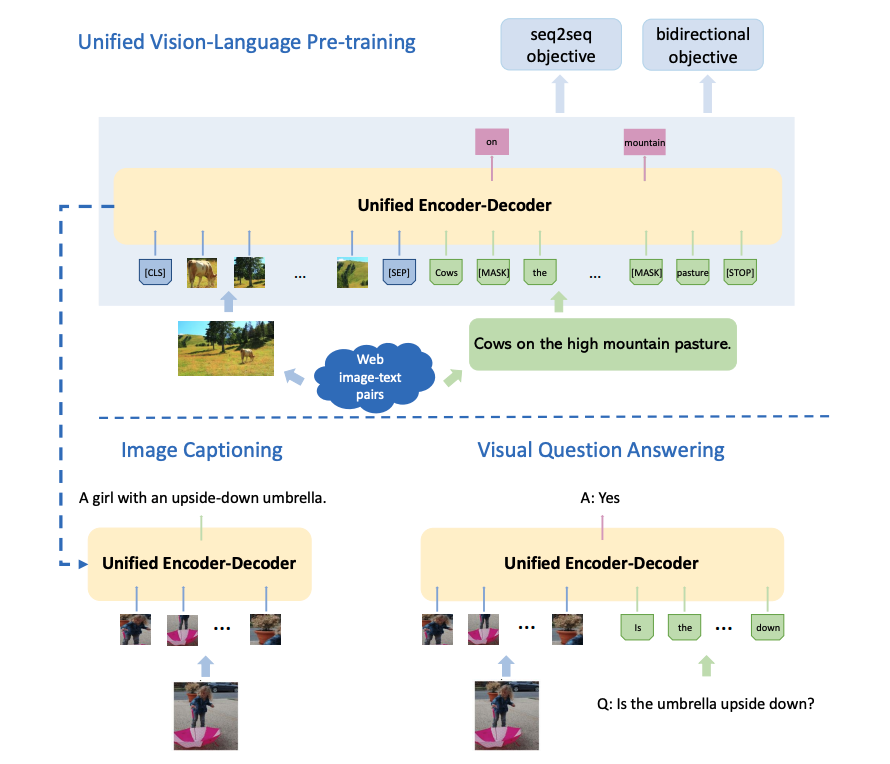

Unified VLP 是用于通用视觉语言预训练的统一编码器-解码器模型。 这些模型使用共享的多层变压器网络进行编码和解码。 该模型使用两个任务的无监督学习目标对大量图像-文本对进行预训练:双向和序列到序列 (seq2seq) 屏蔽视觉语言预测。 预训练的模型架构。 对于预训练,输入包括图像输入、句子输入和三个特殊标记([CLS]、[SEP]、[STOP])。 图像被处理为N提取感兴趣区域(RoI)和区域特征。 该句子被标记化并用 [MASK] 标记进行掩码,以供后续掩码语言建模任务使用。 该模型由 12 层 Transformer 模块组成,每层都有一个屏蔽自注意力层和前馈模块,其中自注意力屏蔽控制预测条件的输入上下文。 根据目标是双向还是 seq2seq 来实现两个自注意力掩码。 该模型针对图像字幕和视觉问题回答进行了微调。

八、XGPT

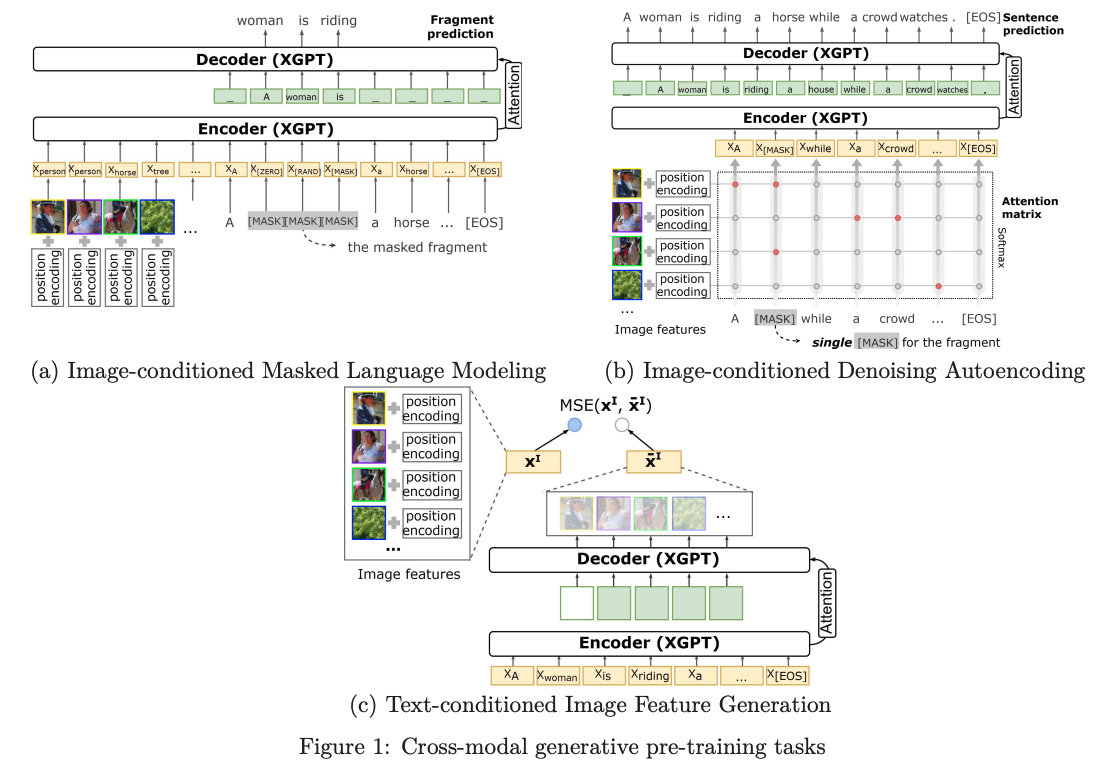

XGPT 是一种图像字幕跨模态生成预训练方法,旨在通过三个新颖的生成任务来预训练文本到图像字幕生成器,包括图像条件掩码语言模型(IMLM)、图像条件去噪自动编码( IDA)和文本条件图像特征生成(TIGF)。 预训练的 XGPT 可以进行微调,无需任何特定于任务的架构修改,并构建强大的图像字幕模型。

九、Vision-Language pretrained Model(VLMo)

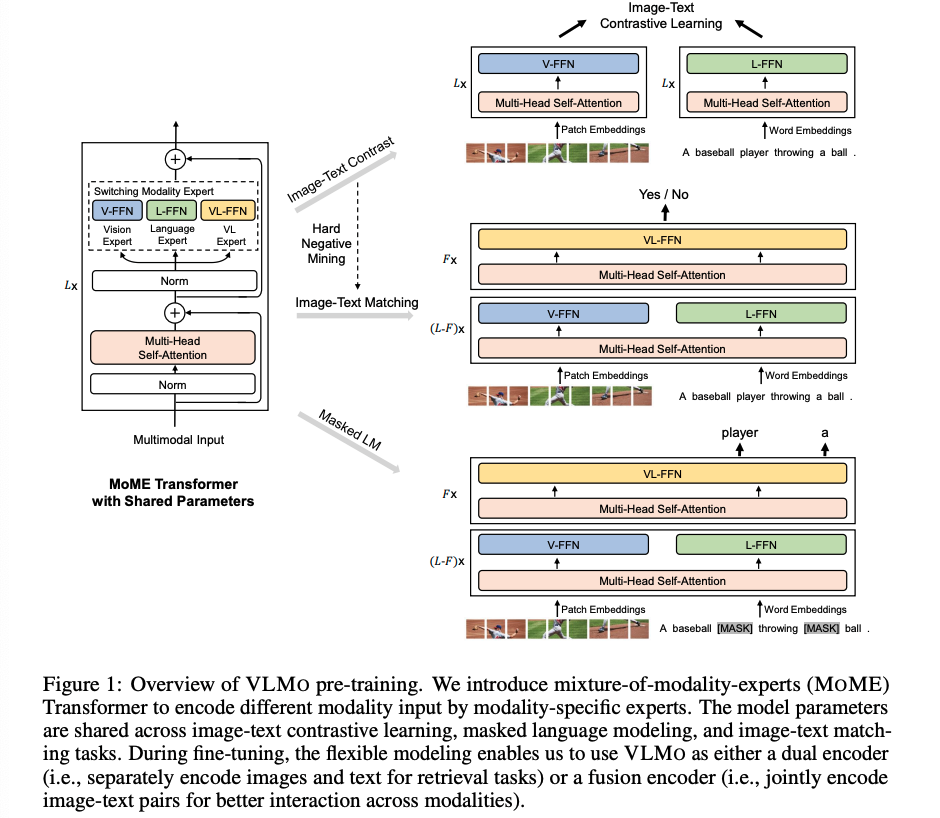

VLMo 是一种统一的视觉语言预训练模型,通过模块化 Transformer 网络联合学习双编码器和融合编码器。 引入了模态专家混合(MOME)变压器来编码不同的模态,这有助于它通过模态专家捕获特定于模态的信息,并通过跨模态共享的自注意力模块来对齐不同模态的内容。 模型参数在图像文本对比学习、掩蔽语言建模和图像文本匹配任务中共享。 在微调过程中,灵活的建模允许 VLMO 用作双编码器(即,分别编码图像和文本以进行检索任务)或融合编码器(即,联合编码图像-文本对,以实现更好的跨模态交互) 对纯图像和纯文本数据的分阶段预训练改进了视觉语言预训练模型。 该模型可用于分类任务,并可作为检索任务的双编码器进行微调。

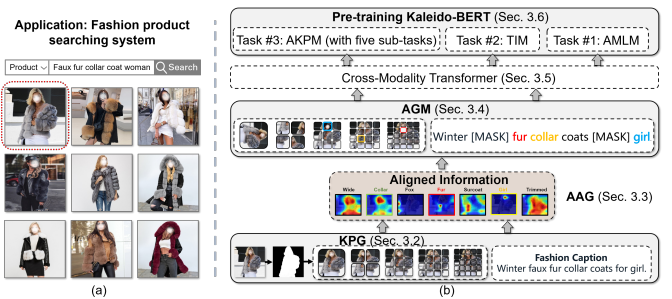

十、One Representation(OneR)

在OneR方法中,模型输入可以是图像、文本或图像+文本之一,CMC目标与传统的图文对比(ITC)损失相结合。 还对所有三种输入类型(即图像、文本和多模态)进行掩蔽建模。 除了初始令牌嵌入层之外,该框架不采用特定于模态的架构组件,从而使我们的模型具有通用性和模态不可知性,并且具有最小的归纳偏差。