SCRDet: Towards More Robust Detection for Small, Cluttered and Rotated Objects

SCRDet:为小的、杂乱的和旋转的物体提供更鲁棒的检测

论文地址:https://arxiv.org/abs/1811.07126

开源代码:https://github.com/DetectionTeamUCAS/R2CNN-Plus-Plus_Tensorflow

以下内容在参考博客的基础上二次学习笔记,会有一些补充学习,如有侵权,立马删除,以下仅作为自己复习,建议去看原博客。

目录

1. SF-Net(Finer Sampling and Feature Fusion Network)

2. MDA-Net( Multi-Dimensional Attention Network)

4.2 Visualization of the MDA-Net

4.5 Experiments on Natural Images

一、介绍

- 对于小型目标、杂乱密集和任意旋转方向的目标检测依然存在着巨大的挑战。

- 本文介绍的方法不仅适合用在航拍数据集上,也可以使用在自然图像数据集中,即SCRDet。

- 设计了一种采样融合网络,它将多层特征融合到有效的anchor采样中,以提高对于小型目标的检测灵敏度。

- 通过抑制噪声和突出物体的特征,使用有监督的像素注意力网络和通道注意力网络,用于小而杂乱的目标检测。

- 为了更准确地进行旋转估计,将IoU常数因子添加到smooth L1 loss中,用来解决旋转边界框的边界问题。

二、SCRDet算法流程

- SCRDet 模型由SF-net,MDA-net和rotation branch 组成。

- 这是一种Two stage网络,由SF-net 和MDA-net提取特征图,在rotation branch 进行位置回归与分类。

- 如图1所示。在第一阶段,通过添加SF-Net和MDA-Net,期望特征图包含更多的特征信息和更少的噪声。对于角度参数的位置灵敏度,此阶段仍然回归水平框。第二阶段通过改进的五参数回归和对每个方案进行旋转非最大抑制(R-NMS)操作,可以得到任意旋转下的最终检测结果。

算法过程:

- 输入一张图片,首先使用resnet提取特征图;

- 用C3和C4两层在SF-net中进行特征融合和精确的特征采样,提取更多的语义信息和位置信息,经过两个通道的元素相加,得到特征图。

- 该特征图F3经过像素注意网络和通道注意网络后,与输入F3进行卷积运算,得到输出新的特征图A3。

- A3作为Rotation Branch的输入,进行RPN提取候选框,候选框映射到特征图中后进行ROI Align ,然后进行目标分类与位置回归,得到最后预测的结果。

1. SF-Net(Finer Sampling and Feature Fusion Network)

分析

检测小物体有两个主要障碍:物体特征信息不足和锚框采样不足。

原因:

- 由于使用了池化层,使得小对象在深层丢失了大部分特征信息。

- 高阶特征图的采样步幅越大,越容易直接跳过较小的目标,导致采样不足。

解决:

- 特征融合。一般认为,低级特征图可以保存小对象的位置信息,而高级特征图可以包含更高层次的语义线索。特征金字塔网络(FPN)[23]、顶下调制(TDM)[35]和与对象先验网络(RON)反向连接[21]是常见的特征融合方法,涉及不同形式的高、低层次特征映射的组合。

- 更好的抽样。训练样本不足和不平衡会影响检测性能。通过引入期望最大重叠(EMO)分数,在[45]中计算锚与对象之间的期望最大交集(IoU)。他们发现锚点(SA)的步幅越小,EMO得分越高,统计上导致所有对象的平均最大IOU的提高。

图2分别为给定步幅16和步幅8的小目标采样结果。可以看出,越小的SA样本,越高质量的样本能够很好地捕捉小物体,这对检测器的训练和推理都有帮助。基于以上分析,我们设计了更精细的采样特征融合网络(SF-Net),如图3所示。

特征融合模块

图3:SF-Net。F3具有较小的SA,同时充分考虑了特征融合和对不同尺度的适应性。

- SF-Net的第一个通道对C4进行采样,使其SA =S,其中是S预期的锚步幅。

- 第二个通道也取样C3到相同的尺寸。

- 通过一个inception结构来扩展C3的接受域并增加语义信息。inception结构包含各种比率卷积核,以捕捉对象形状的多样性。

- 最后,通过对两个通道进行元素相加,得到新的特征图F3。

注意:为了减少网络参数,SF-Net仅使用Resnet[16]中的C3和C4进行融合,平衡语义信息和位置信息,而忽略了其他不太相关的特征。

总述:输入一张800×800×3的图像,根据缩放因子提取出C2、C3、C4不同尺寸的特征图,将C3和C4在SF-NET中进行特征融合,得到新的特征图F3。SA是特征图相对于原始图像的缩放因子(允许自适应采样),分别是C2维度是200×200×256,C3维度是100×100×512,C4维度是50×50×1024。

抽样改进

图2:不同锚点strideSA的锚点采样。

橙黄边框代表锚点,绿色边框代表ground-truth,

红色边框代表ground-truth中IOU最大的锚点。图2分别为给定步幅16和步幅8的小目标采样结果。可以看出,越小的SA样本,越高质量的样本能够很好地捕捉小物体,这对检测器的训练和推理都有帮助。

(原博客的分析:将分析和实验结果放在一起分析很好,值得学习。)

表1:不同步幅SA下DOTA上18K次迭代图像的精度和平均训练开销

根据上面的实验结果可以得出下面两个结论:

- C3和C4特征融合,丰富特征信息:

- 增加特征图大小(减小SA)来提高anchor数。(我们发现最优值依赖于特定的数据集,特别是小对象的大小分布。为了兼顾精度和速度,本文将SA的值普遍设为6)

2. MDA-Net( Multi-Dimensional Attention Network)

- 由于航拍图像等真实数据的复杂性,RPN提出的方案可能会引入大量的噪声信息,如图4b所示。过多的噪声会淹没目标信息,目标之间的边界会变得模糊(见图4a),导致漏检和虚警增加。

- 有必要增强物体线索,弱化非物体信息。

- 许多注意结构[18,17,37,38]被提出来解决遮挡、噪声和模糊问题。然而,大多数方法都是无监督的,难以引导网络达到特定的学习目的。

- 提出的方法:为了更有效地捕捉复杂背景下小对象的对象性,我们设计了一种监督多维注意力网络(MDA-Net),如图5所示。

图5 所设计的MDA-Net由通道注意力网络和像素注意力网络组成。

MDA-NET分别由两部分注意力机制组成:

像素注意力网络

第一部分:网络最上面是像素注意力网络:

- F3经过一个具有不同比值卷积核的inception模块使用不同的卷积核进行不同尺度的特征提取,然后经过卷积操作得到双通道的显著性映射((图4d)前景和背景);

(由于显著图是连续的,非对象信息不会被完全消除,这有利于保留一定的上下文信息,提高鲁棒性。)- 预测:对目标区域进行二值化处理,得到含有目标区域的二值化图((图4e)显著性高的区域赋1值,其他不重要的区域赋0值,将图像变成由0\1组成像素点图像)。

- 标签:为了引导网络学习这一过程,我们采用了一种监督学习方法。根据ground truth很容易地得到一个二值图作为标签(如图4e所示),然后利用二值图与显著性图(第2点显著性图的二值图)的交叉熵损失作为注意损失。

- 对显著图进行Softmax操作,选择其中一个通道与F3相乘。最后得到新的信息特征图A3,如图4c所示。将二值图进行softmax后把显著性映射值限制在[0,1]之间。也就是说,它可以降低噪声,相对增强目标信息。

首先,我们可以此外,我们还使用SENet[18](也就是第二部分)作为辅助的渠道注意网络, reduction ratio的值为16。

通道注意力机制(SEnet的结构)

第二部分:网络下面是通道注意力机制(SEnet的结构),使用GAP输出C个特征通道的数值分布,然后将特征的维度降低到输入的1/r,经过relu激活后再通过一个FC将维度变为原来的维度。然后通过sigmoid获得[0,1]之间归一化的权重。

最后将三个部分相乘,得到新的特征图。

3. Rotation Branch

其中,

x,y :真实框的中心坐标

w,h:真实框的宽和高

θ:真实框的旋转角度

xa :anchor box

x’ :预测框

与典型的候选框计算不同,多了一个角度的公式,用于计算候选框的旋转角度。

上图展示了一个理想的形式,蓝色框逆时针旋转到红色框,但是由于角度的周期性,这种损失会非常大。因此模型必须以其他的形式进行回归(当缩放w和h时,蓝色盒子顺时针旋转),这样提高了回归的难度.

下面介绍损失函数的时候会提到怎么解决这个问题。在传统的smooth L1 loss中 加入IoU常数因子。在边界的情况下,损失函数|-log(IoU)|接近0,消除了损失突然增加的情况。

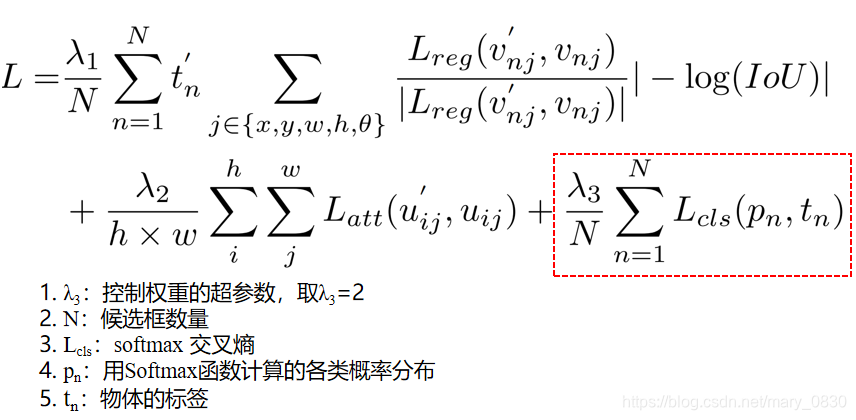

三、损失函数

3.1 Loss Function

3.2 Regrssion Loss

由于存在参数angle角度的缘故,增加IoU常数因子,可以解决复杂的回归问题,如图b所示。

在传统的smooth L1 loss中 加入IoU常数因子,在边界的情况下,损失函数|-log(IoU)|接近0,消除了损失突然增加的情况。新的损失函数是由两部分组成的,一部分是梯度的方向,另一部分是梯度的大小。此外,利用IOU优化定位精度与IOU为主的度量一致,比坐标回归更直观、有效。

3.3 Attention Loss

3.4 Classification Loss

四、实验部分

4.1 DOTA Dataset 的标注格式

imagesource 表示图像来源,gsd 表示地面的采样距离,前八个数值为矩形框的四个坐标(x1,y1,x2,y2,x3,y3,x4,y4),后面表示分别是数据集的类比和检测难易程度的标注。

4.2 Visualization of the MDA-Net

(左)图5所设计的MDA-Net由信道关注网络和像素关注网络组成。

(右)图4:多维注意网络的可视化

(a)模糊边界。(b)输入注意网络特征图。(c)注意网络输出特征图。(d)显著地图。(e)二进制映射。真实(f)。

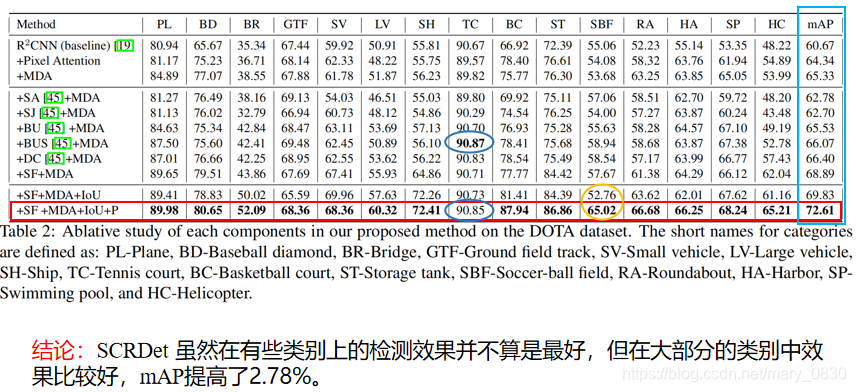

4.3 Ablation Study

SF-Net有效地建模了特征融合和SA设置的灵活性,达到了68.89%的最佳性能,特别是通过对小目标的改进,达到了最好的性能,比如说:车、船、储罐。MDA-Net 进一步提高了大纵横比的检测精度。

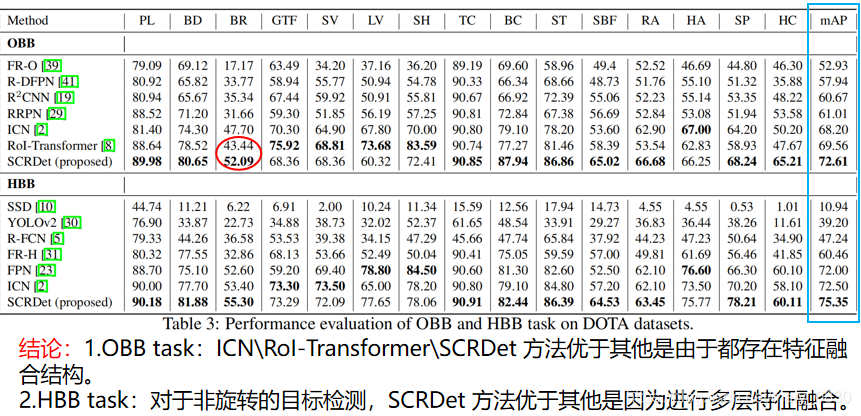

4.4 Peer Methods Comparison

Table 3显示了这些方法的性能,ROI-Transformer、ICN和SCRDet在小目标检测中的优异性能归功于特征融合。SCRDet 由于融合过程中感受野的扩展和噪声的衰减,所以对于大型物体来说,它比ICN和ROI-transformer更好。我们的方法在现有出版物中排名第一。 结果:MAP达到72.61%。

SCRDet方法在超过一半的类别上达到了最佳的检测精度。

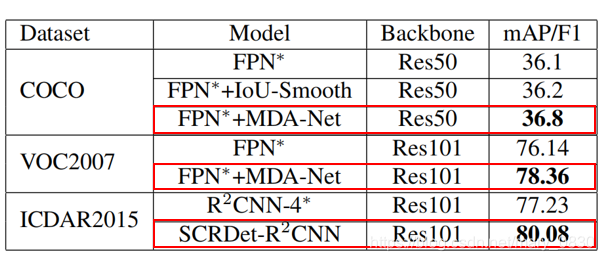

4.5 Experiments on Natural Images

结论:

由图可知,在COCO、VOC2007数据集上使用MDA-net和FPN∗分别提高了0.7%和2.22%。MDA-net在密集对象和小目标中都具有良好的性能检测。

在ICDAR2015数据集中,SCRDet相对于R2CNN-4方法也提高了2.85%。

五、结论

- 提出了一个端到端的多分类检测模型,不仅能够用于航拍图像,还可以用于COCO、VOC等常规数据集的检测。

- 提出了SF-Net,把两个不同层的feature map进行融合,并增加了一种具有较小SA的采样融合网络。

- 提出Pixel Attention和Channel Attention机制,在网络中生成权重以突出目标特征,弱化背景特征。

- 在ROI之后进行任意角的坐标检测,以保存定位信息,解决了密集图像漏检的问题。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SSbfrL1F-1573892931153)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\1573888493349.png)]](https://img-blog.csdnimg.cn/20191116163018560.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L21hcnlfMDgzMA==,size_16,color_FFFFFF,t_70)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-05I4kvec-1573892931163)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\1573889442810.png)]](https://img-blog.csdnimg.cn/2019111616322041.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L21hcnlfMDgzMA==,size_16,color_FFFFFF,t_70)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-aNcGcoNJ-1573892931165)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\1573889660113.png)]](https://img-blog.csdnimg.cn/20191116163239436.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L21hcnlfMDgzMA==,size_16,color_FFFFFF,t_70)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-26TY7K0G-1573892931169)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\1573889846650.png)]](https://img-blog.csdnimg.cn/20191116163311396.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L21hcnlfMDgzMA==,size_16,color_FFFFFF,t_70)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-F7Y4xEo0-1573892931172)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\1573889982313.png)]](https://img-blog.csdnimg.cn/20191116163351307.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L21hcnlfMDgzMA==,size_16,color_FFFFFF,t_70)