Small Object Detection in Remote Sensing Images with Residual Feature Aggregation-Based Super-Resolution and Object Detector Network. Remote Sensing

Abstract

本文利用图像超分辨率的概念,使用基于深度学习的检测方法来增强图像分辨率,从而检测来自卫星或任何飞行器的遥感图像中的小目标。本文通过结合 循环生成对抗网络(GAN)和残差特征聚合(RFA)来改进当前的超分辨率(SR)框架以提高检测性能,从而为小目标的图像超分辨率提供了基本原理。该方法的新颖之处有三:首先,提出了一个框架,独立于研究中使用的最终目标检测器,即 YOLOv3 可以替换为 Faster R-CNN 或任何目标检测器来执行目标检测;其次,在生成器中使用残差特征聚合网络,这显著提高了检测性能,因为 RFA 网络检测到复杂的特征;第三,将整个网络转化为循环 GAN。将以RFA和YOLO作为检测网络的图像超分辨率循环GAN命名为SRCGAN-RFA-YOLO,并与其他方法的检测精度进行比较。对卫星图像和航拍图像(ISPRS Potsdam、VAID 和 Draper Satellite Image Chronology 数据集)进行了严格的实验,结果表明通过使用超分辨率方法增强空间分辨率提高了检测性能;对于 0.10 的 IoU,比例因子为 16 的 AP 为 0.7867。

1. Introduction

1.1. Objective and Research Problem

由于地面采样距离 (GSD) 的限制,在遥感图像中检测感兴趣的目标一直具有挑战性,尤其是在小目标中。对于小目标,比如车辆,几个像素代表整个物体;因此,识别和检测变得具有挑战性。对于尺寸为 4 × 1.5 m2 的车辆,GSD 为 25 cm 的超高分辨率 (VHR) 卫星图像将具有 96 像素(16 × 6)的区域网格。最近开发的解决小目标检测问题的基于深度学习的模型包括 Faster RCNN [1]、单阶段检测器 [2]、语义上下文感知网络 [3] 和 端到端 MSCNN(多尺度卷积神经网络)网络)[4]。Alganci 等人 [5,6] 还比较了目标检测网络,以进一步了解卫星图像中的目标检测;这篇评论被提交给读者。研究人员已经努力调整当前的目标检测器来解决 VHR 卫星图像中的目标检测问题。在 [7] 中,使用基于树的 CNN 检测 VHR 卫星图像中的目标;输出层是全连接的,而单个层包含一个卷积层和一个池化层。在 [4] 中,提出了 EssNet 以确保使用多尺度目标检测对 VHR 图像中的小目标给予足够的重视,这在融合特征金字塔检测 [2] 中是不可能的,因为深度特征级别主导了学习过程,并且在学习过程中丢失了小目标。在[8]中,使用多光谱特征来提高目标检测精度;然而,作者将这种方法用于大型目标检测,包括金球场和发电厂。在最后的卷积层之后,[9] 中使用了基于反卷积层的 Deconv R-CNN,从而更好地定位小尺寸目标特征。

1.2. Background and Related Literature

这些研究被归类为 用于目标检测的端到端学习 或 使用先验网络在目标检测之前增强图像质量。因此,为了检测卫星/航拍图像中的小目标,正在使用 具有特征注意力的多尺度学习 以及最先进的目标检测方法,例如 Fast/Faster RCNN [10](基于区域的卷积神经网络),特征金字塔网 [11],YOLO(YOLOv3 [12],YOLOv4 [13],YOLOv5)Single Shot检测器(SSD)[14],和 RetinaNet [15]。

与 Faster R-CNN [10] 相比,Deconv R-CNN 报告检测目标的平均精度 (mAP) 提高了 13%。 Intersection-over-union (IoU)表示实际和检测到的目标边界之间的整体,检测性能取决于IoU值的选择;对于小目标,选择较小的 IoU 通常会导致更高的检测精度,同时,由于虚警数量增加,会导致定位不佳 [16]。 [16] 中提出了一种基于自适应 IoU 的可变形 R-CNN,与基线 R-CNN 相比,检测性能提高了 4.8%。在 [17] 中,开发了一种称为 DOLO 的基于优化密集 YOLOv2 的方法,用于从无人机 (UAV) 生成的图像中检测小目标; YOLOv2 和 SSD 检测不佳的小目标被 DOLO(三个块)检测到,作者报告的平均精度(mAP)为 0.762。在 [17] 中,Faster R-CNN 和 YOLOv3 报告了更高的 mAP,分别为 0.817 和 0.867。 Liu 等人 [18] 开发了另一种在无人机中检测小目标的方法,称为 UAV-YOLO。在 [18] 中,YOLOv3 中的原始darknet被修改为包含两个 Resblocks;此外,作者在初始层内增加了卷积运算,使网络能够收集更多的空间信息。该方法经过优化以在无人机图像上表现更好,同时它在数据集(如 VOC 和 COCO)上的表现与 YOLOv3 和 SSD 相似。在 [19] 中,作者开发了一种基于 Tiramisu 和 YOLO 的方法,用于对地面采样分辨率为 50 cm 的图像进行车辆计数。使用半自动注释方法对数据集中的 87k 车辆进行分割和注释,这在训练中造成了瓶颈,因为如果将数据集更改为来自不同卫星传感器的图像,注释将花费更多时间。而在 [20] 中,作者在 YOLOv3 模型中引入了 4 和 2 的较低子采样因子,以关注小型目标,由于检测网格较小,因此可以改进对较小目标的检测。在 [21] 中,Wang 等人提出了带有扩张 Resblocks 的 SSS-YOLO,它确保了大的感受野,从而使用路径增强融合网络 (PAFN) 捕获船只的信息。所提出的策略在 SAR 数据集、SAR-Ship-Dataset 和 Gaofen-3 上运行良好,在 mAP 和推理时间方面表现优于 YOLOv3 和 Faster R-CNN。

如前所述,另一种方法是 通过 使用图像 SR 方法提高图像的分辨率 来对数据集执行预处理,从而在执行目标检测之前增加图像的细节级别,如 Courtrai 等人 [22] 所执行的那样。各种技术有助于从低分辨率 (LR) 图像生成高分辨率 (HR) 图像,其中单图像超分辨率 [23] 等方法使用单个图像作为网络输入来执行任务。在 [24] 中,作者回顾了基于深度学习的图像 SR 方法,包括基于卷积神经网络 (CNN) 的方法,例如 SR-CNN [25]、深度递归卷积网络 (DRCN) [26]、快速SRCNN (FSRCNN) [27],以及超深度超分辨率 (VDSR) [28]。基于残差学习的 SR 方法包括拉普拉斯金字塔 SR 网络 (LapSRN) [29]、增强型深度 SR 网络 (EDSR) [30] 和 EnhanceNet [31]。同时,一些当前最先进的方法包括循环反投影网络(RBPN)[32]、二阶注意网络(SAN)[33]和基于小波的剩余注意网络(WRAN) ) [34]。在 [24] 中,探索了进一步的单图像 SR 方法。

在 [35] 中,作者使用渐进式监督学习来检测遥感图像 (RSI) 中的显著目标,使用伪标签生成方法以弱监督方式训练网络,而在 [36] 中,作者使用生成式对抗网络 (GAN) 用于超分辨率,并进一步第二阶段使用 稍作修改的SSD 进行检测。 [36] 的结果表明,与 LR 图像相比,图像 SR 提高了检测和分类性能。此外,在 [22] 中,Courtrai 等人使用 EDSR 作为基础网络来开发基于 YOLOv3 的循环 GAN,该循环 GAN 在 GSD 为 1 m 的 LR 图像中有效地用于 8 的比例因子。在 [37] 中,Rabbi 等人结合增强 SRGAN (ESRGAN) [38] 和边缘增强 GAN (EEGAN) [39] 开发了一种端到端方法的边缘增强 SRGAN (EESRGAN)。 EESRGAN 的输出被馈送到检测网络,该网络由更快的基于区域的卷积网络 (FRCNN) 和 SSD 组成。 [37] 中的方法使用 2 和 4 的比例因子提高了分辨率为 15 cm 和 30 cm 的 VHR 卫星图像的检测和分类性能。

1.3. Proposed Method

对于非常低分辨率 (LR) 的图像,需要更高的缩放因子,对于基于残差学习的方法来说,这需要更多的残差块来从训练数据集中捕获足够的细节并生成高分辨率的图像。因此,使用基于平均绝对误差 (MAE) 或均方误差 (MSE) 的传统优化来训练用于检测任务的单个网络将是一项复杂的任务。在这项研究中,目标是利用超分辨率作为基础模型来改进来自卫星/飞行器的 VHR 图像,然后执行小目标的检测,即车辆检测。

我们提出了一种基于超分辨率的循环 GAN,用于遥感和航拍图像中的小目标检测,具有残差特征聚合以提高图像质量,首先使用生成器、鉴别器和 YOLO 检测器的加权损失函数。所提出的方法是一种改进的图像超分辨率网络,带有检测器来执行小物体检测的最终任务。所提出的方法包含三个改进:基于 RFA 的残差块,用于在非常高的缩放因子下改进超分辨率,独立于目标检测网络的目标检测框架,以及用于改进训练检测性能的循环方法。

1.4. Organization of Research

本文的结构如下。第 2 节通过讨论 EDSR 架构及其在 LR 图像上的性能以及缩放因子如何影响检测网络的性能来介绍实际问题。此外,本节在 EDSR 架构中引入了残差特征聚合,改进了生成的 HR 图像。在第 3 节中,我们提出改进基础 EDSR 网络以提高整体性能,使用基于 GAN 的循环方法,同时使用 YOLOv3 的损失函数来训练所提出的网络。在第 4 节中,我们讨论并分享了回归实验的结果,这些回归实验用于测量所提出的残差特征聚合网络和 YOLO (SRCGAN-RFA-YOLO) ,循环超分辨率生成对抗网络在 ISPRS Potsdam 数据上 [40]的性能。研究问题是在地面分辨率被人为降低 16 倍,即 GSD 从 5 cm/pixel 到 80 cm/pixel 的遥感图像中检测和分类车辆。对于尺寸为 4 × 1.5 m2 的车辆,这对应于 5 × 2 像素,总共有 10 个像素。在第 4.1 节中,我们报告了本文检测中讨论的方法的性能,以验证我们方法的性能。在第 4.2 节中,我们将所提出的方法与其他最先进的目标检测器进行比较。在第 4.3 节中,我们展示了可以使用两个数据集,即 Draper Satellite Image Chronology [41] 和 VAID [42] 数据集,使用车辆检测的迁移学习概念将此方法推广到其他数据集,而无需任何训练。第 5 节讨论结果,第 6 节分享结论和未来的研究计划。

2. 用于图像超分辨的残差学习

本节介绍一些基本的图像超分辨率方法,先于最先进的方法 EDSR [30],这是本研究的基本模型。在最近的研究中 [22,37,43,44],EDSR 模型主要用于遥感,其中目标具有各种尺度,并且由于图像的多尺度性质而难以检测。由于提出的框架是通用的,因此可以更改超分辨率方法的选择。图像 SR 侧重于从 LR 图像输入中恢复 HR 图像,因为原则上,恢复的 HR 图像 IRHR 可以表示为超分辨率函数 φ的输出,如等式(1)所示:

![]()

其中φ是负责将 LR 图像转换为 HR 图像的图像 SR 函数,ILR 是输入的 LR 图像,而 ![]() 描述了图像 SR 函数的参数。图像 SR 参数通常是从各种 LR-HR 图像对的网络训练中提取的特征。图像 SR 的基本架构之一是卷积神经网络 (CNN),它分层堆叠以执行特征提取,然后是像素重排层,该像素重排层也执行上采样。使用提取的特征图,像素重排层 对图像内的像素进行重排,并将维度为 {Bt,Ch2,H,W} 的输入特征图转换为 {Bt,Ch,H×f,W×f}。其中,Bt、Ch、H、W 表示特征图的batch号、通道号、高度和宽度,而 f 是缩放或上采样因子。为了将 x 轴和 y 轴上的特征尺寸加倍,需要一个比例因子 2,这 将使像素重排层中的特征图尺寸加倍,如 Shi 等人 [45 Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network] 和 SR-CNN [46] 所执行的那样。与简单的插值方法(例如双三次插值或基于patch的方法 [47])相比,由于网络架构相对较浅,即五个卷积层,这些方法在图像质量和推理时间方面表现明显更好,如 [45] 所示]。

描述了图像 SR 函数的参数。图像 SR 参数通常是从各种 LR-HR 图像对的网络训练中提取的特征。图像 SR 的基本架构之一是卷积神经网络 (CNN),它分层堆叠以执行特征提取,然后是像素重排层,该像素重排层也执行上采样。使用提取的特征图,像素重排层 对图像内的像素进行重排,并将维度为 {Bt,Ch2,H,W} 的输入特征图转换为 {Bt,Ch,H×f,W×f}。其中,Bt、Ch、H、W 表示特征图的batch号、通道号、高度和宽度,而 f 是缩放或上采样因子。为了将 x 轴和 y 轴上的特征尺寸加倍,需要一个比例因子 2,这 将使像素重排层中的特征图尺寸加倍,如 Shi 等人 [45 Real-Time Single Image and Video Super-Resolution Using an Efficient Sub-Pixel Convolutional Neural Network] 和 SR-CNN [46] 所执行的那样。与简单的插值方法(例如双三次插值或基于patch的方法 [47])相比,由于网络架构相对较浅,即五个卷积层,这些方法在图像质量和推理时间方面表现明显更好,如 [45] 所示]。

我们可以选择残差学习,而不是使用传统的 CNN,使用残差块,其中每个残差块包含卷积、归一化和激活层。此外,输入信息被添加到由残差图提取的特征图中,如图 1 所示的 EDSR 方法 [30]。图 1 显示了一个标准的 EDSR 模型,其比例因子为 4,其中共有四个残差使用块,每个残差块都有一个卷积层(绿色)、归一化层(黄色)、ReLU 激活层(蓝色)和像素重排层(棕色)。图 1 中的像素重排层负责缩放因子 2。因此,两层创建了四的整体比例因子。

在图 1 中,通用残差块在传播到下一个模块之前将残差特征与恒等特征融合在一起。因此,后面的块只能看到融合的特征,忽略了基本的残差特征,导致使用这些块的模型性能下降。最近解决这个问题的方法是残差特征聚合 (RFA) [48],它将残差特征中的局部特征连接起来,从而改进了特征的表示,从而改善了最终的 HR 图像。图 2 显示了一个基于四块 RFA 的残差网络,每个块的局部特征在最终输出中聚合,使用 1×1 卷积层。本节将展示 RFA 如何改进图像超分辨率的性能指标,例如 峰值信噪比 (PSNR) 和 结构相似性指数指标 (SSIM)。此外,本研究中使用的数据集是Potsdam的 ISPRS 二维语义标记竞赛数据集 [40];整个数据集包含城市的 VHR 图像(每个patch 6000 × 6000 像素),分为 38 个相同大小的patch,GSD 为 cm/像素。

ISPRS Potsdam 数据集用于根据分割方法将对象分为六类的能力对分割方法进行评估和排名,即建筑物、车辆、表面、植被、树木和背景/杂项对象。然而,该数据集已被用于 [22,49] 等研究中,使用数据集中车辆类别的分类信息来执行车辆检测。总体而言,共有车辆2244辆,其中轿车1990辆,卡车33辆,面包车181辆,皮卡40辆;我们将使用车辆类别,尤其是汽车的像素信息来进行车辆检测。使用的图像在 RGB 波段,本研究中使用的图像的地面采样距离为 5 厘米/像素(数据集的原始分辨率)、40 厘米/像素(缩小了 8 倍)和 80 厘米/像素像素(缩小 16 倍)。原始patches是参考 HR 图像,LR-HR 图像对是使用两个退化函数生成的:[50] 定义的双三次和模糊退化,使用具有 16 个残差块的 EDSR 架构,固定block大小为 64 × 64,并且用于传统残差块和 RFA 块。在训练阶段,EDSR 中使用归一化层对三个色带中的像素进行归一化,并使用 L1 损失函数与 Adam 优化器一起优化 SR 网络;对于总共 N 个 LR-HR 图像对,损失函数(具有参数 p)在等式(2)中给出。

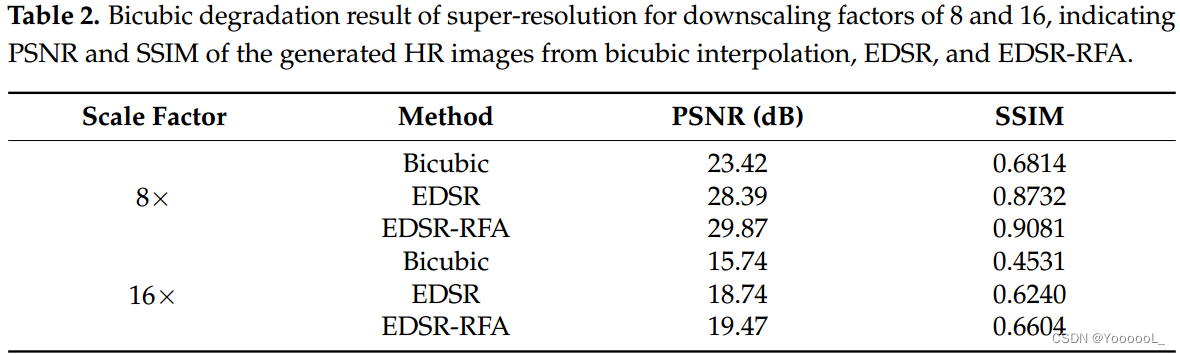

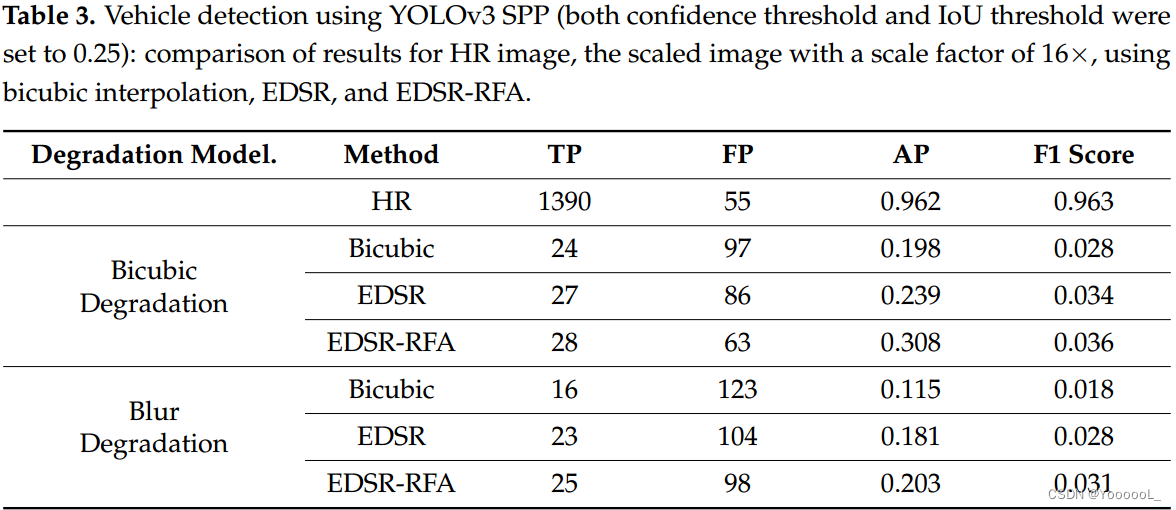

图 3 描绘了缩放因子为 8 的超分辨率,使用双三次插值、EDSR 和带 RFA 的 EDSR (EDSR-RFA) 从 GSD 40 厘米/像素的 LR 图像生成 GSD 为 5 厘米/像素的 HR 图像。与双三次插值相比,观察到图像质量评估 (IQA) 指标(即 PSNR 和 SSIM)的显著改进,并且与 EDSR 方法相比,RFA 进一步提高了图像质量。为了进一步评估性能,我们使用 YOLOv3 [12] 检测器使用SR 图像检测车辆,并将结果与图像的 HR 版本的检测性能进行比较。为了进行评估,我们使用了 Intersection over Union (IoU) 标准,该标准测量在 SR 图像上检测到的框与真值框的重叠。目标检测的阈值设置为 0.25 的 IoU,因为 LR 图像中目标占用的像素很少,低 IoU 值会提高检测性能。因此,在这种情况下,低 IoU 会更可取。 0 到 1 范围内的置信度分数也用于检测。 IoU 和置信度得分值大于 0.25 的框被认为是检测到的目标。对于目标检测评估,我们使用了真正样本(TP)、假正样本(FP)、F1 分数和 AP(平均精度)的指标,使用两种退化模型,即模糊退化(BD)和双三次退化(BI) ),如表 1 所示。EDSR 取得了比基于双三次插值的检测更好的结果,而 EDSR-RFA 取得了最好的结果,对于 BI 和 BD 退化,AP 分别为 0.889 和 0.844。(原文写错了,写的数值是F1 score,不是AP)重建图像的图像质量指标总结在表 2 中,比例因子为 8 和 16。

值得注意的是,对于 8 的比例因子,检测性能是足够的,但是当我们进一步将比例因子增加到 16(对应于 80 cm/像素的 GSD)时,检测性能急剧下降。 EDSR 和 EDSR-RFA 在使用因子 16 生成的 LR 图像上表现不佳,如图 4 所示,这表明重建的图像质量很差。

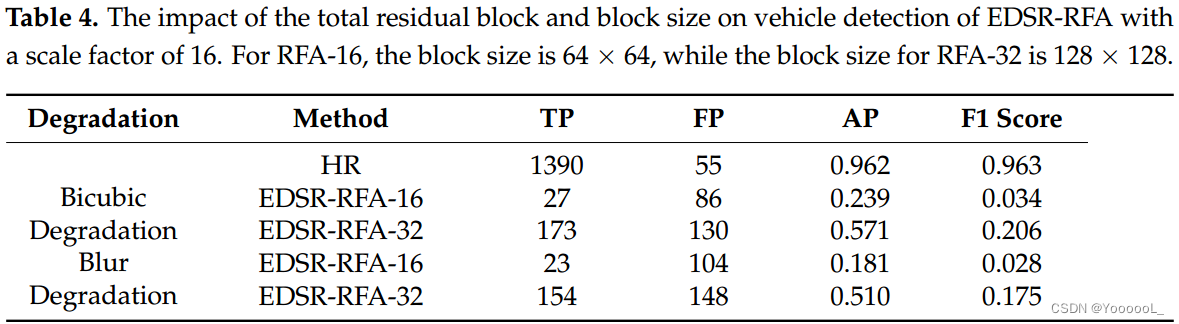

对于 16 的比例因子,最佳图像质量指标(PSNR:19.47dB 和 SSIM:0.66)如图 4 所示,由 EDSR-RFA 报告,导致双三次和模糊退化的检测 AP 分别为 0.308 和 0.203 ,分别(见表3)。虽然采用图像超分辨率提高了 LR 图像的分辨率,但仍然不足以让检测器进行目标检测。此外,正如之前的研究中提到的,向网络中添加更多的残差块可以提高图像质量,因此我们向网络管道中添加了 16 个块,残差块的总数更改为 32。块大小也发生了变化从 64 × 64 到 128 × 128;这些变化导致检测 AP 的增加,但代价是训练时间更长,网络参数显著增加。训练时间增加了 445%,网络参数从 1,145,671 增加到 3,742,897 (327%),同时 图像质量(见图 5)和检测 AP 增加(见表 4)。双三次和模糊退化的检测 AP 增加了约 33%,但 与真实 HR 图像的检测 AP 相比,整体检测 AP 仍然较低(即 0.962)。

具有 32 个残差块的 EDSR-RFA 在目标检测方面仍然存在不足,并且由于使用 Adam 优化器进行优化的限制,整体训练仍然不稳定,从而为块大小为 128 × 128 的数据集的相同分布提供不同的结果。伴随这个问题,网络参数和训练时间显著增加;因此,添加更多的残差块不是最佳选择。在下一节中,我们对基础 EDR-RFA 方法进行了一些修改,以通过更稳定的图像超分辨率来提高检测精度。

3. Methodology

3.1. Basic Network Architecture for Image SR

与其他 SR 网络一样,我们使用通用的三部分网络,即 用于提取浅层特征的初始层,由残差块组成的中间部分用于进一步提取特征 ,而 末端部分执行图像重建。初始层 (F0) 生成的浅层特征由下式给出:

![]()

其中S是初始层的特征提取函数,F0是提取的特征; 这被转移到残差块,以使用图 2 所示的残差块基于残差特征聚合进行深度特征学习。主干部分由48个RFA残差块组成,对于K个残差块,特征函数相关如下所示:

![]()

其中 Mk 表示第 k 个残差模块,它具有输入 Fk−1 和输出 Fk ,重建部分负责对提取的特征 Fk 使用,

![]()

其中 ISR 是超分辨图像,而 ![]() 是重建函数,它等于

是重建函数,它等于![]() ,如等式 (1) 所示,这是网络的整体 SR 函数。

,如等式 (1) 所示,这是网络的整体 SR 函数。

所提出的网络使用 L1 损失函数进行了优化,如等式(1)所示。

3.2. Network Improvements

在本节中,提出了对第 3.1 节中提出的主要网络的进一步改进,以提高航空/卫星图像中小目标的整体检测精度。通过使用改进的 Wasserstein 生成对抗网络 [50] 制作循环 GAN 来改进整个网络,并且网络的生成器在第 3.1 节中定义。最后,使用 YOLO 检测器的损失函数,添加了一个 YOLO-v3 检测器以方便目标检测和训练网络。

3.2.1. Using Generative Adversarial Network Pipeline

在计算机视觉和模式识别中,生成对抗网络 (GAN) 因其通用性而被广泛使用,从二元分类的简单任务到学习图像超分辨率,使用生成器 以及 对生成器输出进行评级的鉴别器。对于超分辨率,第一个基于 GAN 的提议是 SR-GAN [51],在生成器网络中使用基于 EDSR 的残差块; Jiang 等人在 [39] 中使用了类似的方法,提出了用于遥感应用的边缘增强超分辨率 GAN。我们修改了 SR-GAN 中的生成器网络并合并了残差特征聚合(见图 6)以增强生成器的性能。生成器网络的目标是生成 SR 图像,然后由鉴别器 D 对其进行评估,以确定生成器的输出是真实的(HR 图像)还是假的。生成器使用来自鉴别器的反馈来微调网络参数,使用 L1 损失函数生成更逼真的图像,同时鉴别器网络也在每次迭代中自我改进。

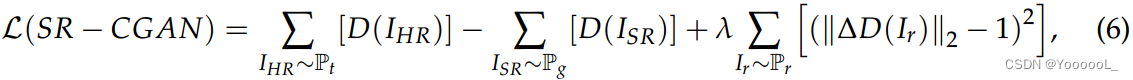

第一个改进是合并,使用生成器网络 Gen,如图 6 所示,使用基于 RFA 的 32 个大小为 128 × 128 的残差块,而鉴别器网络 D 与 SR-GAN 中的相同,用于评估生成的 HR 图像。我们还利用了 Arjovsky 等人 [50] 提出的 Wasserstein GAN 形式的改进,它在鉴别器的损失函数中使用梯度惩罚,由以下给出:

其中 IHR、ISR 和 Ir 分别是 HR 图像、SR 图像和从 IHR 和 ISR 中均匀采样的随机图像,而 Pt 、Pg 和 Pr 是真实 HR 图像、生成图像和随机采样的概率密度分布分别是图像,而 l 是梯度惩罚系数,按照 [52] 中的建议,它被指定为 10 的高值。

3.2.2. Cyclic Network

下一个改进涉及在 GAN 中使用循环方法,正如 Zhu 等人 [53] 提出的那样,通过添加另一个 GAN 从第一个生成器的输出生成 LR 图像,如图 7 所示。

将第二个生成器生成的最终 LR 图像与原始 LR 图像进行比较。使用损失函数,它调整网络参数如下:

其中 IHR 和 ILR 是 HR 和 LR 图像; GenHR 和 GenLR 是对应的 HR 和 LR 生成器,如图 7 所示。

如等式(7)所示,循环 GAN 的损失函数显示了我们的显著改进,这确保了两个 GAN 网络通过评估彼此的输出来运行以最小化整体的损失函数。将 GenLR 生成的最终重建 LR 图像 (IRLR) 与使用真实 HR 图像生成的实际 LR 图像 (ILR) 进行比较,使用双三次和模糊退化。关键思想是确保两个低分辨率图像(即 IRLR 和 ILR)相同,从而确保生成的 HR 图像也接近真实的 HR 图像。此选择的进一步结果和分析显示在第 4 节中。

3.2.3. Detection Network

我们进一步添加了最先进的目标检测网络 YOLOv3,以对循环 GAN 生成的 SR 图像执行最终检测任务。主要目标是确保生成的 HR 图像中的感兴趣对象类似于真实的 HR 图像,因此使用 YOLOv3 在整体模型中确保这一点。 YOLOv3 检测网络是在 HR 图像上训练的。因此,在将其集成到循环 GAN 模型中时,其网络权重是固定的;生成的模型如图 8 所示。在训练阶段,生成的 HR 图像被送入 YOLO 网络以检测目标,同时预测框的坐标用于计算 YOLO 网络的损失函数,即 L(Y)。计算总损失函数,并使用反向传播,使用总损失的梯度更新生成器和鉴别器网络的权重。

如图 8 所示,所提出的方法包含三个组成部分;因此,使用了三个不同的损失函数,如等式(8)-(10)所示:

其中 L(G) 是生成器损失,pram 是参数,N 是样本总数,![]() 是第 i个生成的 HR 图像,

是第 i个生成的 HR 图像,![]() 是真值 HR 图像。

是真值 HR 图像。

基于改进的 Wasserstein GAN [8] 的基于 48 ResBlock 的生成网络 G(ILR, γ),块大小为 64 × 64,内核为 3 × 3,具有高梯度惩罚值的判别器损失函数中的系数如式(9)所示:

![]()

其中 IHR、ISR 和 Ir 分别是 HR 图像、SR 图像 和 从 IHR 和 ISR 均匀采样的随机图像,而 Pt 、Pg 和 Pr 是真实 HR 图像、生成图像和分别随机采样图像,而 l 是梯度惩罚系数,按照 [52] 中的建议,它被分配了一个高值 10。

检测网络 (YOLO) 损失函数由以下给出:

其中 DG 和 A 表示与 YOLO 检测器关联的 检测网格 和 锚框的数量,而 (x, y, h, w) 和 (x', y', h', w') 描述了真值的坐标和预测的边界框; (x, y) 和(x', y') 表示中心点的坐标,而(h, w) 和(h', w') 表示边界框的尺寸。图8所示网络的整体损失如下:

![]()

其中 μ1、μ2 和 μ3 是与生成器、鉴别器和检测器网络相关联的权重。在训练过程中,权重被赋值为μ1 = 0.95,μ2 = 10,μ3 = 0.1,以保证三个损失函数的误差范围相似,保证了三个方面的均衡学习。使用超分辨率实现 HR 图像,使用生成器,鉴别器确保图像逼真,检测网络执行目标检测和定位。

3.3. Implementation Details

所提出的方法是在 PyTorch 框架上使用具有 16 GB RAM 和 Nvidia Titan XP 图形处理器的 Ubuntu 20.04 计算机实现的。选择 10 的梯度惩罚系数来训练 Wasserstein GAN,而总损失函数权重 m1、m2 和 m3 的赋值分别为 0.95、10 和 0.1。该网络总共训练了 250 个时期。

4. Results

在本节中,我们将讨论和评估所提出的新型 SRCGAN-RFA-YOLO 网络所取得的成果。最初,我们专注于目标检测的主要任务,并将结果与本研究中报道的主流方法进行比较。在第 4.2 节中,我们 在 0.10 的 IoU 的 AP 方面将我们的方法的结果与最先进的目标检测器进行了比较。最后,我们讨论了迁移学习的概念,使用预训练网络在其他航空数据集上执行图像超分辨率和目标检测,例如 Draper Satellite Image Chronology [41] 和 VAID [42]。

4.1.提高图像质量和检测精度

图 9a 显示了各种方法在图像质量指标(PSNR 和 SSIM)方面的 SR 结果。 LR 版本的比例因子为 16,对应于 80 厘米/像素的 GSD。图像 SR 方法、EDSR 和 EDSR-RFA 单独使用时,无法实现如图 9a 所示的高图像质量,而循环方法,即 SRCGAN 和 SRCGAN-RFA-YOLO,可以生成高质量的超分辨率图像PSNR 分别为 28.13 dB 和 30.41 dB。图 9b 中的缩放图像显示了各种方法恢复细节的质量。图 9 显示,循环模型通过分别为 SRCGAN 和 SRCGAN-RFA-YOLO 使用 0.86 和 0.93 的 SSIM 重建图像表现最佳。由于第 3.2 节中介绍的改进,所提出的 SRCGAN-RFA-YOLO 方法取得了最佳结果,尤其是在恢复低分辨率图像中的纹理信息方面,如图 9a 所示。

最后,我们比较了所提出的 SRCGAN-RFA-YOLO 方法与双三次插值、EDSR、EDSR-RFA、SRGAN 和 SR-CGAN 的训练性能和精度/召回曲线 250 个时期。我们方法的训练性能在 AP 方面超过了所有其他报道的方法(见图 10a);同时,我们的方法在几个 epoch 内获得了更高的 AP,这表明 所提出的方法收敛速度快且训练稳定。精确率/召回率曲线也显示了图 10b 中我们方法的优越性能。图 10b 中的绿线表示 HR 图像的精度/召回曲线。所提出的 SRCGAN-RFA-YOLO 方法的精度/召回率曲线以红色显示。与 EDSR 和 EDSR-RFA 相比,我们的方法接近 HR 图像实现的性能,从而为低分辨率图像提供卓越的检测性能。

检测性能根据精度、召回率和 F1 分数来衡量,如表 5 所示。

如表 5 所示,SRCGAN-RFA-YOLO 报告 ISPRS Potsdam 数据集的 IoU 为 0.10,F1 得分为 0.86。与 EDSR-RFA 的检测 F1 分数相比,我们的方法报告 F1 分数增加了 20.5 倍。

4.2.与其他目标检测器的性能对比

在本节中,通过使用 RetinaNet [15]、SSD (VGG16) [14]、EfficientDet [ 54] 和 Faster R-CNN [10]。为了避免方法偏差,我们使用 HR 图像训练所有方法,在 ISPRS Potsdam 数据集上使用 512 × 512 像素的输入图像大小。 SRCGAN-RFA-YOLO 的检测性能与最先进的目标检测器在比例因子为 8 和 16 时进行了比较,如表 6 所示。对于 HR 图像,所有目标检测器的检测性能几乎相似,但随着比例因子的增加,所提出的方法达到了最高的 AP 值,特别是对于比例因子为 16 的 GSD 为 80 cm/像素。单幅图像推理时间表明,所提出的方法在为更高比例因子提供最佳 AP 的同时,具有相对较低的推理时间,即每幅图像 33.67 毫秒。

所提出的 SRCGAN-RFA-YOLO 生成的超分辨率图像被用作上述目标检测器的输入,表 7 显示了 IoU 为 0.10 的 AP 检测性能。

如表 7 所示,YOLOv3、SSD (VGG16)、EfficientDet 和 Faster R-CNN 在 HR 上实现了相似的检测性能,这表明 HR 图像性能不依赖于检测器的选择,而对于 SR 图像(对于尺度因子为 16),最好的结果是 Faster R-CNN,AP 为 88.81%。与双三次插值相比,YOLOv3 检测器实现了 AP 的最显著变化 (~54%),因为 SSD (VGG16)、EfficientDet 和 Faster R-CNN 为双三次插值图像实现了相对较高的 AP 值。

SSD (VGG16) 和 EfficientDet 在双三次插值图像上获得了更高的 AP 值,这主要是因为训练过程中内置的图像增强方案。输入的图像和边界框针对不同的比例值和纵横比进行重新采样 [14,54]。同样,Faster R-CNN 也因为引入了区域生成网络 (RPN) 而实现了改进的 AP,RPN 使用注意力机制来提高检测精度。提出的框架允许集成不同的目标检测器;因此,使用 SSD (VGG16)、EfficientDet 和 Faster R-CNN 等目标检测器将使整体 AP 提高 10%,如表 7 所示。

4.3.在不同的遥感数据集上应用迁移学习

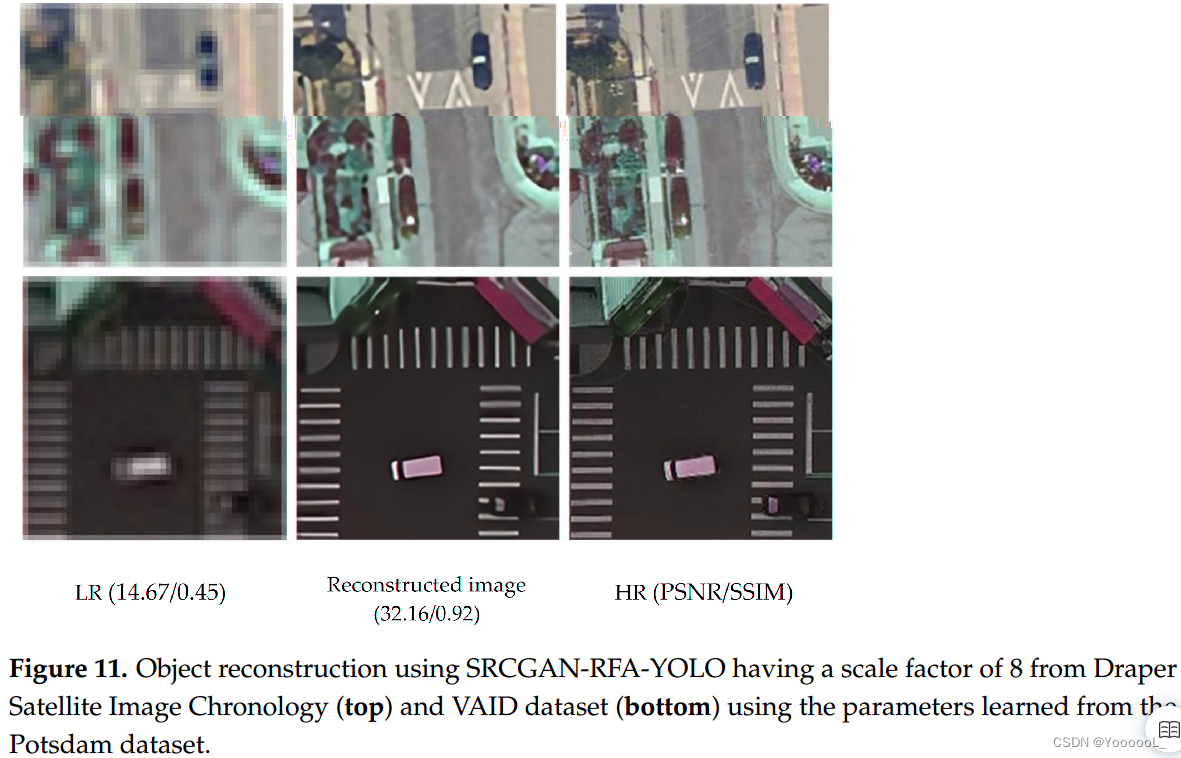

本节讨论通过在不同的遥感数据集上执行目标检测来进行迁移学习的概念,使用新颖的 SRCGANRGA-YOLO 在 ISPRS Potsdam 数据集上学习的参数。为这项任务考虑的两个数据集是 Draper Satellite Image Chronology [41] 和 VAID [42]。图 11 显示了数据集上图像超分辨率的结果。为了比较性能,我们缩小图像以匹配 80 厘米/像素的 GSD:VAID 数据集的 GSD 为 12.5 厘米/像素,因此,使用比例因子 6 生成 LR 图像;对于 Draper Satellite Image Chronology,GSD 为 10 厘米/像素,因此使用比例因子 8 生成 LR 图像。

图 11 中的结果描述了 所提出的方法 以端到端的方式 使用预训练网络 对低分辨率卫星图像执行小目标检测的重要性。

5. Discussion

分析来自同一数据集的其他图像块,我们测量了各种方法的检测性能,包括 SRCGAN-RFA-YOLO。我们进一步研究了 IoU 对检测性能的影响,表 8 显示了三个不同 IoU 值(即 0.10、0.25、0.50)下 AP 的变化。最好的结果以粗体突出显示,而第二好的结果则用下划线标出。

值得注意的是,SRCGAN-RFA-YOLO 在所有三个 IoU 值上都取得了最好的 AP,SRCGAN 在 0.10 和 0.25 的 IoU 上取得了第二好的 AP,而 SR-GAN 在 0.50 的 IoU 上取得了第二好的 AP。对于小目标检测,选择 0.10 的低阈值作为 IoU,所提出的方法实现了 78.67% 的 AP 值,与 YOLO 检测器一起使用时,比 EDSR 方法实现的 AP 高出约 32%。此外,使用 YOLO 网络的损失函数训练我们的 SRCGAN-RFA 将 AP 提高了 11.5%,突出了所提出方法的优越性能。

与基于双三次插值的检测相比,所提出的方法在 IoU 为 0.10 时 AP 增加了 54.3%,而与 EDSR 方法相比,AP 值增加了 31.8%。 AP 的这些增加非常显著,因为 LR 图像的空间分辨率为 80 厘米/像素,比例因子为 16,对于这种低分辨率图像,所提出的方法实现了最先进的性能。

在图 12 中,对于 LR 图像,YOLO 网络没有检测到任何车辆,而基于残差特征聚合的方法成功检测到所有五辆车,而 SRCGAN-RFA-YOLO 在图像质量置信度得分和 AP 方面取得了最佳性能。

提出的框架允许集成不同的目标检测器;因此,使用 SSD (VGG16)、EfficientDet 和 Faster R-CNN 等目标检测器将使整体 AP 提高 10%,如表 7 所示。

两个数据集的迁移学习结果如图 11 所示。虽然我们的方法改进了图像,尤其是 LR 图像中的车辆,但由于缺乏特征,我们的方法没有生成复杂的纹理;然而,超分辨率图像实现了改进的目标检测。

该方法的新颖之处有三:首先,提出了一个框架,独立于研究中使用的最终目标检测器,即 YOLOv3 可以替换为 Faster R-CNN 或任何目标检测器来执行目标检测;其次,在生成器中使用残差特征聚合网络,显著提高了RFA网络检测复杂特征时的检测性能;第三,整个网络被转化为循环 GAN,提高了训练、测试和验证的准确性,这也从图 10a 中可以明显看出。

所提出方法的检测性能是在从 Draper 卫星图像年表和 VAID 数据集的选定图像创建的独立数据集上测量的(图像缩小以匹配 80 厘米/像素的 GSD,即低分辨率)。检测性能根据精度、召回率和 F1 分数进行衡量,如表 9 所示。

如表 9 所示,SRCGAN-RFA-YOLO 使用从 ISPRS Potsdam 数据集的 LR-HR 图像对学习的网络参数,报告独立数据集的 IoU 为 0.10 的 F1 分数为 0.84。图 13 显示了 SRCGAN-RFA-YOLO 的检测示例。

在独立数据集上的性能表明了所提出方法的有效性。如图 13 所示,错误分类示例包括阴影下的车辆 或 嵌入相似颜色背景中的车辆。然而,使用预训练网络,SRCGAN-RFA-YOLO 获得了 0.84 的 F1 分数。

6. Conclusions and Future Directions

低分辨率图像的目标检测具有挑战性,当直接用于低分辨率图像时,通用检测器表现不佳。在卫星图像的情况下,当处理低分辨率图像时,感兴趣的对象(在我们的例子中是车辆)占用很少的像素,并且我们已经证明在检测任务之前使用超分辨率可以显著提高检测精度。我们的方法针对遥感图像空间分辨率较低的挑战性条件,并且在大多数遥感卫星图像的情况下,由于成像有效载荷的限制,图像分辨率不是很高。目标检测网络的提出的改进 包括 使用基于残差特征聚合的超分辨率方法 (EDSR-RFA) 来收集捕获的复杂特征,并通过 采用基于循环 GAN (SRCGAN) 的方法 并使用目标检测网络 (YOLOv3) 来训练网络和检测任务来改进模型。结果表明,与双三次插值图像上的目标检测相比,我们的方法将 AP 提高了 54.3%,与最先进的 EDSR-RFA 方法相比,所提出的 SRCGAN-RFA-YOLO 实现了 29.4% 的 AP 提升。此外,迁移学习表明,当我们的方法应用于其他数据集时,使用从本研究中使用的数据集中学习的参数,可以显著提高图像质量。

与其他目标检测器(YOLOv3 和 SSD)相比,所提出方法的推理时间相对较长(33.67 毫秒),因为残差特征聚合确保了复杂特征的收集,从而增加了网络参数。下一步是将所有提出的改进组合到一个框架中,并将其部署为低分辨率图像的通用目标检测器。此外,我们计划在大数据集上训练网络,例如 BigEarth [55],并发布用于航空和遥感图像中目标检测任务的预训练网络。