Preface

这是我的Andrew Ng机器学习课程学习的开始,从这里开始我将一步一步的进入机器学习的领域,为自己以后的学习打下基础。

Andrew Ng

吴恩达(1976-,英文名:Andrew Ng),华裔美国人,是斯坦福大学计算机科学系和电子工程系副教授,人工智能实验室主任。吴恩达是人工智能和机器学习领域国际上最权威的学者之一。吴恩达也是在线教育平台Coursera的联合创始人(with Daphne Koller)。

2014年5月16日,吴恩达加入百度,担任百度公司首席科学家,负责百度研究院的领导工作,尤其是Baidu Brain计划。

2017年10月,吴恩达将出任Woebot公司新任董事长,该公司拥有一款同名聊天机器人。

Machine Learning

Tom Mitchell:对于一个计算机程序而言,给它一个任务T和一个性能测量方法P,如果在经验E的影响之下,使得T对于P的测量结果有所改进,就称该计算机程序从经验E中学习。

分类:

监督学习(Supervised Learning) 回归问题(连续数据) 分类问题(离散数据)

学习理论(Learning Theory)

无监督学习(Unsupervised Learning) 聚类问题 ica

强化学习(Reinforcement Learning)

Linear Regression

1. 问题导入:

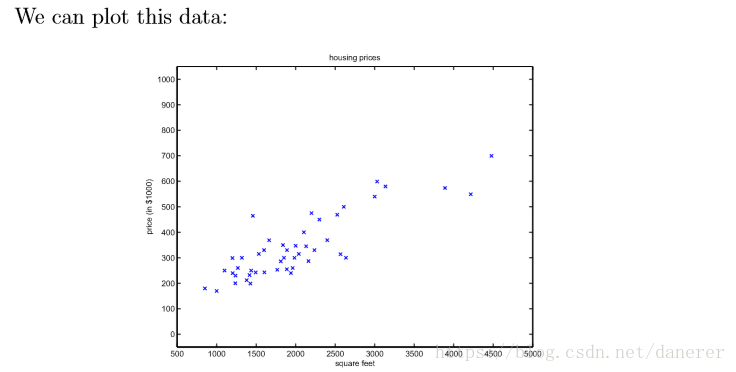

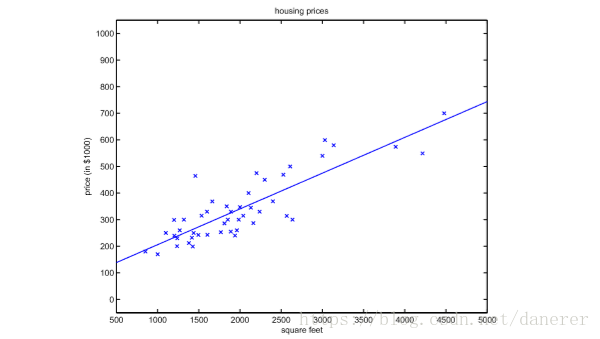

Andrew Ng老师举了一个关于房价预测的例子,即从给定的一组数据通过一定的算法模型来预测房子大小与价格之间的关系。

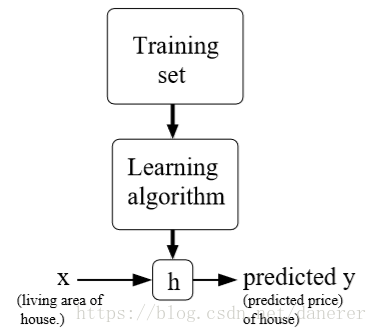

接着我们需要设计在下面一张图片中的学习算法来生成假设函数(预测函数)h(x),在这里通过将所给数据会知道二维坐标系中,我们可以通过这些散落在坐标系中的点大致预测出房大小与房价应该是正相关的线性关系。

故,可以设假设函数h(x)=ax+b的传统形式,得出下图中的直线:

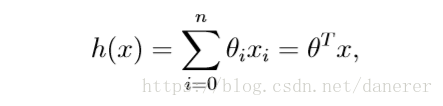

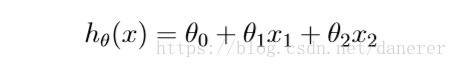

上述中,我们只使用到一个特征(房大小)来预测房价,在实际情况中,我们往往需要考录多个特征来预测房价,故假设函数h(x)就可以表示为:

进而得出:

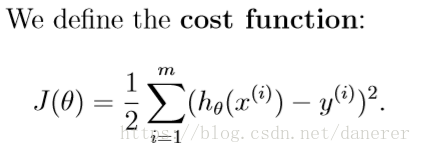

2. Cost function

现在我们的问题就变成了如何求得h(x)中的

。

这样的话,我们就需要使用代价函数(cost function)来度量预测值与真实值之间的差距。

这里乘上一个1/2是为了后面方便计算

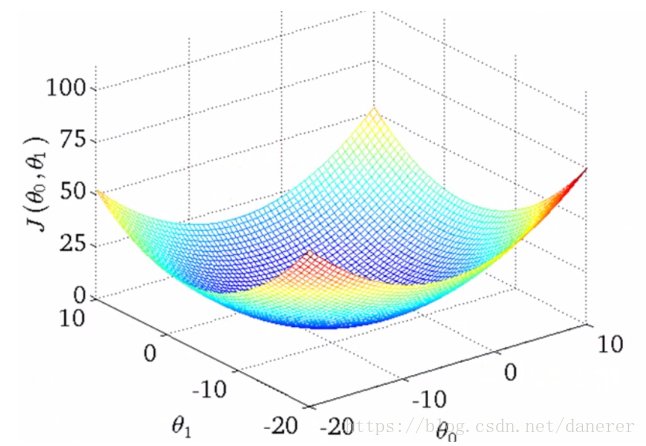

我们可以通过下图中的最低点感受一下代价函数的最低点:

3. Gradient Descent(LMS)

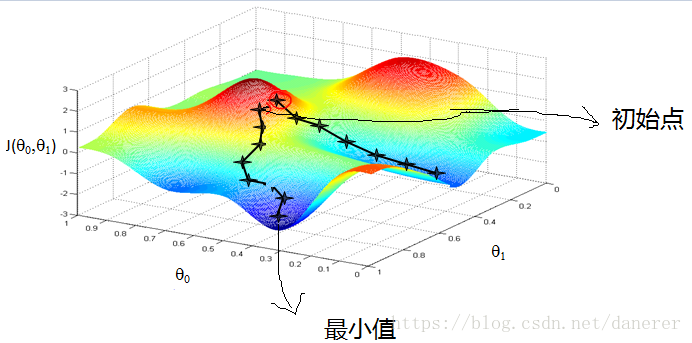

在大学高等数学课本中,关于梯度的理论说明了函数在沿着梯度的方向增加或减少的速度是最快的。而梯度的求法就是对该函数做偏导运算。

梯度下降法的核心思想就是,给定一个初始点,在该点处求其梯度,迭代得到下一个 点。直到梯度为零时结束。

为什么是梯度为零时结束

当迭代点是最优时,其对应的梯度为零称之为无约束问题解得一阶必要条件

证明的核心思想是利用最优点处利用泰勒展开,因为已经是最优点,所以在其附近的点函数值近似相等,便可以得到梯度为零的结论

详细证明参见 李董辉 数值最优化算法与理论(第二版)19页

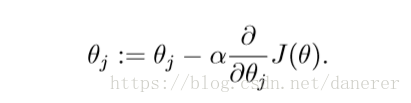

梯度下降算法中的迭代过程:

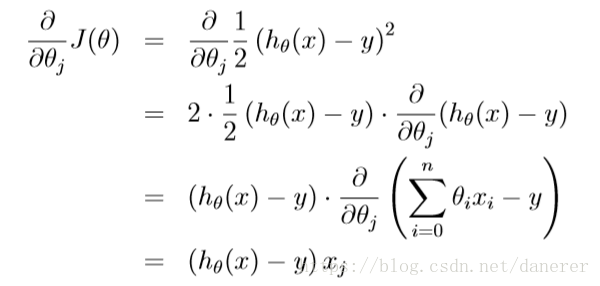

一组数据的梯度下降过程,在这里就体现了加上一个1/2的优越性:

进而得到

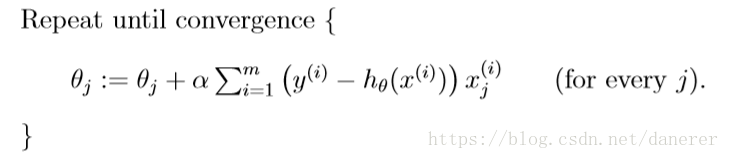

这里的是学习速度,它决定了算法在梯度下降时的步子的大小,通常是依照经验设置。如果太小,学习速度太慢不满足要求;如果太大,会导致算法越过最小值。

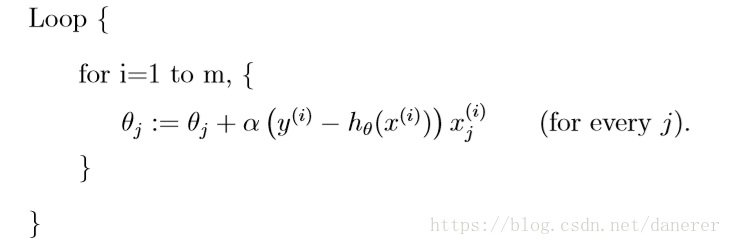

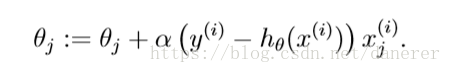

进而我们得到梯度下降的算法描述:

4. Stochastic Gradient Descent(LMS)

对比上述的梯度下降算法每一次都需要对于整个数据集进行求和,在数据集十分庞大的时候,这将是一件十分好费时间的工作。

所以对于巨大的数据集,我们使用随机梯度下降(每一次使用一个数据样本):

5. The Normal Equations

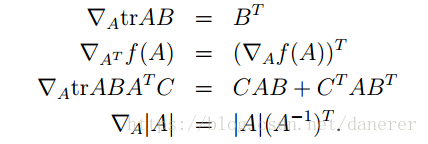

线性代数基础概念:

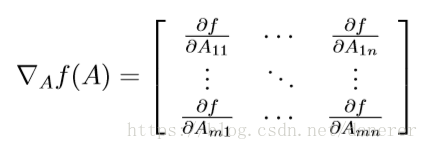

函数f对矩阵A的倒数

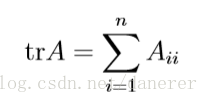

矩阵A的迹:

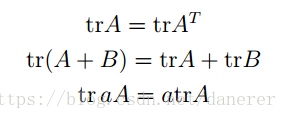

关于迹与梯度的一些推论:

证明:

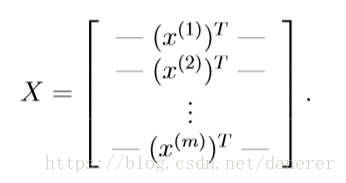

输入矩阵X:

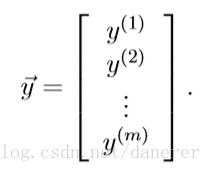

输出矩阵Y:

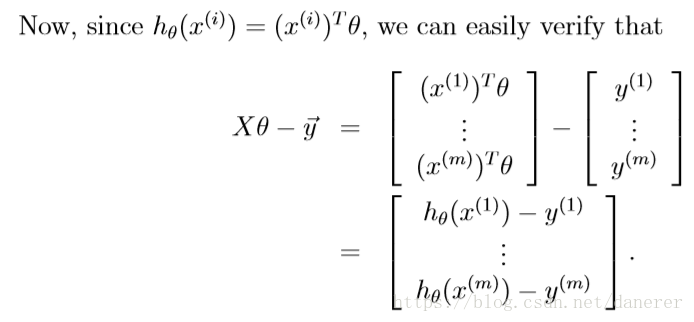

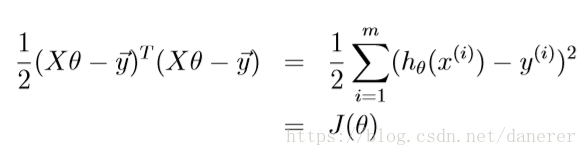

所以:

由于:

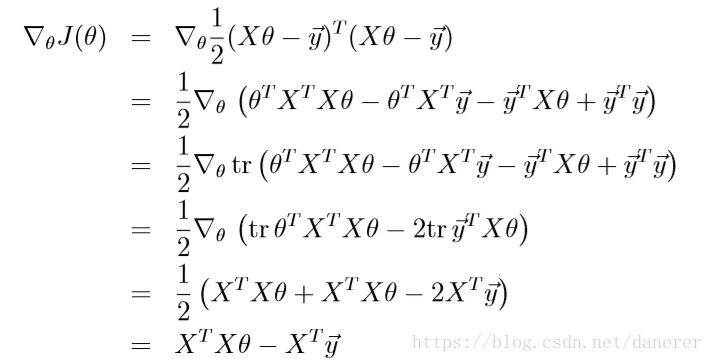

所以:

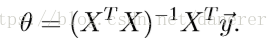

进而我们得到正规方程的算法描述:

所以,最小

:

参考文献

[1] https://blog.csdn.net/qq_27008079/article/details/70527140#12-cost-function

[2] https://blog.csdn.net/xiaocainiaodeboke/article/details/50371986

[3] http://www.qiujiawei.com/matrix-calculus-1/