Preface

主要内容:

Newton’s Method(牛顿法)

Newton’s Method

step 1 :问题导入

现需要对函数

f(θ)

,找到一个合适的

θ

使得

f(θ)=0

。

step 2:迭代

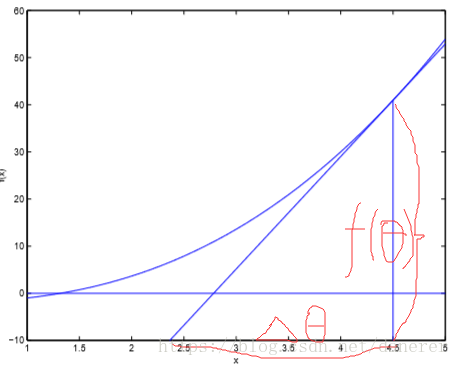

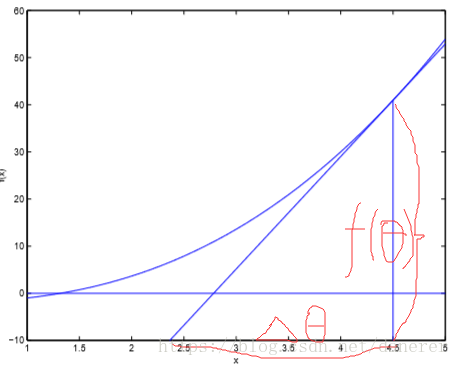

牛顿法搜索动态示例图:

根据导数定义:

f′(θ(0))=f(θ(0))ΔΔ=f(θ(0))f′(θ(0))θ(0)−θ(1)=f(θ(0))f′(θ(0))θ(1)=θ(0)−f(θ(0))f′(θ(0))即,θ(t+1)=θ(t)−f(θ(0))f′(θ(0))(1)(2)(3)(4)(5)

注:

f(θ)

的初始值对函数无影响,

θ(0)

表示

θ=0

。

step 3:求最大似然函数

回顾上一篇文章Andrew Ng机器学习课程笔记(二)之监督学习之Linear Regression and Logistic regression 中使用梯度法求最大似然函数,在这里我们将使用牛顿法来求最大似然函数。

牛顿的方法提供了一种方式去

f(θ)=0

。如果我们想使用它的一些功能使得似然函数

ℓ(θ)

最大化?

ℓ(θ)

极大值对应的点,其一阶导数

ℓ′(θ)

为零。所以,让

f(θ)=ℓ′(θ)

,我们可以使用相同的算法来最大化

ℓ(θ)

。

显然,这里

θ

的更新规则已经变成了,

θ(t+1)=θ(t)−ℓ′(θ)ℓ′′(θ)(6)

step 4:多维特征推广

当

θ

为一个大于一维的向量时,我们得到的迭代规则为:

θ(t+1)=θ(t)−H−1∇θℓ(θ)(7)

其中

H

为Hessian矩阵:

Hij=ℓ2(θ)∂θi∂θj(8)

参考文献

https://www.cnblogs.com/shixiangwan/p/7532830.html