论文链接: https://ieeexplore.ieee.org/document/8907836

文章目录

一 、摘要

尽管近年来取得了进步,但跨场景人员的重新识别仍然具有挑战性,这主要是由于行人通常被高度复杂的环境所包围。 在现实中,人类感知机制可以自适应地找到适合行人识别的上下文时空线索。 然而,由于不断增加的计算成本,常规方法在自适应地利用长期时空信息方面不足。 此外,基于CNN的深度学习方法由于内置上下文搜索操作的不可微分性而难以进行优化。

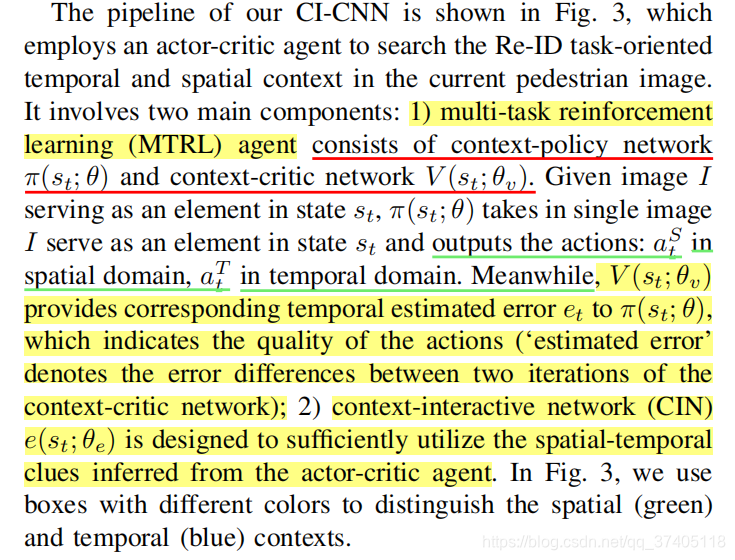

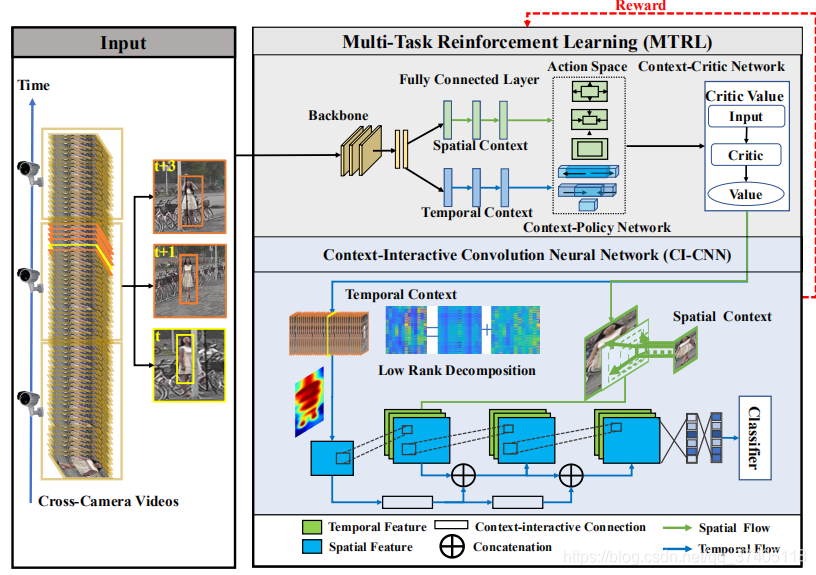

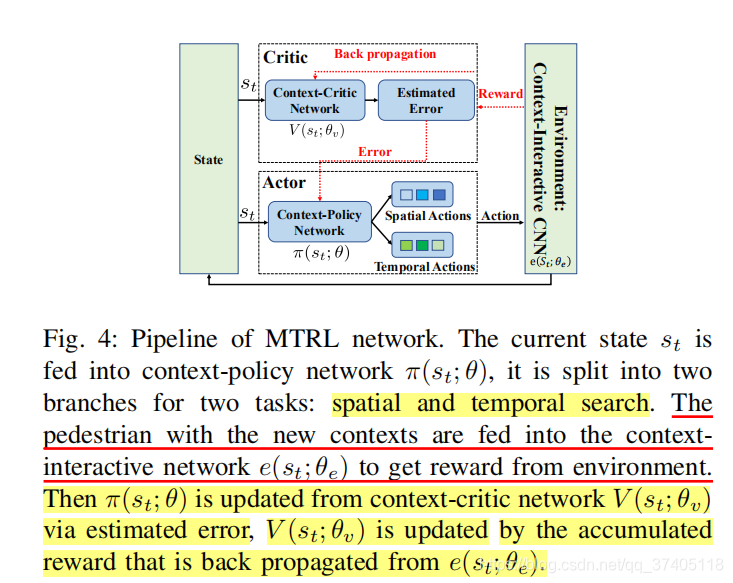

为了改善这种情况,本文提出了一种新颖的上下文交互CNN(CI-CNN),通过嵌入多任务强化学习(MTRL)来动态查找时空上下文。 CI-CNN通过使用行为者批判代理同时捕获时空上下文来简化多任务强化学习,它包括上下文策略网络和上下文批评网络。 前者网络学习确定最佳空间上下文区域和时间序列范围的策略。 基于推断的时空线索,后一个线索集中于识别任务并为策略网络提供反馈。

因此,CI-CNN可以在空间和时间域中同时放大/缩小感知场,以便与环境进行上下文交互(进行反馈很关键)。 通过促进人与环境之间的协作互动,我们的方法可以在各种公共基准上取得出色的表现,这证实了我们假设的合理性,并验证了我们的CI-CNN框架的有效性。

(CI-CNN 通过MTRL来找下上文线索,然后通过使用行为批判代理进行多任务强化学习,包括了策略和批评网络,策略提供最佳属性(空间大小和时间序列长度),批判用来判断好不好做出反馈)

二 、 INTRODUCTION

(spatial)目前存在的方法常常关注于在空间领域抑制背景,单独处理一张图片的背景和前景。目的就是找到不同场景下相同的区域。现实中不好行得通,因为各种因素导致。遮挡 分辨率等。

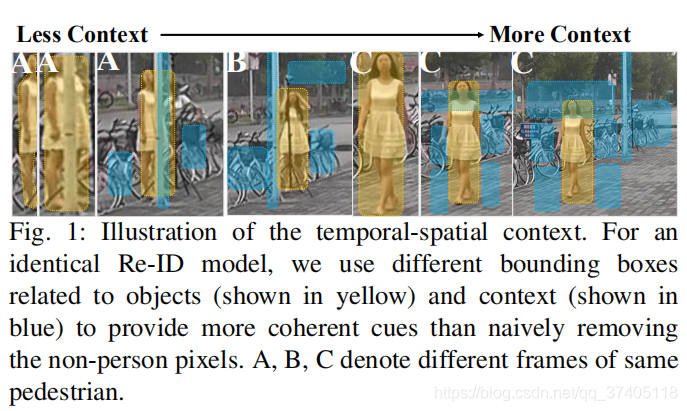

总之,单个图像/行人区域不足以完成跨领域的行人重识别任务,太多或太少的上下文会影响特征提取,只有适当的上下文才能促进特征提取以提高性能。 此外,适当使用背景[5]也可以提高最终的识别结果。

直观地说,空间上下文表示周围背景与目标行人之间的关系。 例如,在路上行走的行人和骑在 自行车上的人有两种主要的姿态形状。

(temporal)时间内容因素也可以提高表征。

【一般常用在视频检测序列那种】【6 7 8 9】,相关方法把视频序列所有帧权重相同,造成计算耗费大,并且不好收敛。

【10 11 12】 加入注意力在关键帧上边。 然而,这些方法不能很好地平衡背景和人的前景区域。(前景是你感兴趣的对象。背景却不是。)

recently,通过对个体的时间和空间相关运动进行建模,同时抑制人类交互和活动识别中不相关的运动,已经取得了令人满意的性能,此外,我们观察到,按时间顺序汇总行人区域的效果要好于利用单个图像信息,因为单张图片划分不相关区域会模糊,但是时间序列可以起到一个很好地对不相关背景的抑制效果。

---------------------------------------------------------------------------------------------------------------------------------------------------------------------

尽管已有研究调查了背景的影响,但他们很少研究如何动态地为每个特定的行人区域找到合适的时空背景。 由于人类视觉和记忆系统通过以时空协作方式综合判断连续的动作和周围环境上下文来识别人,因此,为了模仿这种机制,我们设计了另一种上下文感知模型来利用时空上下文信息。行人在不同的视角下外观特征可能差别比较大,但是他的上下文信息关系是稳定的。同时,为了满足适当的上下文范围,卷积层中的固定感知字段由上下文的包装操作符动态放大/缩小,如图2所示。感受野随着行人图片的上下文信息变化而变化。

然后网络可以基于辨别能力动态地提取当前图像的上下文特征。 而且,时间语境可以为被遮挡和姿势变异的行人提供内在线索。 我们通过在适当的时间范围内将帧分解为背景和与行人相关的组件来嵌入时间线索。 至于行人的区分性表示,它已经被CNN方法很好地解决了[15]。 在本文中,我们主要侧重于利用上下文线索。 我们使用自适应的时空上下文学习过程来提供更连贯的线索,而不是简单的去除非人像素。

从某种意义上说,不同人的Re-ID任务可以看作是人与时空环境的相互作用,其中行人的区域提供了外观信息,周围的区域和相关的时间序列为区分前景对象和背景提供了最佳的先验条件(图1)。

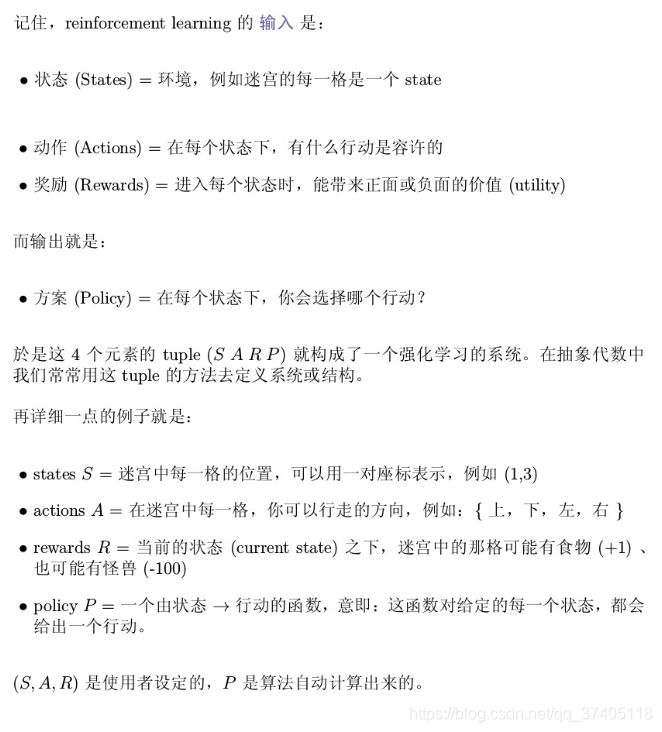

现存的方法很多只关注空间策略,忽视了时间线索。这篇论文,我们提出了一个多任务强化学习框架,可以共同学习时空线索。给定单个图像,我们可以确定是否需要更大的区域或更长的视频序列。 由于这两个任务在强化学习中具有相同的状态,我们联合两个任务合并成一个演员批评智能体(既是演员又是评判者),该智能体采取行动(即放大,缩小或保持不变)来确定行人边界框的大小和连续帧的长度,为行人识别提供适当的上下文范围。

主要贡献:

@ 我们提出通过将新奇的行为批评代理集成到强化学习的嵌入式CNN中来解决跨场景的人Re-ID问题,可以动态地找到上下文和伸缩感知领域,从而产生用于人识别的内在信息。

@ 我们揭示了跨场景Re-ID的情境(context)与行人之间的关系,并阐述了最佳人物区域与其时空语境之间的相互作用,从而为获得最佳情境线索提供了简单而有效的学习策略。

@ 我们设计了一种新颖的基于深度强化学习的多任务框架,通过与上下文策略网络和上下文批评网络协作来学习上下文代理。 全面的实验证明了我们框架的优势。

二 、 RELATED WORKS

A 、 Person Re-id

one 基于图片(image-based) 通常强调正价特征表征,对姿态、复杂背景、摄像头视角。但是这种方法忽视了时间的联系性,导致缺乏其他数据集的泛化能力。

two 基于视频(video-based) 试图捕获时间线索通过视频的连贯性。 最近,时间和空间的联合(时空)注意力得到了很大的进步。。 然而,这些方法在单一场景中是有限的,而且很难在场景中捕捉到足够的上下文线索。

作者提出在每个帧的自适应框架中捕获空间和时间上下文。

B、 Reinforcement Learning

【强化学习详细介绍链接: https://www.zhihu.com/question/41775291.】

强化学习主要是尝试解决策略学习问题在一些视觉任务中,目前获得了很多的成功应用,我们试图自适应的为每个图片自动的找到上下文线索,基于person Re-ID task via Asynchronous Advantage Actor-Critic(A3C) ,其中我们利用多任务神经网络来代表演员-评判智能体。

【A3C详细介绍链接: https://blog.csdn.net/Hansry/article/details/80829127】

三 、 NEW METHODOLOGY AND NETWORK

A 、Overview of Our CI-CNN

Fig. 3: Pipeline of our CI-CNN. MTRL: taking image as input, MTRL will output actions to adjust the size of the bounding box (i.e., zoom-in the pedestrian’s box) and the length of neighboring frames (i.e., enlarge the consecutive frames), According to the actions, a new pedestrian box and a low-rank component in the suggested length of sequences will be computed. Person-Context Interaction: the context-interactive network (CIN) takes the image and its corresponding low-rank component as input,provides the reward to evaluate the actions, and updates the actor-critic agent.

B 、Multi-Task Reinforcement Learning

定义自适应上下文搜索作为一个演员评判过程。

1 智能体(MTRL)和环境交互,通过一系列的动作,基于环境的奖励来优化时空上下文的搜索策略。流程图如图所示,

2 智能体首先从单独图像I接收观察,然后根据MTRL的状态从动作空间对进行采样操作,该状态包含观察和历史经验。

3 此后,它执行采样操作以确定空间上下文框的大小和时间序列的长度。

4 执行完每个动作后,它会根据新生成的图像和序列的识别准确度获得奖励。 通过最大化累积的奖励,智能体旨在寻找与当前框架相关的最满意的上下文序列。

(1)Environment

The environment interacts with the proposed MTRL network via the pre-defined reward mechanism,和传统的强化学习(固定的奖励)不同,our environment contains a context-interactive and dynamically-updated CNN e(st; θe) to provide the reward, wherein θe denotes the iteratively-updated parameters of CNN.In our training settings, the environment will be updated with the newly generated context of the agents.

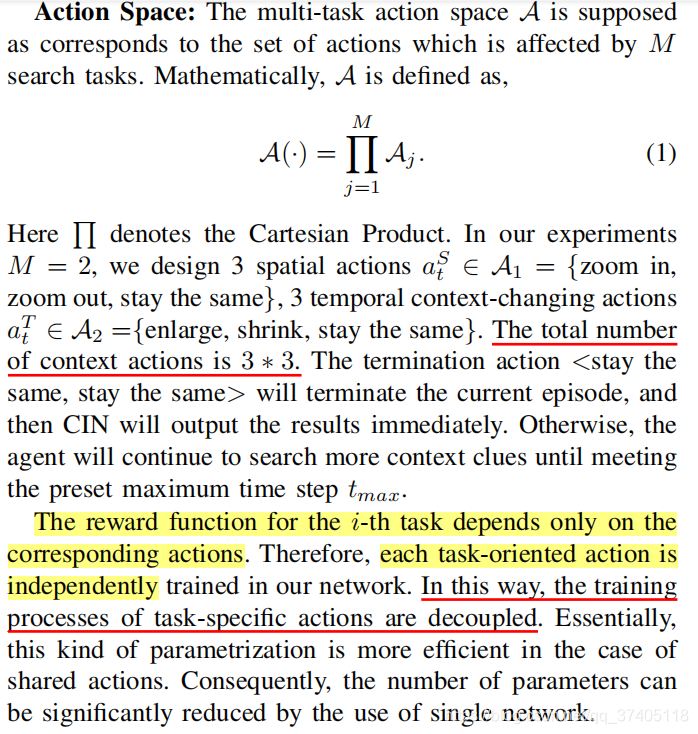

(2) Action Space

action space 指的是所有动作的空间集合, 3 *3 大小

CONCLUSION