对应于《机器学习》书中3.1与3.2节

1.基本形式

线性模型就是试图找到一个可以进行预测的线性函数:

![]()

其中x是示例的属性,w是权重,当d>1时的问题叫多变量回归问题,否则叫单变量回归问题。

线性模型的优点在于其可解释性强,因为可以直观表达每个属性的重要程度。

2.线性回归

数据的属性值有两种类型:

- 连续型,比如同学的身高

- 离散型 ,比如房屋朝向

离散型按照属性值之间是否存在“序”关系又分为有序和无序两种,前者可将数据连续化转为连续值,举例如身高={高,矮}变为{1.0,0.0}。后者可将数据转为k维向量,举例如瓜 = {南瓜,西瓜,冬瓜}变为南瓜=(1,0,0),西瓜 = (0,1,0),冬瓜=(0,0,1),也就是哑变量。

求解单变量线性回归问题的过程就是寻找w,b使得![]() 的过程。其中

的过程。其中![]() 。

。

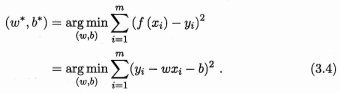

具体方式是使均方误差最小化:

其中argmin表示使函数取到最小值的自变量的集合。

其中argmin表示使函数取到最小值的自变量的集合。

求解上式的过程称为:线性回归模型的最小二乘参数估计。

最小二乘法:基于均方误差最小化进行模型求解的方法

线性回归中的最小二乘法:找到一条直线使样本点到直线的欧式距离之和最小

2.1线性回归模型的最小二乘参数估计

设![]() ,即求使此式最小的w,b。

,即求使此式最小的w,b。

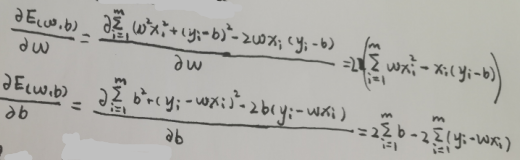

由于上式为凸函数,所以对式求关于w,b的偏导,导数为0即可得(w,b)。

凸函数:对区间中任意两点x1,x2,均有

,则称函数为区间(a,b)上的凸函数

对E(w,b)求导:

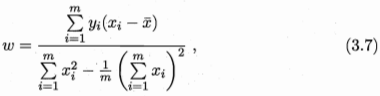

令导数为0,得:

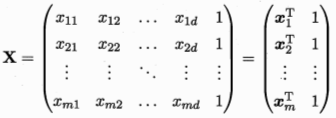

2.2 多变量线性回归

与单变量线性回归的区别是每个数据有多个属性。

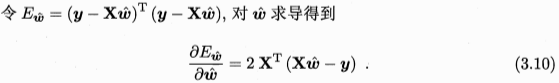

此时还是用最小二乘法,所求:

![]()

其中![]() ,

, ,

,![]() ,m为数据数,d为数据的属性数

,m为数据数,d为数据的属性数

令上式为0得到w,当为满秩矩阵或者正定矩阵时

![]() ,最终的多元线性回归模型:

,最终的多元线性回归模型:

![]()

现实生活中数据的属性值常常多于样例数,因此无法满足满秩的要求,此时得到多个满足要求的

,这里由学习算法的归纳偏好决定选择哪个

,常见做法为引入正则化项。

归纳偏好:机器学习算法在学习过程中对某种类型假设的偏好,一种常用原则为奥卡姆剃刀原则。

奥卡姆剃刀原则:若有多个假设与观察结果一致,选择最简单的那个

2.3 广义线性模型

考虑单调可微函数,令:

![]()

为广义线性模型,其中为联系函数

对数线性回归是当联系函数为时的特例,即

![]() ,是让一个对数函数逼近y。

,是让一个对数函数逼近y。