计划好久,还欠下的债。

问题一: 最小二乘法和梯度下降法的区别

在回答这个问题前,有必要来推导下线性回归的公式,方能说到实处。

开始公式

如一元线性回归,即只有一个自变量,那也只有两个参数

其损失函数为:

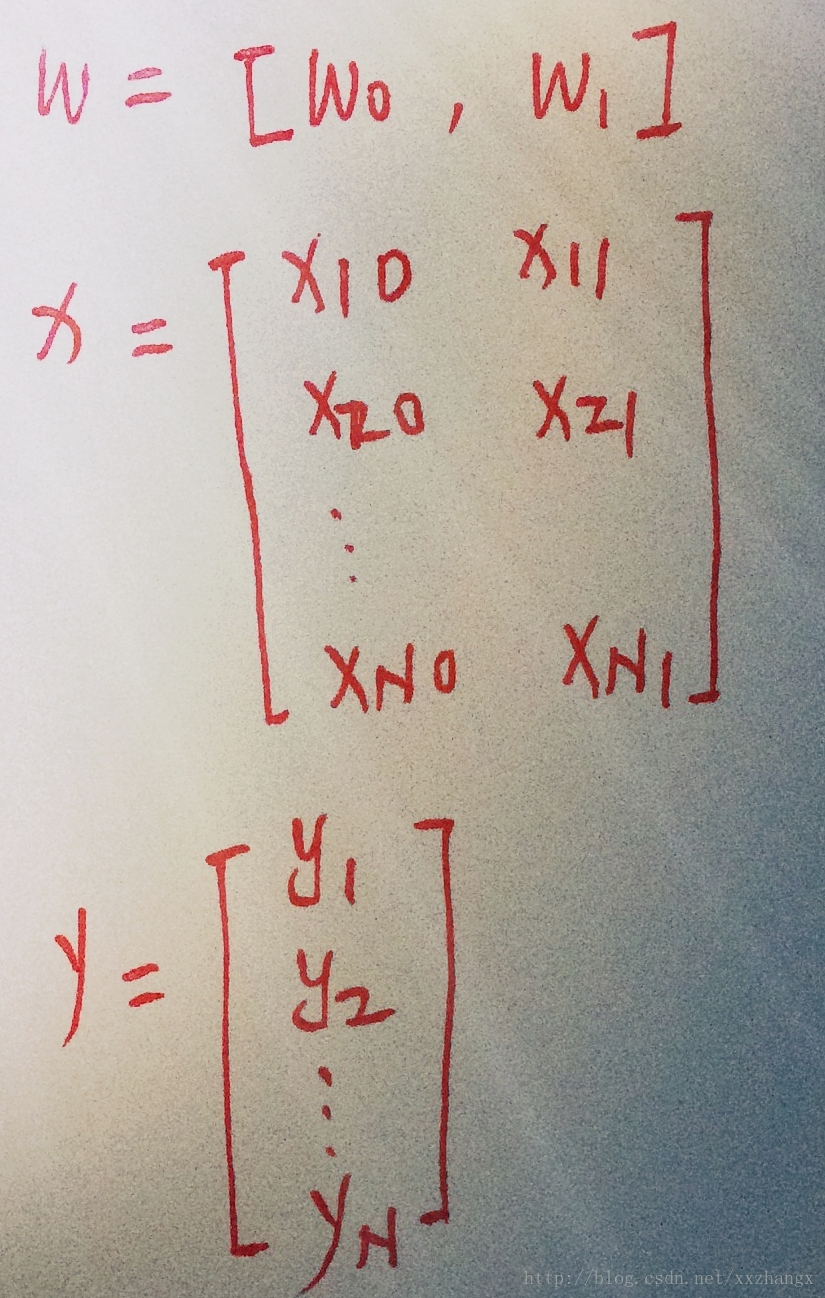

改为矩阵形式

则:

对损失函数求导

最小二乘法是取损失函数的导数为0,得到

可知,

改进方法:

1、梯度下降法

更新公式为:

2、正则化

如引入L2正则化,

对它关于

令上式子等于0,

理论上的总结:

1、当

2、最小二乘法是求解全局最小解;梯度下降法是求解局部最小解。

未完待定

1、进一步完善公式;

2、新的理解;

3、拓展范围;

4、加入代码