版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/weixin_41427758/article/details/80791771

Motivation

- 已有很多算法在现有的Re-ID数据集取得了较高的精度,但是相对于实际应用场景差距较大(人与摄像头数量、各种变化)

- 不同数据集之间存在domain gap,在一个数据集上训练模型,在另外一个数据集上进行预测性能下降很大,如何解决这个问题呢?

Contribution

- 提出了更加接近真实场景的MSMT17数据集

- 提出了利用现有数据集的行人迁移模型,可能缓解在新数据集上标注的代价,并使在实际场景训练re-id系统更加容易

- 分析了阻碍re-id应用的一些问题

1.Introduction

- re-id定义以及意义

目前re-id面临的问题:(motivation)

- 现有公开的数据集与真实场景存在很大不同

- 不同re-id的数据集之间存在domain gap,在一个数据集上训练好的不模型无法应用在另一个数据集上,如下图:

解决方法:contribution

2.Related Work

2.1.Descriptor Learning in Person ReID

- global descriptors

- local cues

- misalignment issue

2.2. Image-to-Image Translation by GAN

- 条件GAN

- Cycle-GAN

- 用GAN产生新样本

3.MSMT17 Dataset

3.1. Overview of Previous Datasets

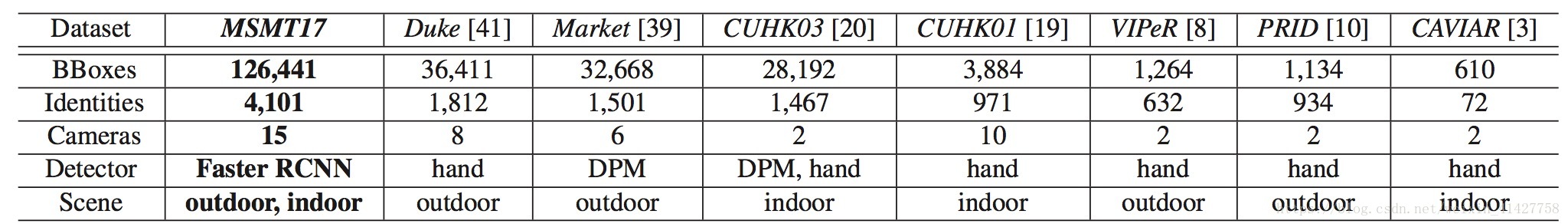

- 现有数据集如下表:

- 现有数据集的局限性:

- 人以及摄像头的数量不够大

- 单一的场景:要么室内或者室外

- 由短时间的监控录像组成,没有显著的光照变化,bbox要么是由人工标注要么是采用过时的检测器DPM

3.2. Description to MSMT17

- 15个摄像头:12个室外 、3个室内

- 一个月中选了天气不同的4天,对于每一天,在早上、中午、下午各采集了1小时

- 最后视频总长180小时:15x4x3

- Faster RCNN作为行人检测框

- 三个标注者用两个月进行标注

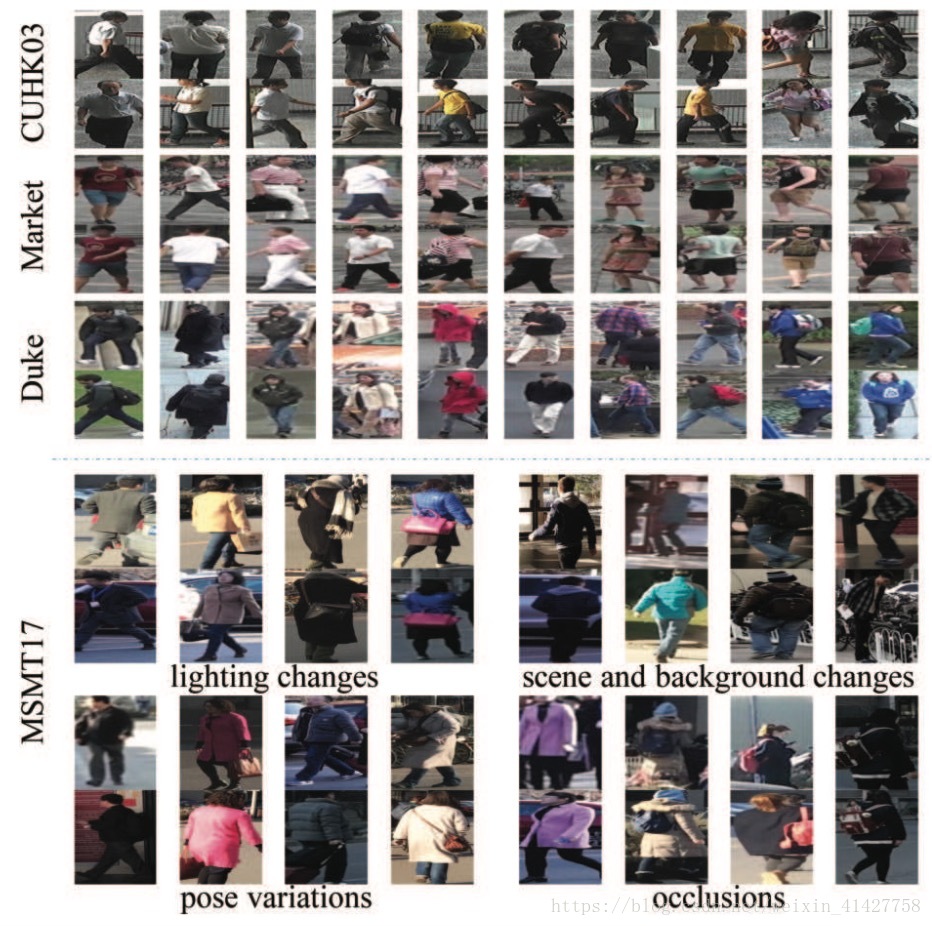

- 与现有数据集的比较如下图:

- 数据集的一些统计如下图:

- 数据集特性:

- 大量的人(4101)、bbox(126441)、摄像头(15)

- 复杂的场景与背景

- 多个时间段导致严重的光照变化

- 更加可靠的检测器:Faster RCNN

3.3. Evaluation Protocol

- 训练与测试集划分为1:3,训练集为1041个人的32621bboxes,测试集3060人的93820的bboxes,其中随机选11659个bboxes作为query,其他82161个作为gallery

- 评价指标:

- CMC

- mAP

4.Person Transfer GAN

- 目的:

- 更好将A数据集上的训练数据用在B上,直接使用会因为不同数据集的光照条件、背景、分辨率等条件的不同导致性能很差

- 在实际中,出现在A中的人如果被B中的摄像头拍到,其风格应该与B一致,本文的person transfer在于模仿这一过程

- 保证迁移的人物与目标数据集有相同的风格

- 在迁移过程保持人的外观和身份线索

- PTGAN:两个限制

- style transfer一致性:学习不同数据集上的风格映射函数

- person identity一致性:保证在迁移过程中人的身份不变

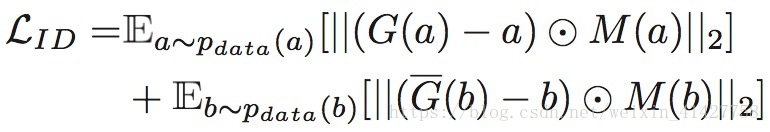

- PTGAN损失函数定义如下:

代表风格损失,

代表身份损失

- 不同ReIDs数据集没有成对的行人图像–> Cycle-GAN(unpair image-to-image tanslation task)

- style transfer learning目标函数如下:

- 身份损失目标函数如下:

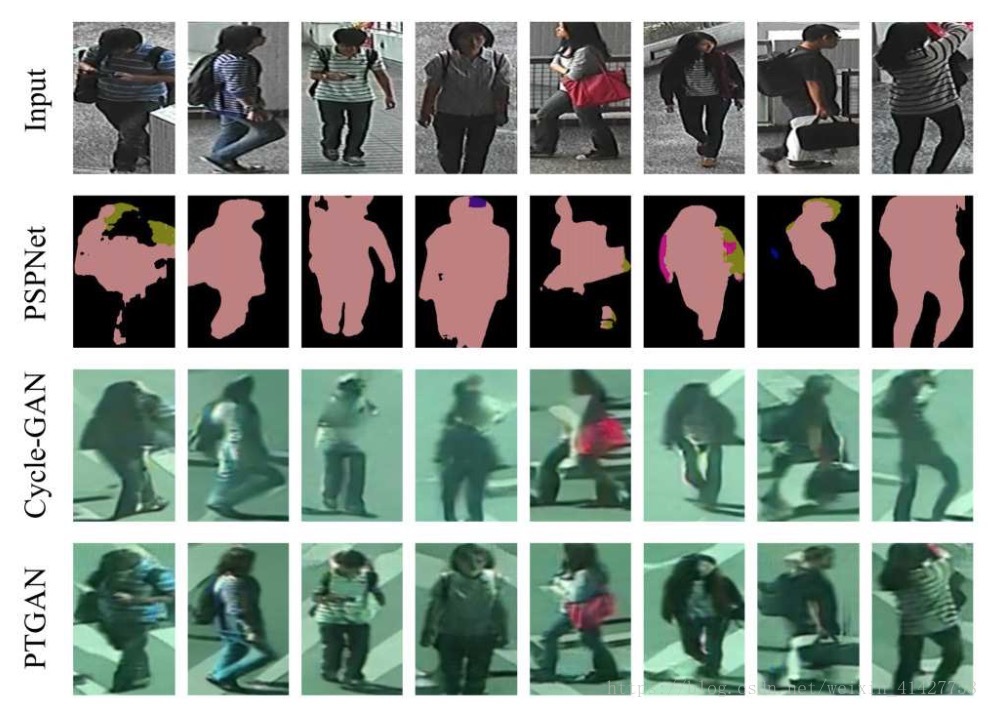

- PSPNet用来提取图像中的行人

- 下图为PTGAN产生的结果样例:

5. Experiments

5.1. Datasets

- MSMT17、DukeMTMC-reID、Market-1501、CUHK03、PRID

5.2. Implementation Details

- Cycle-GAN:

- generator network:

- stride-2 convolutions, 9 residual blocks, and two stride- - fractionally-strided convolutions

- learning_rate:0.0002

- discriminator network(two parts):

- PathGAN:分类图片中70x70patch是真实还是假的

- 对于前景的人,计算输入与输出的 距离,(PSPNet)

- learning_rate:0.0001

- generator network:

- Adam

- input size:256 x 256

5.3. Performance on MSMT17

- 实现了在Market与CUHK03上的SOTA方法在MSMT17上进行了测试

- GoogleNet作为了本文的baseline

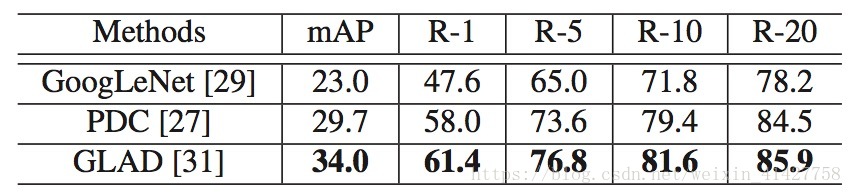

实验结果如下表:

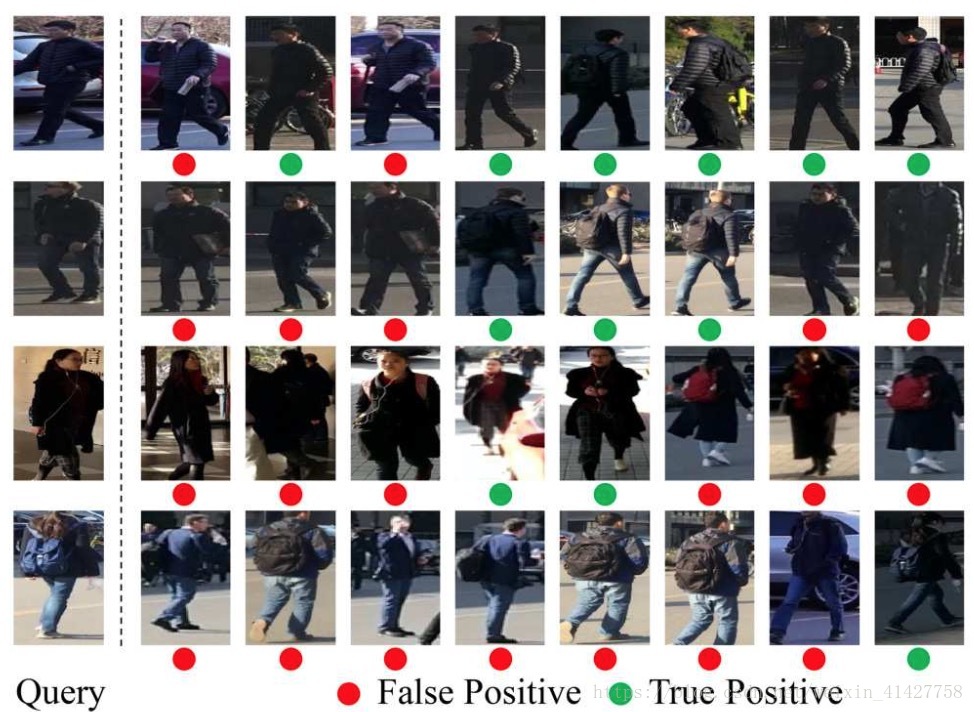

下图为检索结果示例:

5.4. Performance of Person Transfer

- 两种测试:

- 从大数据集A到小数据集上B

- 从大数据集A到大数据集上B

5.4.1 Transfer from Large Dataset to Small Dataset

- CUHK03和Market –> PRID的两个摄像头style

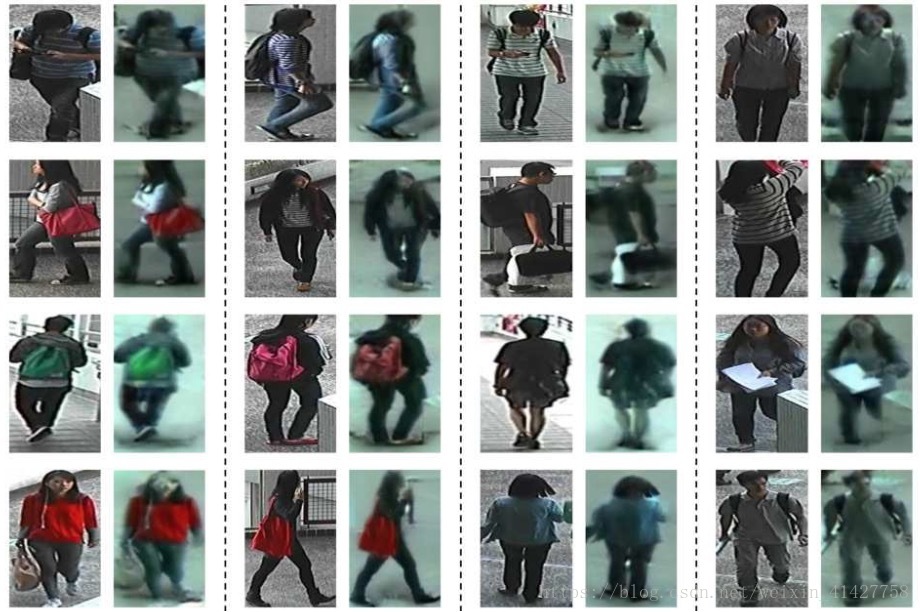

迁移的结果如下图:

CUHK03 –> PRID

Market1501 –> PRID

对直接使用原数据集进行训练以及迁移后的图片进行训练,结果如下表:

- 实验说明即使不借助目标数据集上的label也能得到较合理的性能

- 当结合两个cam风格的数据后性能最好,可能原因:

- 更多的数据有助于训练深度网络

- 不同视角下的行人图片增加了网络学习到特征的鲁棒性

5.4.2 Transfer from Large Dataset to Large Dataset

- 因为大型数据集摄像头很多,对于每个摄像头使用PTGAN开销太大,该实验中没有区分摄像头,只使用了一个PTGAN

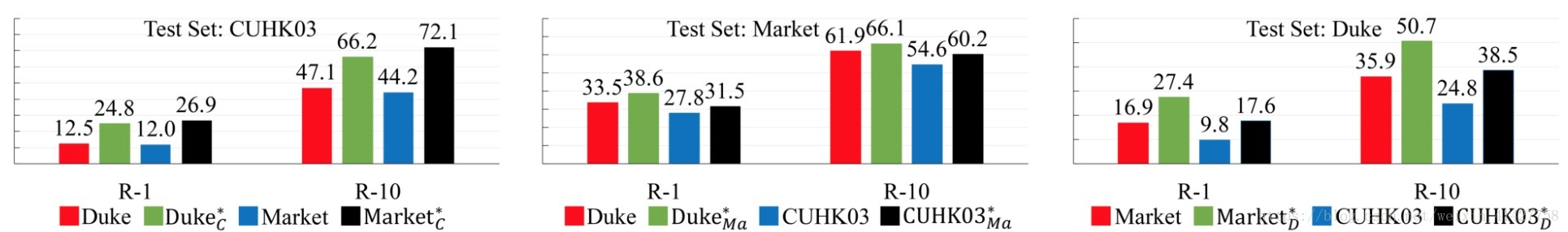

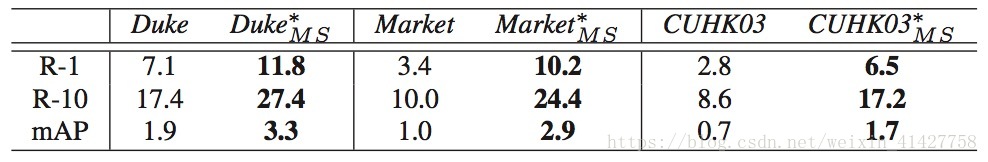

- 实验结果如下图:

- 样本示例如下图:

5.5. Performance of Person Transfer on MSMT17

- 同样是对比在直接使用源数据集训练与迁移后的数据训练结果,如下表:

- 测试了person tranfer在有效的训练数据但大量测试集这种更接近真实场景下的作用,结果如下表:

- 实验说明10%的MSMT数据与从Duke迁移的数据得到的性能相似—> 6.3迁移图片等价一张标注图片

6. Conclusions and Discussions

- 为re-id社区贡献了一个大规模MSMT数据集,目前为止最大的数据集,在光照、场景、背景、人类姿势有大幅差异,更接近真实场景

- 提出了PTGAN来解决数据集之间的Domain gap,通过大量实验证明了PTGAN对于降低Domain gap的有效性

- 不同的摄像头之间存在不同的风格,很难用一个map函数来进行不同的风格,本文的策略并不是最优的,可以通过用多个map函数来考虑不同的风格差异—2018-CVPR-Camera Style Adaptation for Person Re-identification