论文链接:https://arxiv.53yu.com/pdf/2204.09331.pdf

代码链接:https://github.com/haochenheheda/NFormer

1. 动机

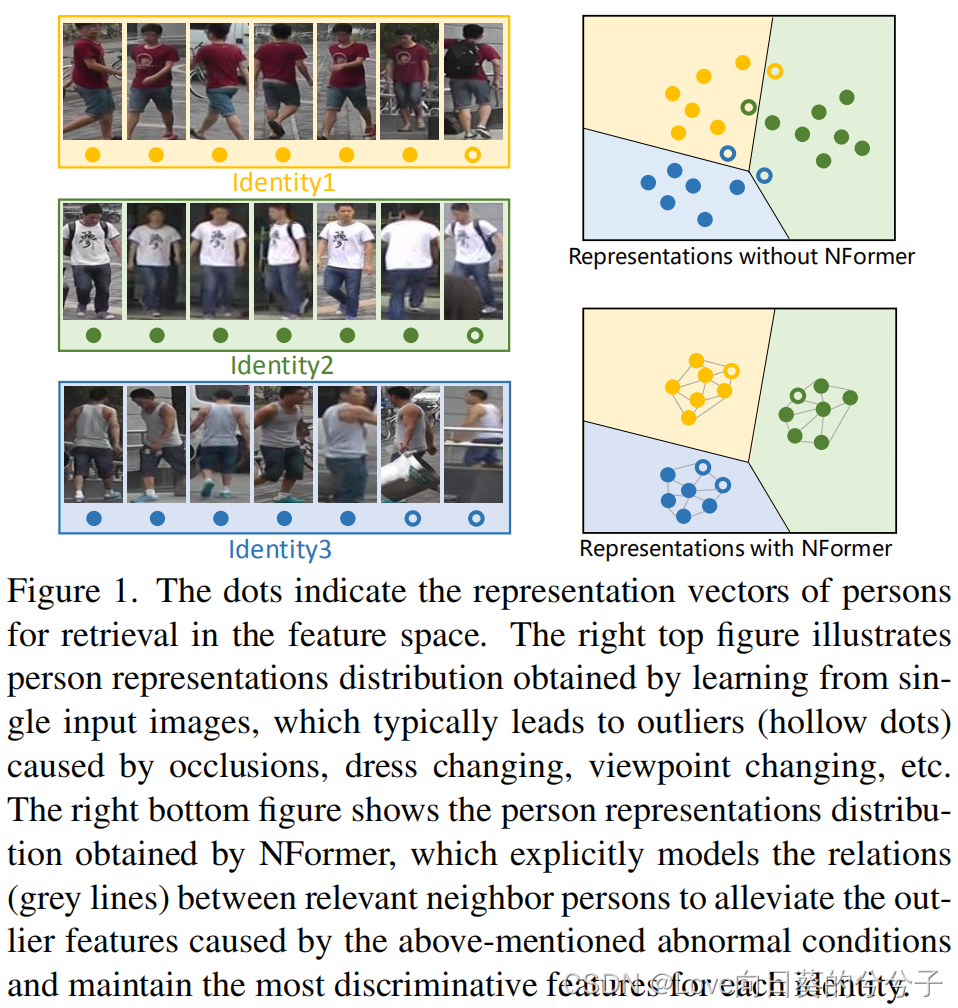

Re-ID的主要挑战之一是,由于外部因素,如不同的相机设置,灯光,视角,遮挡,或内在因素,如服装改变,任何个人的外观通常会发生显著变化。因此,在对应于特定个体的表征中存在高度的身份内变异,导致不稳定的匹配和对异常值的敏感性

2. 贡献

- 提出了一个 Neighbor Transformer Network (NFormer),以有效地在训练和测试时建模所有输入图像之间的关系

- 提出了一个 Landmark Agent Attention (LAA),通过在表示空间中引入少量landmark agent来减少亲和矩阵的计算量

- 提出Reciprocal Neighbor Softmax (RNS)函数,来实现稀疏attention,只关注计算上可管理的邻居。RNS显著地约束了不相关个体之间的噪声交互,使表示聚合过程更加有效和高效

3. 方法

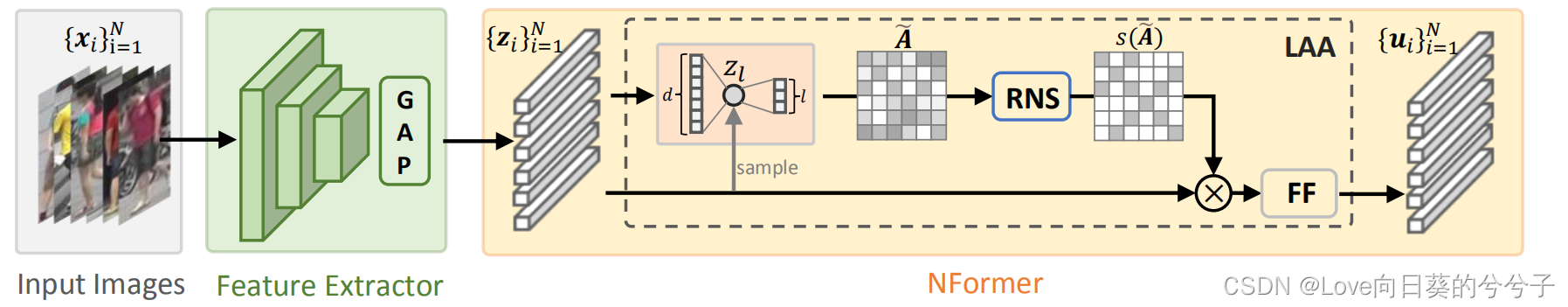

整个架构主要由两部分组成:特征提取器和NFormer。其中,NFormer主要由两部分组成:Landmark Agent Attention (LAA)和Reciprocal Neighbor Softmax (RNS)。下面详细讲解一下LAA和RNS:

3.1 Landmark Agent Attention

LAA核心有两点:

- 将高维表示向量 z z z映射到低维编码空间,从而获得计算更加高效的近似亲和矩阵 A ~ \tilde{A} A~

- 在近似亲和矩阵 A ~ \tilde{A} A~上,利用Reciprocal Neighbor Softmax (RNS)强制对少数相关 attention weights进行稀疏化。即,从近似亲和映射 A ~ \tilde{A} A~上计算一个前k个邻居掩码 M k M^k Mk,它将关注每行的前k个亲和值

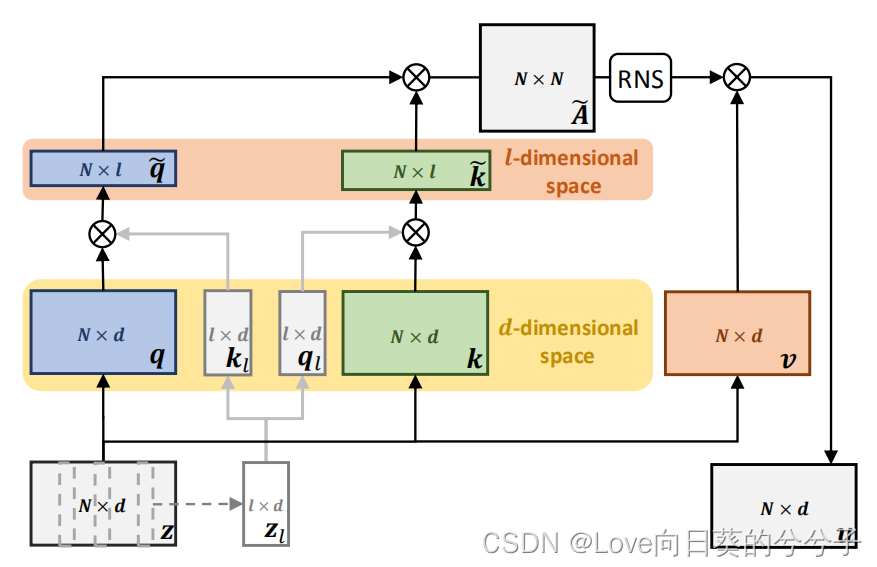

具体地,如上图所示,对于输入 z ∈ R N × d z \in R^{N \times d} z∈RN×d

1)首先在其上随机采样 l l l个样本,即 z l ∈ R l × d z_l \in R^{l \times d} zl∈Rl×d;

2)然后利用三个不同的线性映射 φ q ( ⋅ ) \varphi_{q(·)} φq(⋅), φ k ( ⋅ ) \varphi_{k(·)} φk(⋅), φ v ( ⋅ ) \varphi_{v(·)} φv(⋅)将输入 z z z映射成query(q), key(k)和value(v),即 q , k , v ∈ R N × d q,k,v \in R^{N \times d} q,k,v∈RN×d,同时利用线性映射 φ q ( ⋅ ) \varphi_{q(·)} φq(⋅), φ k ( ⋅ ) \varphi_{k(·)} φk(⋅)将 z l z_l zl映射成 q l q_l ql和 k l k_l kl矩阵,其中 q l , k l ∈ R l × d q_l, k_l \in R^{l \times d} ql,kl∈Rl×d;

3)接着,可以利用 q l q_l ql和 k l k_l kl矩阵将原始query和key映射到 l l l-dim空间,即 q ~ = q k l ⊤ , k ~ = k q l ⊤ \tilde{q} = qk^⊤_l , \tilde{k} = kq^⊤_l q~=qkl⊤,k~=kql⊤,其中 q ~ , k ~ ∈ R N × l \tilde{q}, \tilde{k} \in R^{N \times l} q~,k~∈RN×l, q ~ i j , k ~ i j \tilde{q}_{ij}, \tilde{k}_{ij} q~ij,k~ij表示表征向量 l ∈ { 1 , … N } l \in \{1,…N\} l∈{ 1,…N}和landmark agent j ∈ { 1 , . . . , l } j \in \{1, . . . , l\} j∈{ 1,...,l}之间的相似性。

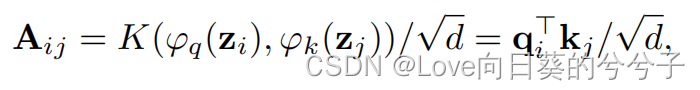

4)最后,将大的亲和映射 A ∈ R N × N A \in R^{N\times N} A∈RN×N的计算

分解为两个低秩矩阵 q ~ , k ~ \tilde{q}, \tilde{k} q~,k~的乘积

因此,获取亲和矩阵的乘法复杂度从 O ( N 2 d ) O(N^2d) O(N2d)显著降低到 O ( N 2 l ) O(N^2l) O(N2l)。在本文的实验中, l l l通常比 d ( l = 5 , d = 256 ) d (l = 5, d=256) d(l=5,d=256)小得多。

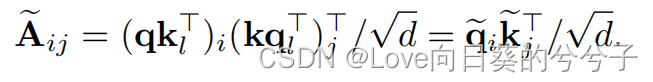

作者实验展示了(如下图6所示),即使有少量的landmark agent,NFormer也能够稳定地运行

3.2 Reciprocal Neighbor Softmax

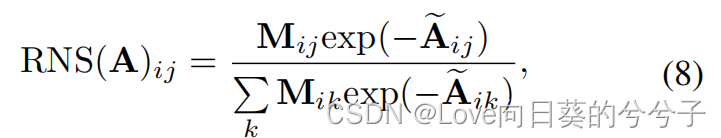

原始的softmax计算是聚合所有的样本,但是不相关样本的显著存在会对最终计算产生负面影响。而且,除了最终的输出表示有负面影响外,表示聚合的计算复杂度为 O ( N 2 d ) O(N^2d) O(N2d),由于输入规模 N N N较大,计算负担也较大。

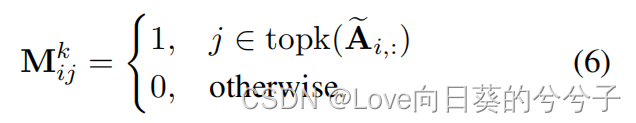

因此,这里作者提出Reciprocal Neighbor Softmax (RNS),用reciprocal邻居掩码强制对少数相关的attention weight进行稀疏化。例如,假设如果两幅图像在特征空间中互为邻域,则它们很可能是相关的。为此,作者建议从近似亲和映射 A ~ \tilde{A} A~计算一个前k个邻居掩码 M k M^k Mk,它将关注每行的前k个亲和值

然后用Hadamard Product将 M k M^k Mk与其转置相乘,就可以得到一个reciprocal邻居掩码 M M M,即

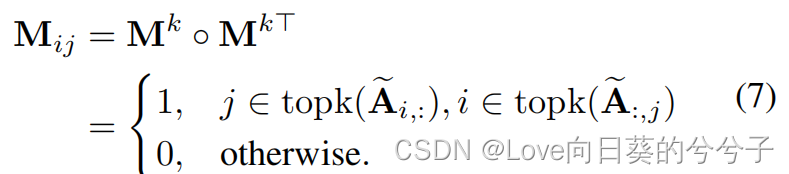

对于每个元素 M i j M_{ij} Mij,如果 i i i和 j j j都是彼此的前 k k k个邻居,则其值设为1,否则设为0。通过将这个掩模 M M M添加到常规softmax函数中,可以实现仅发生在邻居中的稀疏注意,这增加了对更相关图像的关注。RNS公式如下:

由于大多数注意力值被设置为0,如下图4 (b)所示,关系被约束到相关的邻居,使得原本的聚合更加集中和健壮。此外,由于不需要对权值为0的表示进行加法操作,特征聚合的时间复杂度从 O ( N 2 d ) O(N^2d) O(N2d)显著降低到 O ( N k d ) O(N kd) O(Nkd)。

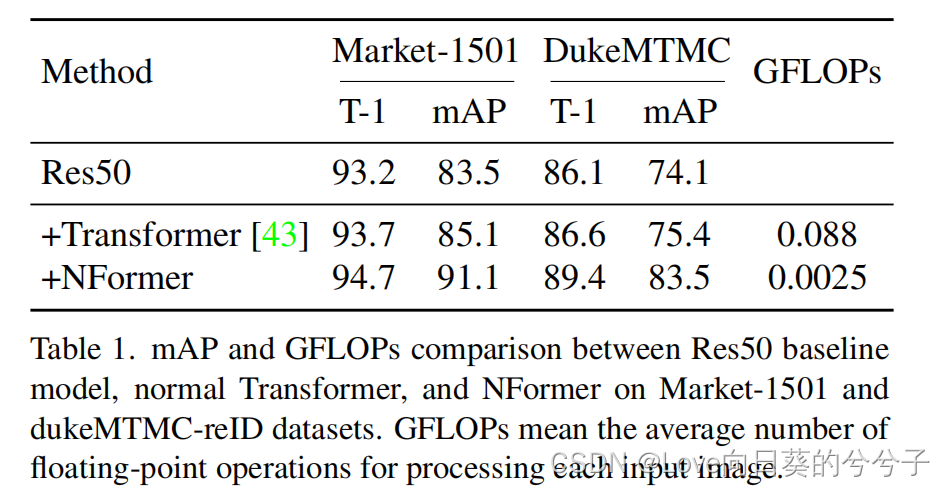

4. 部分实验结果

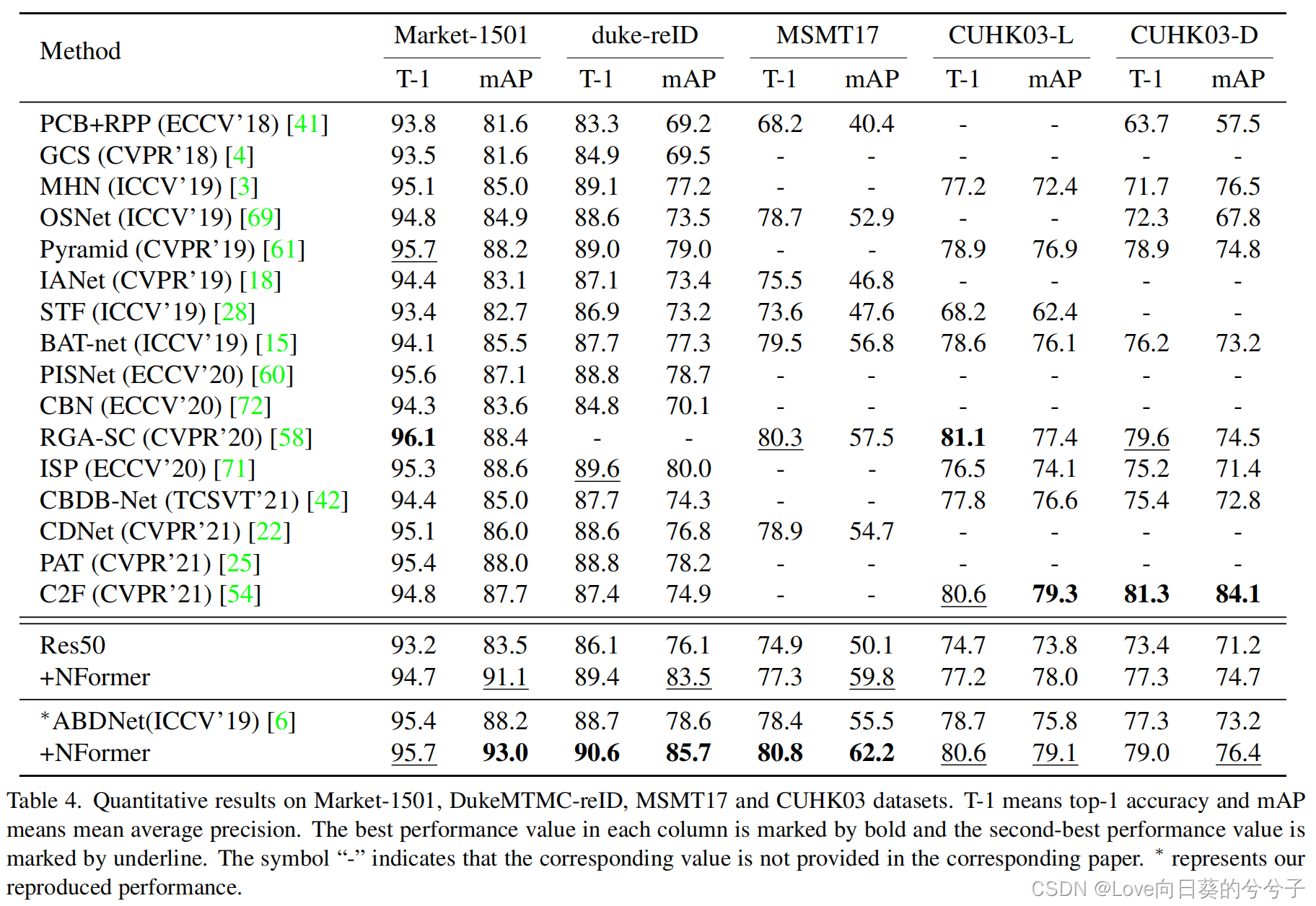

4.1 与SOTA方法对比

4.2 与标准Transformer效率和性能对比