课堂提问

- 在2层简单神经网络中,W1和W2有什么含义吗?

答:W1依然可以看成是我们学习到的线性分类器中的各种各样的模板,而 表示这些模板的得分,W2将这些模板得分组合起来形成新的复杂模板。

例如上面这个例子,假设我们既有头朝左的马,又有头朝右的马,那么对于一匹头朝左的马,可能一个模板分高一个模板分低,然后取 后保留其是左侧马的分数。

注:这里的 可能将取值较低的模板分数就略去了,也引入了非线性,就是图中所显示的 。

1. 神经网络介绍

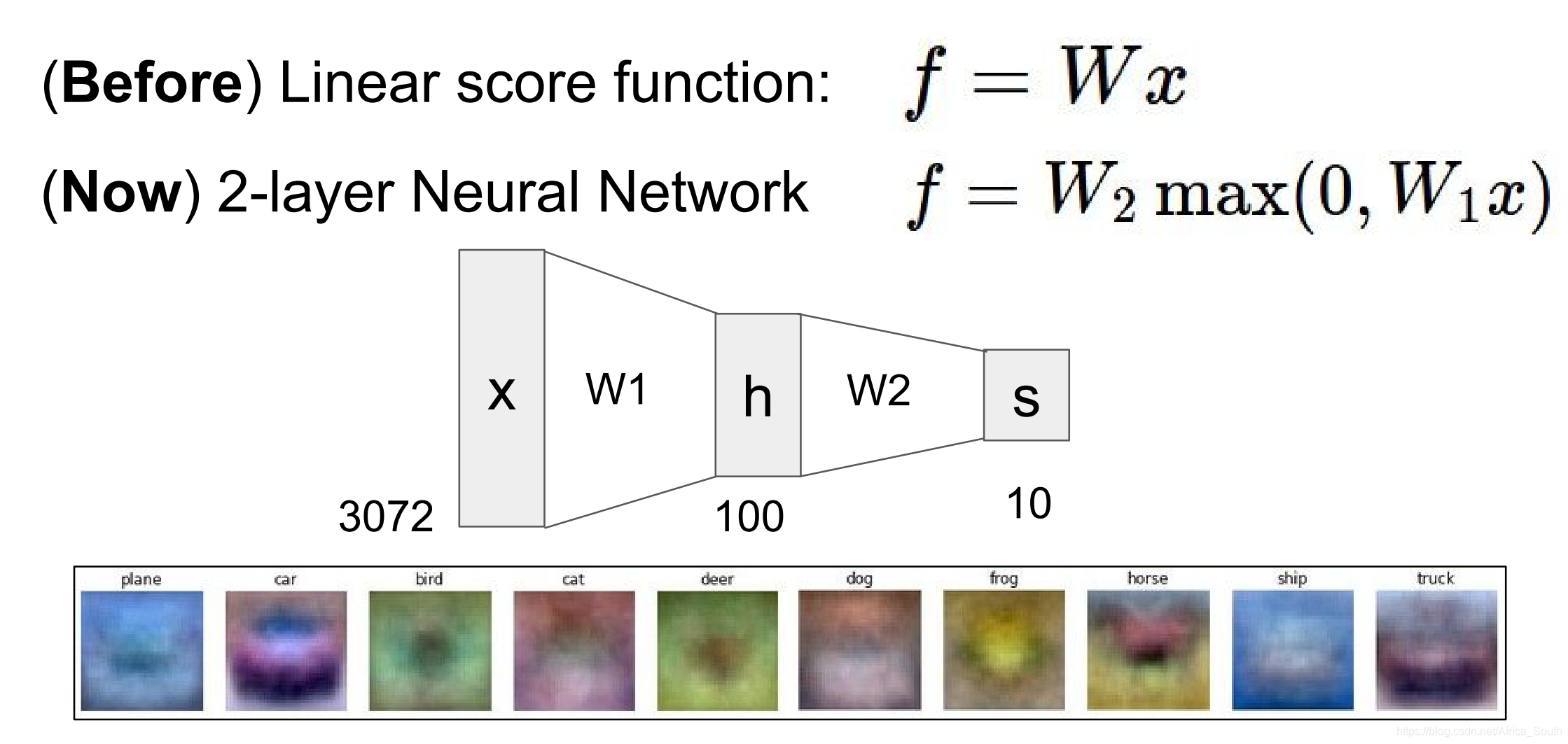

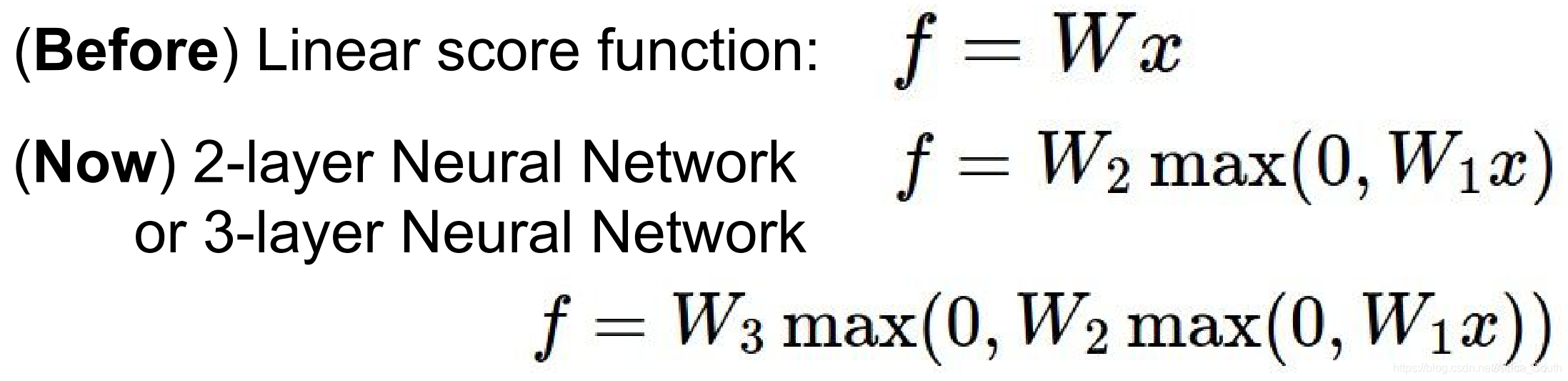

与线性函数

不太一样,神经网络可以看成是由一组简单函数构成的(层次化堆叠)复杂 非线性 映射函数。例如下图中的简单线性函数,和2层,3层简单神经网络。

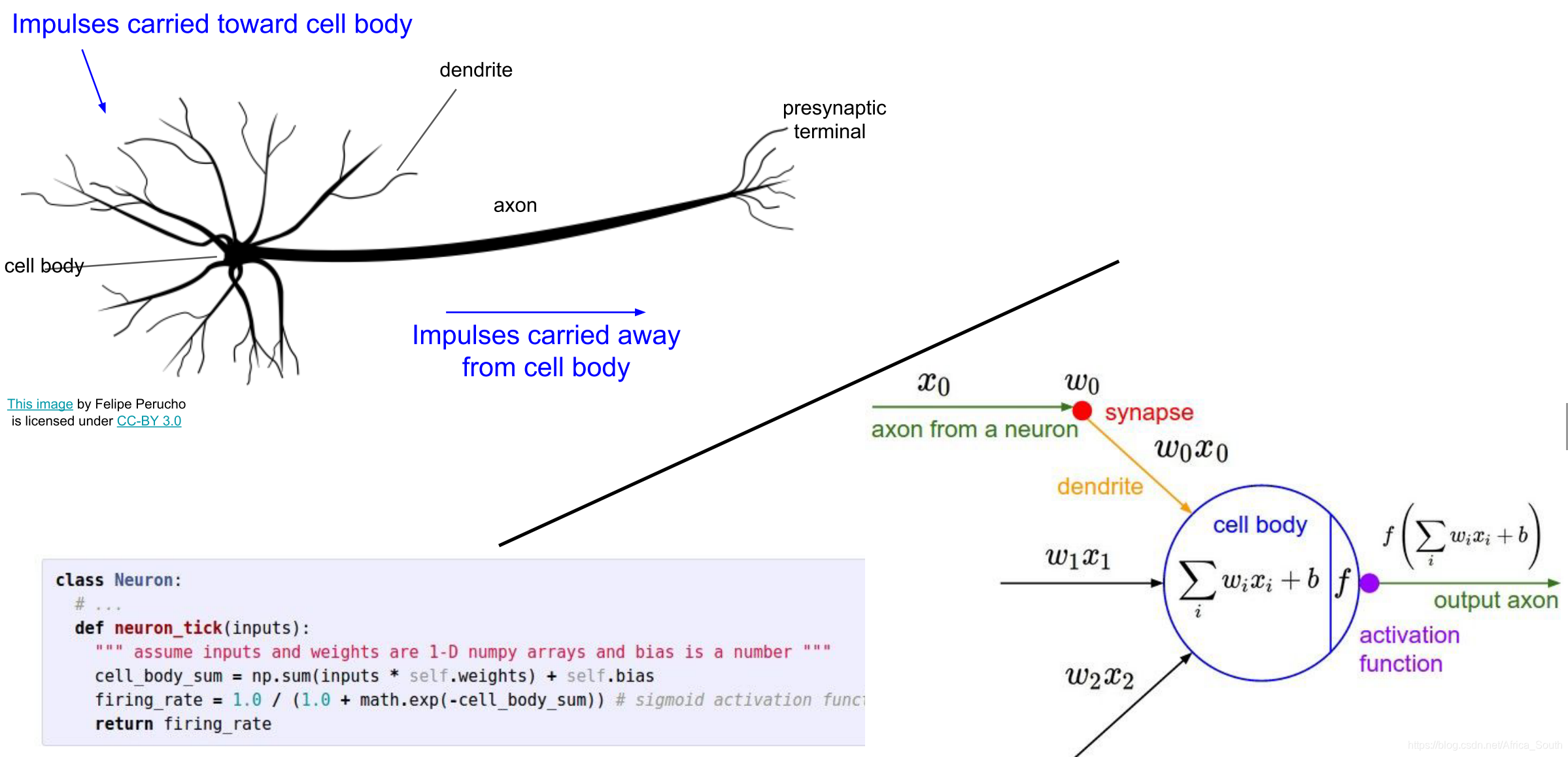

单个神经元类比

神经元中树突接收脉冲信号,然后细胞体进行处理,再通过轴突传给下一个神经元。这和我们计算图中单个函数门(gate)接收输入,计算并用激活函数激活类似,但是要远远复杂的多。

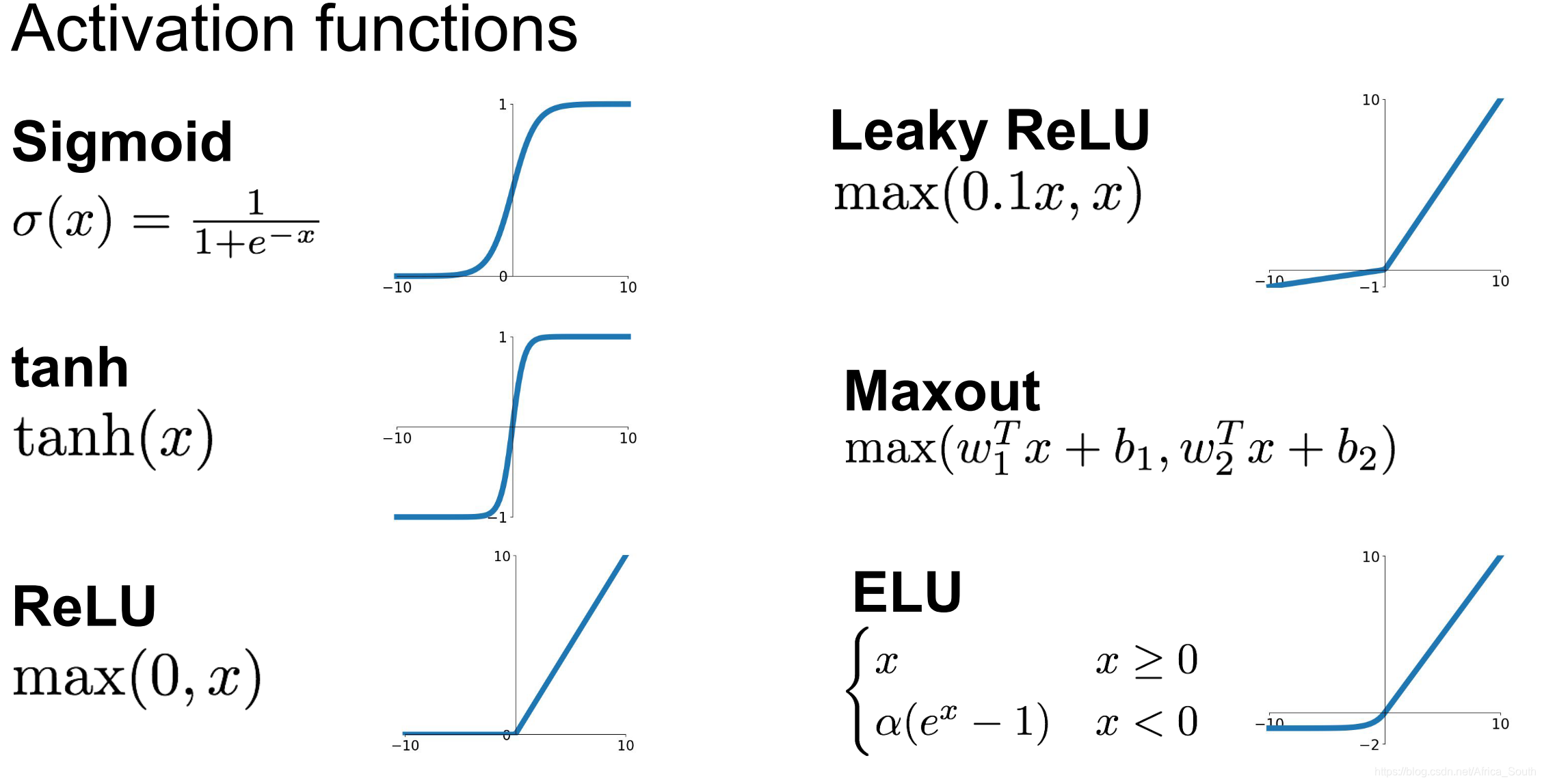

例如常见的激活函数如下:

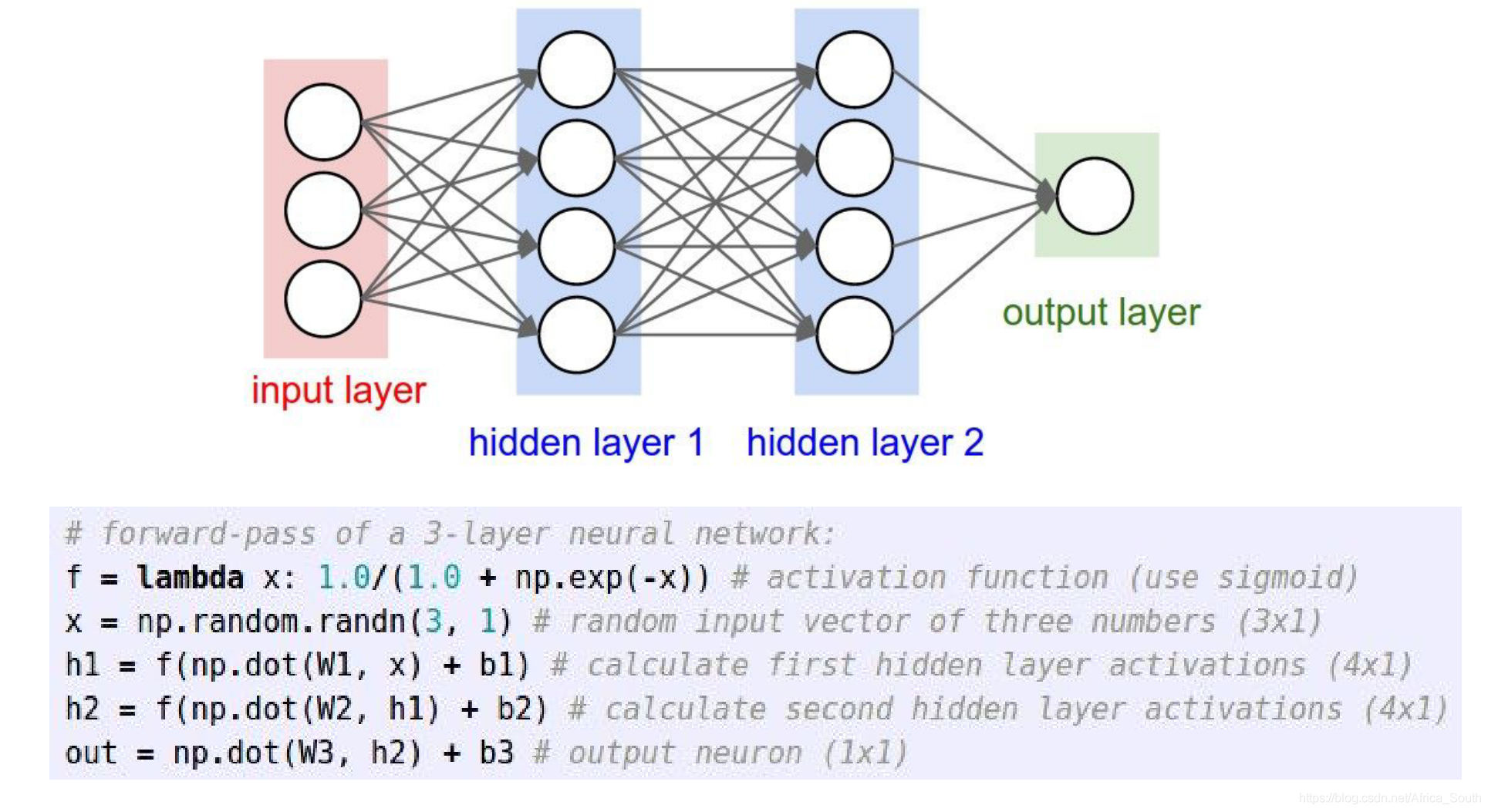

神经元的向量化计算

上面讲到,一个 “神经单元” 接收很多输入,然后进行计算并输出,所以,一般我们将神经元的输入看成向量来进行计算。例如,下面示例的简单双隐层神经网络结构和其前向传播过程。