机器学习:多远线性回归

其他

2018-05-29 14:47:40

阅读次数: 0

一、多元线性回归基础

- 简单线性回归算法只有一个特征值(x),通常线性回归算法中有多个特征值,有的甚至有成千上万个特征值

- 多元线性回归中有多个特征值

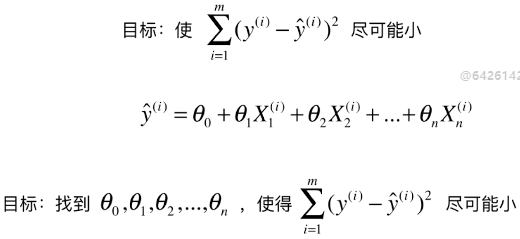

1)多元线性回归问题的解决思路

- 求解思路与简单线性回归的思路一样

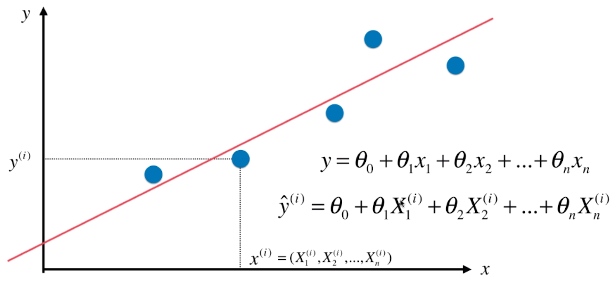

- y = θ0 + θ1X11 + θ2X22 + θ3X33 + ... + θnXnn

- X = array([X1, X2, X3 , ..., Xn])T:数据集

- Xn:数据集中的每一个向量,也是该数据集中的一个样本

- X1 = array([x1, x2, x3, ... , xn])

- xn:每一行(一个样本)的一个元素(特征值)

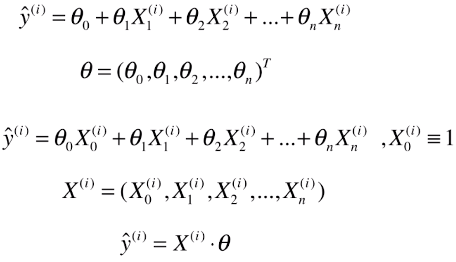

2)多元线性回归的公式推导

A)原始公式

- θ:参数向量,必须为列向量,才能与数据集矩阵X相乘:X*θ,得到的也是一个列向量

- ý(i):模型的预测值

- X(i):变形后的一个样本,也是变形后的数据集矩阵的第 i 行

- X0(i):第 i 行的第0号元素; # 原因:为了让计算式的每一项的格式统一,并且和θ0结合在一起,方便整个公式的推导,虚构为X(i)的第0个特征;

- X0(i) ≡ 1:此元素恒等于1,变形后的公式与原公式一样

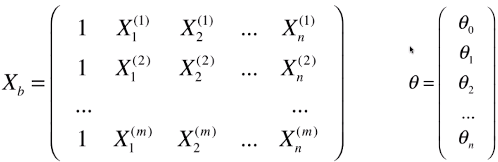

B)变形数据集矩阵

- 新的数据集矩阵:Xb,比原矩阵X多了一列:X0,全部为1

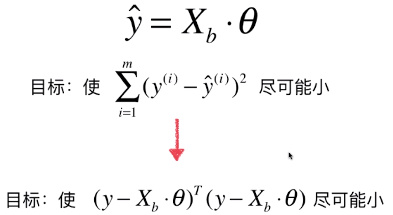

- 变形后的数学模型:ý = Xb * θ

- ý为列向量,每一个元素(ý(i))为每一个样本X(i)讲过预测后得到的预测值

- 矩阵相乘有先后,不能写成θ * Xb

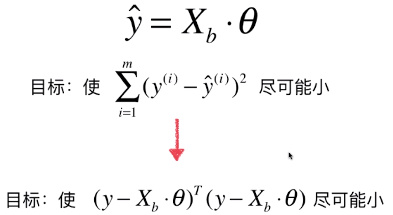

C)优化目标函数

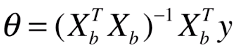

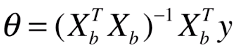

- 数学推导(对矩阵求导(非本科学校内容)):得到θ的表达式

- 此公式为多元线性回归的正规方程解(Normal Equation)

- 公式缺点:时间复杂度高:O(n3),即使通过手段优化后:O(n2.4) ,效率低;

- 优点:不需要对数据做归一化处理; # 因为数据集中的数据直接参数运算

二、实现多元线性回归

转载自www.cnblogs.com/volcao/p/9104921.html