自信息(self-information):

I(x)=

=

- log(

p(x)

) (1)

式中的log表示自然对数, 如果用以2为底的对数,单位是比特(bit)。

上式是什么意思?p(x)是指x发生的概率,I(x)代表x所包含的信息量。考虑这么一个问题,马云破产以及马云获得全国首富这两个事件,那个包含的信息量大?当然是马云破产的信息量更大,因为它发生的概率非常小。这也就是(1)式是用概率的倒数的原因。

熵:

一个离散型变量 的熵

定义为:

H(X)也就是平均信息量,或者说对X不确定度的度量(事件发生的概率越小,它的不确定度就越高)。

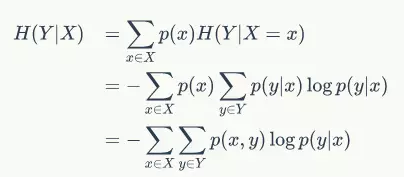

条件熵:

具体的解释请参考:http://blog.csdn.net/xwd18280820053/article/details/70739368

通俗来讲就是,知道X情况下,Y的信息量。

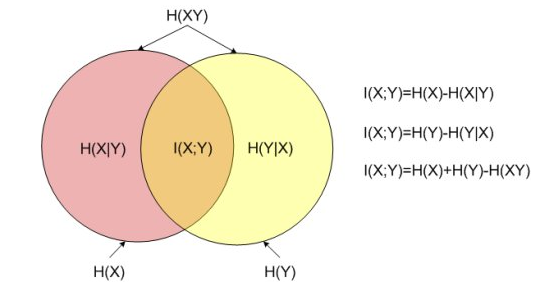

互信息、条件熵与联合熵的区别与联系

那么互信息就是知道X,给Y的信息量带来多少损失(或者知道Y,给X的信息量带来多少损失)。

举个例子,假设H(X)用一块糖来表示,Y代表一杯水,H(X|Y)也就是将这杯水倒在糖上,H(X)还剩多少,那么溶于水的那部分糖就是Y给H(X)带来的损失,即就是互信息。