信息熵

对某件事件的不确定性叫做熵,熵值单位为bit,计算公式为:![]()

。它是统计平均意义下的不确定性,包括熵,条件熵,联合熵。

例如对于一道选择题A、B、C、D四个选项,后面的百分数为选该选项的概率,假设如下我们来分析熵值:

A:25% B:25% C:25% D:25%

四种等可能,log4=2bit,可以理解为需要两个比特位来表示ABCD分别为00、01、10、11;当然也可以理解为要选出任意一个选项,需要抛两次硬币来确定,先后顺序为:正反、正正、反正,反反;

A:100% B:0% C:0% D:0%

log1=0,熵值为0,可以理解为无需抛硬币就知道答案。

个人理解:熵越大,越不确定,我们越懵逼,但是蕴含的信息量也越大,我们可以更加求知进步探索文明;相反:熵越小,事件越确定,我们对事物更加可知甚至完全认识,所蕴含的信息量更小。举个栗子,小明说明天太阳从东方升起,这句话熵几乎为0,没有携带什么信息量;但是被告知明天太阳从西方升起,这句话所含的信息量就非常大了,若真则颠覆世界,若假至少能说明小明是个神经病!

如果是不等概率,如何计算熵值?公式如下:

其实这个公式只是

的一般化,假如 p(x) 为等概率都为 1/N 那么推导一下就为:

熵一般有两种解释:(1)熵是不确定性的度量;(2)熵是信息的度量

具体参考:苏剑林. (Dec. 01, 2015). 《“熵”不起:从熵、最大熵原理到最大熵模型(一) 》[Blog post]. Retrieved from https://spaces.ac.cn/archives/3534

信息:能消除熵的数据叫做信息。

例如对于一道选择题A、B、C、D四个选项,后面的百分数为选该选项的概率,假设如下有人告诉说D选项是错误的。

A:25% B:25% C:25% D:25% 变为 A:33% B:33% C:33% D:0% 即计算熵值为log3=1.58,很明显通过被告知的信息使得熵值减少了0.42的熵,那也就说明这则信息提供了0.42的数据量。

噪音:不能消除信息熵的数据叫做噪音。

例如被告知ABCD中有一个是正确答案。

之间的关系

熵和信息数量相等,意义相反;信息用来消除熵(不确定性);

熵在等概率时达到最大。

概率是某件事情某个可能情况的确定性,而熵是某人对某件事到底是哪种情况的不确定性。

信息是相对的,相对于观察者对该事物的了解程度而言。若会这道题ABCD,则别人提供的正确答案提供的信息量为0bit。若不会,则提供了2bit。

先讲一个例子

下面以一个例子进行说明,假设一个暗箱有3个红球,2个黑球,5个白球,假设取到红球的记为事件X,取到黑球记为事件Y,要求我们在箱子中无放回取出三个球;

在概率论中我们明白:表示取到一个红球的概率(先验概率),

表示条件概率(后验概率),在取到两个黑球的条件下取到一个红球的概率。类似于这个,后面会涉及到先验和后验两个词。

自信息

未经统计平均的不确定性,包括自信息量、条件自信息量、联合自信息量;自信息的概念有点像熵,都是表示不确定性的一个量,自信息不是信息,互信息量才是信息,而是先验不确定性,另外注意与熵的联系与区别。 : 表示

的先验不确定性,也称为

的自信息量。公式为:

,即概率得倒数取对数。由此看出概率越大,自信息(不确定性)越小 。其实信息熵说到底就是自信息的期望!!!如下图告知了明天的天气概率求自信息:

自信息即概率得倒数求对数,分别为 1bit,2bit,3bit,3bit ; 一般以2为底数,当然也可以以其他数为底数,单位相应变化如下:

互信息

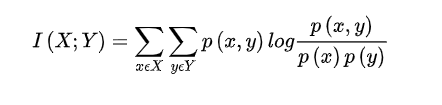

互信息(Mutual Information)是度量两个事件集合之间的相关性(mutual dependence);

上面我们谈到自信息,即对某件事情的不确定性。表示取到i个红球的不确定性,即取到i个红球的自信息。

也常常称为先验不确定性,

称为后验不确定性。结合以上例子基础知识,接下来我们需要说明如何计算互信息量。互信息是从一件事物中获取关于另外一件事的信息量,单位也是bit。公式如下:

从中获取关于

的信息

的先验不确定性

的后验不确定性

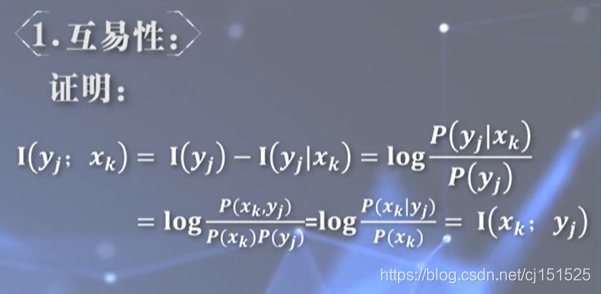

通过下面特性互易性推算我们可以得到

假设一个暗箱有3个红球,2个黑球,5个白球,假设取到红球的记为事件X,取到黑球记为事件Y,要求我们在箱子中无放回取出三个球;

那么X可取0、1、2、3,Y可取0、1、2,求可通过最上面第一个公式求和得出。

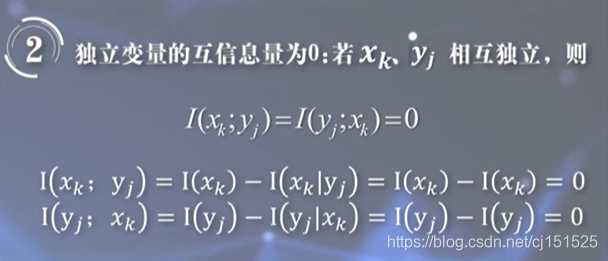

特性

当互信息量为正则意味不确定性更小,互信息量为负不确定性更大。

例题

(1):

(2):