论文链接:FEW-SHOT LEARNING WITH GRAPH NEURAL NETWORKS

Idea:

- Few-shot 学习不依靠于规则化扩展数据集来补偿缺少有监督数据对模型带来的影响,而是受启发与人类学习去探索相似任务在空间上的分布情况。

- GNN网络实际是CNN网络在非欧几里得空间上的扩展。

Problem Set-up

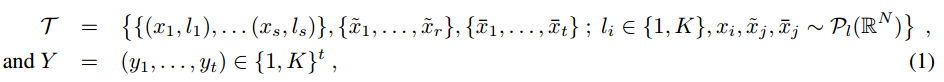

以下的定义可以应用于semi-supervised,few-shot learning 和active learning 三个任务中:

被定义为输入输出对,是从部分被标记的图像数据中选择的。

其中,S代表有监督样本的数量,r代表无监督样本的数量,t代表要分类样本的数量,k代表类的个数。其目标就是通过神经网络(end to end)来对待分类样本预测标签Yi。例如,给定一个训练集合![]() ,一个标准的有监督方法的训练目标是:

,一个标准的有监督方法的训练目标是:

Few-shot learning: 当r=0,t=1,s=qk的时候,这就是一个典型的q-shot,K-way设置的few-shot学习。在k种类型的数据中,每个类含有q个具体实例。

Semi-Supervised Learning:当r>0,t=1的时候,就变成了一个半监督学习任务了,模型根据来自于这些样本的特征分布来进行预测。

Active Learning:在主动学习中,模型从无监督数据中来请求数据的标签。

Model

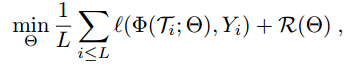

在GNN中,第一步也是最重要的一步是如何建立输入数据(input data)和图表示(graph representation)之间的映射关系。

Set and Graph Input Representation

Few-shot学习的目标是将标签信息从有监督样本上传播到的无标签的query数据上。这种信息传递方式可以被规范化为一种图模型预测值到标签值之间的后验推理。

Graph Neural Networks

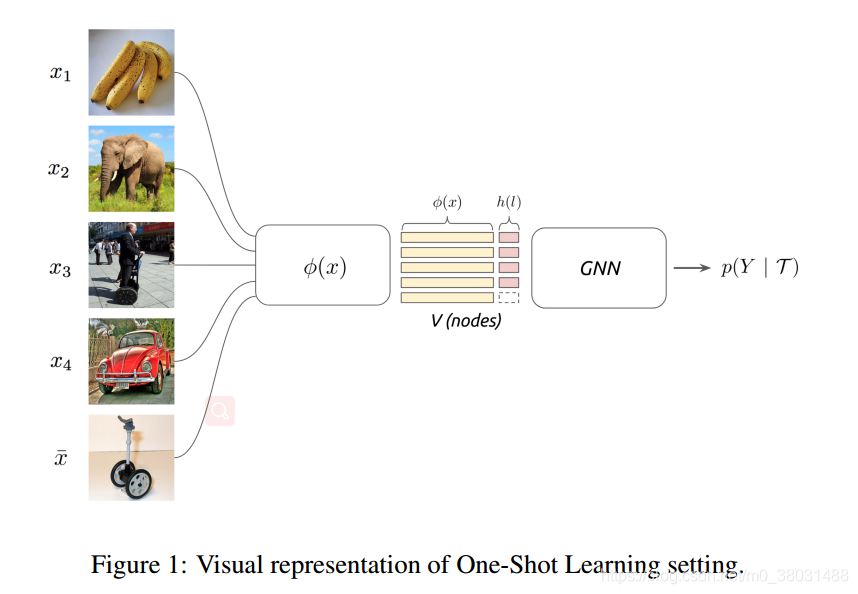

自从GNN被定义为G=(V,E),GNN在样本复杂性和样本表示之间就建立起了一种比较平衡的关系。一个GNN层的Gc(*)操作被定义为:

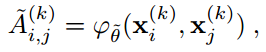

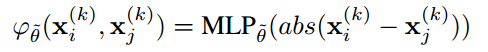

其中θ是可训练的参数,ρ为激活函数(Relu),B为节点之间的邻接矩阵。对于以上的公式近年来也生成了许多GNN变种,其中比较典型一种工作是受message-passing networks的启发,从图中当前节点的隐藏状态开学习边的特征表示A。

其中θ是可训练的参数,ρ为激活函数(Relu),B为节点之间的邻接矩阵。对于以上的公式近年来也生成了许多GNN变种,其中比较典型一种工作是受message-passing networks的启发,从图中当前节点的隐藏状态开学习边的特征表示A。

其中函数为参数化的对称函数,例如神经网络。在该文中,函数被定义为多层感知机应用于两个节点向量化表示的距离。

其函数的本质就是表达一个度量概念,学习两个节点向量化表示之间的绝对距离。构建出的这种距离结构具有对称性,既![]() ,

,![]() 。

。

然后,对邻接矩阵的每一行通过softmax来做归一化操作。一般来讲,网络深度的选择是根据图的大小来确定的,论文中认为深度能简单的被解释为赋予模型更强的表达能力。

Construction of Initial Node Features

模型输入样本和图中节点表示之间的映射关系可以被定义如下。

Φ是一个卷积神经网络,h是样本标签的one-hot表示,两者被拼接起来。如果是未标记的样本,h被定义为一种均匀分布函数![]() 。

。