《Simple Baselines for Human Pose Estimation and Tracking》

来源:微软亚洲研究院

论文:https://arxiv.org/abs/1804.06208

源码:https://github.com/Microsoft/human-pose-estimation.pytorch

本次笔记省略了Tracking部分

Introduction

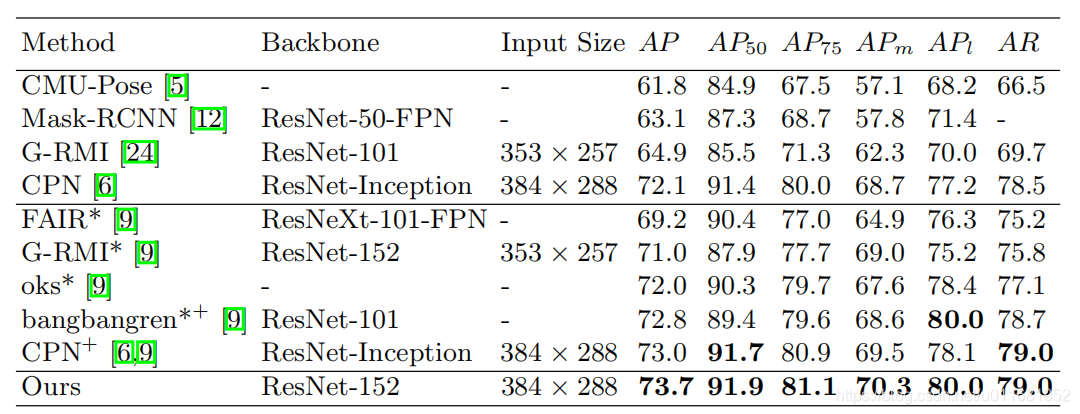

近年来,人体姿态估计的研究已取得显著进展;早期的MPII Benchmark,现在的COCO人体关键点挑战赛发展更快,如2016年冠军PAF(openpose,mAP=60.5)和2017年冠军CPN(mAP=72.1);当然这期间也还有很多优秀的人体姿态方法,如Hourglass等

本文设计了非常简单的CNN模型SimplePose,实现top-down模式的人体姿态估计,在COCO测试集上取得mAP=73.7,在2018挑战赛上也取得了亚军席位

这里说句题外话,PAF是bottom-up模式,CPN和SimplePose是top-down模式,两者都有自己的优势,只对比mAP对PAF是不太公平的,有兴趣移步PAF

SimplePose

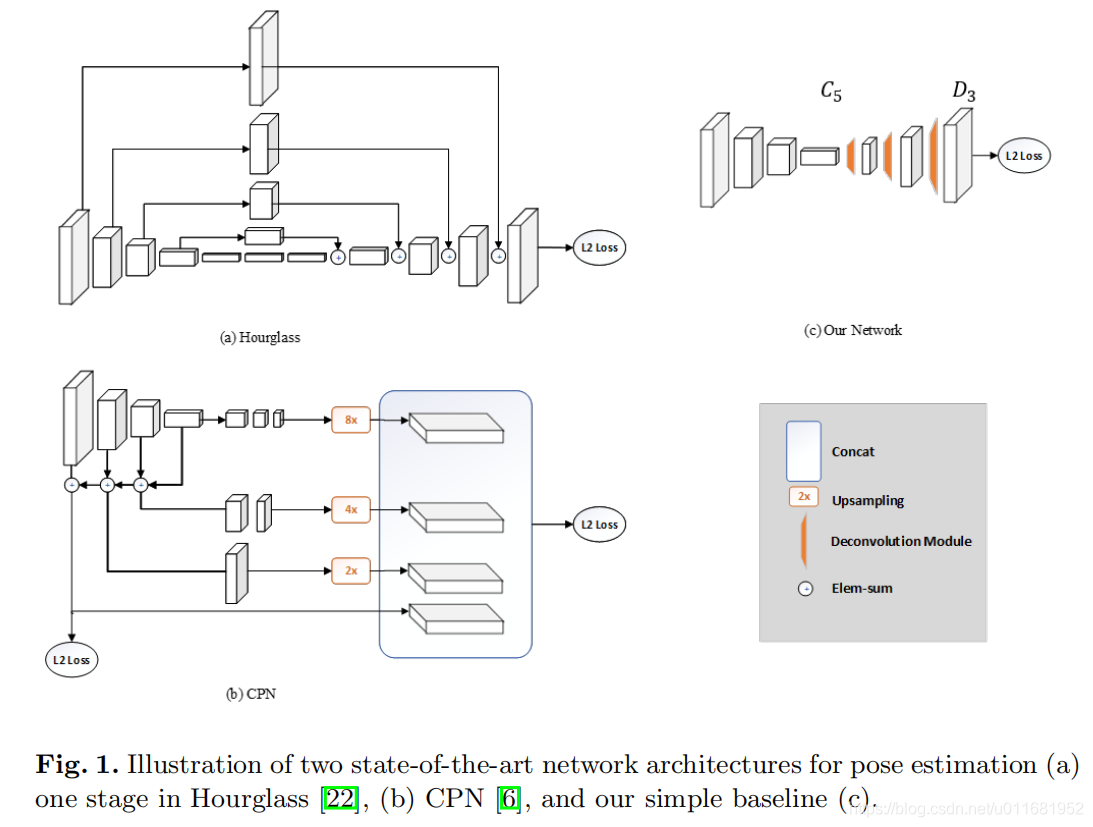

本文提出的模型结构非常简单,如下

1)上图中a是Hourglass网络,b是CPN,c是本文的SimplePose,可以直观看出结构的复杂度对比

2)前两种结构需要构造金字塔特征结构,如FPN或从Resnet构建

3)SimplePose则不需要构建金字塔特征结构,它是直接在Resnet后面设计反卷积模块并输出结果

4)具体结构:

首先:在Resnet的基础上,取最后残差模块输出特征层(命名C5)

然后:后面接上3个反卷积模块(每个模块为:Deconv + batchnorm + relu,反卷积参数,256通道,44卷积核,stride为2,pad为1)

最后:用11实现输出热力图

在这些模型中,可以看出如何生成高分辨率特征图是姿态估计的一个关键,SimplePose采用Deconv扩大特征图的分辨率,Hourglass,CPN中采用的是upsampling+skip方式;当然我们很难就这一个实例就判定那种方式好

Experiments

1)Backbone和Input Size对比

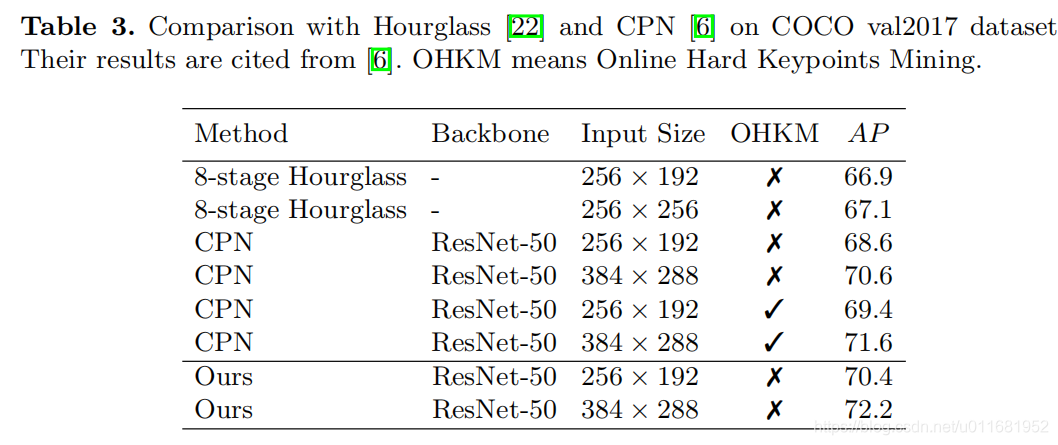

2)Hourglass,CPN对比

3)金典算法对比