姿态估计 - Simple Baselines for Human Pose Estimation and Tracking

其他

2021-03-18 18:49:59

阅读次数: 0

0. 前言

- 相关资料:

- 论文基本信息

- 领域:人体姿态跟踪

- 作者单位:微软亚洲研究院

- 发表时间:ECCV 2018

- 一句话总结:提出了单人姿态估计(ResNet+Deconv)以及人体姿态追踪(上一帧结果+光流预测当前帧结果,基于光流的bbox相似度计算方法)的简单方法。

1. 要解决什么问题

- 当时在姿态估计上有较大进展,担任姿态估计数据集MPII和COCO人体姿态数据集上都有较大提升。

- 希望在pose tracking(即人体姿态追踪)进行研究,但相关研究较少。

- 当时的大量姿态估计网络结构之间又打区别,但准确率差距不大,很难判断哪些细节是有效的,哪些作用不大。

2. 用了什么方法

- 本文方法的设计思路与众不同:简单的方法能达到怎样的精度?

- 按照这个思路提供了姿态估计与姿态追踪的baseline。

- 单人姿态估计baseline

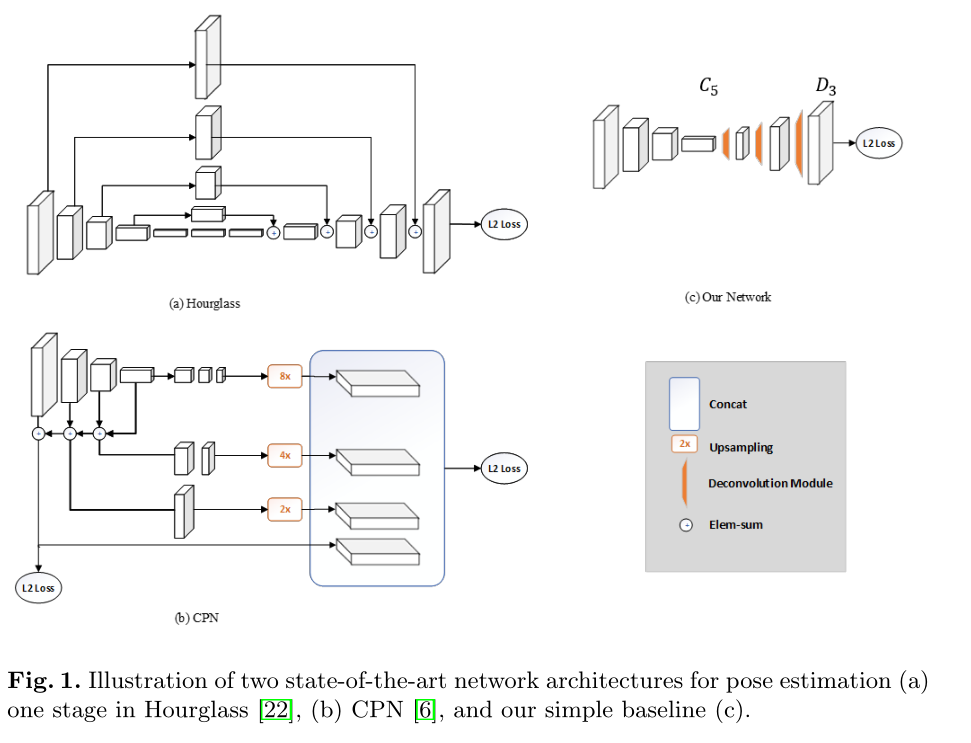

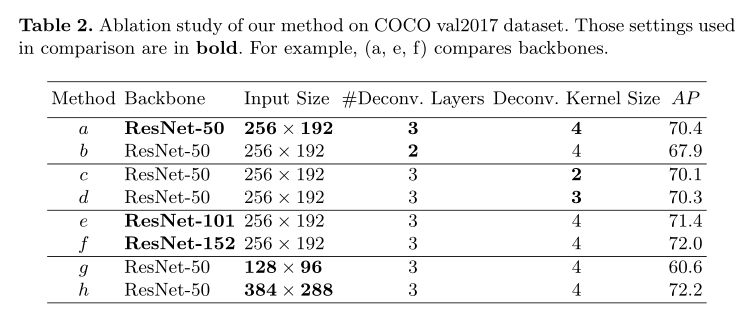

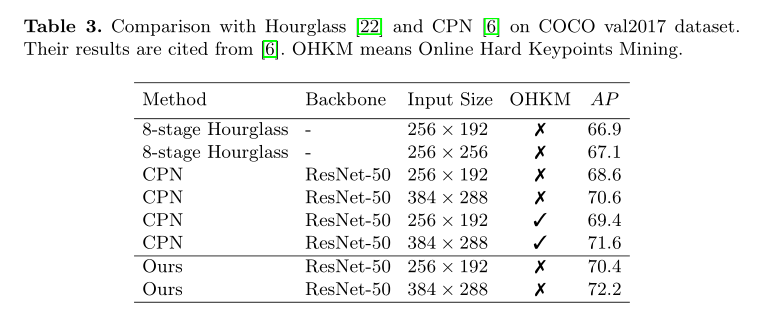

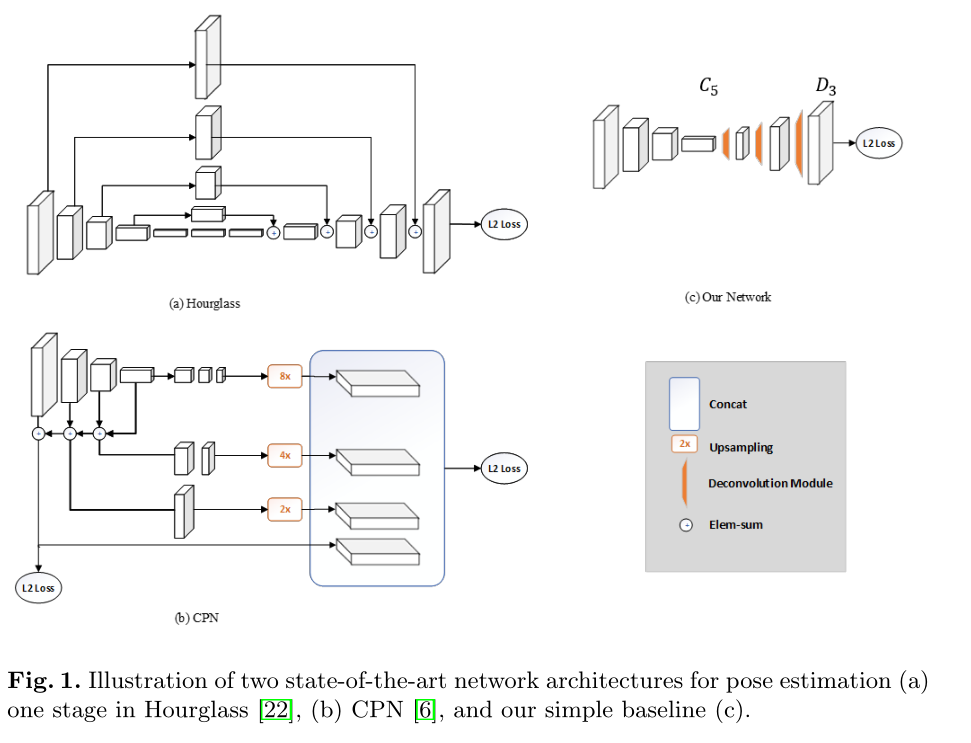

- 在ResNet后面添加一些转置卷积。可以看出,我们的结果比CPN、Hourglass容易很多,且我们的结果使用转置卷积(而不是双线性插值)作为上采样方式,且没有使用skip connection(应该是block间没有skip connection,但block中有没有需要看下源码)。

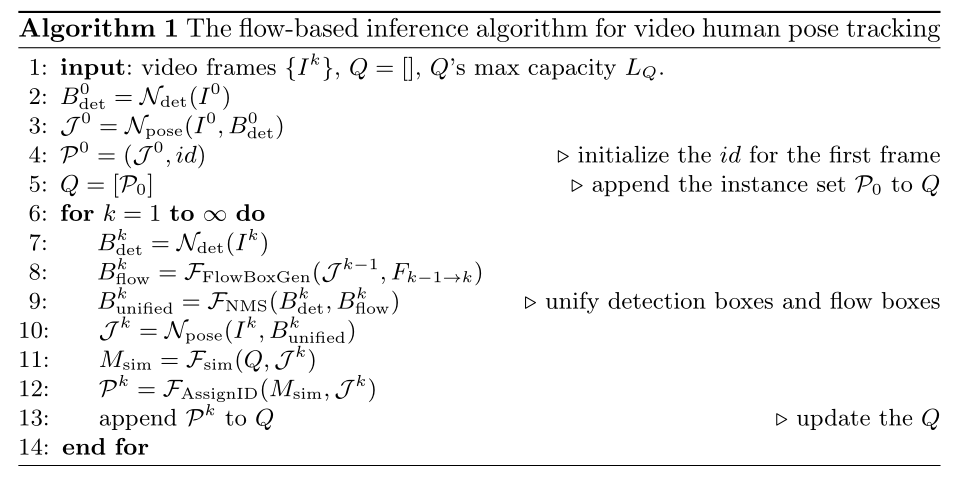

- 人体姿态追踪baseline

- Pose Track问题描述

- 已知前一帧的所有人物姿态以及对应人物id,当前帧所有人物姿态

- 求当前帧所有人物id

- 以前的方法(PoseTrack 2017的冠军方法)

- 先使用Mask R-CNN进行多人姿态估计

- 再使用基于贪心二分匹配:前一帧与当前帧结果进行二分匹配计算相似度,选择最高的两个进行匹配使用相同的id,依次执行上一部,如果当前帧还有剩下的就分配新的id

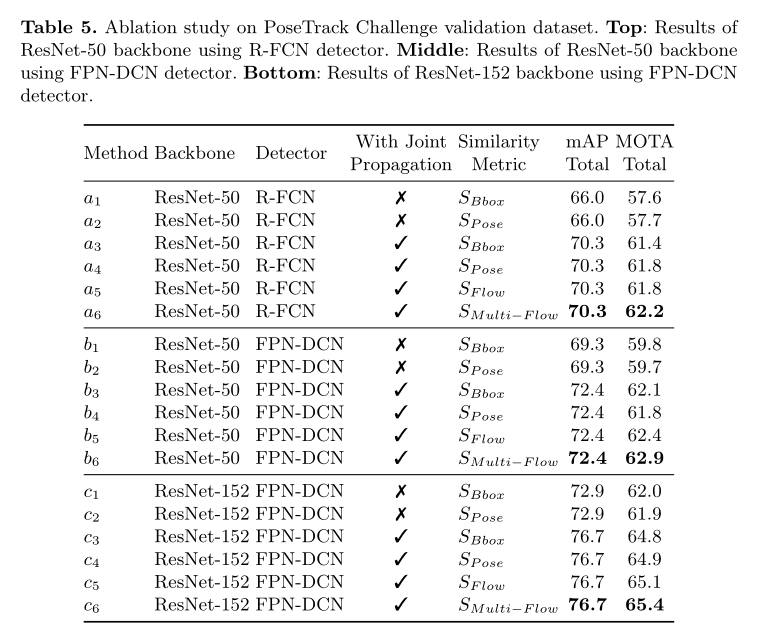

- 主要改动:use optical flow based pose propagation and similarity measurement

- 人体bbox的来源有两种,一是当前帧Mask R-CNN结果,二是上一帧结果以及光流估计的bbox(详情参考论文3.2)。

- 计算两个bbox的相似度,提出了一种基于流的体改相似度指标,详情参考论文3.3。

- 总体流程如下

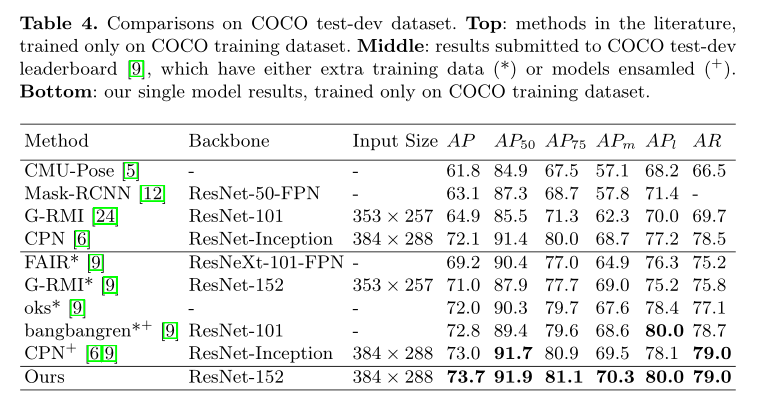

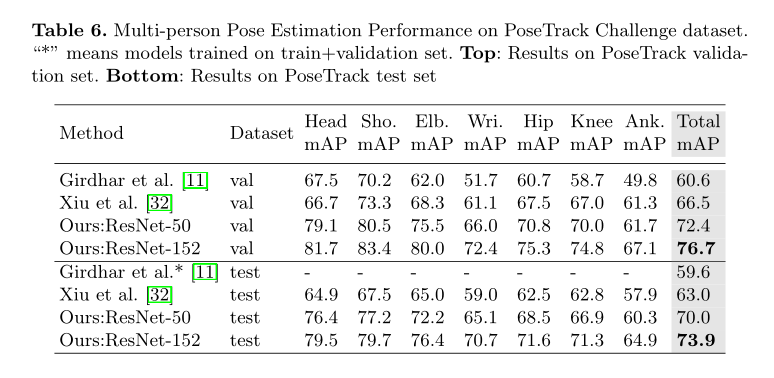

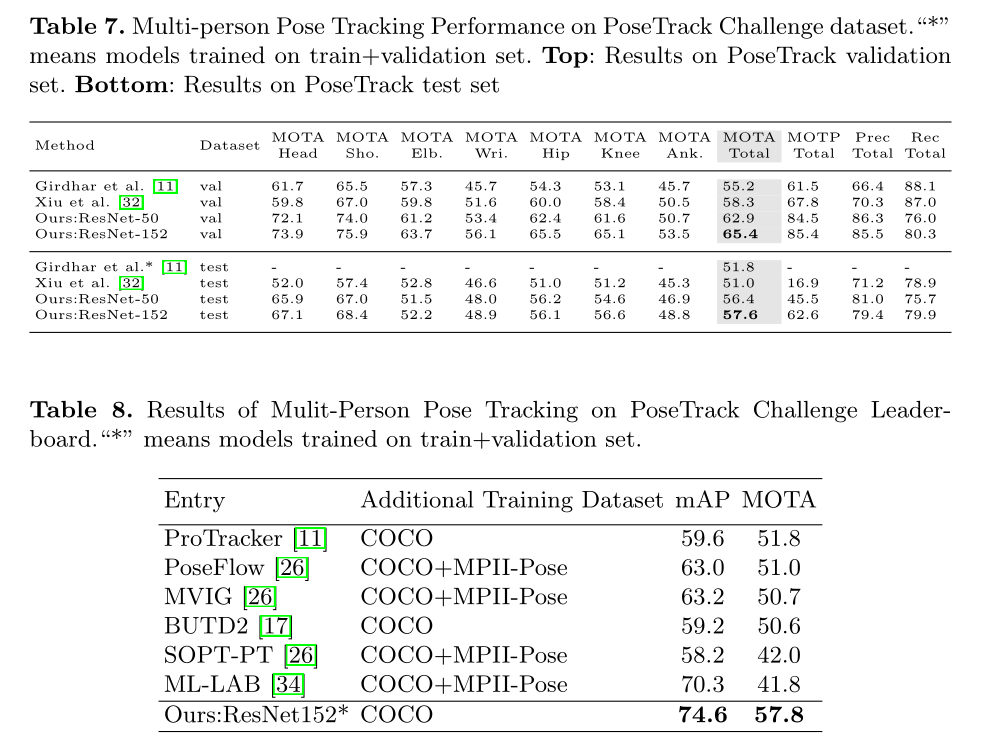

3. 效果如何

4. 还存在什么问题&可借鉴之处

- Pose Track 这个任务倒是挺有意思,可以稍微多看几眼。

转载自blog.csdn.net/irving512/article/details/112505673