论文地址:Simple Baselines for Human Pose Estimation and Tracking

代码地址:https://github.com/leoxiaobin/pose.pytorch

论文总结

本文的方法和内容如文章名一般,是为了提供一个人体姿态检测和跟踪的Baseline,且易于实现。本文在网络结构上没有多的花哨的思想,只是在backbone后添加了几个deconv层,没有skip connection传递特征。通过实验得到对应的超参数。在论文实验上,也没有中间监督什么的track,就是简单的基于heatmap的训练。

然后在pose track上,提出基于光流的姿态传播和相似度度量,而不是之前简单的那种基于human detector的bounding box IoU度量。

论文内容介绍

Pose Estimation

本文的网络结构如上图所示,就是在 backbone 后添加了几个 deconv 层,每个 deconv 后都接着 BN 层和 ReLU,每个 deconv 的 channel 数都为256,kernel_size 为4,stride 为2。最后在预测层,使用一个1*1 conv 得到对应 channel 的 heatmap。

Pose Track

Pose Track 基本都是对边框和ID进行跟踪。相较于贪婪匹配两帧中预测的 bounding box IoU,本文采用的跟踪管道有两点不同:(1)产生两种Bounding box:1. human detector产生的;2. 前面帧使用光流产生的;(2)贪婪匹配的相似度度量不同,本文使用的是基于光流的pose 相似度度量。

使用光流进行关节点跟踪

基于光流的跟踪:对前一帧的每个关键节点使用光流跟踪,利用跟踪后的点,扩展边框 15% (两边分别 7.5%)得到候选 bounding box。采用光流的跟踪,可以有效地为human detector的错检和漏检进行改善。

基于光流的pose 相似度

当人物移动过快时,IoU 作为相似度度量可能带来问题,因为没有(低)overLap。利用 OKS 度量是进一步的做法,但当姿态在不同帧发生变化时,也会产生问题。所以,本文发生的是基于光流的 pose 相似度度量。

采用的策略是:使用前面(数)帧(特定)实例的跟踪,与当前的实例进行 OKS 计算。这是因为在考虑到遮挡的问题下,实例人总是消失又重现,连续两帧内的跟踪是不足够的,故进行多帧的基于光流的 pose 相似度量,标记为 S M u l t i − f l o w S_{Multi-flow} SMulti−flow。在这种情况下,可以实现 relink 那些在中间帧消失的实例。

基于光流的Pose Track

检测框和跟踪的边框结合起来,一起使用bounding box NMS 操作,跟踪的边框作为漏检的补充。最后由bounding box 通过 crop 和 resize 处理后,进行姿态估计。

为防止因为遮挡导致的目标丢失,需要重新赋 ID 的问题,使用光流跟踪的边框以联系不同的帧之间的实例 ID 的传递。

实验

训练时,扩展bounding box到指定的长宽比(4:3),再resize到指定的分辨率(256*192)。使用的学习策略为 1 e − 3 1e^{-3} 1e−3的初始学习率,在 90 epochs 掉到 1 e − 4 1e^{-4} 1e−4和 120 epochs 掉到 1 e − 5 1e^{-5} 1e−5。batch_size 为128,使用Adam 优化器。

测试时,使用 faster-RCNN 作为human detector,使用 flip 测试增强。同时,采用最高响应到第二响应的 1 / 4 1/4 1/4 作为最后的检测点处。

消融学习

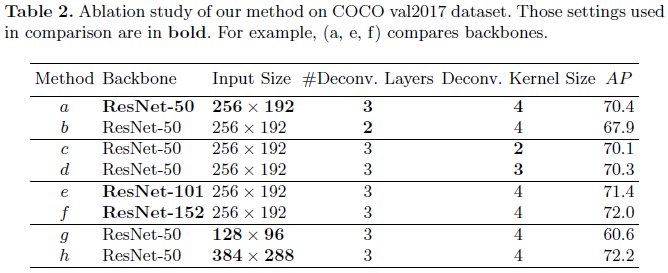

从下表可以看出:

- 由(a), (b)可以得出结论:8倍的下采样比4倍的下采样 AP 下降了2.5。因此,默认使用3层deconv;

- 由(a), (c ), (d)可以得出结论:小的kernel_size会造成明显的 AP 差距,因此,默认使用kernel_size为4;

- 由(a), (e), (f)可以得出结论:更深的网络增长不大(相较于增长的运行时间和资源增长),因此,默认使用ResNet-50;

- 由(a), (g), (h)可以得出结论:图片分辨率很重要。 384 ∗ 288 384*288 384∗288会带来更高的 AP,但也带来更大的计算量;

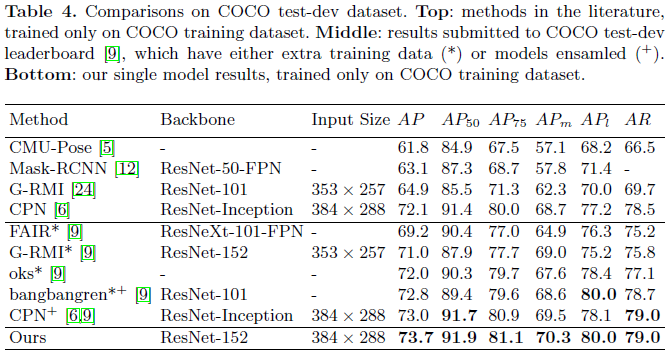

不同算法在COCO val2017数据集上的表现,如下表所示。由于 Hourglass 和 CPN 是原文的结果,而不是本文作者实现的,所以性能上的 AP 差异不一定是性能差异,也可能是实现上的差异。但本文所提出的算法结构仍是具有可比性的,且是较简单的。

不同算法在COCO val2017数据集上的表现,如下表所示: