这个超分效果,亲测不错,而且作者提出的残差注意网络方便实用。

论文认为图像输入和特征中含有丰富的低频信息,这些信息在不同的信道中被平等对待,从而阻碍了cnn的表征能力,因此提出了一种非常深的残差通道注意网络(RCAN)。

(1)如何解决更深:当然是利用残差网络,因此基于残差设计了一个非常深的网络,即一个大残差模块中包含多个小的残差模块(RIR:residual in residual)。通过长连接将这些大残差模块连接起来。这些小的残差模块中的残差通过短连接将它们连接起来。

超分的重点是恢复高频细节:RIR允许丰富的低频信息通过多个跳转连接,直接传递,避免信息受损,使主网络专注于高频信息的学习。

(2)跨特征通道的区分学习能力:不要平等对待每一个通道:基于注意力通道:考虑到通道直接的依赖关系,作者设计了一个基于注意力的通道结构,感觉来自SENet。

如下图:为整个网络结构,属于图像(LR图像)通过卷积提前特征,再通过多个残差组,然后经过上采样模块,卷积,得到最终的HR图像。

论文认为,简单地将残差模块堆叠起来构建更深层次的网络很难得到更好的改进。更深层次的网络是否能进一步对图像SR做出贡献,以及如何构建更深层次的可训练网络,还有待探索。另外对信道通道特征一视同仁,在处理不同类型的信息时缺乏灵活性。

图像SR可以看作图恢复尽可能多的高频信息的过程。因此输入图像(LR图像)包含大部分低频信息,可以直接传输到最终的HR输出,使得网络更加专注高频信息学习。但是另外目前基于cnn的方法对每个通道的特征都一视同仁,缺乏跨特征通道的区分学习能力,阻碍了深层网络的表征能力。为了切实解决这些问题,论文提出了一种残差注意网络(RCAN),以获得非常深的可训练网络,同时自适应地学习更多有用的通道特征

RIR:如何使网络更深且不影响训练

为了使深度网络(如400层以上)的训练容易,论文提出残差包含残差(RIR)结构,残差组(RG)作为基本模块,通过一个长跳连接来进行连接。每一个残差组里面的多个简单的残差模块则通过短跳连连接。这个长跳连接和这个短跳连接使得丰富的低频信息可以进行传递。允许网络的主要部分集中在LR高频学习。

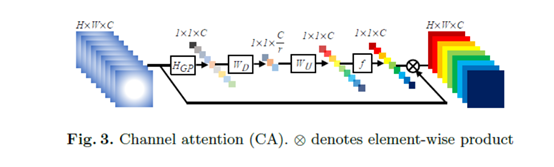

CA: 如何使每一个通道得到不同的注意力?也就是为每一个通道赋予不同的权重,那么如何得到这个权重图。见下图Fig3,感觉这块主要来自【12】SENet)。

作者主要基于两点考虑:首先,LR空间中的信息具有丰富的低频和有价值的高频成分。低频部分比较平坦。高频部分通常是区域,充满边缘、纹理和其他细节。另一方面,Conv层中的每个过滤器都有一个局部感受野。因此,卷积后的输出无法利用局部感受野外的上下文信息。

因此,先通过使用全局平均池化,将信道方向的全局空间信息转换为信道描述符。取每一个feature map 的和,这种信道统计量可以看作是局部描述符的集合,这些局部描述符的统计量有助于表示整个图像。除了全局平均池之外,这里还可以引入更复杂的聚合技术。

作者以捕捉通道的依赖关系为目的引入了一种门控机制。其应满足两个条件:首先,它必须灵活(它尤其应该能够捕捉通道之间的非线性相互作用关系),其次它必须能够在多个通道在经过多次激活函数情况下学习多个通道之间非互斥关系。

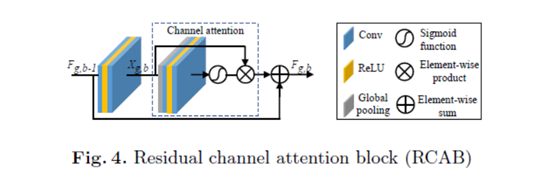

最终设计一个RCAB模块,也就是将注意力融合到残差模块中,如下图: