文章地址:https://arxiv.org/abs/1807.02758

补充材料地址:Support-RCAN

作者的项目地址: RCAN-Pytorch

1 网络介绍

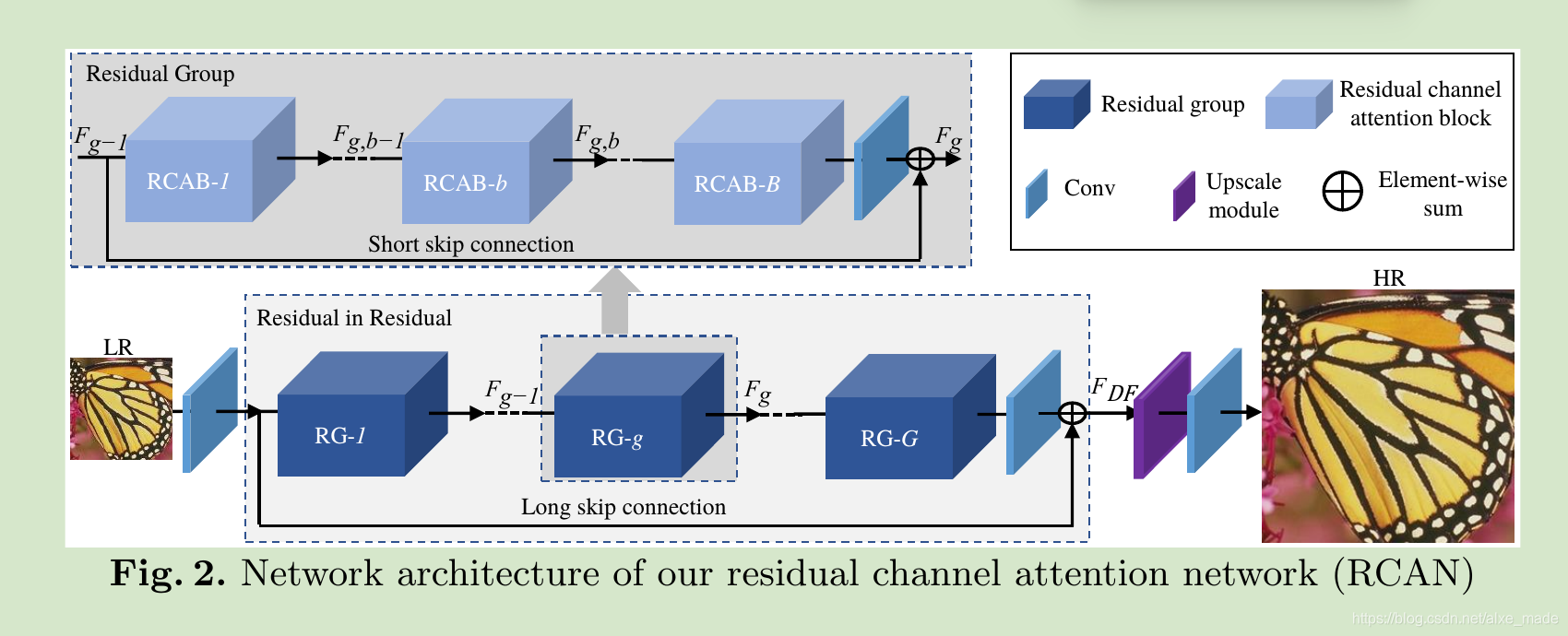

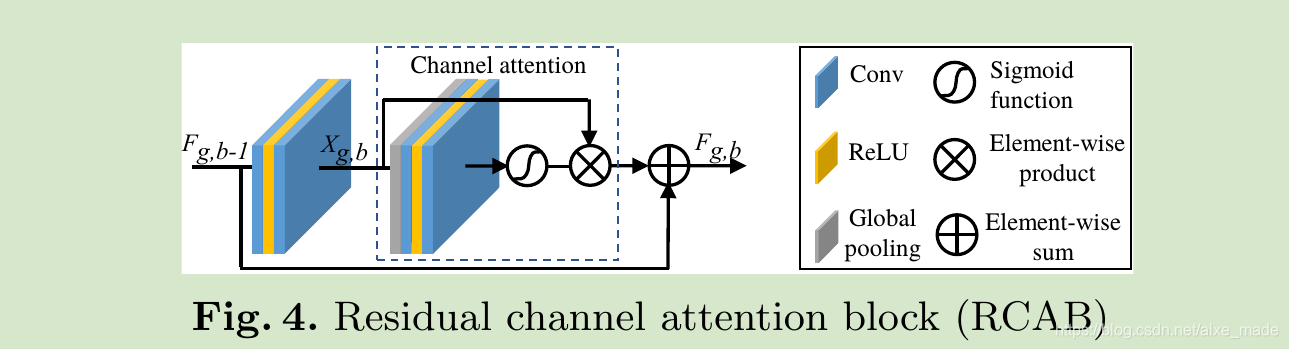

在这篇文章中,作者提出了一种让CNN更深的方法:首先要做的就是,准备10个残差组(RG),其中每组包含20个残差通道注意模块(RCAB)。

研究人员表示网络的深度很重要,我们也认为如此,也见证过EDSR和MDSR带来的一波浪潮。然而,通过简单堆叠残差块来构建更深的网络可能很难得到更大的提升,需要在架构方面有更多进展。

所以,他们提出了RIR(residual in residual)架构,堆叠的每个残差组里包含很多残差块,因此我们也可以获得长跳过(LSC)连接和短跳过(SSC)连接。

上述提到的映射和残差块中的快捷键可以绕开低频信息。

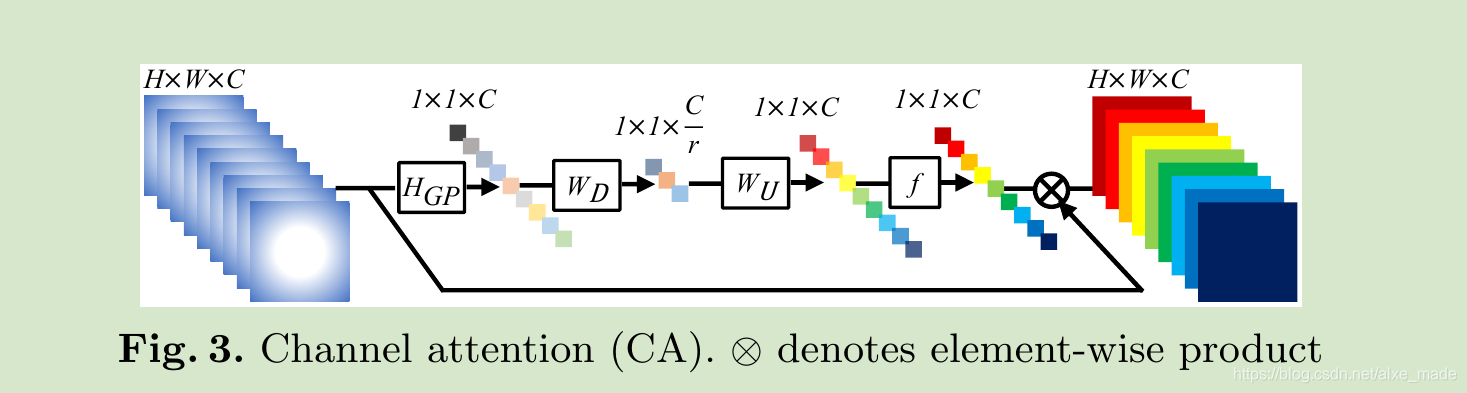

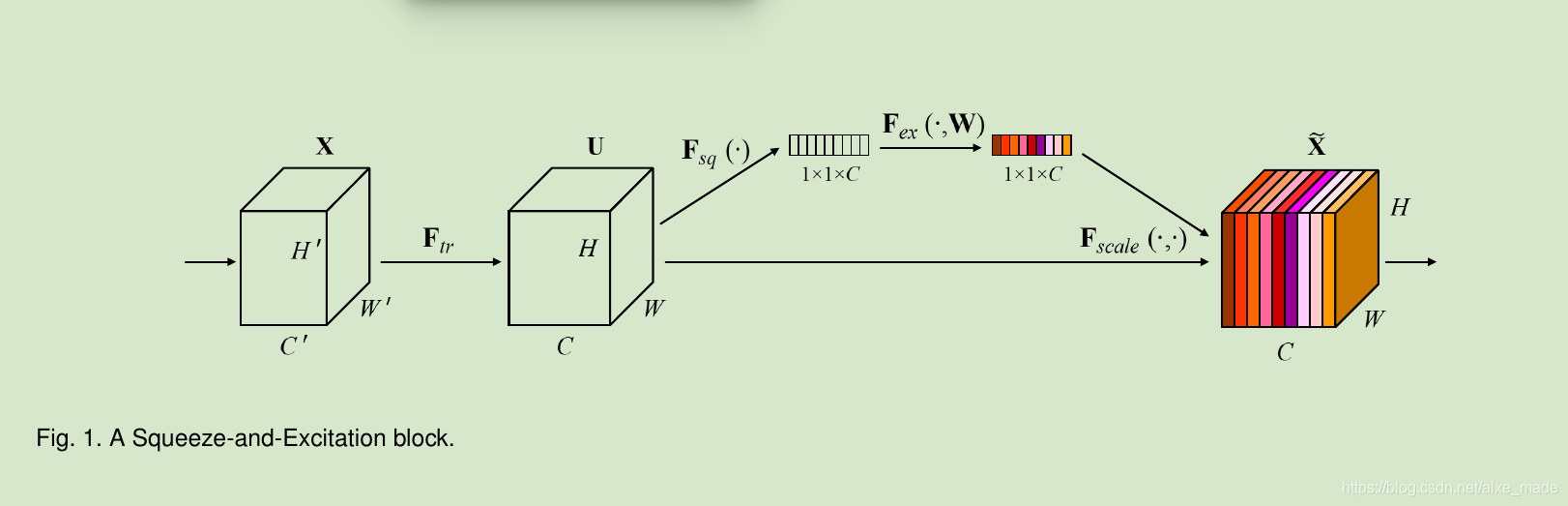

其实乍一看感觉挺复杂的,但是仔细的阅读作者的文章,发现也是很容易的理解的。作者的工作主要两个方面,第一个就是RIR(Residual in Residual)无非就是利用ResNets的相关思想,提出了LSC和SSC策略,让我们的网络可以达到很深,比如大于400层。另外一个方面就是引入了CA模块,也就是注意力机制,简单来说,之前的SR文章对待feature map中每一个通道是一样的,作者认为每一个通道的重要性不一样,有些通道重要,而有些不那么重要,所以我们要扬长避短, 增加重要通道的权重,抑制不那么重要的权重。其实,这个一看RCAB模块,发现就是Squeeze-and-Excitation Networks文章里面的 “Squeeze-and-Excitation” (SE) block,这项工作拿到了ImageNet2017 image classification 的冠军,原本是一个分类任务,作者很好的运用到SR任务上了。下图是Squeeze-and-Excitation Networks的核心网络:

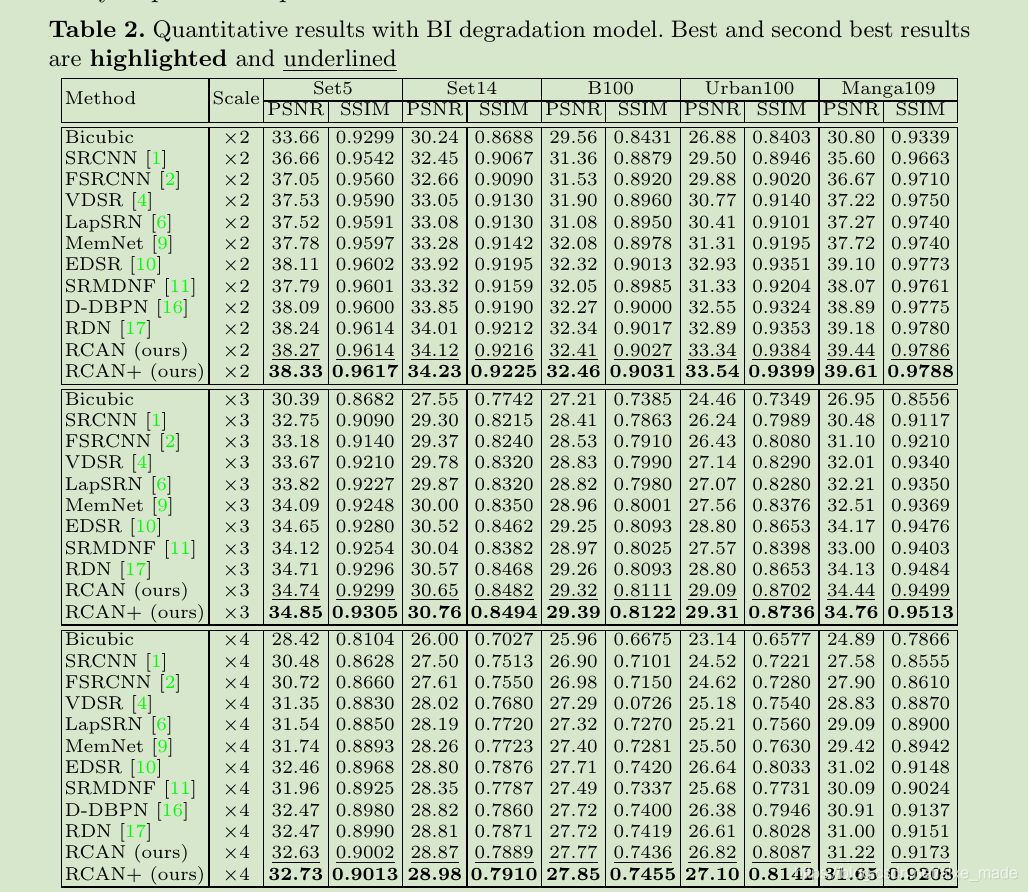

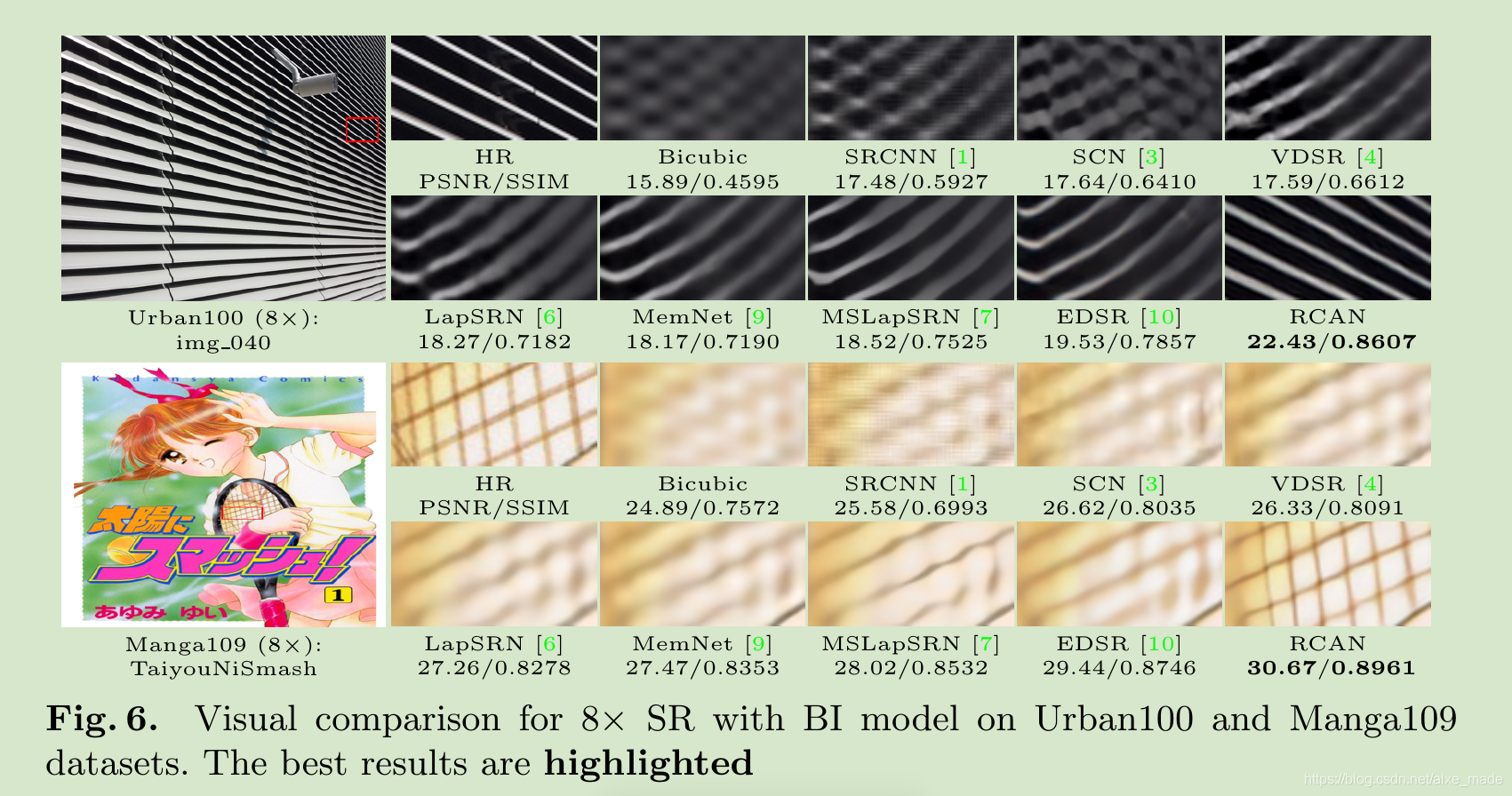

2 结果

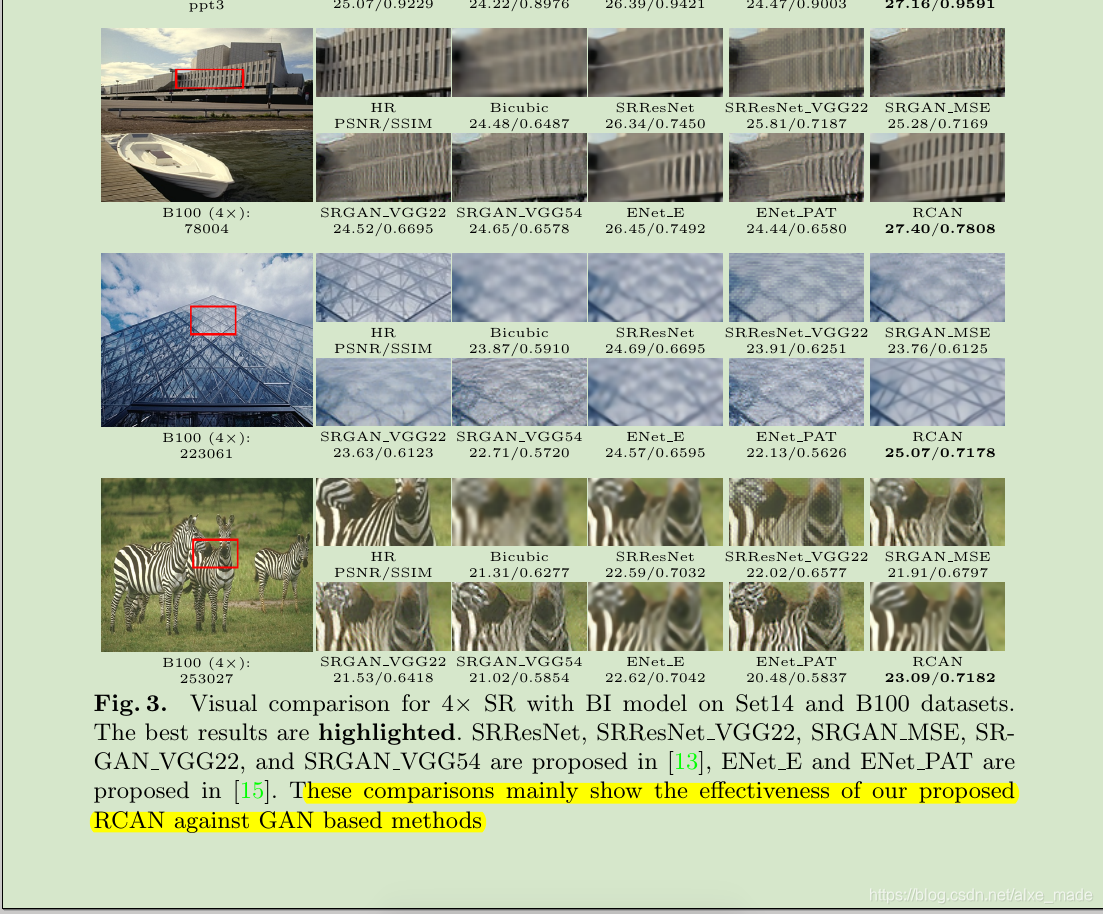

从结果上来看,作者做了大量的实验,并且从结果也证明RCAN网络具有优良的表现。值得一题的是,在作者的补充材料中,作者也做出了更多的对比实验,这里列举一个实验是作者对比GAN相关的实验:

从结果上看,基于GAN的几个网络表现并没有想象中那样好,可能的原因就是训练太困难。另外作者的项目是基于EDSR,核心的RCAN模块实现也是比较简单的。

3 感想

从最近的几篇文章来看,可能会有更多的文章运用注意力机制。比如传统的NLP领域,以及最近的图像分类、图像标注,推荐几篇相关的文章,以及比较好的关于注意力机制入门的文章。

- CVPR2018: Tell Me Where to Look: Guided Attention Inference Network

- CVPR2017: Residual Attention Network for Image Classification

- CVPR2017: SCA-CNN: Spatial and Channel-wise Attention in Convolutional Networks

for Image Captioning - 深度学习中的注意力机制

- 知乎:从2017年顶会论文看 Attention Model

- 知乎:模型汇总24 - 深度学习中Attention Mechanism详细介绍:原理、分类及应用