一:需求

1.卷积网络的输入和输出多为固定尺寸(样本大小和模式)

2.解决序列问题:语言问题,时间序列预测问题(和基础单位相关)

需要保存上下文信息,很难/无法选择上下文窗口大小

二:Recurrent Neutral Networks(RNNs)

时间递归神经网络 Recurrent Neutral Network

结构递归神经网络 Recursive Neutral Network

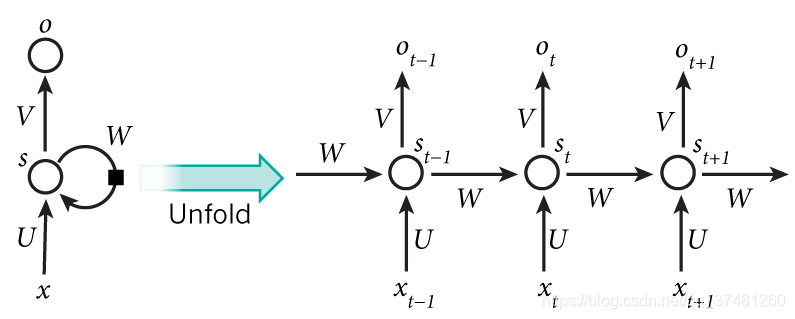

1.RNN将上一次的输出或者隐状态作为一下次的输入

2.对于某个时间t,历史信息T< t会被保存,会保留信息

3.weights参数共享

4.吸收了HMM模型(马尔可夫)的表达

5.RNN是一类扩展的人工神经网络,它是为了对序列数据进行建模而产生的

针对:文本,语音,视频,天气,股票

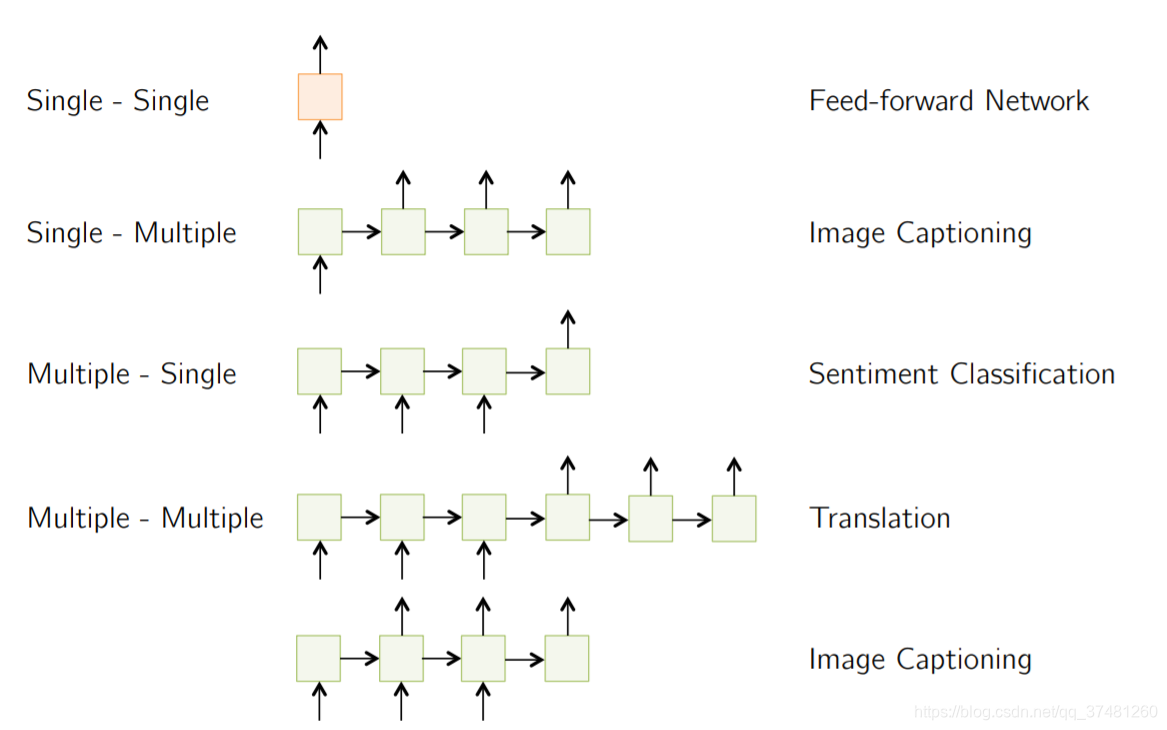

6.基本框架:一对一,一对多,多对一,多对多

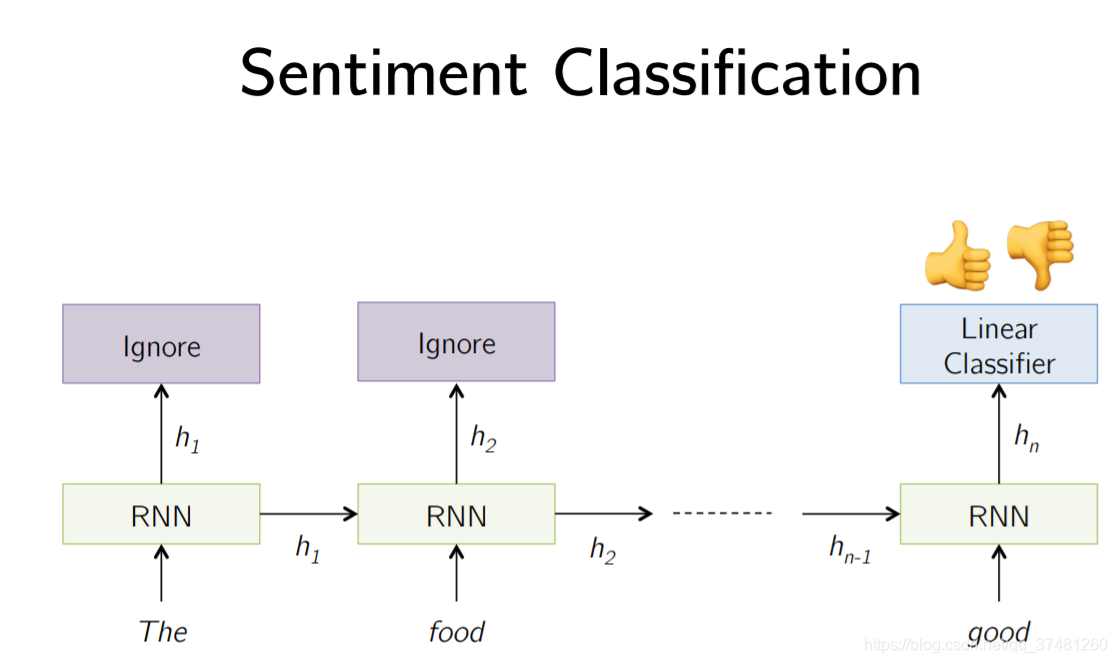

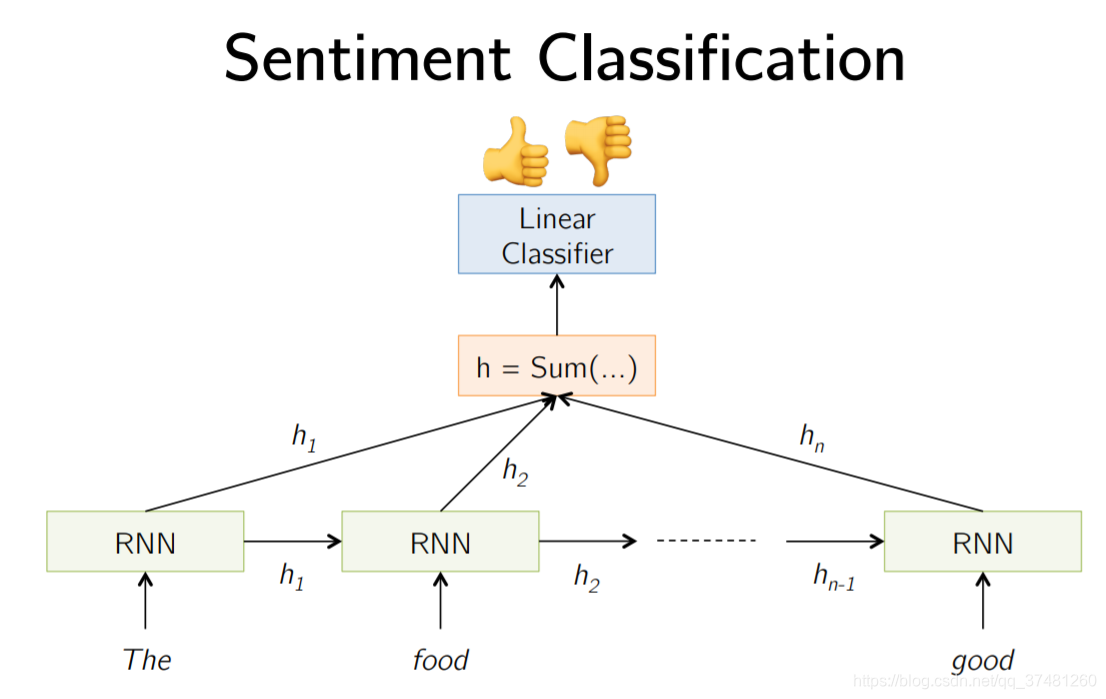

7.情感分类:

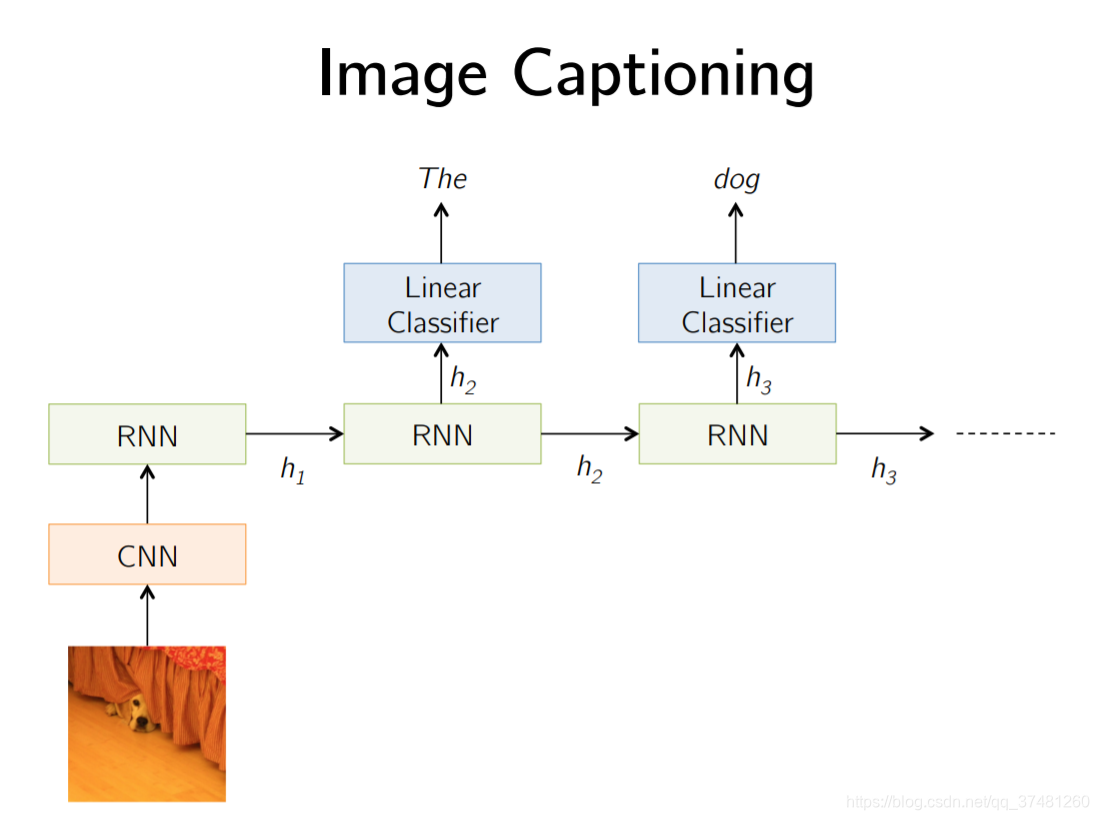

8.图像标注

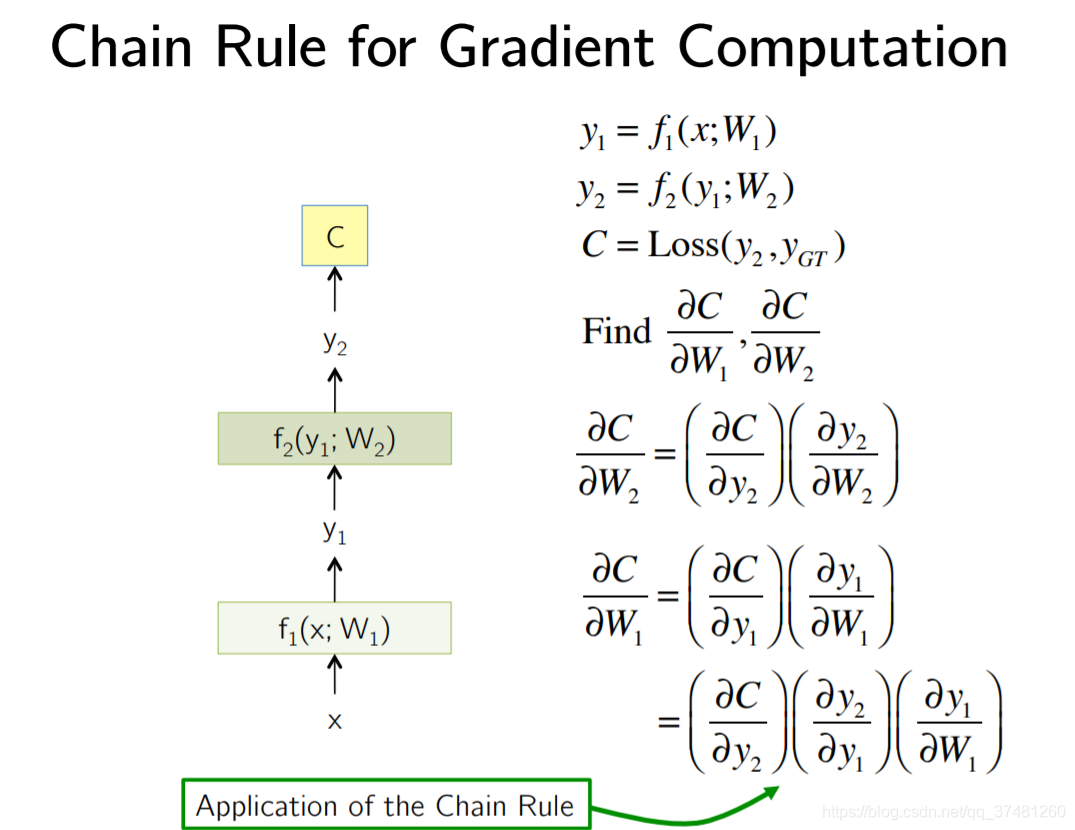

9.反向传播(BPTT Back Propagation Through Time)

固定长度,来一次更新一次

BPTT面临的问题:梯度消失问题,梯度爆炸问题

解决方案:选择其他合适的激活函数,如ReLU,引入改进网络结构的机制 如LSTM

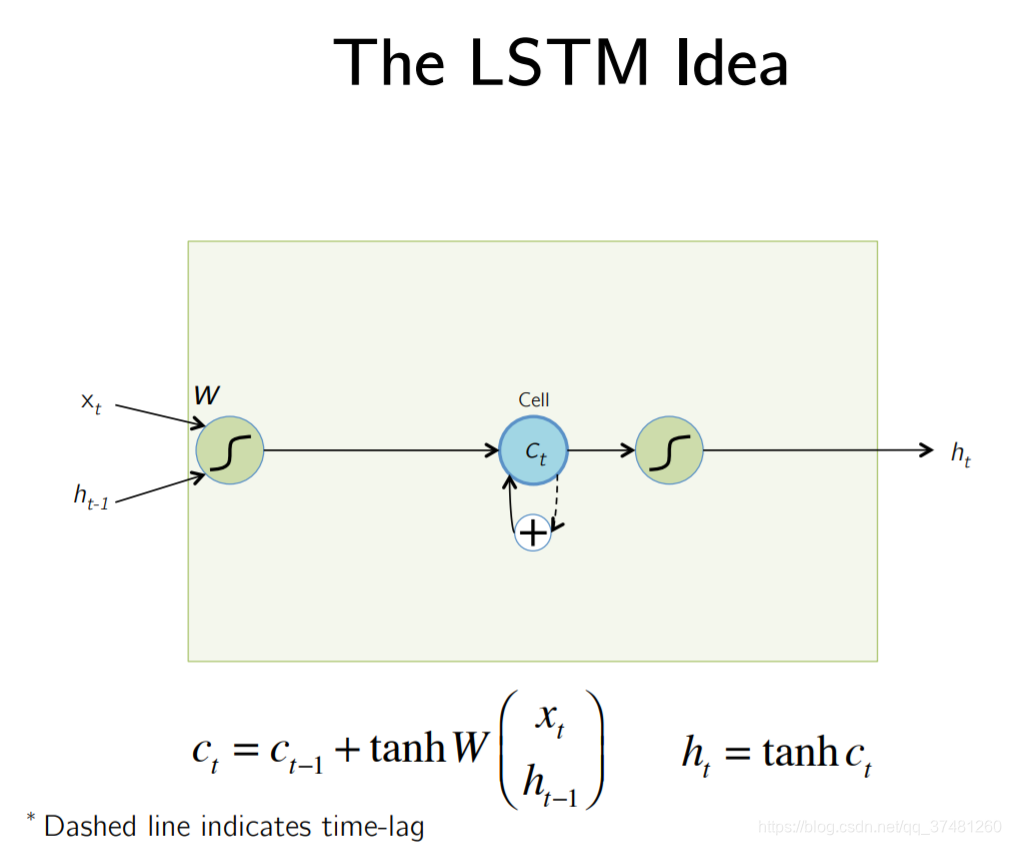

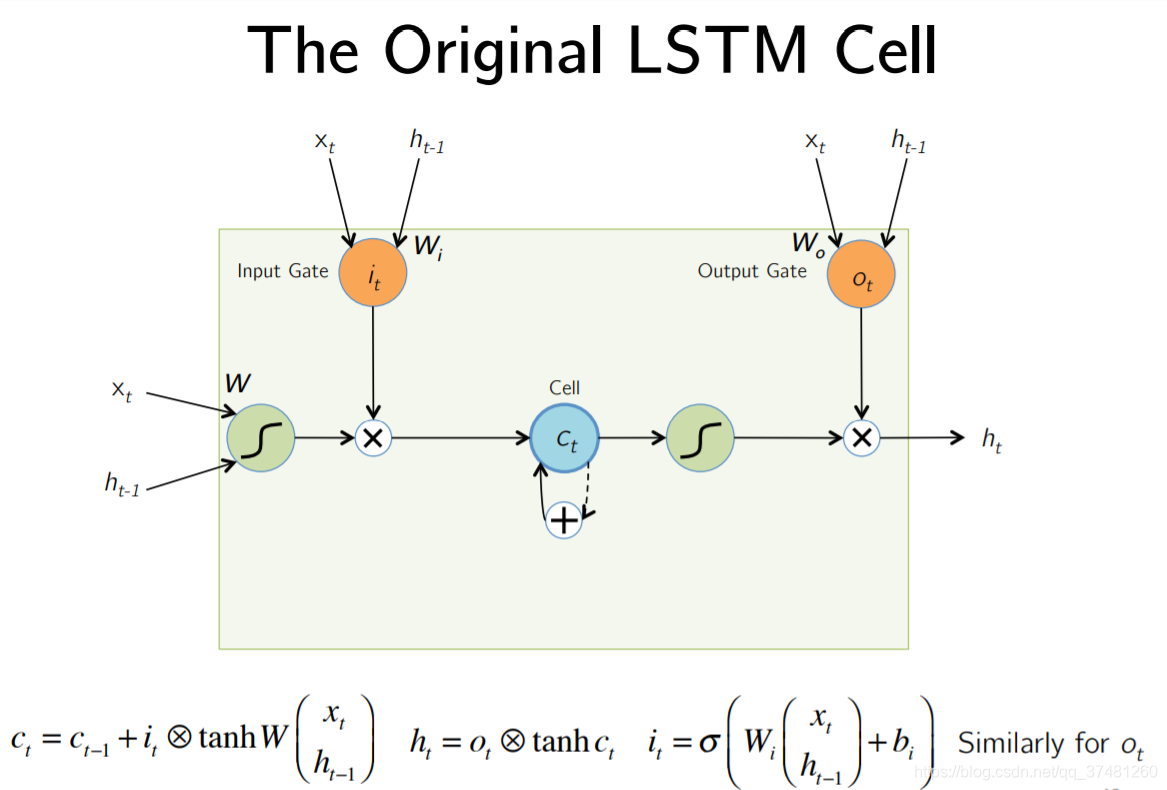

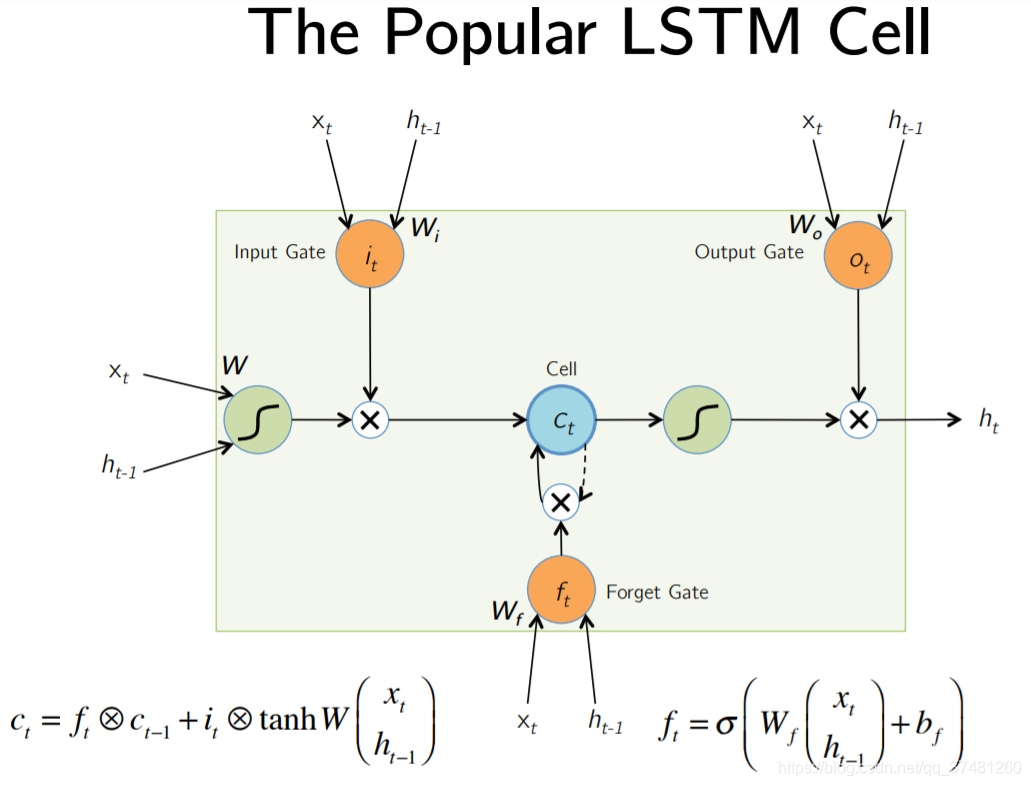

三:LSTM(Long Short-Term Memory)

1.引入恒定误差流

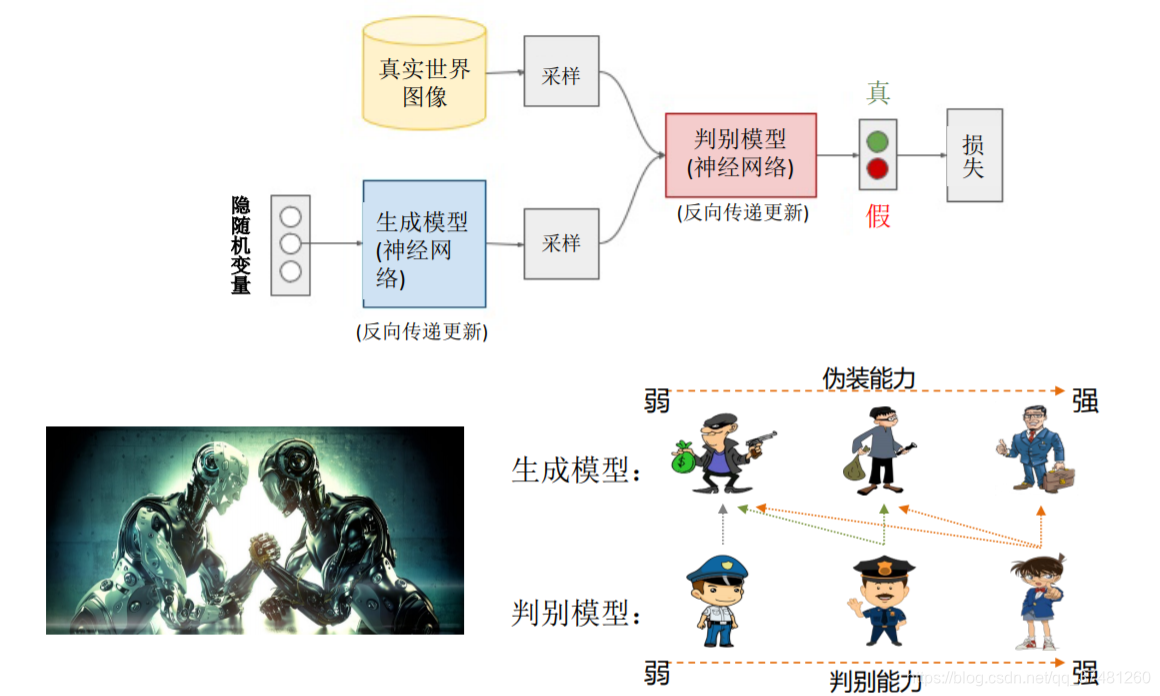

四:GAN(生成对抗模型)

• 测试高维复杂的概率分布建模

• 模拟未来 (规划, 仿真)

• 处理缺失数据

• 多模态输出

• 解决真实的数据生成问题

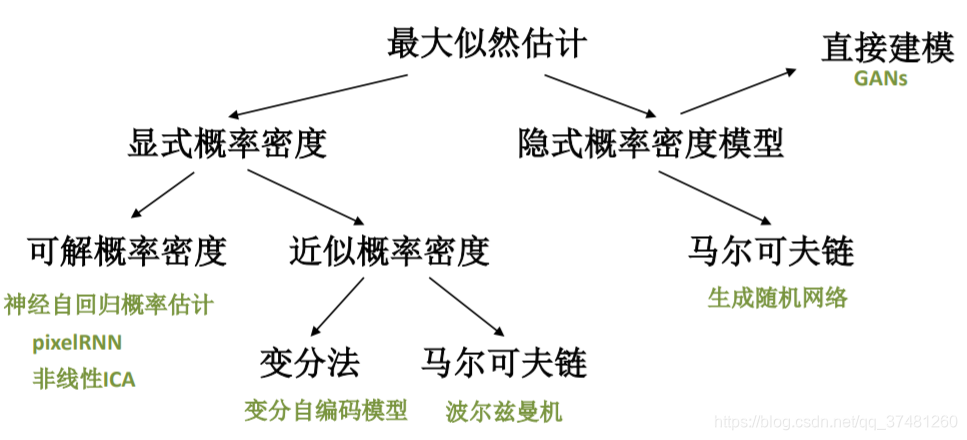

1.生成模型分类

Q:什么是显式过程,什么是隐式过程?

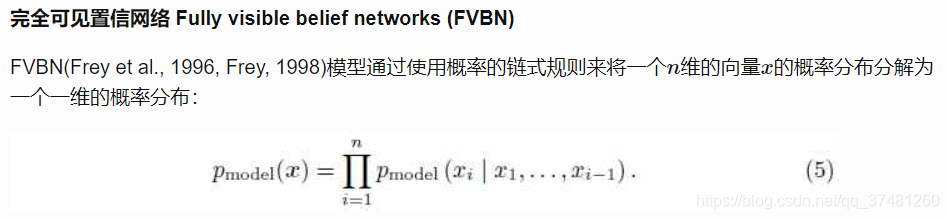

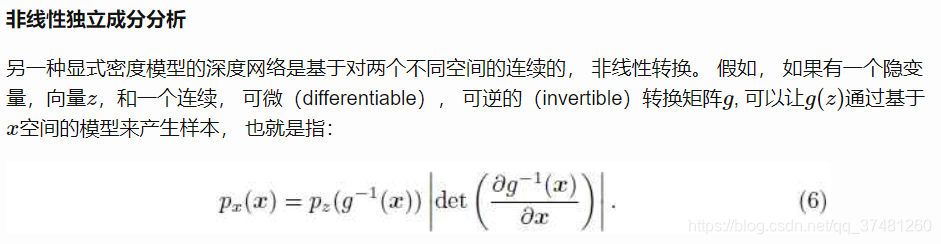

显式密度模型。 这种模型目前有两种流行的方法: 完全可见置信网络(Fully visible belief network) 和 非线性独立成分分析(nonlinear independent components analysis)。

隐式密度模型

有一些模型不需要定义显式的密度函数就可以被训练。 这些模型提供了一种与pmodel

间接的交互的方法, 通常是使用它们(也就是pmodel)的采样数据。

• 使用隐编码

• 近似一致 ( 优于变分模型)

• 不需马尔科夫链

• 生成数据质量高

基本框架:

参考:http://slazebni.cs.illinois.edu/spring17/lec02_rnn.pdf

http://ice.dlut.edu.cn/valse2018/ppt/Generative_Adversarial_Nets_JSFeng.pdf

https://sinpycn.github.io/2017/04/29/GAN-Tutorial-How-do-generative-models-work.html

https://wenku.baidu.com/view/b07dc5ef9b89680203d825e9.html