版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/bryant_meng/article/details/83422849

1 SVM

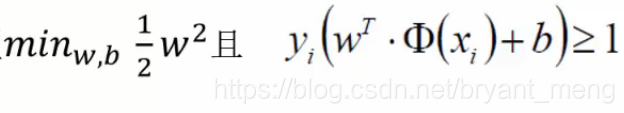

目标函数

详细的推导可以看 支持向量机原理篇之手撕线性SVM [★★★★★ 推荐], 此处不赘述,看完后,看能不能回答如下几个问题:

- margin 的求法,1的由来(放缩)

- min max L 中 max 由来(min max L 等价于 带约束的最小值——目标函数)

- min max L = max min L (强对偶)的由来(强对偶的等价条件是1.凸优化,2.满足 KKT条件)

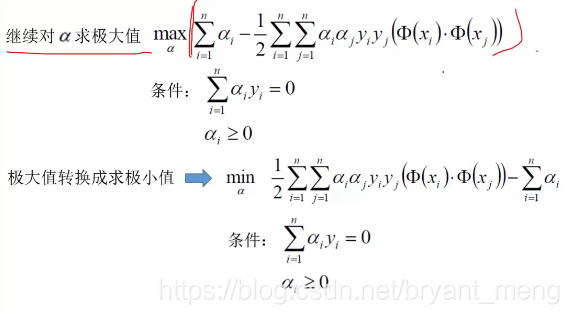

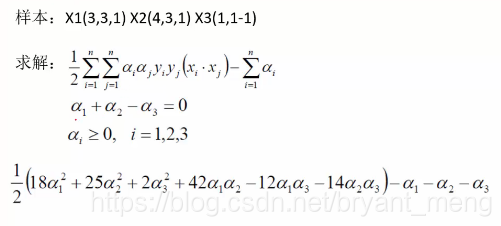

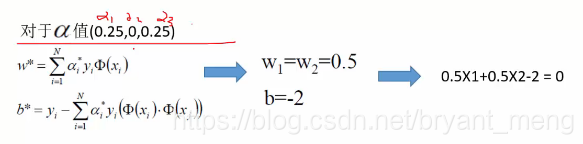

- min L 先求(w,b)最小值,之后 max 求 a 的最大值(二次规划方法),可以用 smo 方法,也可以用下面小例子1的方法(max 转化为 min优化问题)

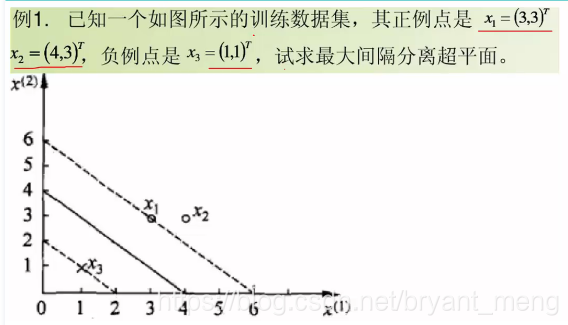

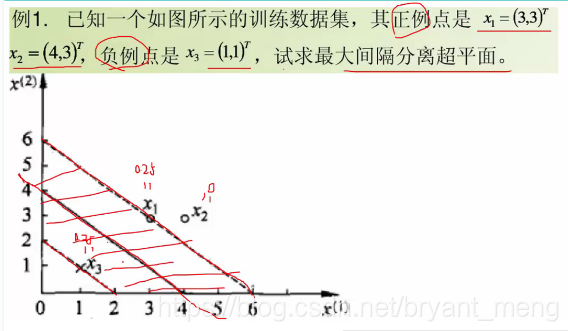

小例子:

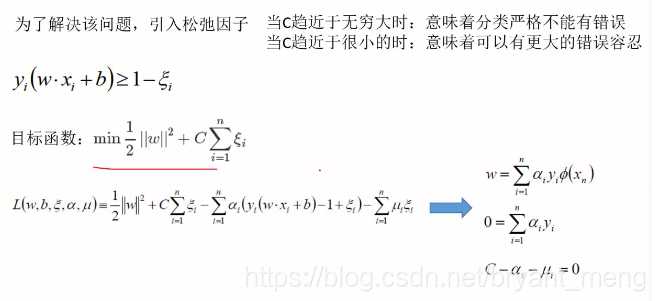

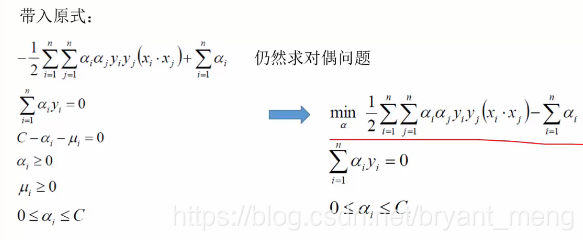

2 SVM+soft margin

扫描二维码关注公众号,回复:

3839173 查看本文章

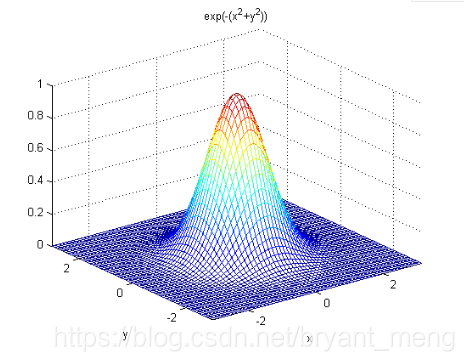

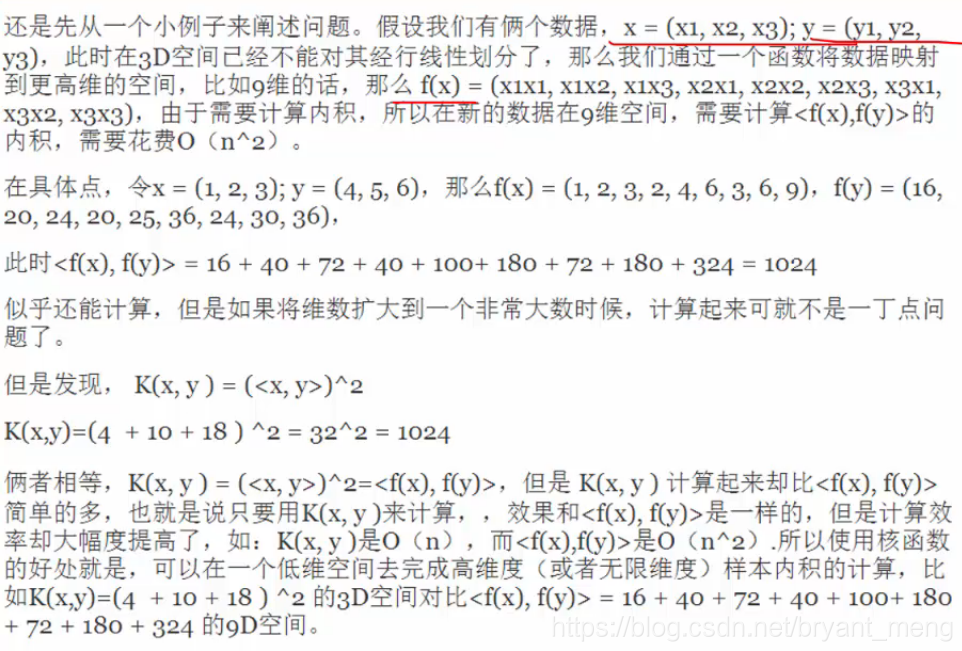

3 SVM + kernel function

,涉及到内积,注意,先对x,y平方(核函数映射),然后再算内积,等价于先算内积再平方(核函数映射)

我们要把数据映射到高维,然后分开(目标函数中出现内积),等价于在低维先内积,再映射到高维

例如,高斯核函数,把每个样本变都映射成一个高斯分布