版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/weixin_41427758/article/details/80557040

- 和之前一篇笔记思路比较像,也是考虑用多任务来做Re-ID来学到相对鲁棒的特征(多个损失),本文方法中根据不同loss的特点在不同层使用不同的loss来优化感觉很有意思,简单总结下本文的方法部分

Motivation

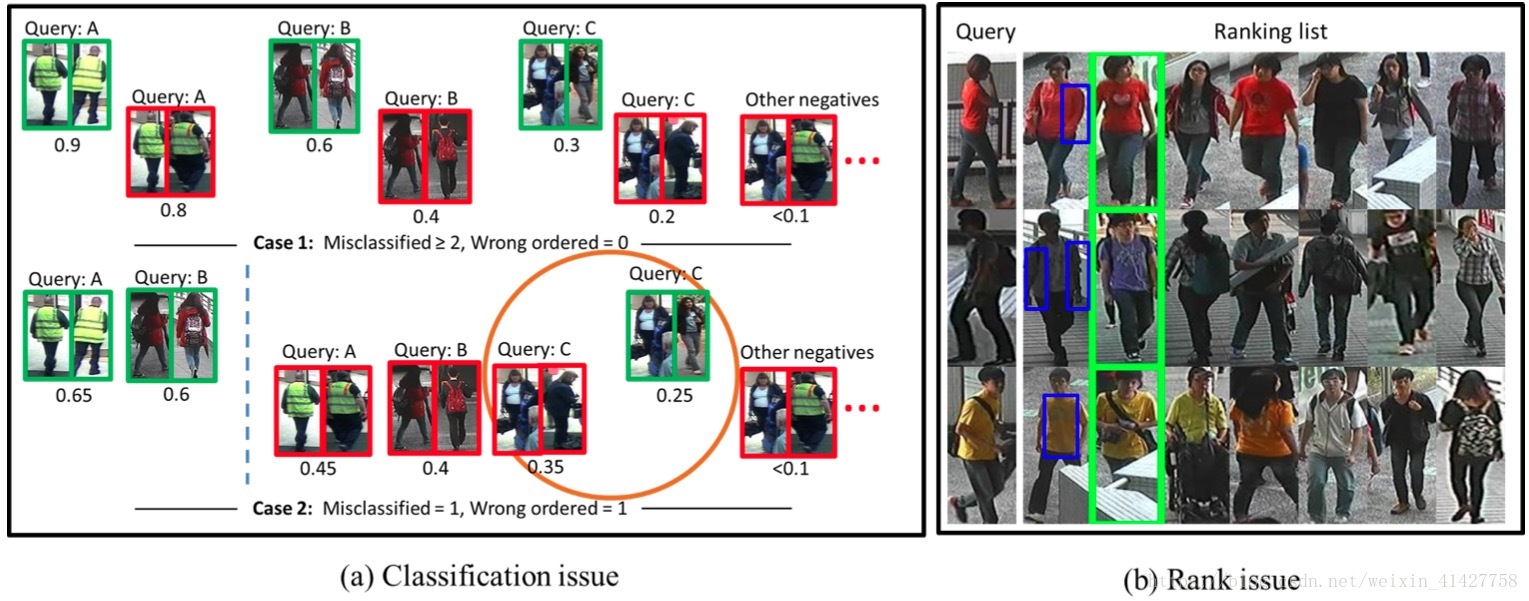

- rank loss与binary classification loss各有优缺点

- 对于深度学习方法来说,re-id数据集规模太小,难以在小数据集上训练深度网络

Contribution

- 新的多任务学习模型,两个任务针对不同的层来联合优化

- 针对有效的数据集,提出基于联合特征图的跨领域结构

- 在5个数据集上做了实验表明本文方法的优于大多数SOTA方法

Introduction

- binary cls loss目标是使所有的正例距离小于所有负例,这与在query时目标不一样(只需要正例距离小于其对应的负例子),randk loss可以解决这个问题

- rank loss会将正样本对在特征空间里有更近的距离,但是正样本对不一定是外观上最相似的?

- 数据集规模小问题 ==> 跨领域学习:借助较大的数据集辅助小数据集训

Related work

- 特征提取:

- 传统方法

- CNN提取

- 度量学习

The propsed network

The multi-task network:

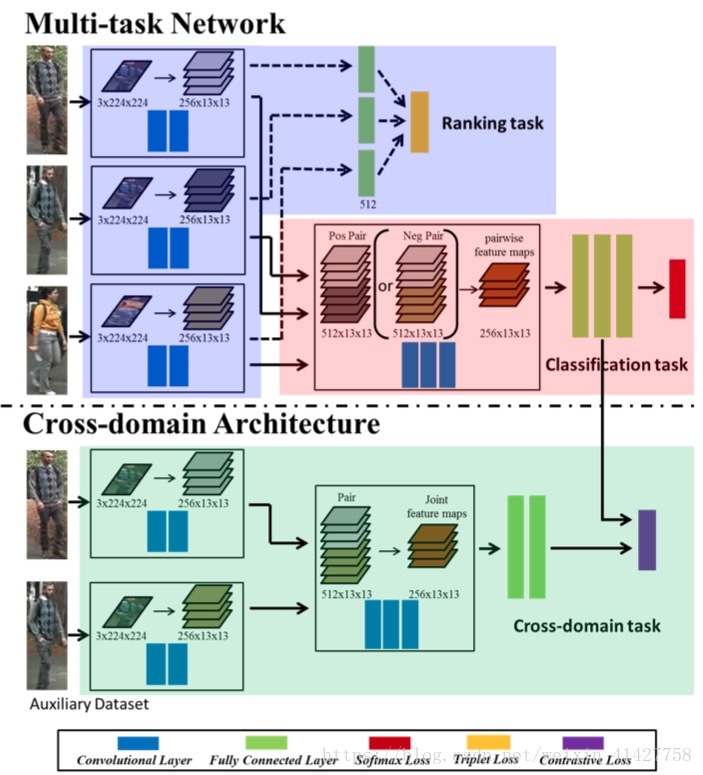

- 根据两个任务的不同点设计的网络:

- rank任务需要根据全局特征(low-level features)得到相似性分数

- 分类任务根据局部特征(semantic local features)来进行区分

- 根据上述两个loss的特点用在了网络不同的层来优化,得到对任务更加有利的特征。

rank部分:

三元输入模型:两个卷积层(shared) – > fc(shared) –> triple loss,公式如下:

cls部分:第三个卷积层的输入是三个input image经过前面两个卷积层256 * 13 * 13的feature map重组成两种类型的图像对,每一对特征图大小为512 * 13 * 13,图像对接着依次送入三个卷积网络输出得到joint feature map,再送入fc网络计算相似性,cls损失使用binary logistic regression loss,公式如下:(感觉少了log?)

- 训练阶段triplet loss优化前两个卷积层,分类loss优化整个网络

- 测试阶段只使用分类结构

Cross-domain architecture

- 主要用在辅助数据集上,多任务模型训练目标数据集,这个半监督的方法不是特别理解,思路很有意思,后面接着看

- input图像对 –> 两个卷积层(输出Concatate) –> 三个卷积层(输出joint feature map) –> contrastive loss

- 两个模型上输入图像对的label设计:对两个图像对的label作XNOR操作作为Contrastive loss的label,当两个图像对相同时,拉近两个数据集的joint feature map。

- 训练阶段仍然是个多任务,contrastive loss用来将不同数据集同类的joint feature map尽可能的相似

- 测试阶段只使用在目标数据集上训练的模型

- 该方法的主要目的是让不同数据集比较相似性的方式可以共享

Experiments

Setup

Implementation:

- Caffe

- input:224 x 224 水平翻转与其他数据增强加数据扩增4倍

- pre-train AlexNet权重来初始化前两个卷积层

- lr 10-3

- CMC

DataSet and settings:

- CUHK03

- CUHK01

- VIPrR

- iLIDS

- PRID2011

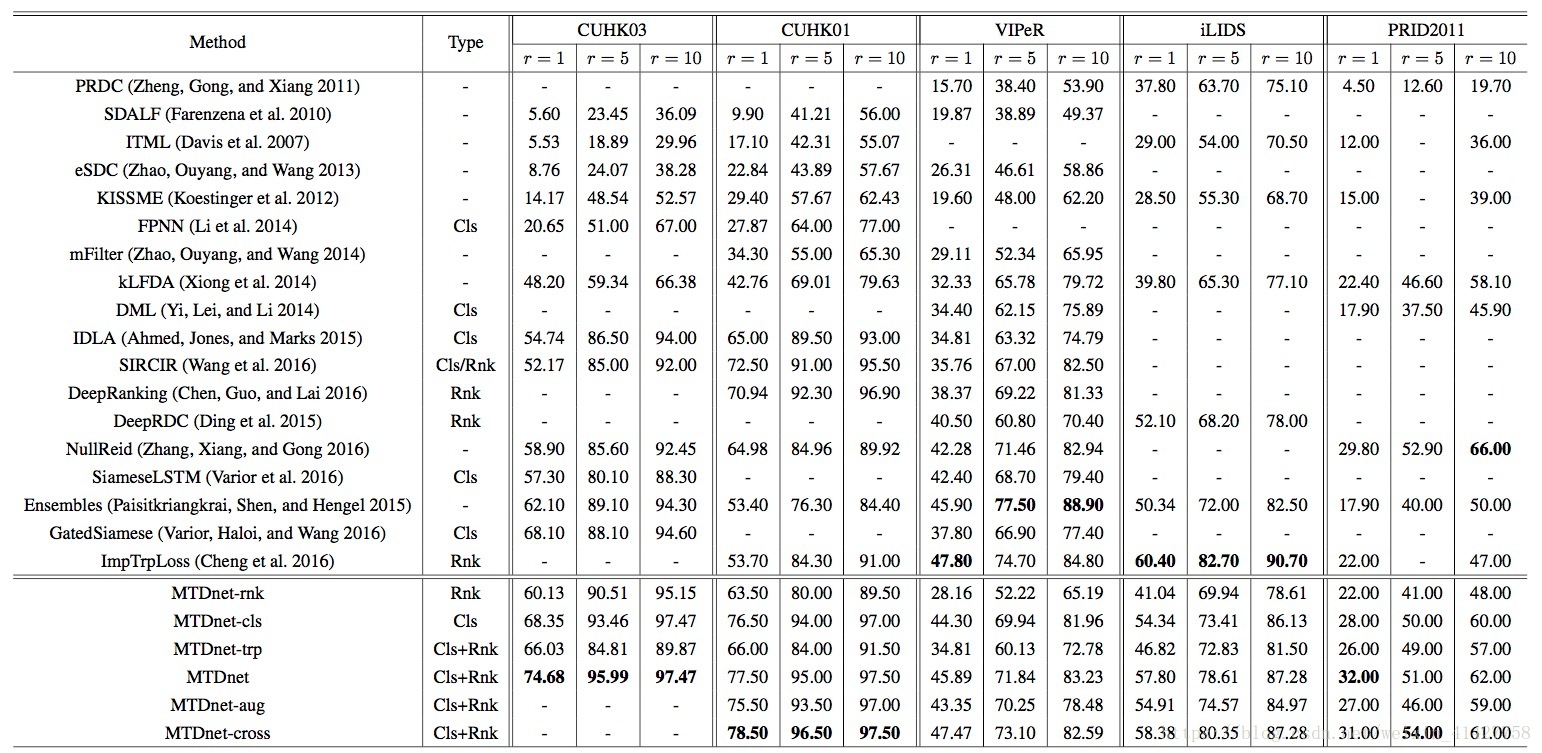

Results for the multi-task network

Multi vs. single task: 对比了测试使用rank loss、训练只用binary logistic classification loss或者triplet loss性能

Cross-domain architecrue: 使用CUHK03作为源数据,将其他四个小数据集作为目标数据集进行实验

Comparison with the state of the arts: 与SOTA结构比较

Conclusion

- cls与rank loss的互补

- cross-domain结构对小数据集的提高

- 优于SOTA方法的性能