多维特征

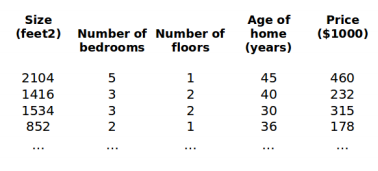

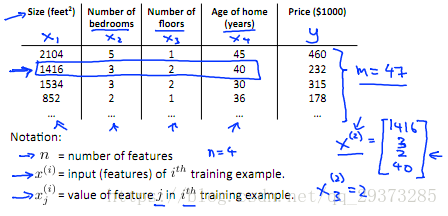

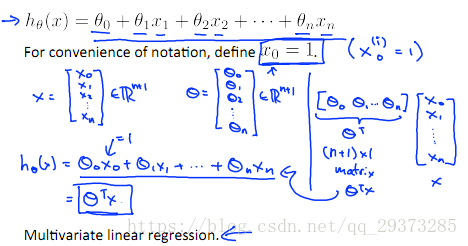

目前为止,我们探讨了单变量(特征)的回归模型,现在我们对房价模型增加更多的特征,如房间数楼层等,构成一个含有多个变量的模型,模型中的特征为(x ,x ,...,x )。

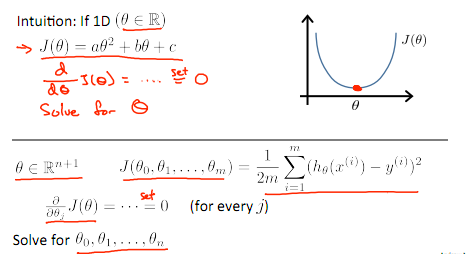

多变量梯度下降

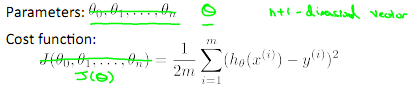

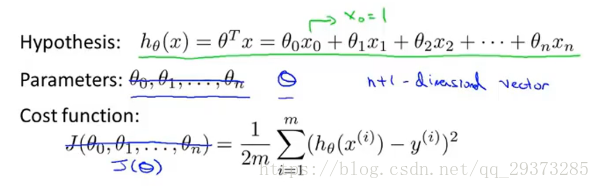

与单变量线性回归类似,在多变量线性回归中,我们也构建一个代价函数,则这个代价函数是所有建模误差的平方和,即:

其中:

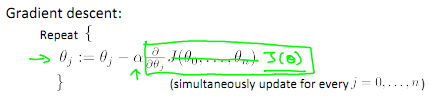

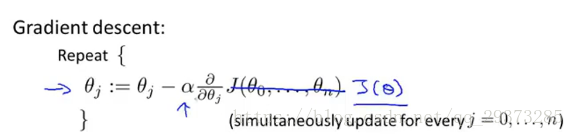

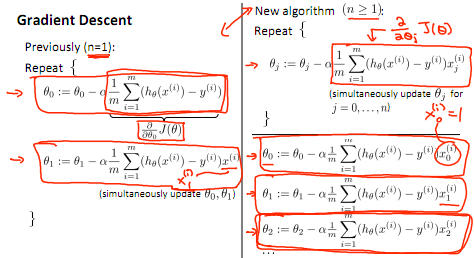

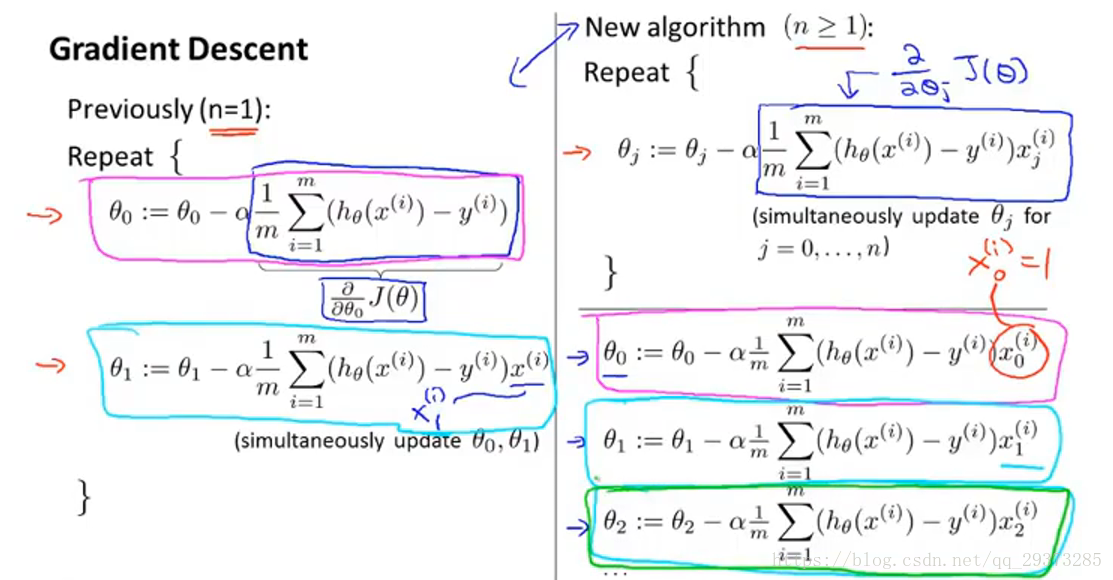

我们的目标和单变量线性回归问题中一样,是要找出使得代价函数最小的一系列参数。 多变量线性回归的批量梯度下降算法为:

左边为单变量学习方法,右边为多变量学习方法。

梯度下降法实践

1 特征缩放(使迭代次数减少,更快收敛)

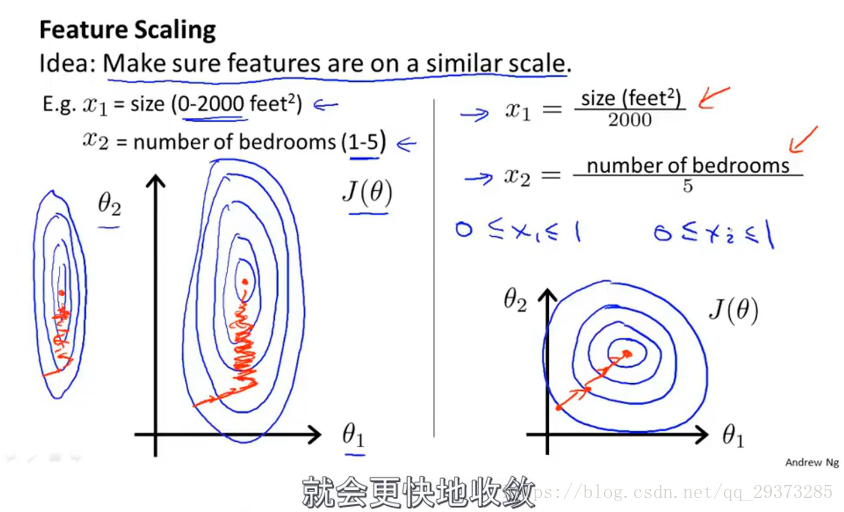

在我们面对多维特征问题的时候,我们要保证这些特征都具有相近的尺度,这将帮助梯度下降算法更快地收敛。

以房价问题为例,假设我们使用两个特征,房屋的尺寸和房间的数量,尺寸的值为 0-2000平方英尺,而房间数量的值则是0-5,以两个参数分别为横纵坐标,绘制代价函数的等高线图能,看出图像会显得很扁,梯度下降算法需要非常多次的迭代才能收敛。

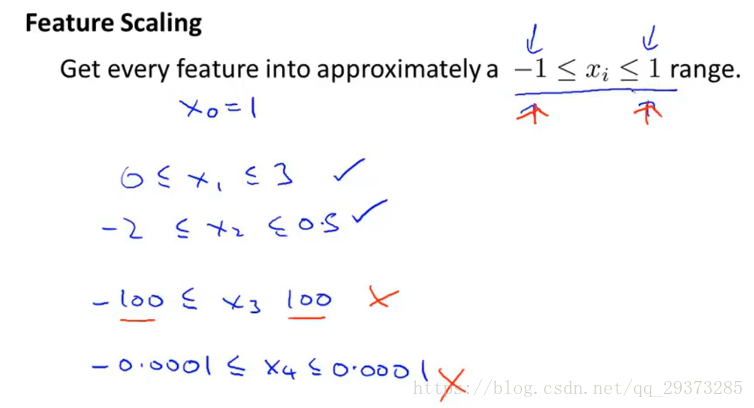

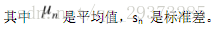

解决的方法是尝试将所有特征的尺度都尽量缩放到-1 到1之间。如图:

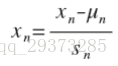

最简单的方法是令:

Sn也可以是range(Max-Min),u为平均值

2 学习率

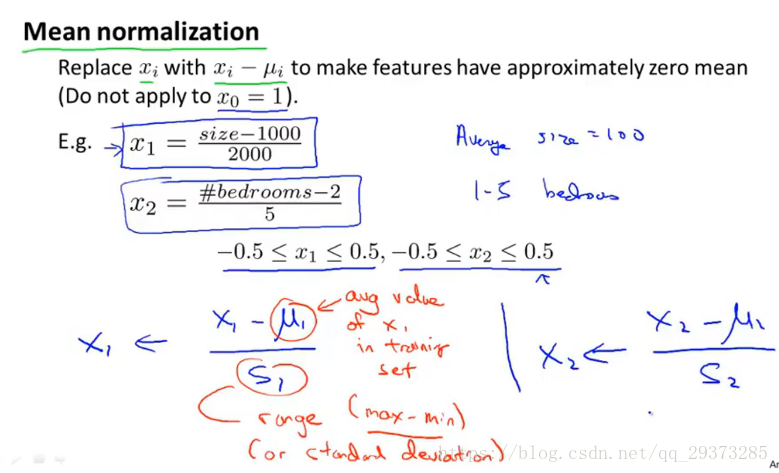

梯度下降算法收敛所需要的迭代次数根据模型的不同而不同,我们不能提前预知,我们可以绘制迭代次数和代价函数的图表来观测算法在何时趋于收敛。

梯度下降算法的每次迭代受到学习率的影响,如果学习率 α过小,则达到收敛所需的迭代次数会非常高;如果学习率α 过大,每次迭代可能不会减小代价函数,可能会越过局部最小值导致无法收敛。

通常可以考虑尝试些学习率:α=0.01,0.03,0.1,0.3,1,3,10

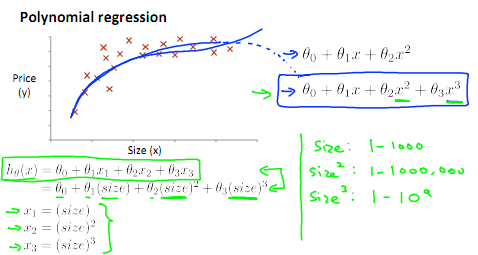

特征和多项式回归

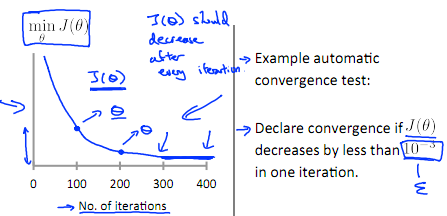

如房价预测问题:

线性回归并不适用于所有数据,有时我们需要曲线来适应我们的数据,通常我们需要先观察数据然后再决定准备尝试怎样的模型。另外,我们可以将模型转化为线性回归模型。如下图 x->size:

注:如果我们采用多项式回归模型,在运行梯度下降算法前,特征缩放非常有必要。

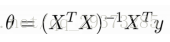

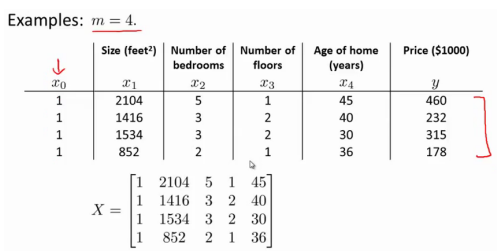

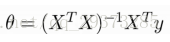

正规方程

到目前为止,我们都在使用梯度下降算法,但是对于某些线性回归问题,正规方程方法是更好的解决方案,它可以直接解出参数。如:

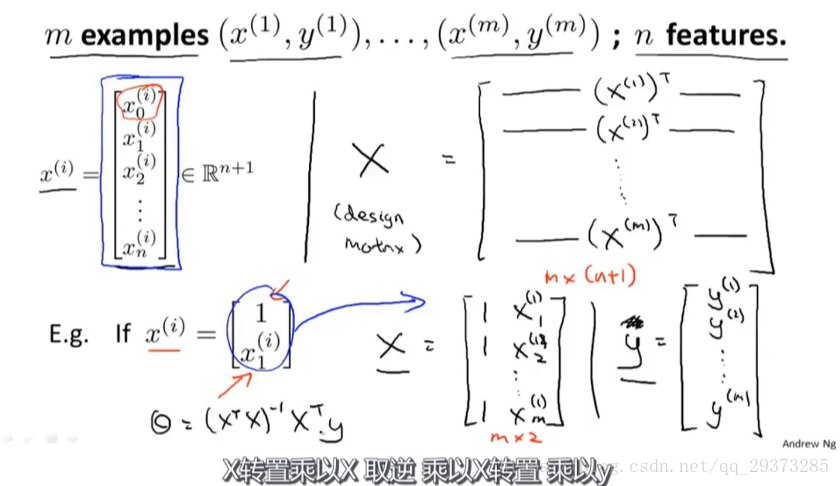

假设我们的训练集特征矩阵为X(包含了 x0=1)并且我们的训练集结果为向量 y,则利用正规方程解出向量:

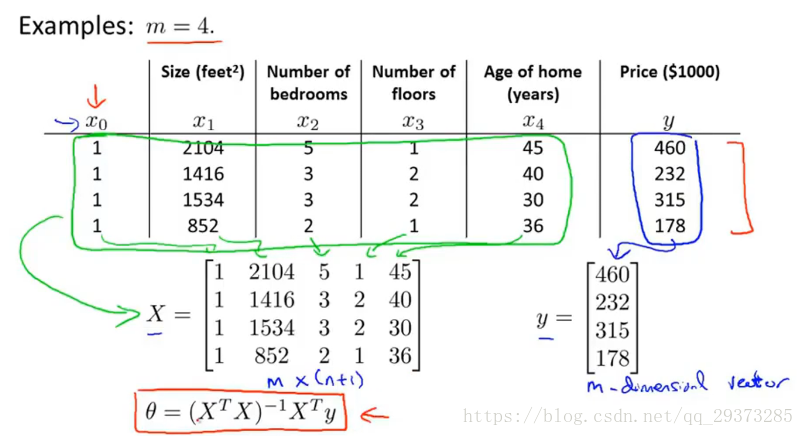

以下表示数据为例:

则根据公式:

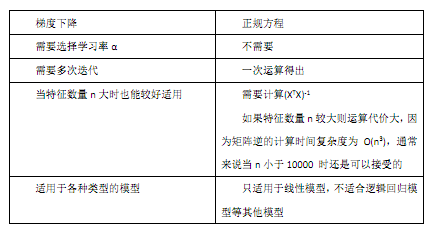

梯度下降与正规方程的比较:

梯度下降法和正规方程的比较: