接着上一篇博文《机器学习人工智能算法——支持向量机(Support Vector Machine, SVM)》的内容,我们来聊一聊如何使用SVM的思想解决回归问题。

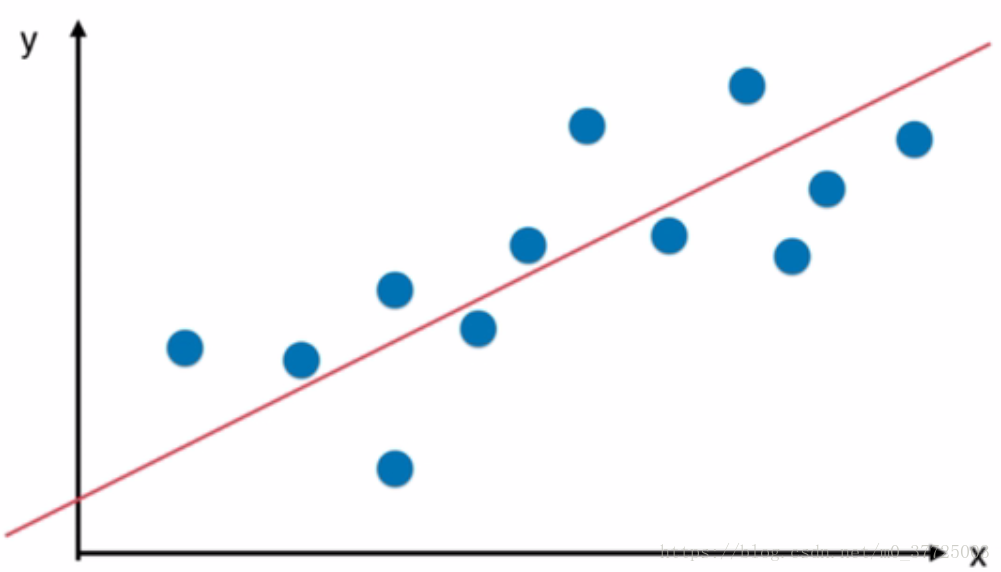

回归问题的本质其实就是找到一根直线也好曲线也好,能够最佳程度拟合我们的数据点,在这里,怎样定义拟合其实就是回归算法的关键。比如说我们之前学过的线性回归算法定义拟合的方式,就是让我们的数据点到我们预测的直线相应的MSE的值最小,而对于SVM算法的思路来说,对拟合的定义是另外一个定义。

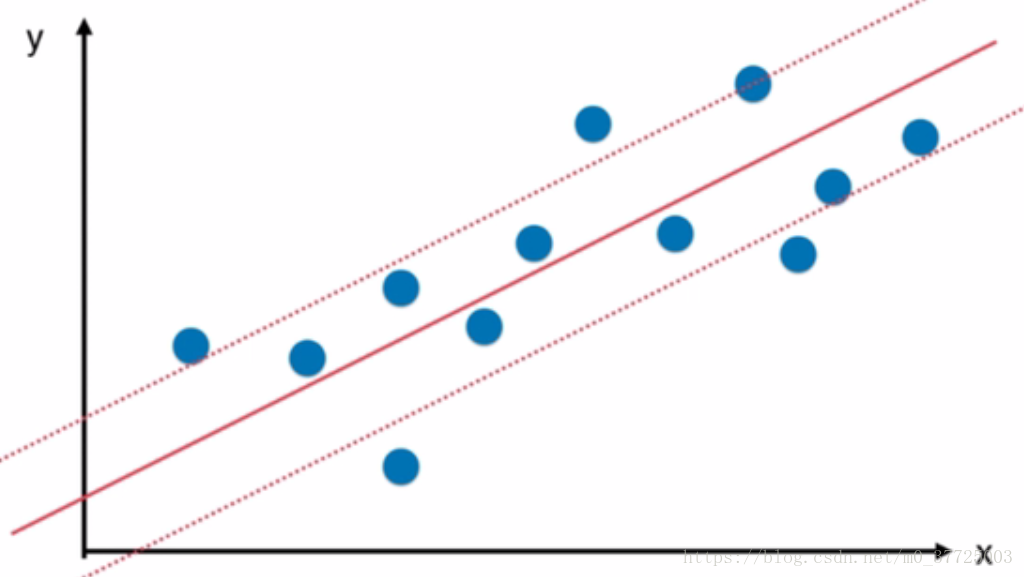

这个定义是这样的, 我们要指定一个margin值,可以回忆一下之前用SVM解决分类问题时在决策边界上下有一个margin值,那么用SVM解决回归问题时同样也是有一个margin值的,只不过这回归问题中,我们期望的是在这个margin范围里,我们可以包含进的样本数据点越多越好,如果在margin范围内的数据点越多,就代表我们的这个范围能够比较好的来表达样本数据点,在这种情况下,我们取中间的直线作为回归结果,用它来预测未知点相应的y的值。

或者说我们使用SVM解决回归问题和我们用SVM解决分离问题是一个相反的思路,我们在使用SVM解决分类问题时,希望margin范围内的值越少越好,在极端情况hard margin时,要求margin范围内一个点都不能有,但是对于解决回归问题来说,恰恰相反,我们希望的是在margin范围里,样本点越多越好。

在我们具体训练SVM回归问题结果时,我们是对margin范围进行指定,所以在这里,我们要引入一个超参数,用

来指定上下两根直线中任意一根直线到中间直线的距离。

这就是用SVM解决回归问题相应的直观的想法,希望大家已经理解了这个思路。