大神笔记 http://scruel.gitee.io/ml-andrewng-notes/week2.html

以下为便于理解添加的图或内容

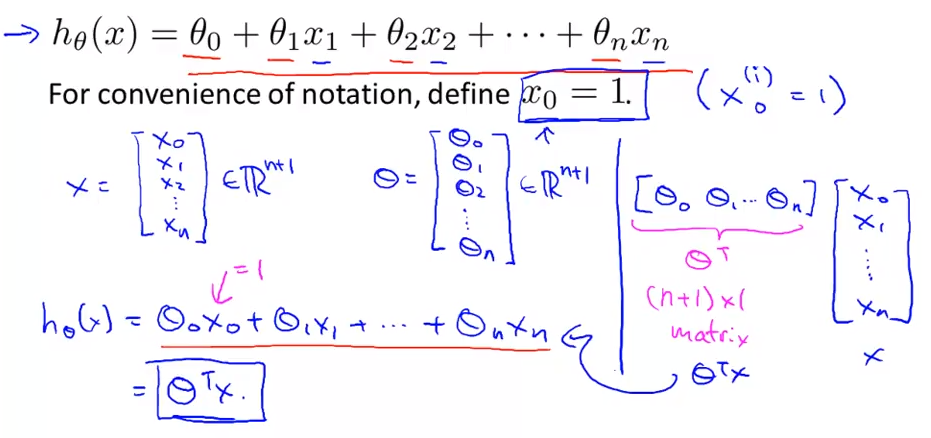

4.1多特征:

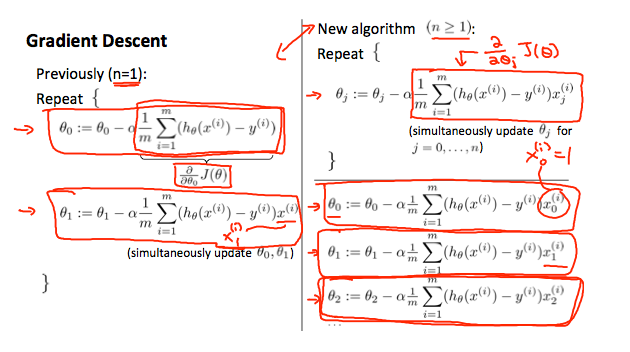

4.2多变量梯度下降

一与多:

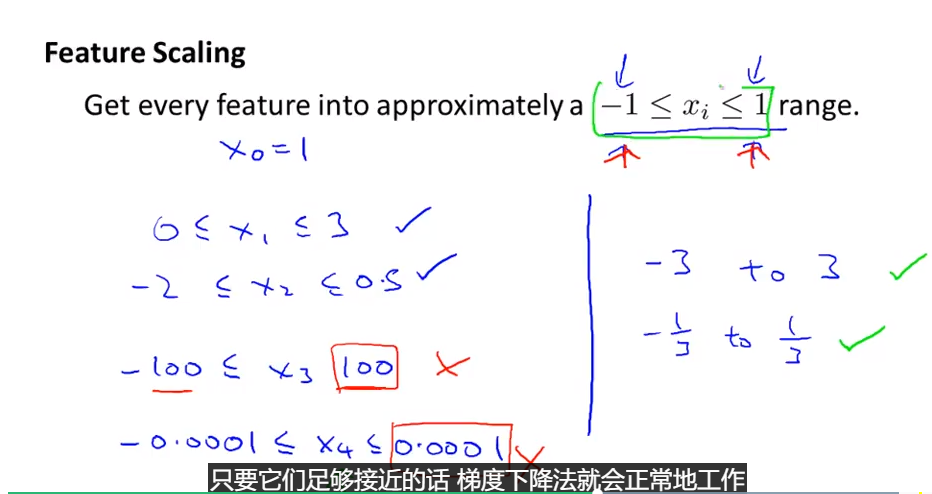

4.3梯度下降——特征值缩放

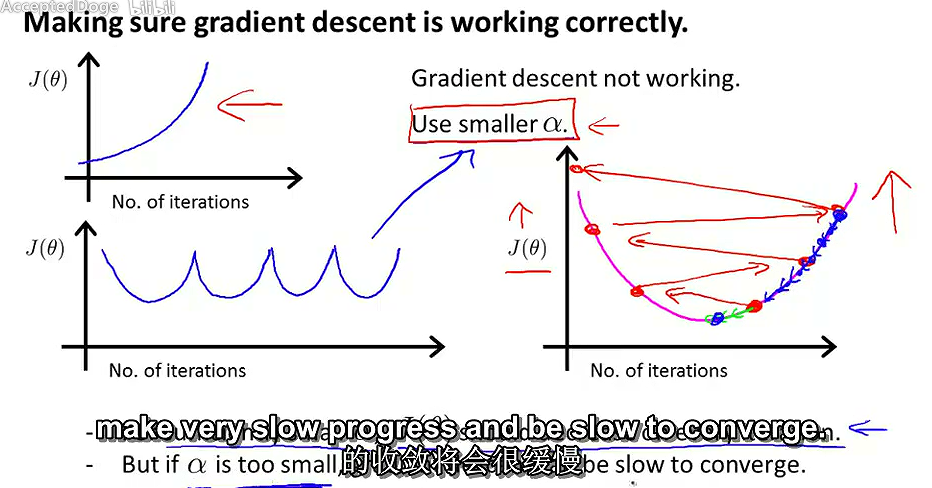

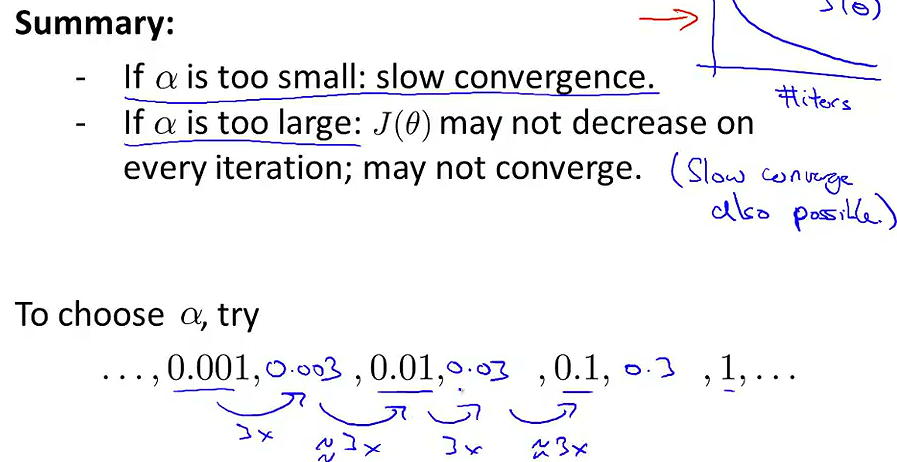

4.4梯度下降——学习效率

4.5特征和多项式回归

我们可以通过使它成为二次函数,立方函数或平方根函数(或任何其他形式)来改变我们的假设函数的行为或曲线。线性回归只能以直线来对数据进行拟合,有时候需要使用曲线来对数据进行拟合,即多项式回归(Polynomial Regression)。在使用多项式回归时,要记住非常有必要进行特征缩放,比如 的范围为 1-1000,那么 的范围则为 1- 1000000,不适用特征缩放的话,范围更有不一致,也更易影响效率。

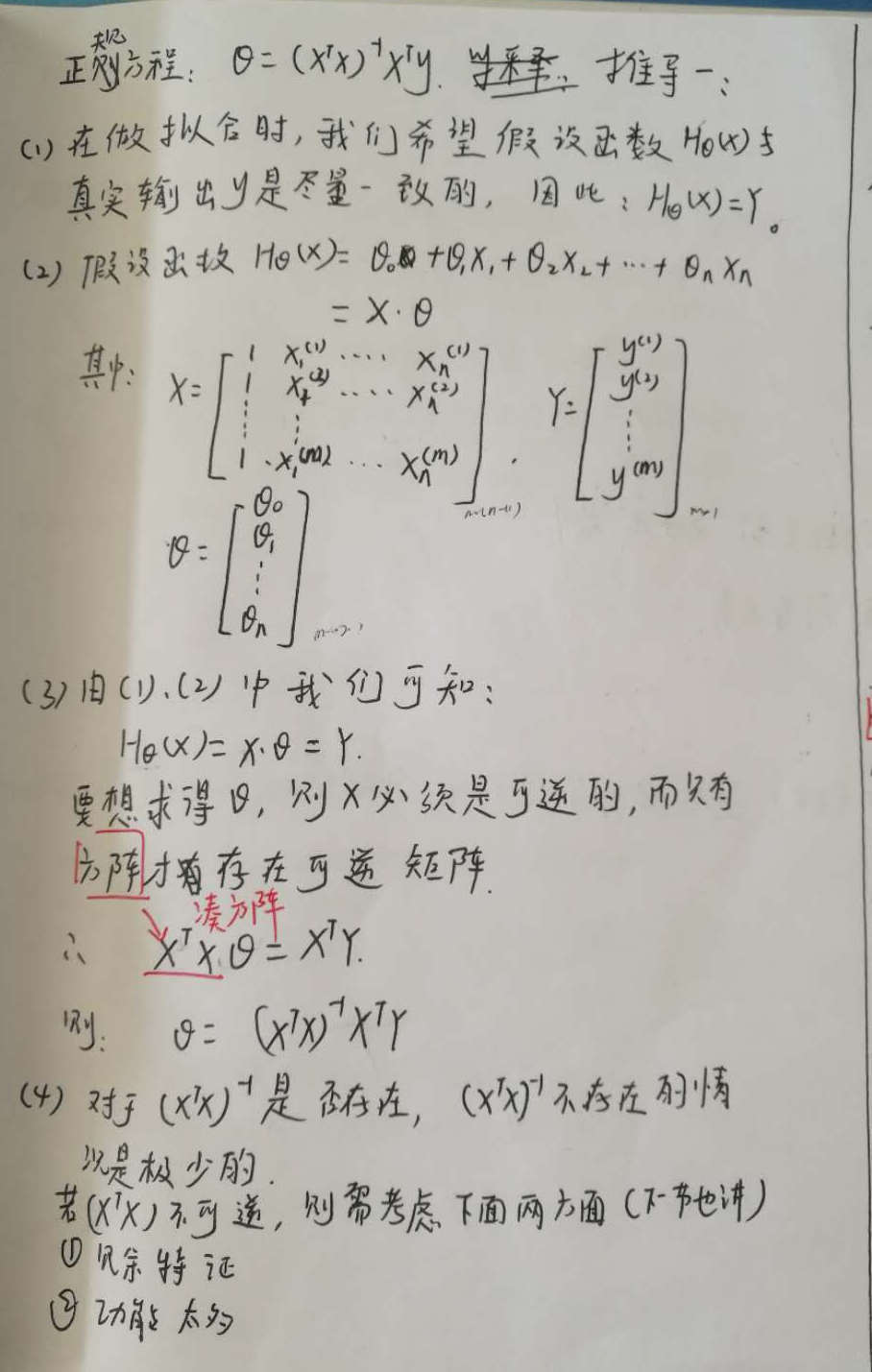

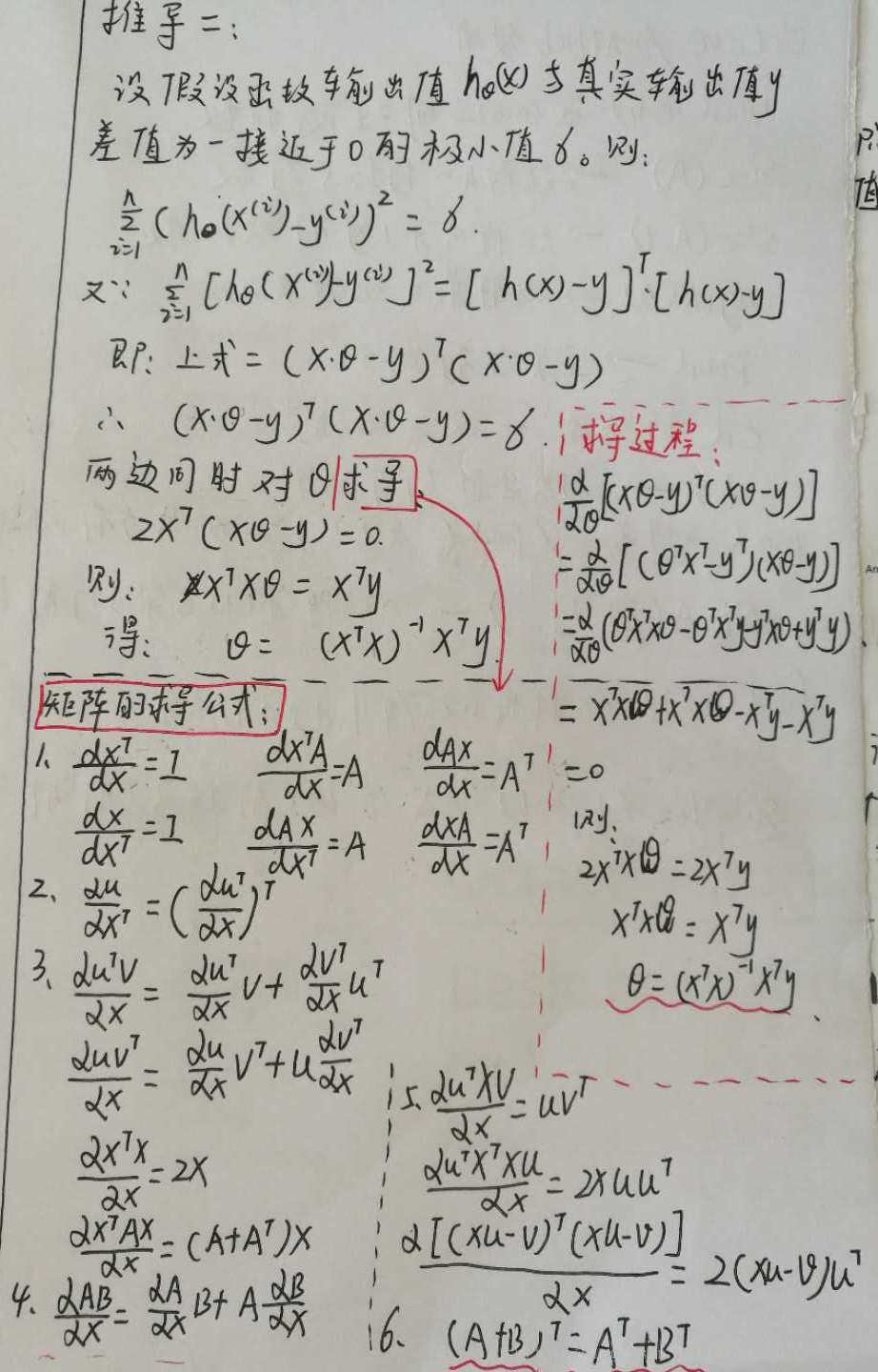

4.6正规方程(标准化方程):

矩阵的求导公式是关键,图片转载自https://blog.csdn.net/perfect_accepted/article/details/78383434

4.7不可逆性正规方程

选讲