Learning Attentions: Residual Attentional Siamese Networkfor High Performance Online Visual Tracking

2018年CVPR 王强大神的论文。

王强大神维护的benchamark-results跟踪结果:https://github.com/foolwood/benchmark_results

论文下载地址:http://www.dcs.bbk.ac.uk/~sjmaybank/CVPR18RASTrackCameraV3.3.pdf

论文代码:https://github.com/foolwood/RASNet

1. 摘要:

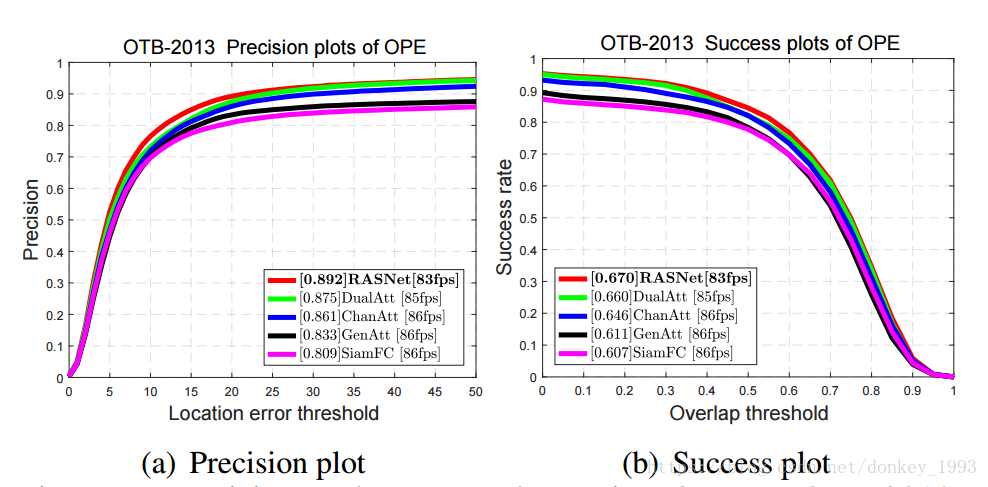

基于离线训练的目标跟踪可以很好的平衡准确率和跟踪速度,但是基于离线训练的模型来适应在线跟踪目标仍然是一个挑战。本文在孪生网络里面重构了相关滤波、加入了三种Attention机制。该算法缓解了深度学习中过拟合的问题,同时将表征学习和判别学习分开来增强算法的判别能力和适应能力。算法在OTB2015和VOT2017的跟踪里面取得了很好的结果,速度可以到达80fps。

2. 文章的三个主要的贡献:

1)端到端的训练网络。

2)加入了三种Attention机制:General Attention, Residual Attention, and ChannelAttention。

3)开发了一种非常有效、高效的基于深度学习的跟踪器。

3. 算法跟踪过程:

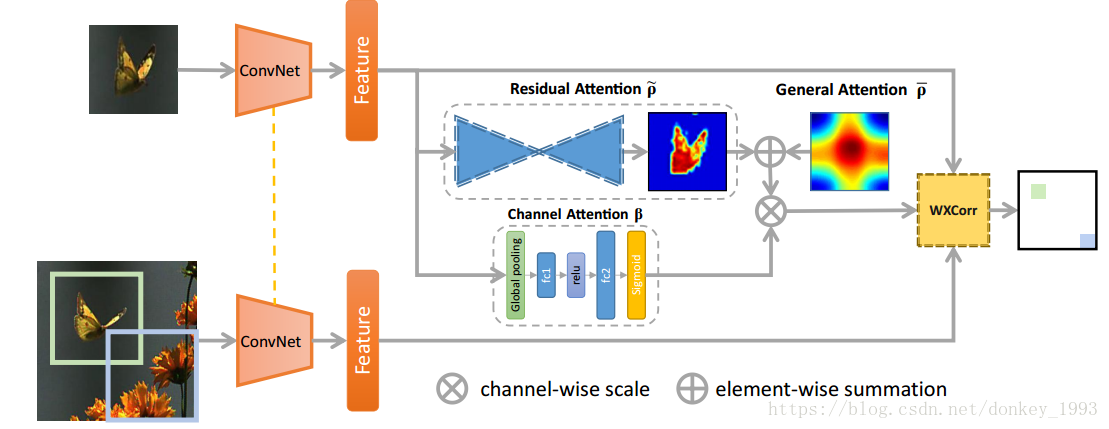

类似于Simfc算法,将标注好的第一帧传入到网络里面,先提取特征的得到的特征图分为两条路,一条是直接传到加权相关滤波,另一条是经过三个Attention机制再传到相关滤波。将基于上一帧的得到的搜索区域提取特征图之后直接传到相关滤波里面,相关滤波对传入的三种特征图做处理,得出跟踪目标在当前帧中所在的位置。由于只有第一帧经过三个Attention网络提取特征所以说速度相对于Simfc并不会慢很多。

4. Attention机制

4.1 General Attention:网络在训练的时候得到的一个包含训练样本通用信息的特征图,得到不同的跟踪目标之间的共同的特征。

4.2 Channel Attention:不同的通道得到的特征图不一样,通过这个机制来选取对跟踪效果比较好的通道,剔除噪声通道。

4.3 Residual Attention:通过沙漏网络得到跟踪目标之间的差异的特征图。

将4.3和4.1的特征图相加就可以得到不同视频中跟踪目标共同的特征和区别。

5.加权相关滤波:

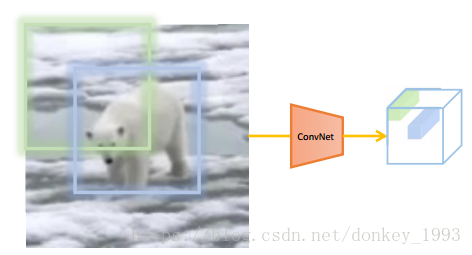

作者认为蓝色的框比绿色的框更能表示所跟踪的目标。所以用加权相关滤波来表示这种特征,找到一个响应值最大的跟踪框(找到图中蓝色的跟踪框)。

6. 跟踪结果:(没什么好说的,就是效果好速度快。)

论文总结:通过channel attention 选取对目标有用的通道,剔除噪声通道。Residual attention和General attention用来找到不同视频跟踪目标之间的共同的特征和区别。加权相关滤波就是用来找到最后最好的跟踪框。

论文看的还不是很明白,有什么错误还请大家指正。