论文:High Performance Visual Tracking with Siamese Region Proposal Network

文论下载:http://openaccess.thecvf.com/content_cvpr_2018/papers/Li_High_Performance_Visual_CVPR_2018_paper.pdf

DaSiamRPN代码地址:https://github.com/foolwood/DaSiamRPN

DaSiamRPN配置方法:UBUNTU16.04下面配置的。https://blog.csdn.net/donkey_1993/article/details/82794101

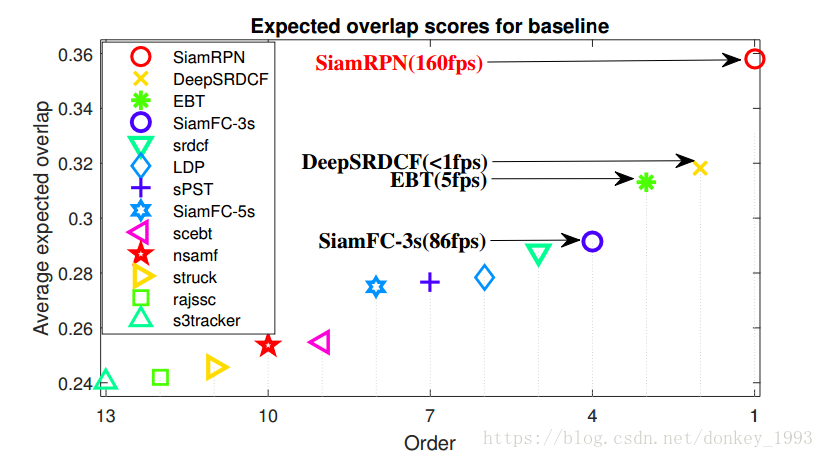

2018年CVPR,在VOT,Benchmark上面都去了很好的成绩,跟踪速度提升很快,泰坦下面可以跑200FPS。

2018年ECCV的Distractor-aware Siamese Networks for Visual Object Tracking也是在这篇论文的基础上改进的,跟踪效果提升了一些。

论文摘要:

网络结构是孪生网络,把Faster-Rcnn里面的RPN引入到跟踪里面,同时在跟踪阶段使用了 一次检测(后面会解释) 的方法。跟踪速度可以达到160FPS,在VOT2015,2016,2017上面都取得了很高的准确率。

论文结构:

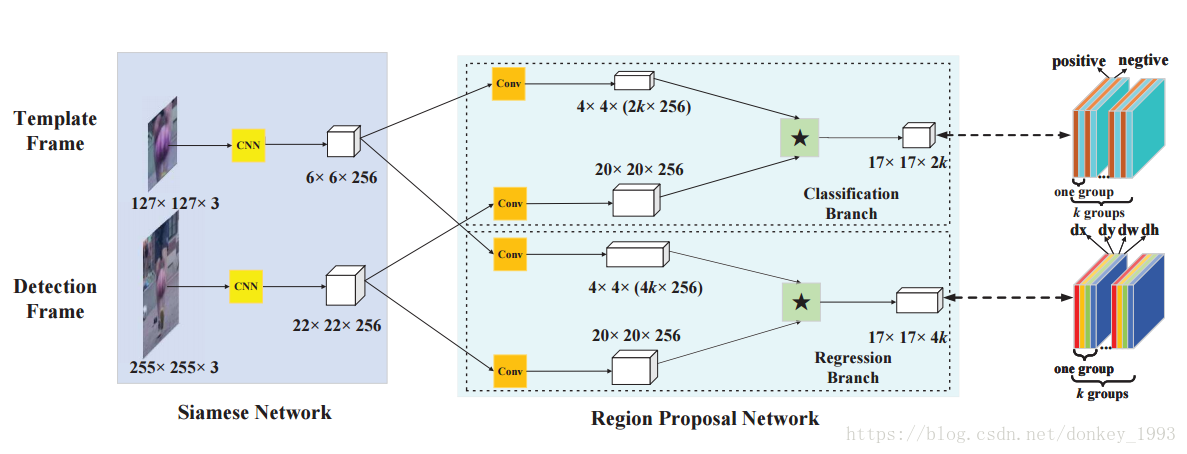

图一:算法的网络结构

这篇论文主要是由三部分组成:(后面会围绕这三部分来讲一下)

1.孪生网络提取特征。

2.Region Proposal Network(RPN)网络结构。

3.One-shot learning,一次学习。

孪生网络提取特征:

孪生网络在目标跟踪领域应用广泛,由Siam-FC,Goturn等算法。他可以兼顾速度和准确率。论文中的孪生网络主要是用来提取特征。

RPN网络结构:

RPN主要是同来选择候选区域的。想Faster-Rcnn上一样,但是本算法的RPN的尺度分别为[0.33,0.5,1,2,3]五种尺度。

One-shot learning:

one-shot learning以及zero shot learning都属于迁移学习领域,主要研究的是网络少样本精准分类问题,单样本学习能力。

算法的跟踪流程:

1.将第一帧图片和当前帧传到孪生网络里面来提取特征。

2.将第一帧和当前帧的特征图传到RPN网络里面,RPN网络主要分为两部分,一部分是分类网络,一部分是回归网络。这两部分都分别将第一帧和当前帧的特征图传到网络里面来。分类网络,假设有k个anchor,我们分类只需要分前景和背景所以有2k个值。回归网络里面则有4k个值。

3.在分类网络里面,用第一帧的特征图作为卷积核来卷积但前帧的特征图。在回归网络里面,用第一帧的特征图作为卷积核来卷积但前帧的特征图。

4.RPN网络里面的分类网络会输出前景和背景的分类结果,回归网络会把标注框回归输出来。

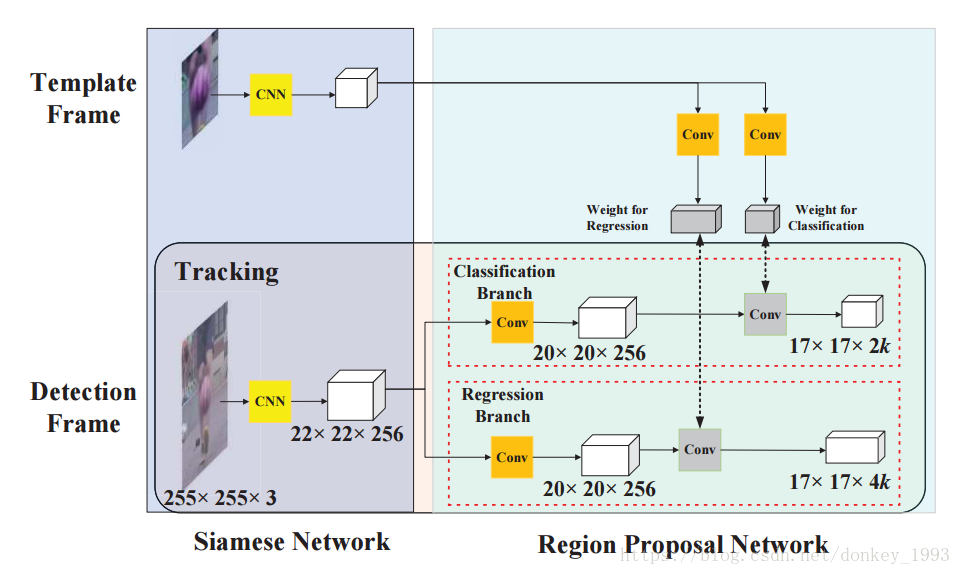

下面讲一下算法在跟踪过程中的 one-shot detection:

就如下图所示的一样Teamplate Frame只有在第一帧的时候会运行一次,然后后续的跟踪第一帧就不需要再进行提取特征

的操作。只需要运行灰色框中的网络就可以了。这个就是one-shot detection(个人理解)。

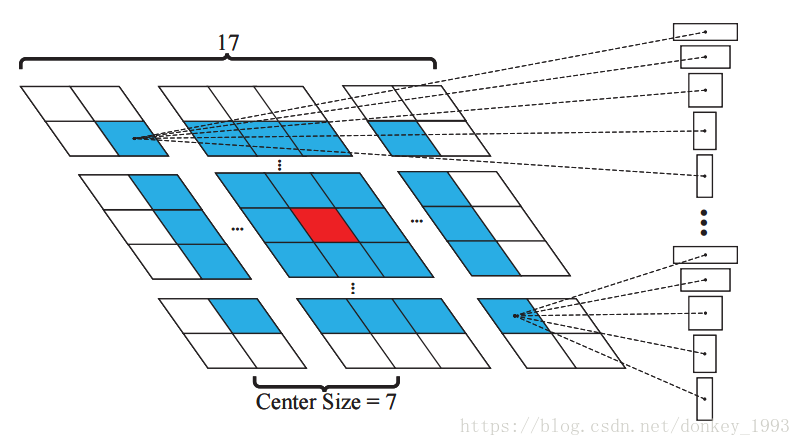

候选区域的选择方式:

1.第一种方法,只搜索离中心区域最远为7的区域的anchor框。如下图所示以中心红框为中心距离为7的正方形区域。

2. 第二种方案选择策略是利用余弦窗口和尺度变化惩罚对候选区域的得分进行重新排序,得到最优的方案。

跟踪结果:

这个就不需要多说了,跟踪效果最好,速度快。

以上就是我看的这篇论文的主要内容。