理解出错之处望不吝指正。

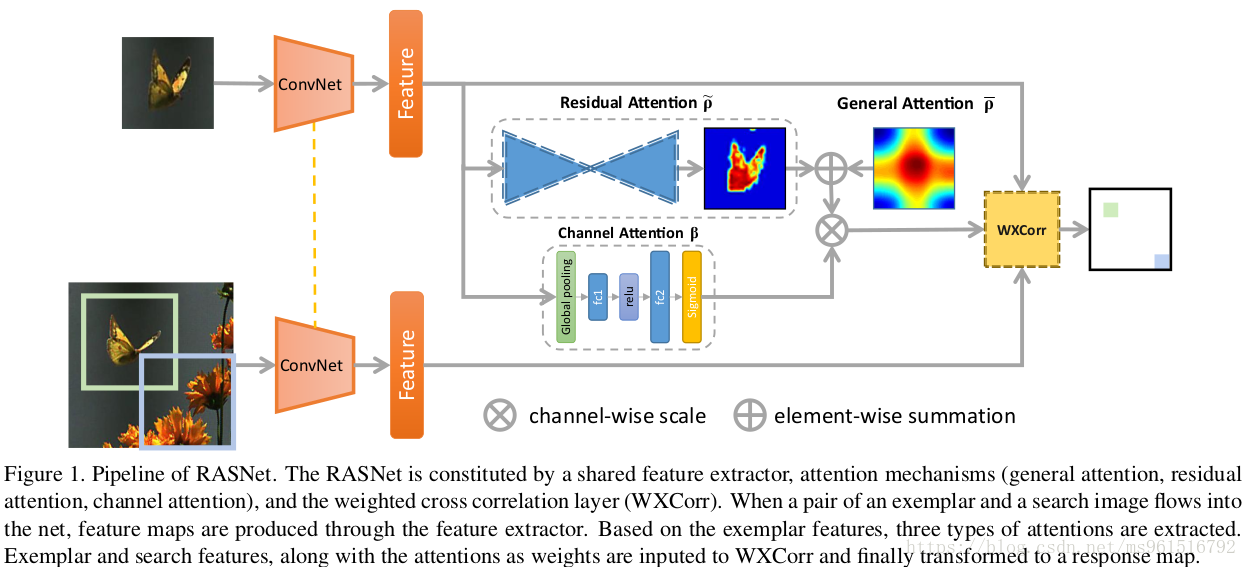

本文模型叫做RASNet,在Siamese框架下重构了CF,提出了三种attention机制(general、residual、channel),这三种attention的提出使得离线训练的特征表示可以适应在线跟踪的目标,同时避免过拟合。

传统的Siamese使用f(z, x)函数对跟踪目标z和search image x进行评价:

作者认为,不同位置的权重应该不同:

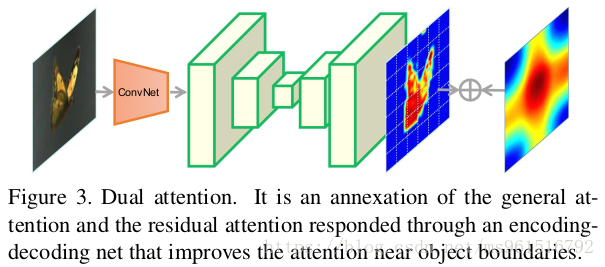

这里的r(那个字母打不出来)即为attention,称为“full attention”,我们又将其分为两部分:dual attention P和channel attention B。其中,P又分为两部分:general attention和residual attention(下式中的两部分):

general attention负责编码所有训练样本的共性。

residual attention负责学习每种不同的跟踪物体之间的差异性。

channel attention负责使模型适应于不同的contexts。