目录

二、指数加权平均(Exponentially weighted averages)

四、RMSprop算法(root mean square prop)

五、Adam优化算法(adaptive moment estimation)(Momentum+RMSprop)

一、Mini-batch梯度下降法

最好选择不大不小的mini-batch,这样的效率的是最好的!

一般多尝试几个值,找到最合适的那一个!

二、指数加权平均(Exponentially weighted averages)

滤波器?时间序列里的指数平滑

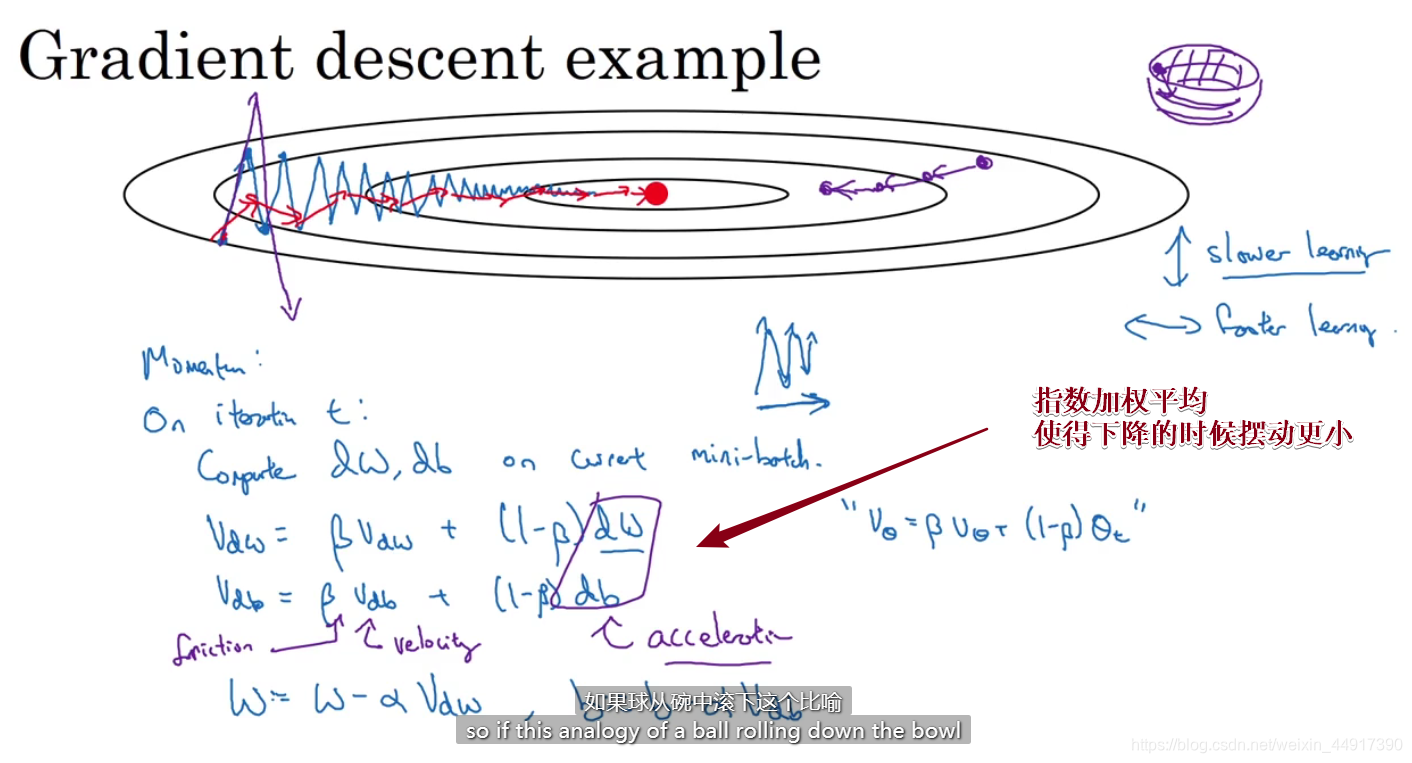

三、Momentum(动量)梯度下降法

四、RMSprop算法(root mean square prop)

适用于不同深度学习的结构

这样即便使用一个比较大的α(学习率)也不会出现太大的摆动!

五、Adam优化算法(adaptive moment estimation)(Momentum+RMSprop)

适用于不同深度学习的结构

六、学习率衰减

七、局部最优问题

作业