文章目录

- P1 【第一周深度学习概论】1.1 欢迎

- P2 1.2 什么是神经网络

- P3 1.3 用神经网络进行监督学习

- P4 1.4 为什么深度学习会兴起

- P5 1.5 关于这门课

- P7 【第二周 神经网络基础】2.1 二分网络分类

- P8 2.2 logistic回归

- P9 2.3 logistic损失回归函数

- P10 2.4 梯度下降法

- P11 2.5 导数

- P12 2.6 更多导数的例子

- P13 2.7 计算图

- P14 2.8 计算图的导数计算

- P15 2.9 logistic回归中的梯度下降法

- P16 2.10 m个样本的梯度下降

- P17 2.11 向量化

- P18 2.12 向量化的更多例子

- P19 2.13 向量化logistic回归

- P20 2.14 向量化logistic回归的梯度输出

- P21 2.15 Python中的广播

- P22 2.16 关于python_numpy向量的说明

- P23 2.17 Jupyter 笔记本的快速指南

- P24 2.18 (选修)logistic损失函数的解释

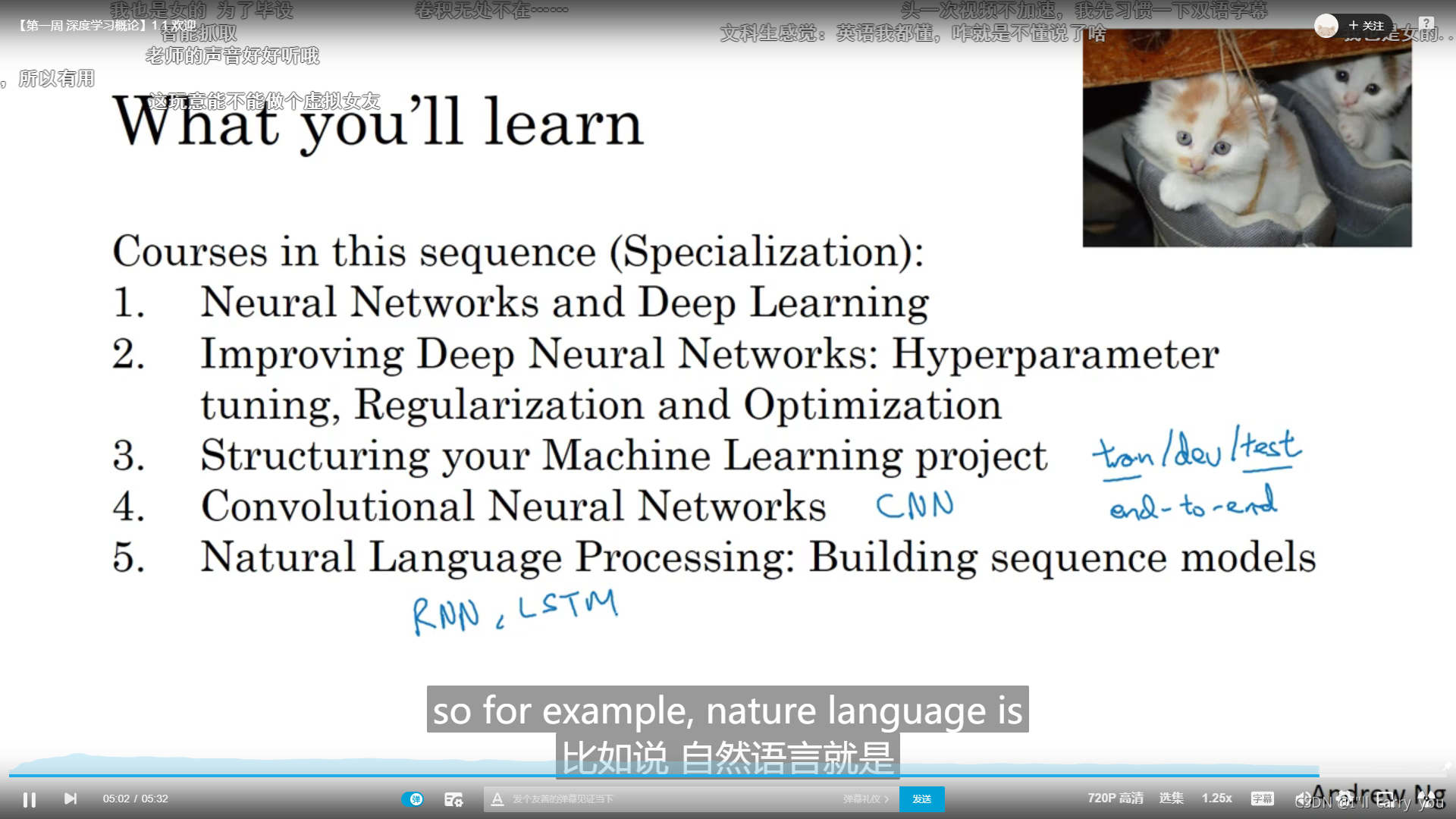

P1 【第一周深度学习概论】1.1 欢迎

学习大纲

P2 1.2 什么是神经网络

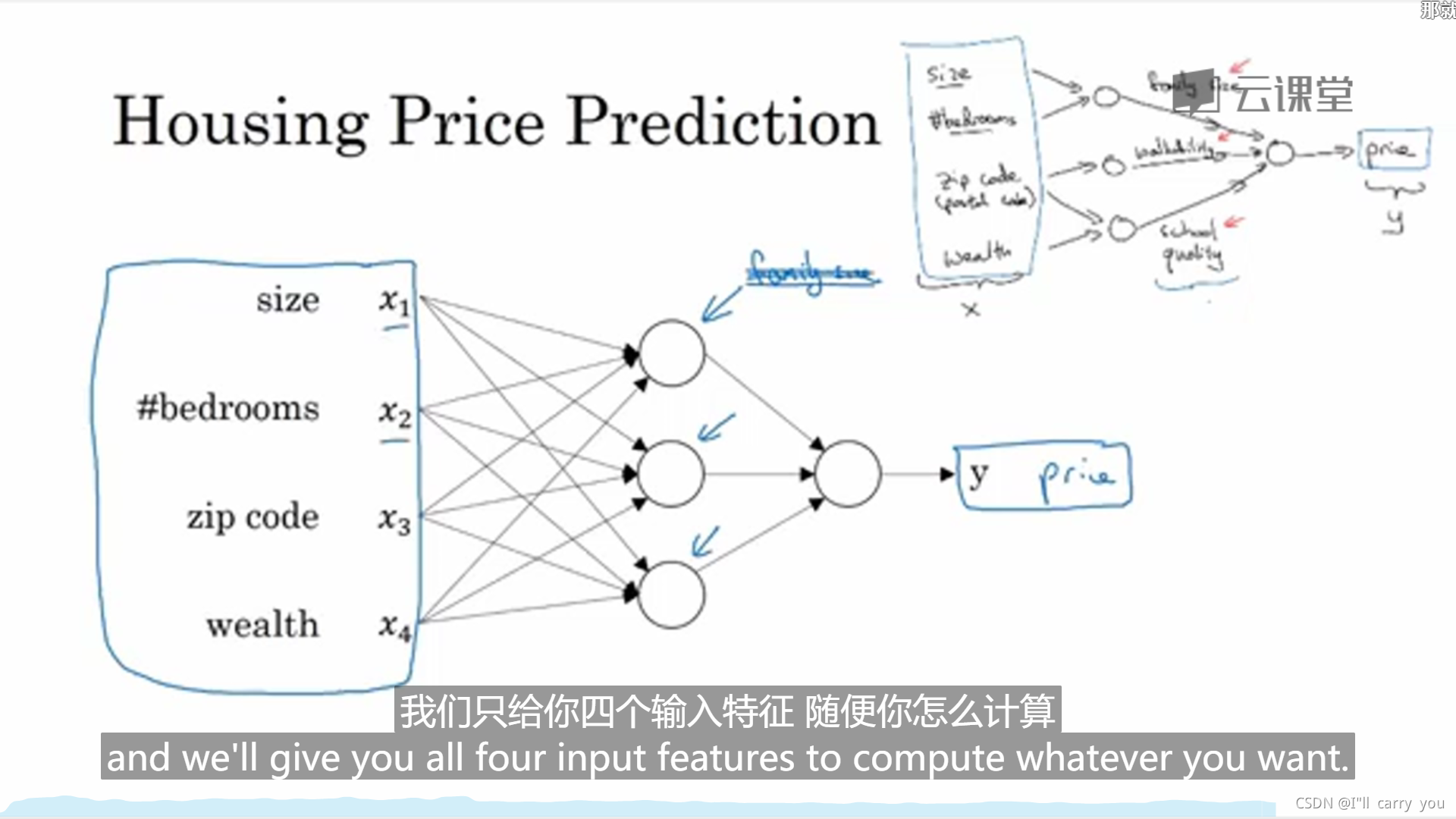

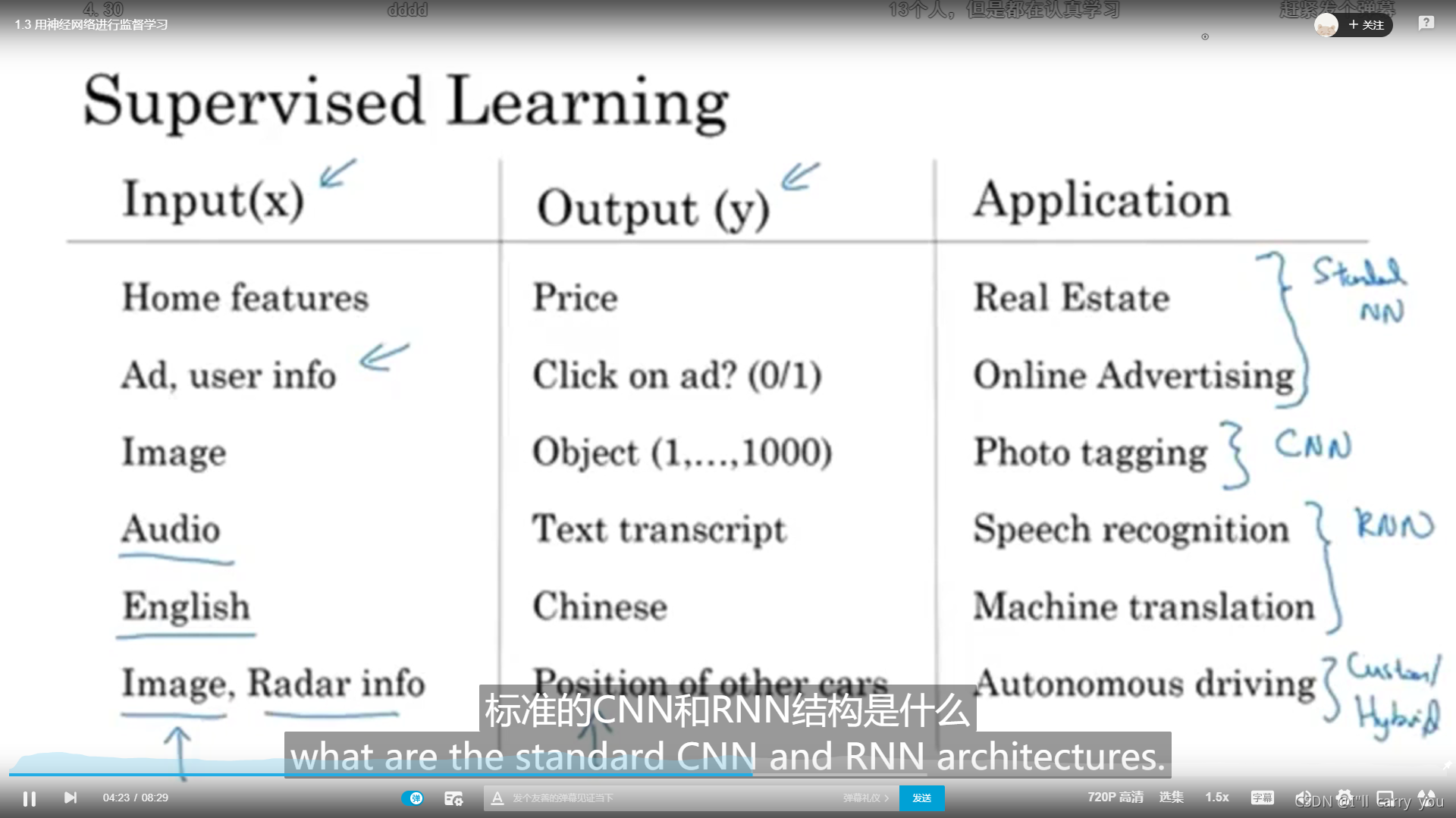

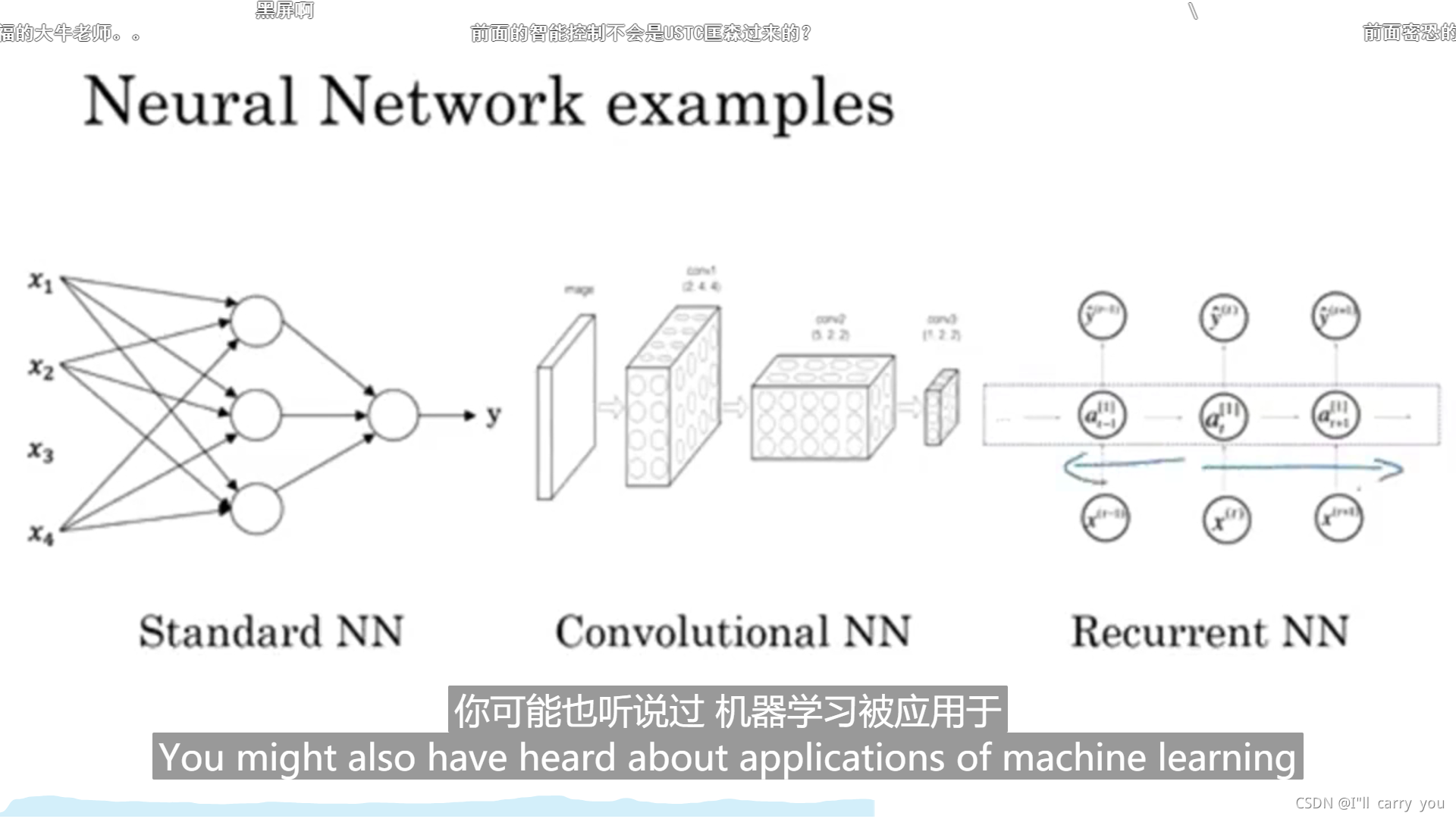

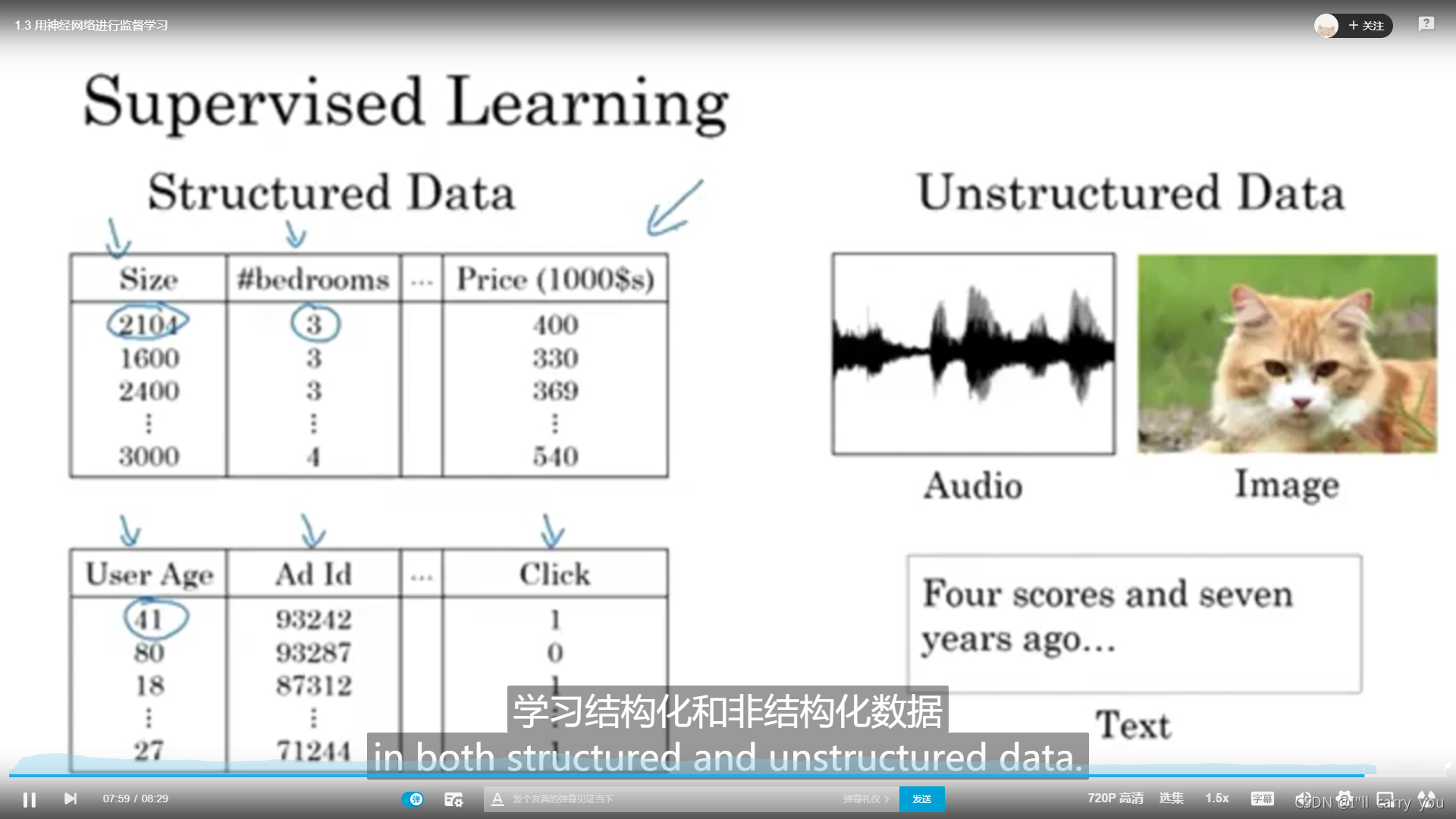

P3 1.3 用神经网络进行监督学习

监督学习的例子

神经网络例子

结构化数据和非结构化数据

P4 1.4 为什么深度学习会兴起

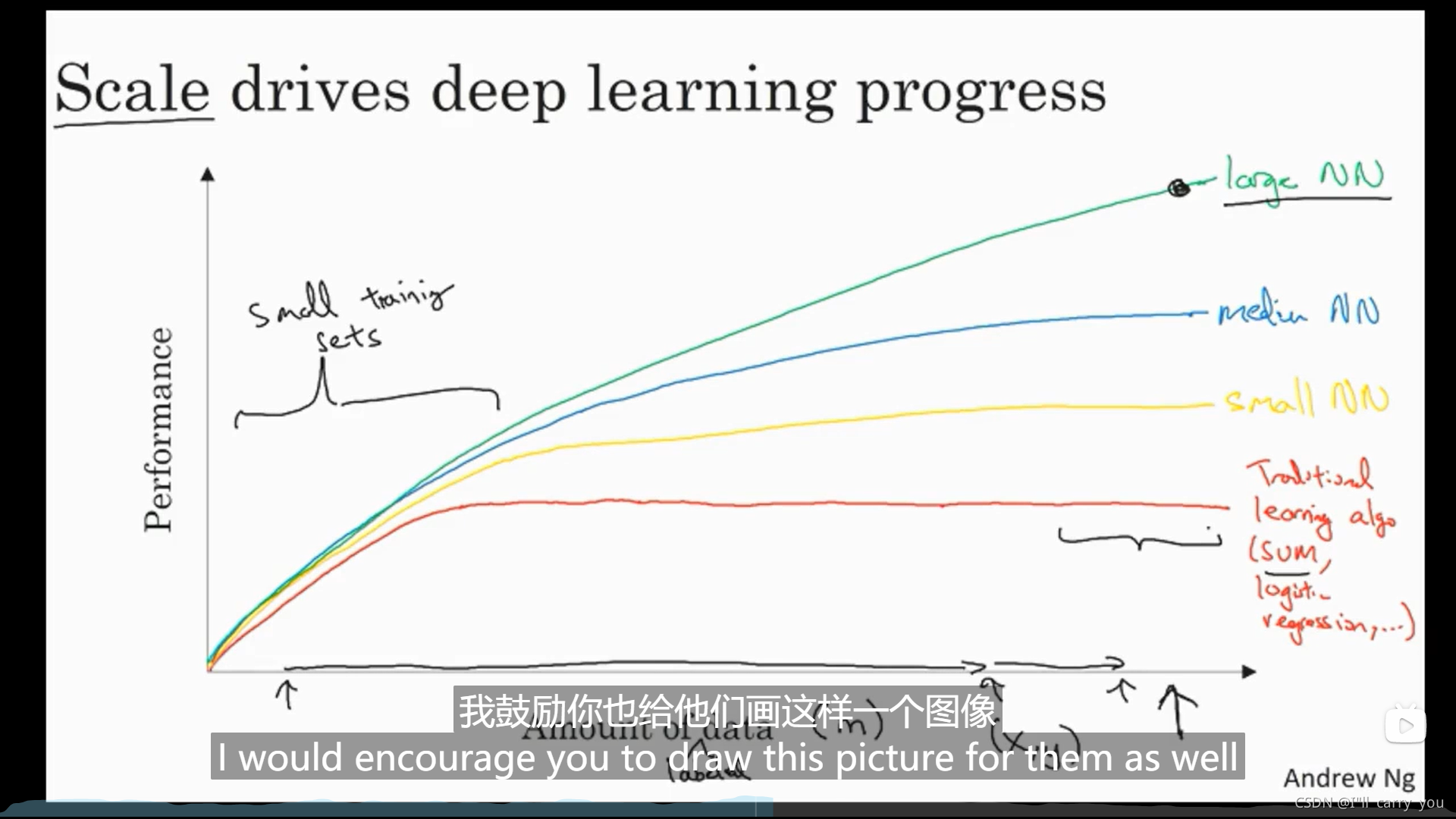

数据越多,深度学习比传统算法性能越好

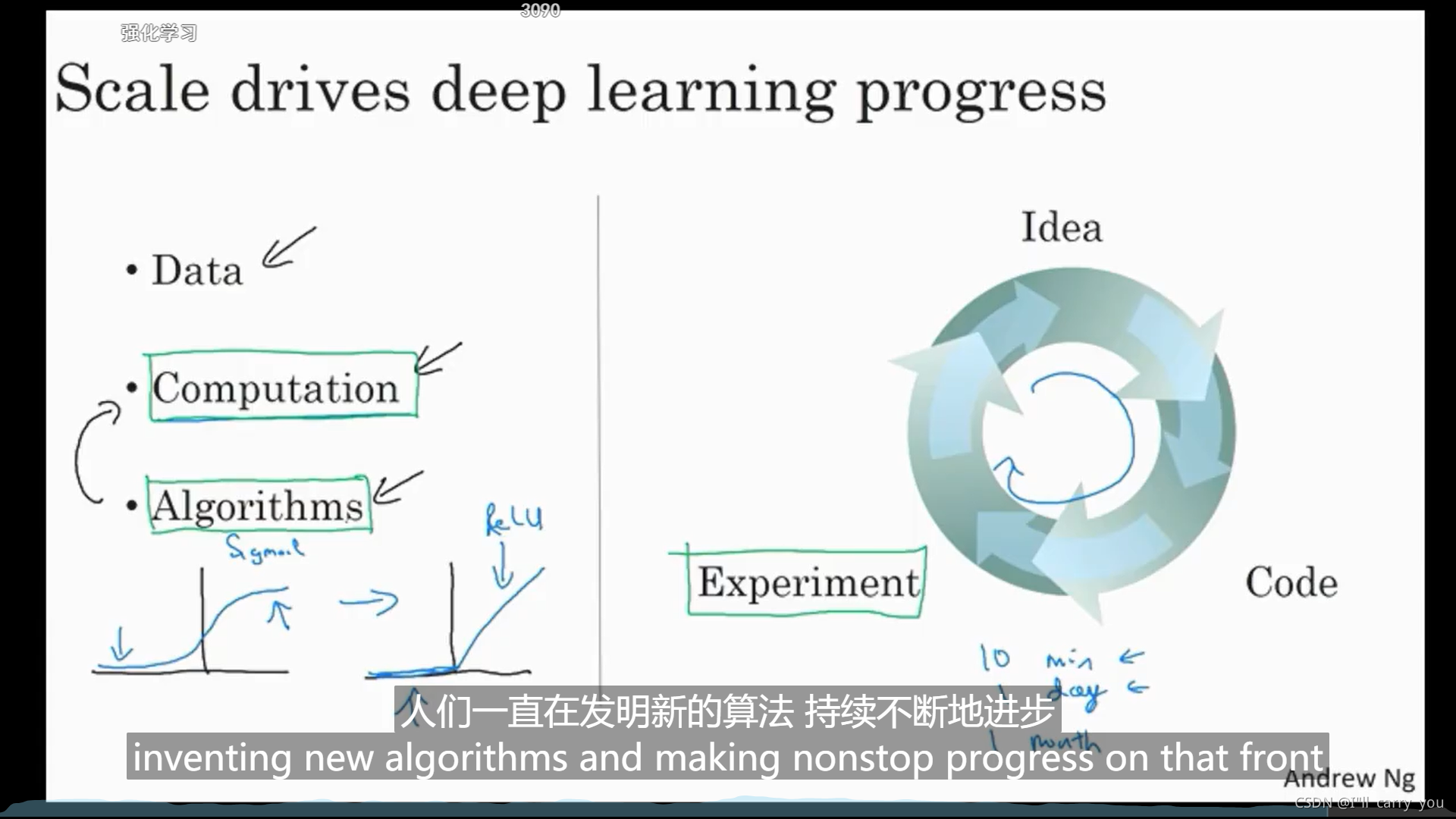

算法创新提高了计算速度,加快了迭代速度

P5 1.5 关于这门课

P7 【第二周 神经网络基础】2.1 二分网络分类

符号表示

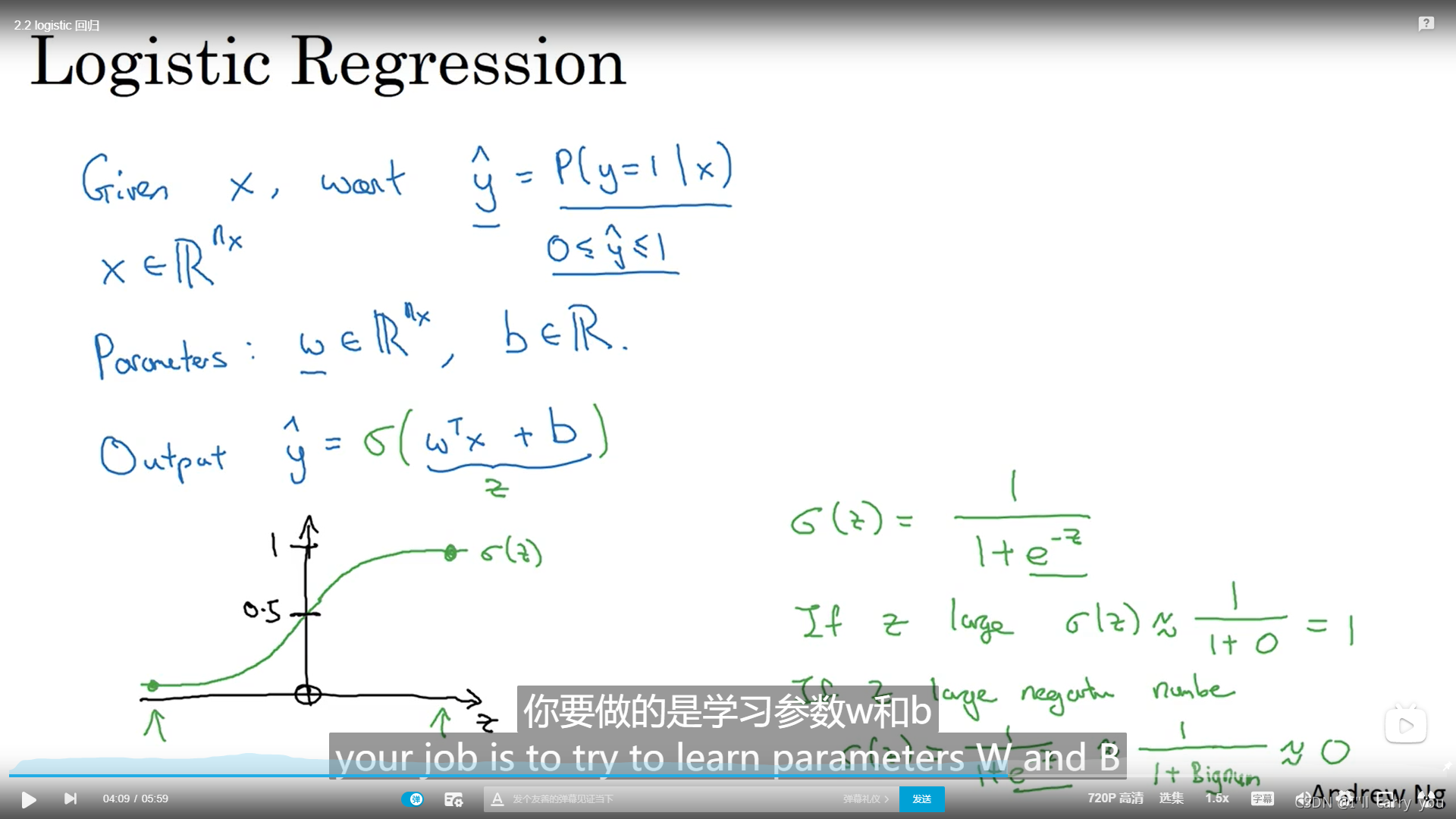

P8 2.2 logistic回归

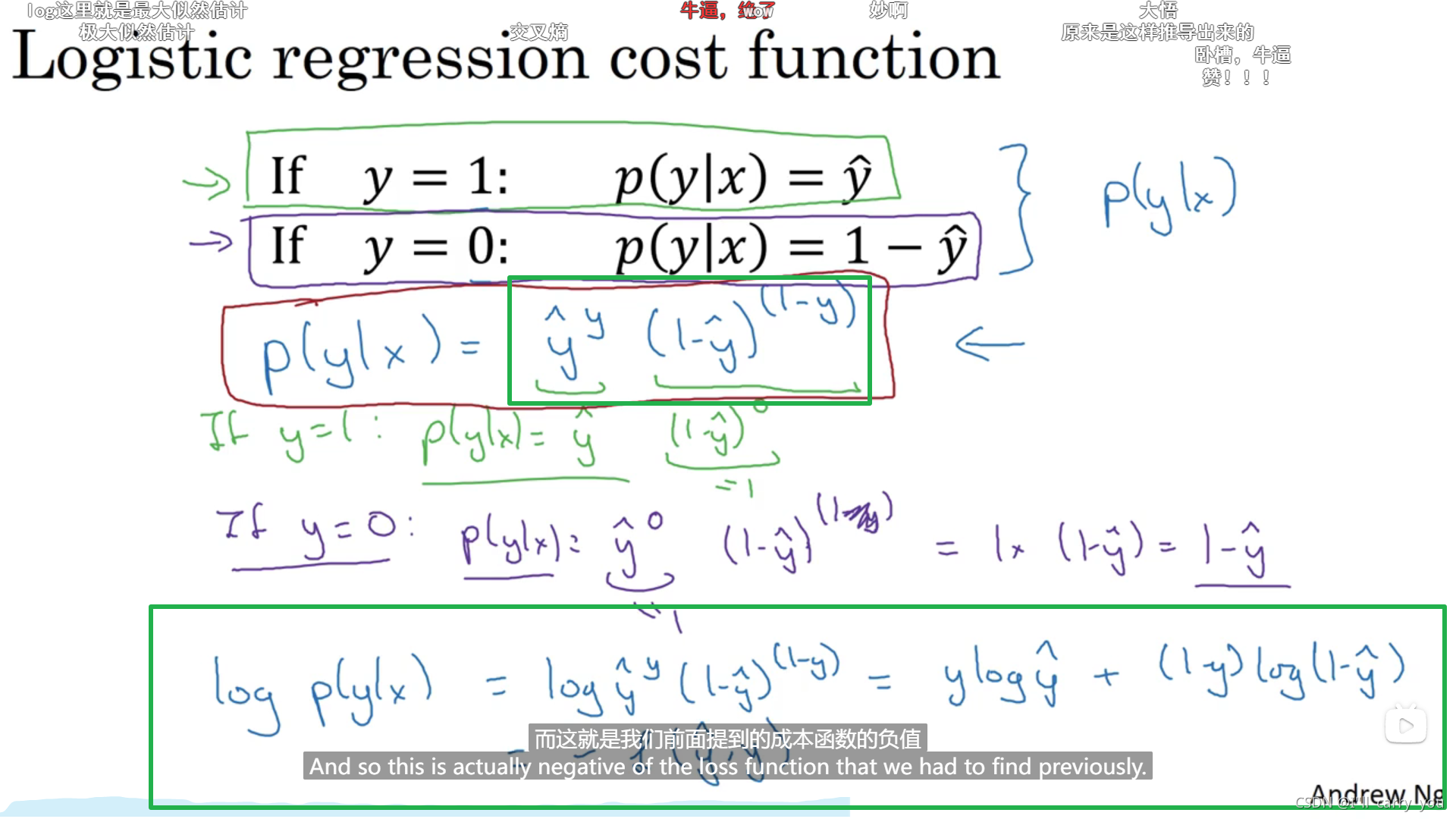

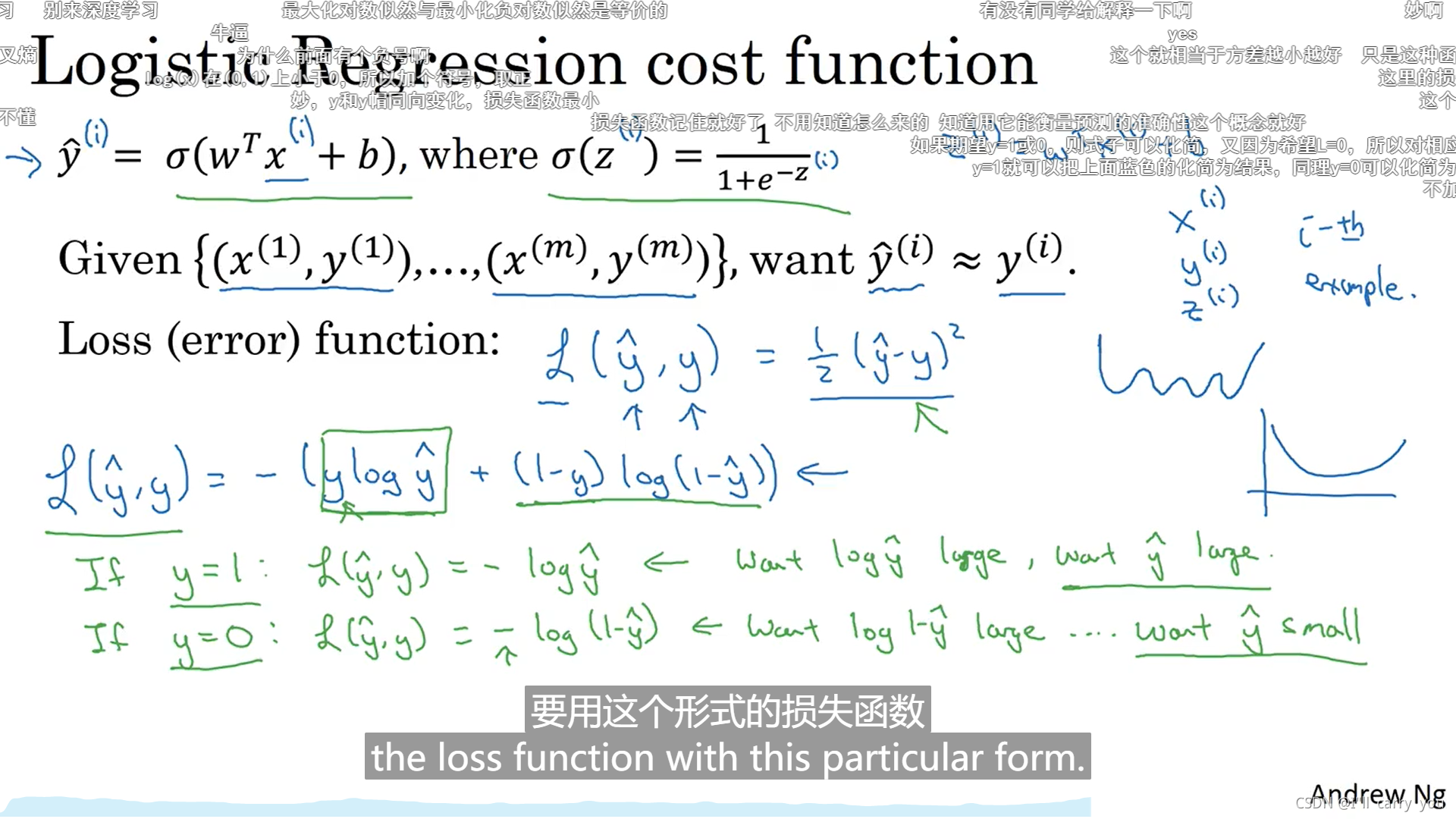

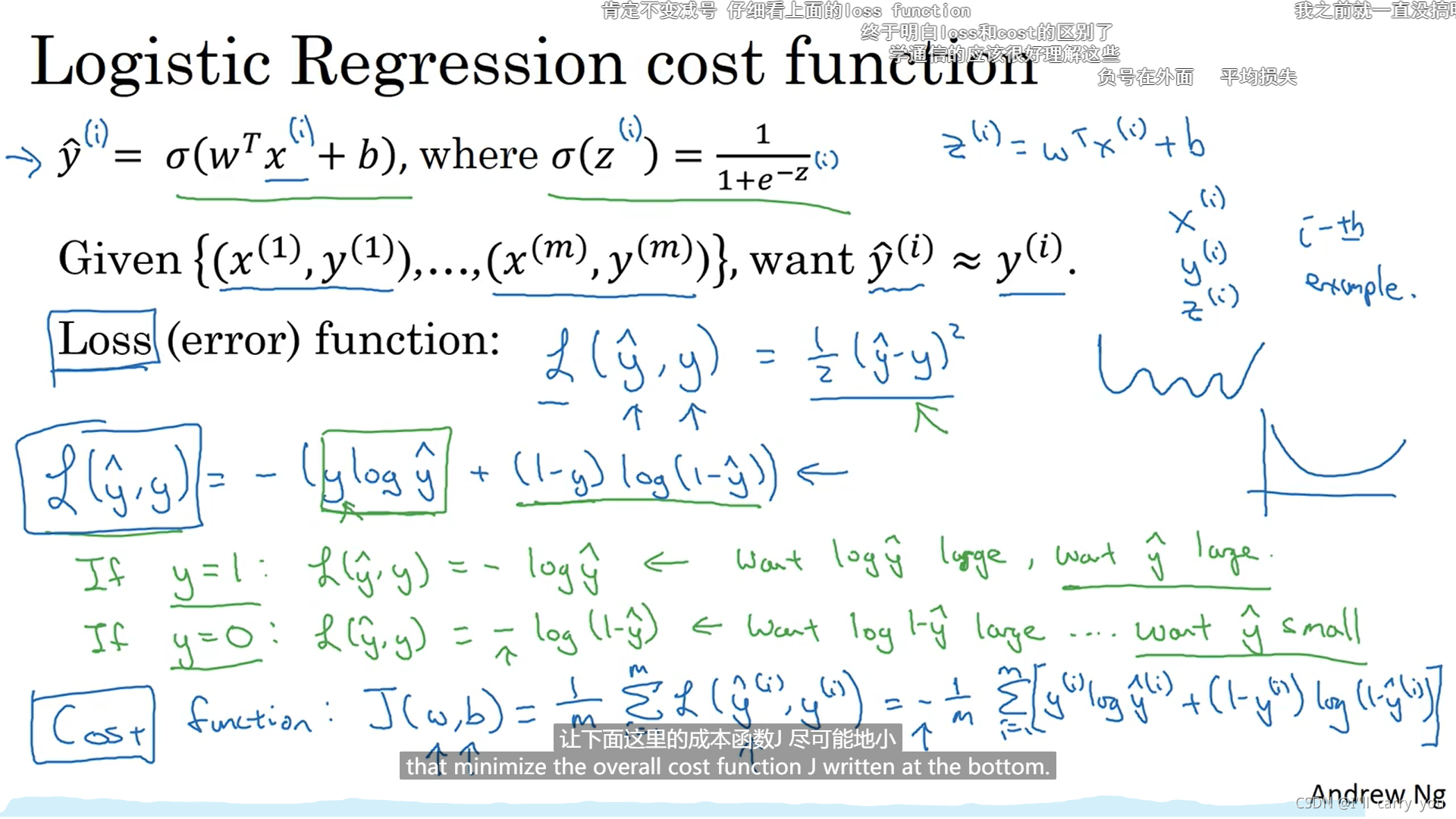

P9 2.3 logistic损失回归函数

l是单个样本的损失函数,cost是全部样本的损失函数

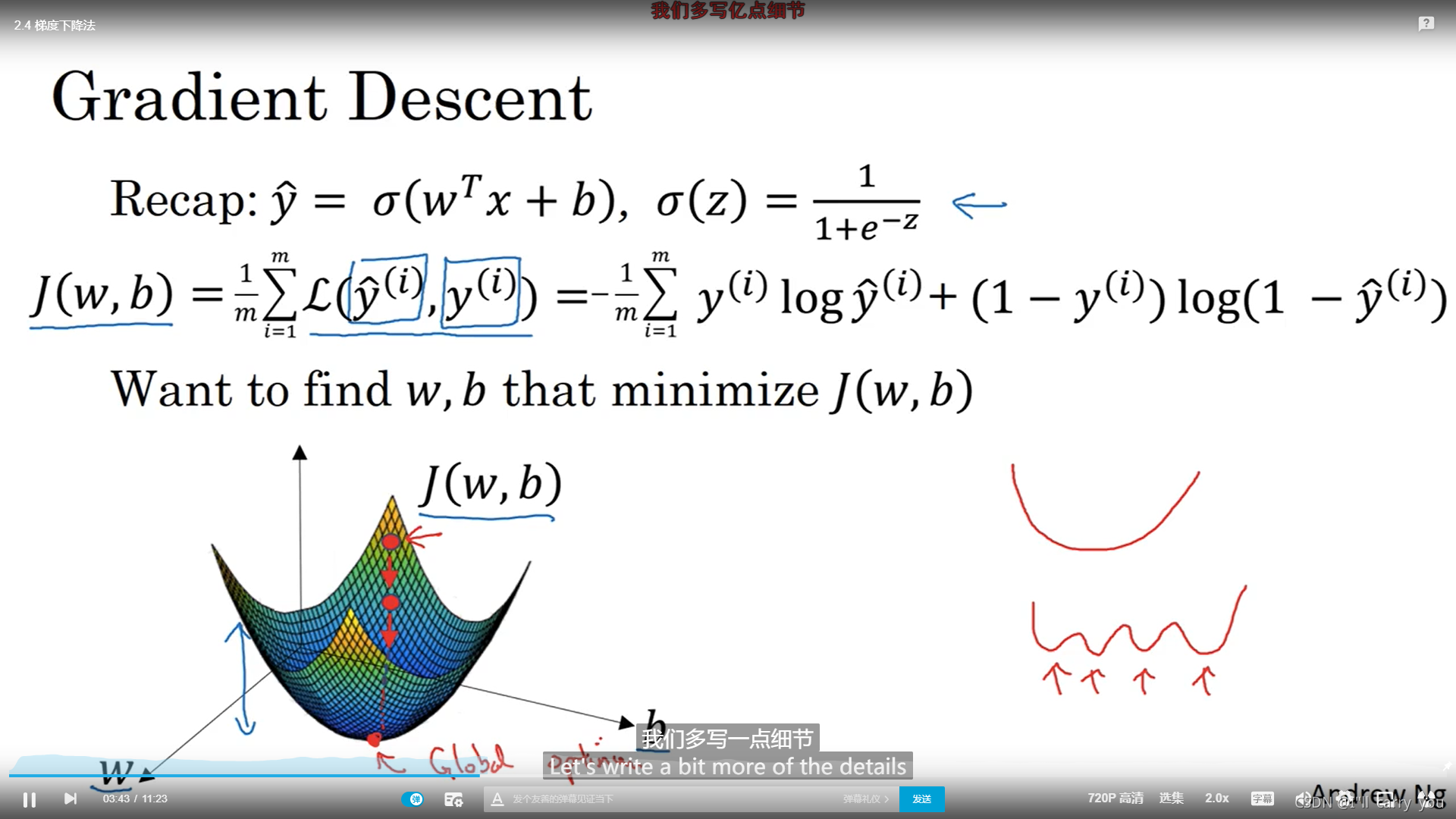

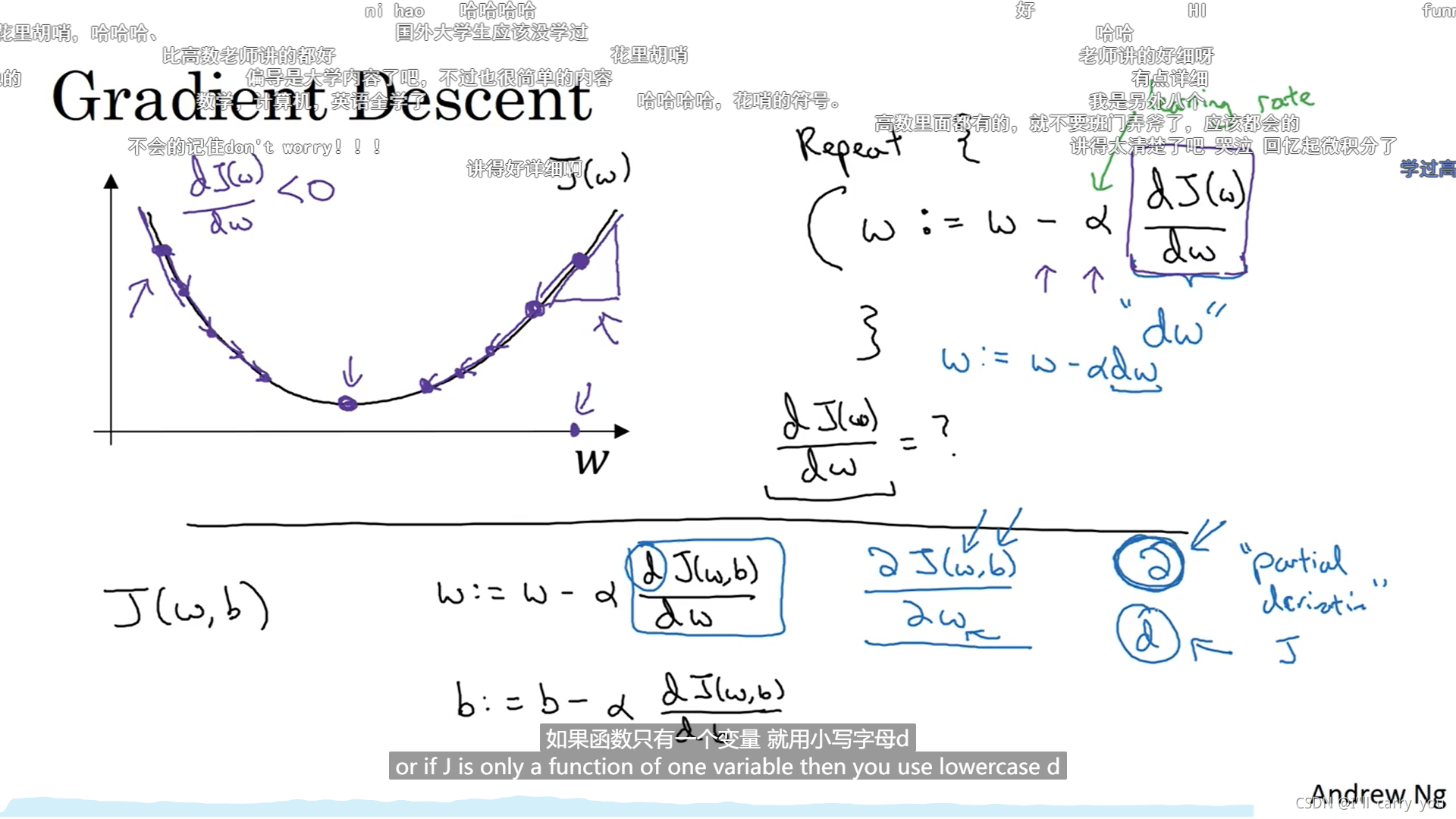

P10 2.4 梯度下降法

P11 2.5 导数

P12 2.6 更多导数的例子

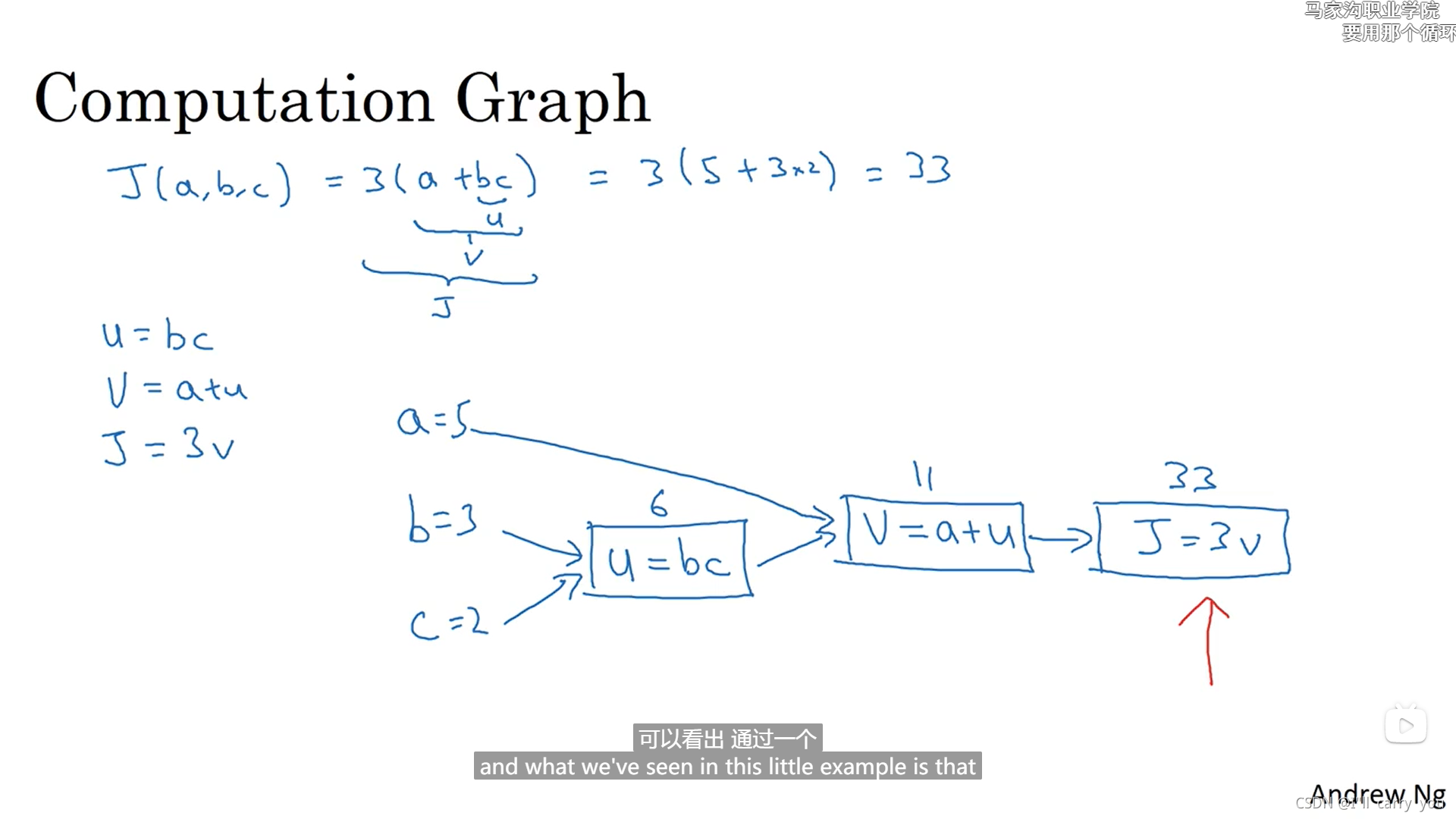

P13 2.7 计算图

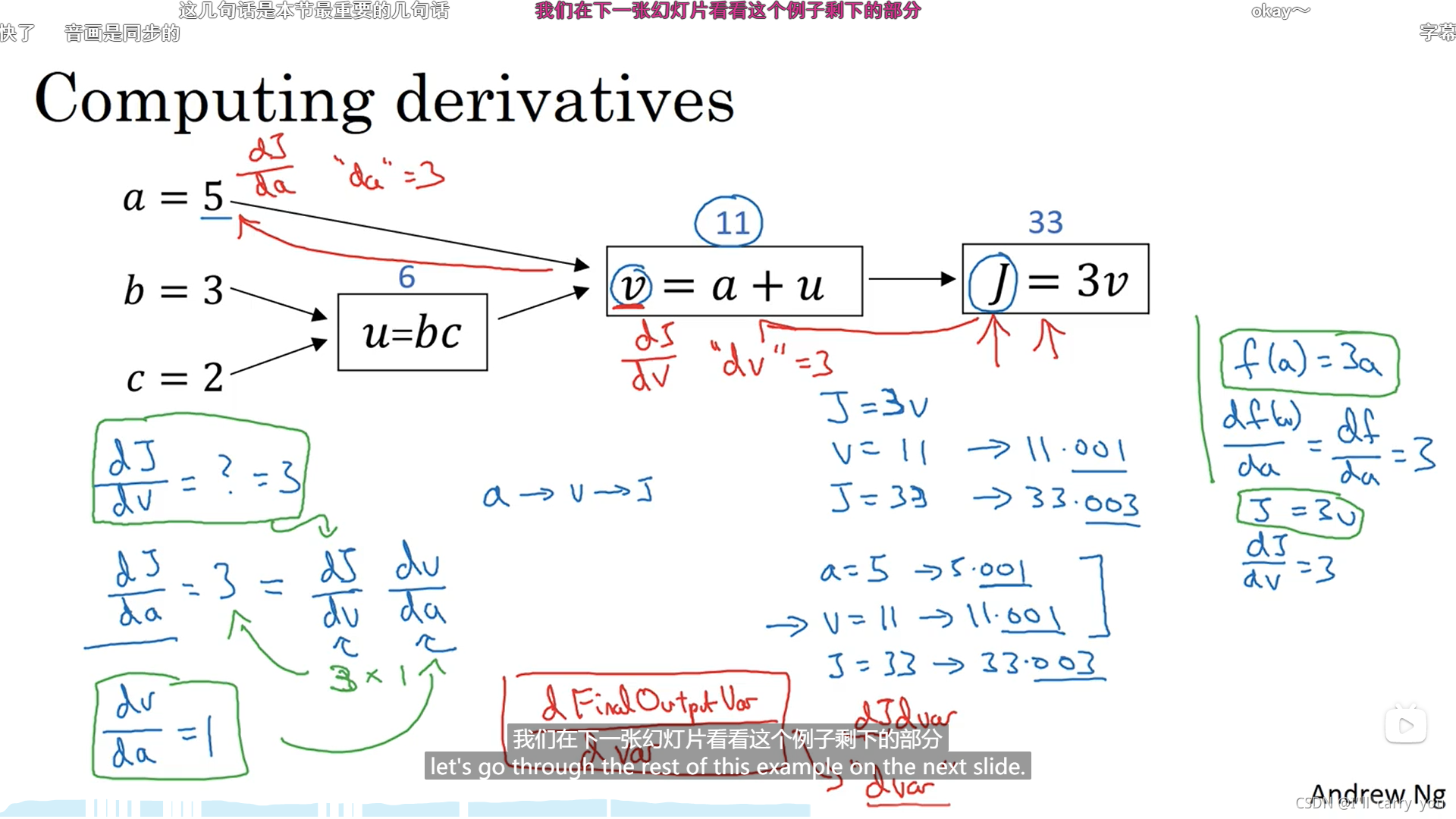

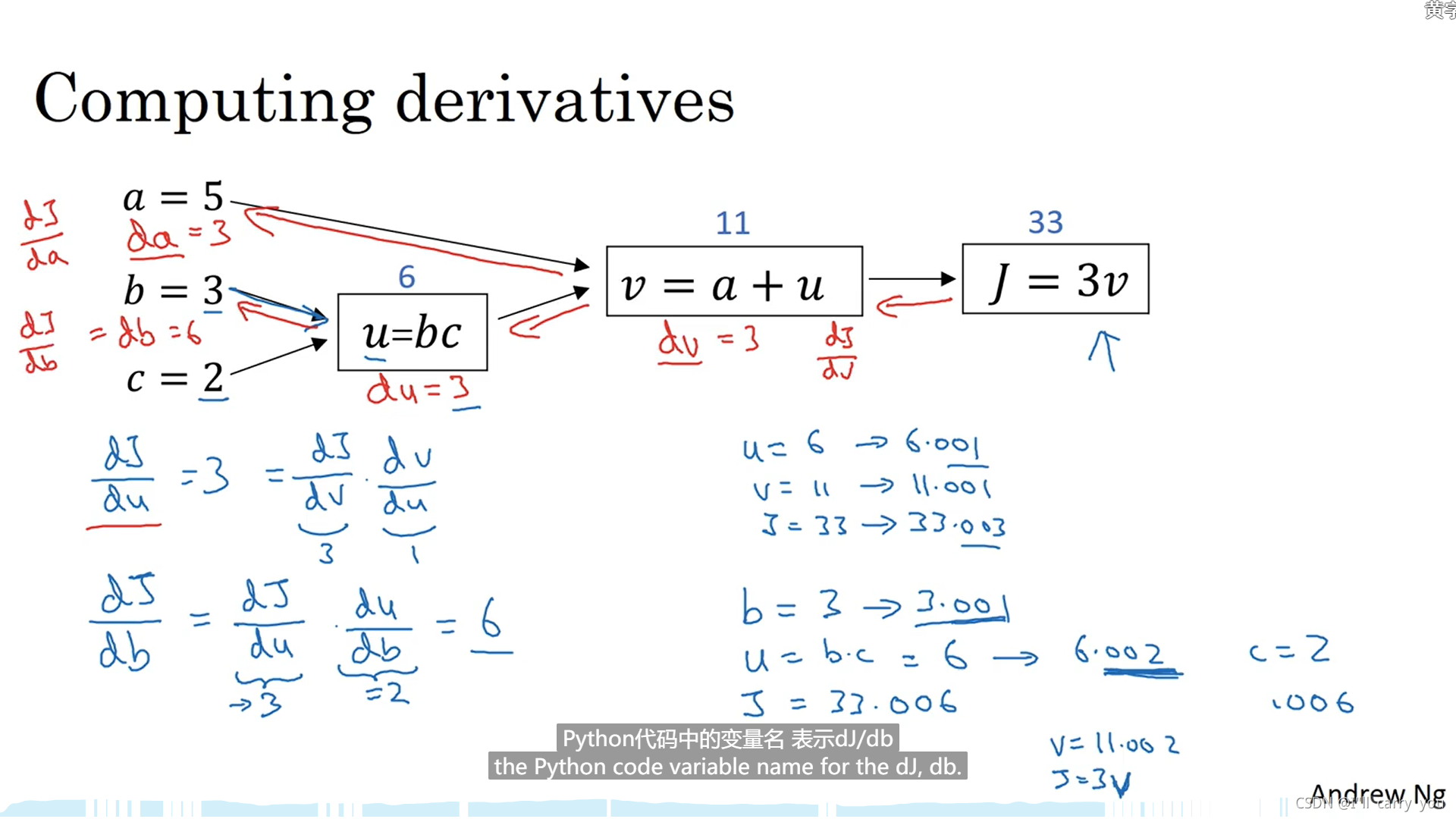

P14 2.8 计算图的导数计算

P15 2.9 logistic回归中的梯度下降法

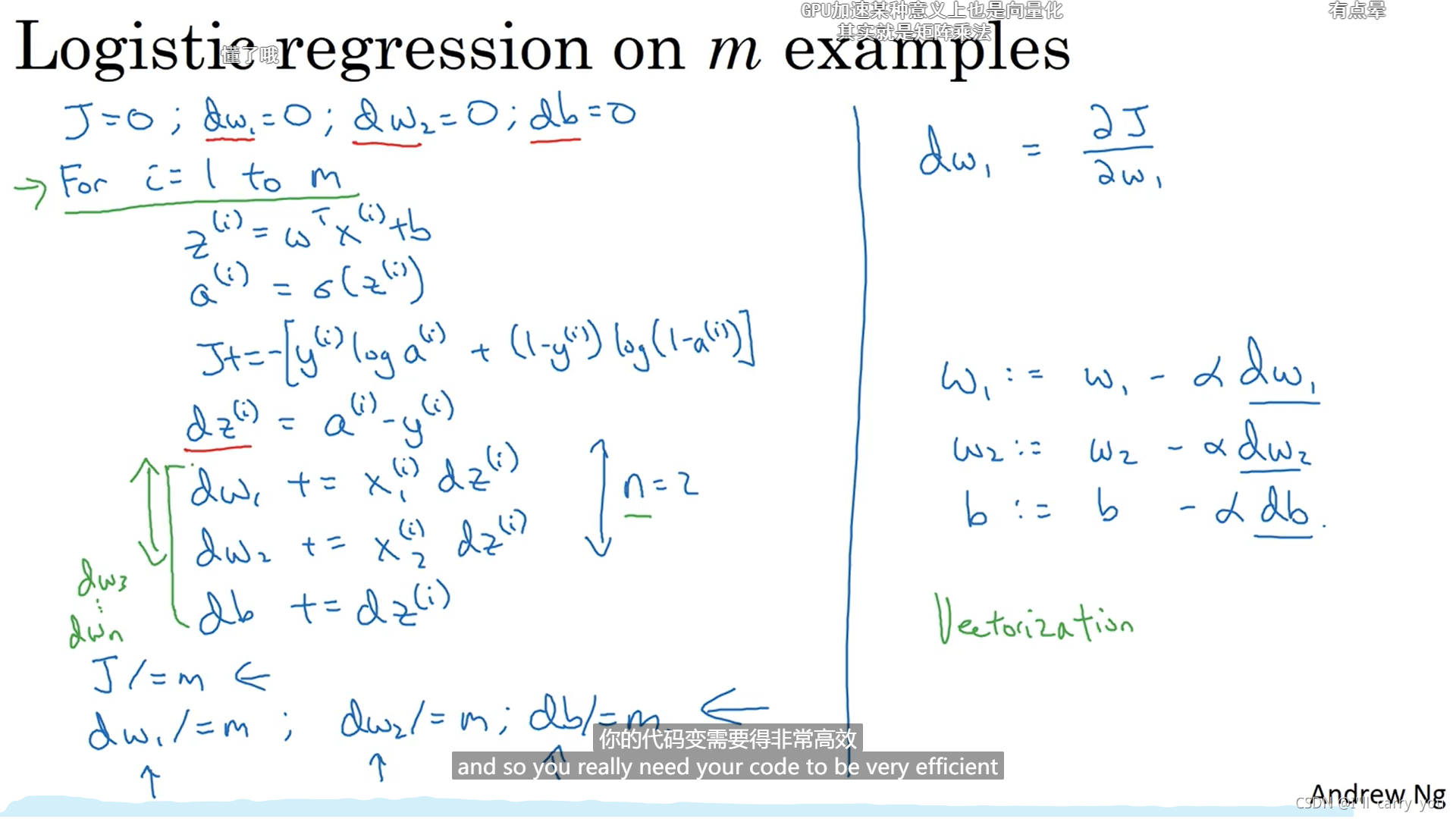

P16 2.10 m个样本的梯度下降

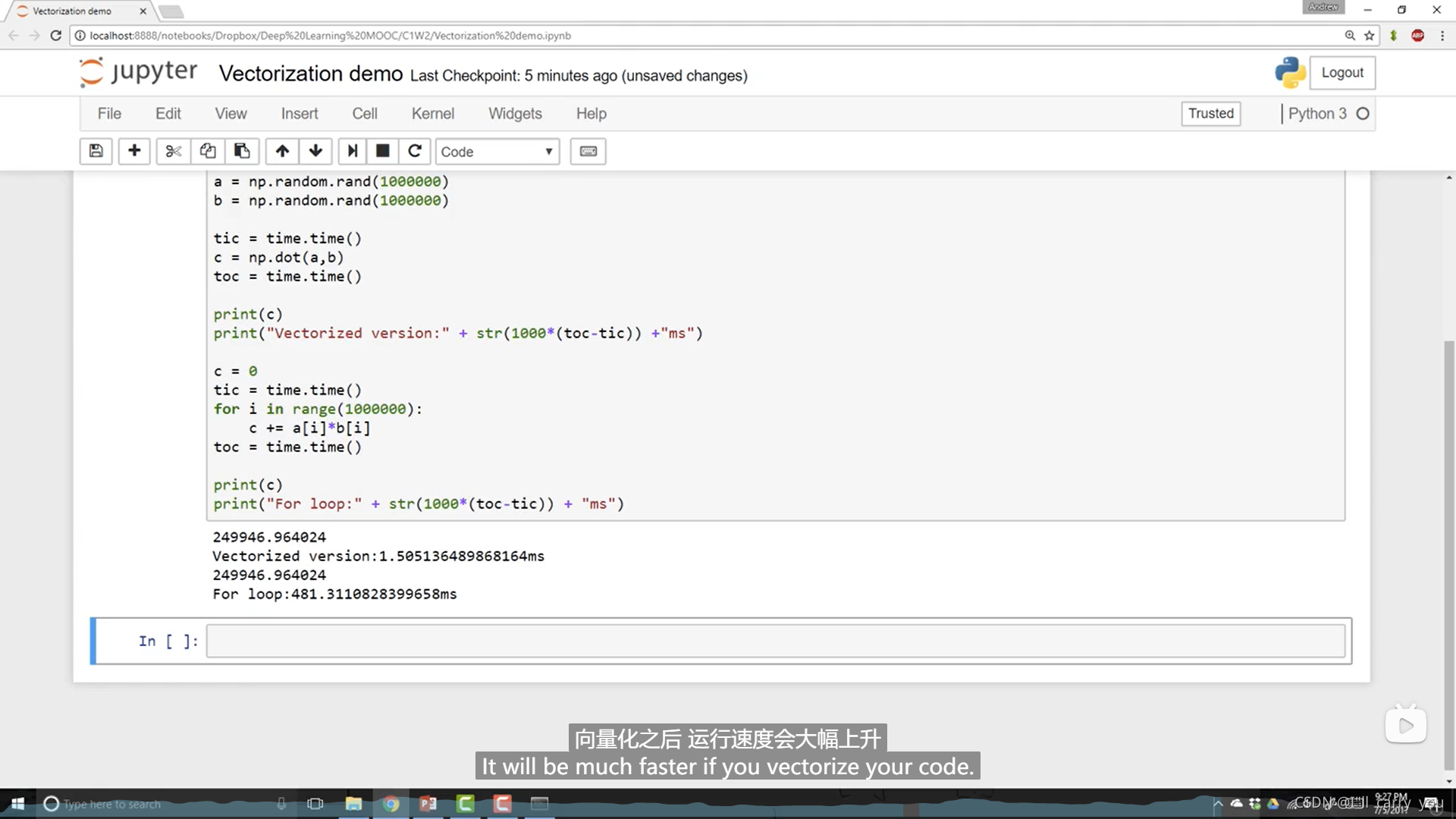

P17 2.11 向量化

P18 2.12 向量化的更多例子

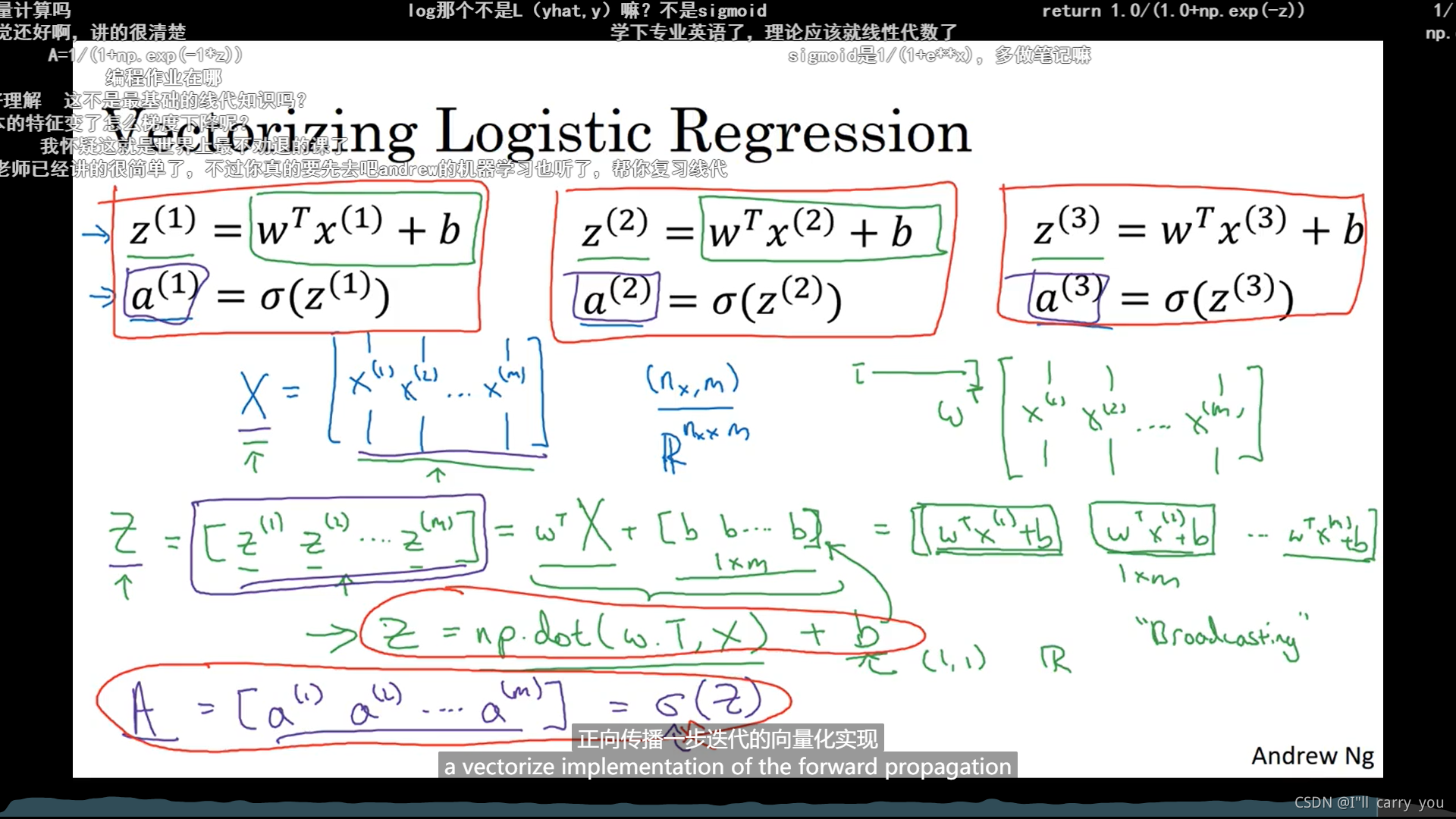

P19 2.13 向量化logistic回归

P20 2.14 向量化logistic回归的梯度输出

P21 2.15 Python中的广播

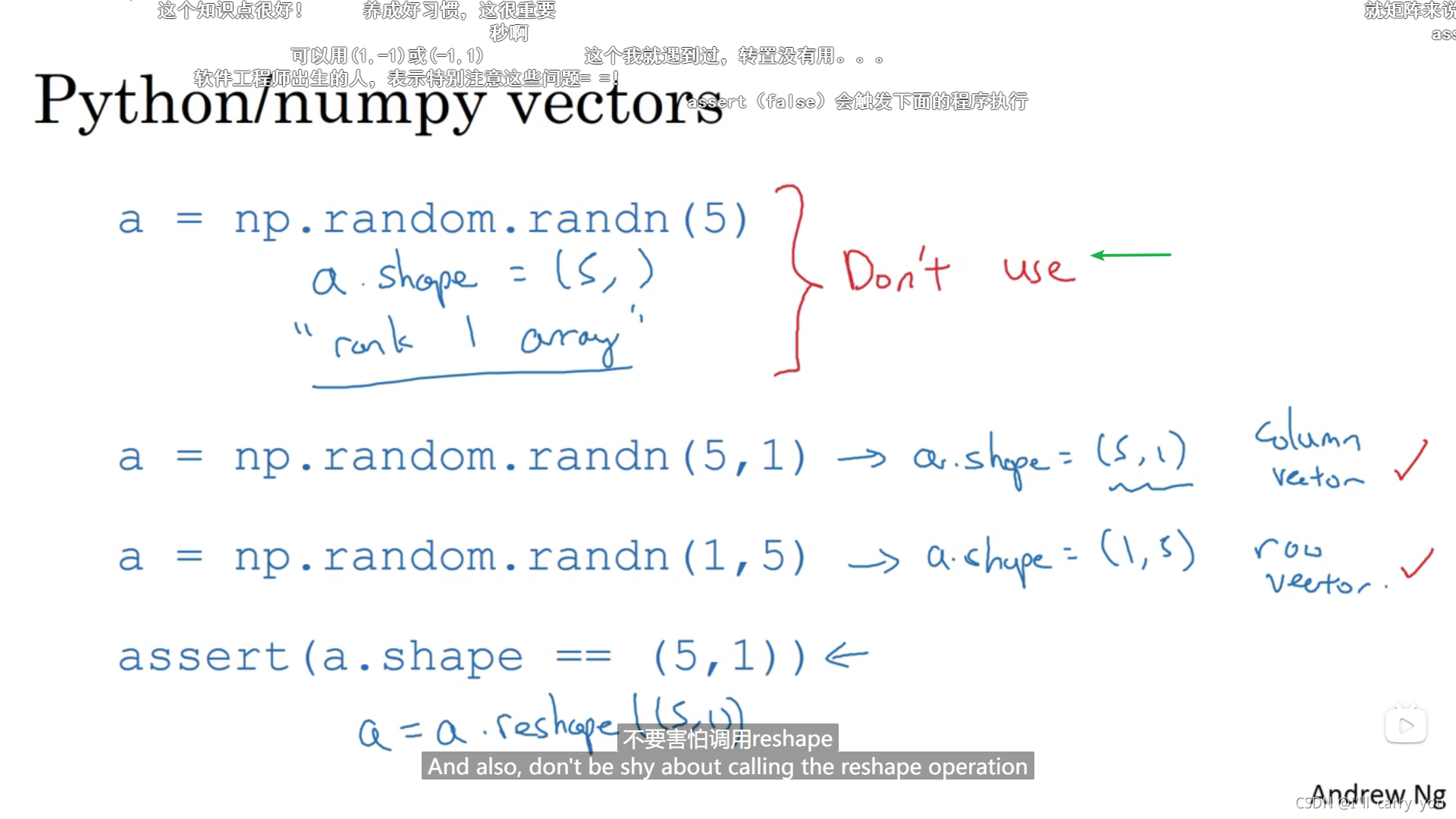

P22 2.16 关于python_numpy向量的说明

P23 2.17 Jupyter 笔记本的快速指南

P24 2.18 (选修)logistic损失函数的解释