全文都在和CNN作比较

最强优点鲁棒性

v Challenge:首先,Hughes现象是指随着训练数据维数的增加,识别准确率急剧下降,来自数百个频谱带[2]。 其次,它们的高空间分辨率使得小物体的识别成为可能,但增加了相邻像素之间的高相关性。

v 3DCNN模型的分类精度随层数的增加而减小。 DL模型最近的应用表明,利用模型学习的特征而不是手工特征来分析HSI是一种新的趋势。

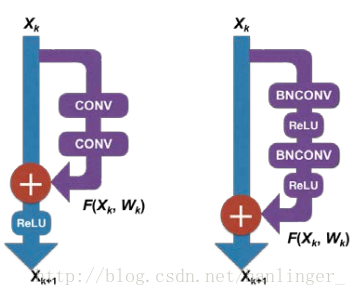

v Res网络缓解了精度下降的影响,并取得了很好的分类性能,为每两个卷积层添加身份映射到卷积神经网络来构建深度残差网络,卷积层可以如下制定。

在等式(1)中,Hk表示模型中第k层的输出,Fk是第k卷积滤波器组,bk表示第k层的偏差,G是整形线性单元(Re LU)。给定足够的标记数据,CNN可以产生比传统的机器学习方法更准确的分类结果。

v 批量标准化定义如下。

在等式(2)中,X表示特征批X的第i维,E表示期望值,VAR表示特征的方差。维度降低(DR)在HSI可视化和分类中起着重要的作用[11]。

v 在相似样本上构建概率分布并保留高维数据的局部结构的t-SNE是一种将HSI数据嵌入到低维空间的降维方法。每次迭代的t-SNE结果通过Kullback-Leibler(KL)发散的最小化来执行,其可以写为如下。

在等式(3)式中,P表示第i个样本和第j个样本的相似度,q表示投影特征空间中的相应相似度。

v 残差网络可以如下表示。

在等式 (4)中,Xk是第k个单元的输出,Wk是残差结构的参数。 堆叠的非线性层旨在构造函数F(Xk,Wk)而不是直接映射期望的Xk + 1。 与CNN相比,深度剩余网络1)更易于优化; 2)有更多的代表能力; 3)更深层次的识别精度更高。

v 在不同数量的卷积核和不同层次的HSN分类中的CNN参数。受启发[12],我们采用改进的残差网络进行HSI分类。 Tabel I显示Res Nets和CNNs,其内核数为{8,16,24,32,40},神经层数量为{4,6,8,10}。所有深度学习模型的输入数据是7×7×b HSI量,其中b是band number。

v 具有正则化方法的深度学习模型一致地产生比原始模型更高的分类准确性。

v 梯度消失Although this phenomenon still exists in Res Net models, the classification accuracies of which are more robust than their CNN counterparts.

v The classification maps of Res Nets in both datasets are much smoother than those of CNNs.

v t-SNE(t-distributed stochastic neighbor embedding)是用于降维的一种机器学习算法,是由 Laurens van der Maaten 和 Geoffrey Hinton在08年提出来。此外,t-SNE 是一种非线性降维算法,非常适用于高维数据降维到2维或者3维,进行可视化。 t-SNE是由SNE(Stochastic Neighbor Embedding, SNE; Hinton and Roweis, 2002)发展而来。