版权声明:新建了专注于语义分割的QQ群704803384,欢迎交流!!! https://blog.csdn.net/u014451076/article/details/79426394

Abstract

CVPR2017的文章,商汤、清华、港中文和北邮合作的文章。基本想法就是受现在的attention mechanism 和residual的激励,考虑把两者放在一起实现更好的效果。

本文的主要贡献是:

- 可堆叠的网络结构

- 注意力残差学习

- Bottom-up top-down相结合,自底向上是特征提取,自顶向下是attention

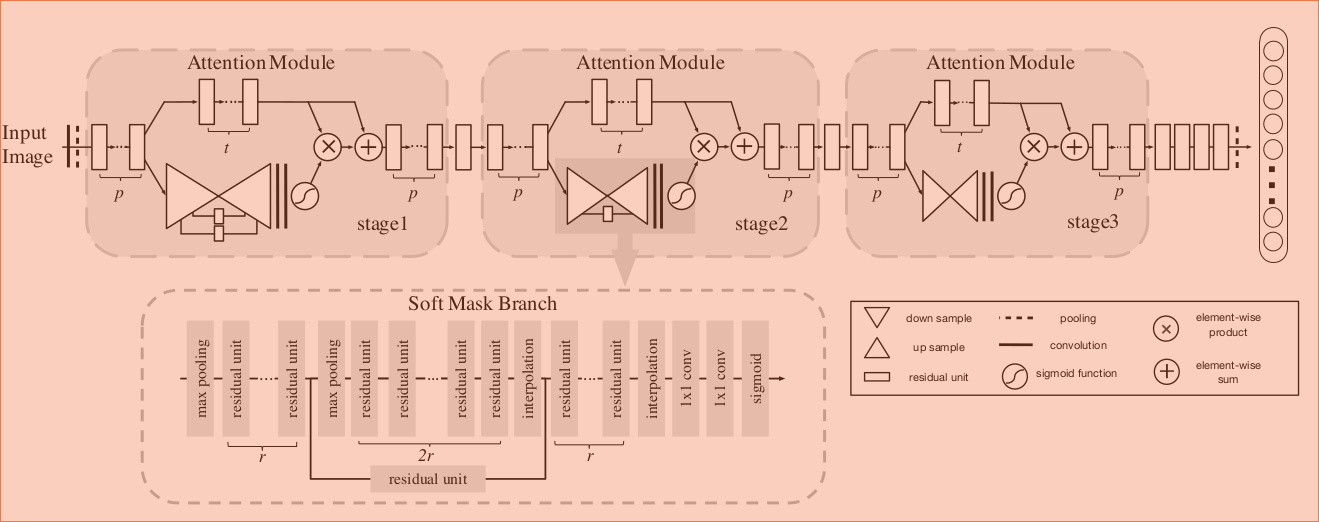

Framework

Attention residual learning

每一个Attention Module 都是一个学习模块,下边的分支是mask分之,上边的分支是trunk分支,两个分之之间组成Residual的结构

soft mask branch

mask分支类似一种编码解码网络Spatical attention and channel attention

- Mixed attention, 对每个通道和每个空间位置使用sigmoid

- Channel attention, 使用L2正则化约束所有通道的每一个位置,来移除空间信息

- Spatial attention, L2正则来约束每个位置的每一个通道,和空间信息相关

不太理解具体怎么做

结构实例

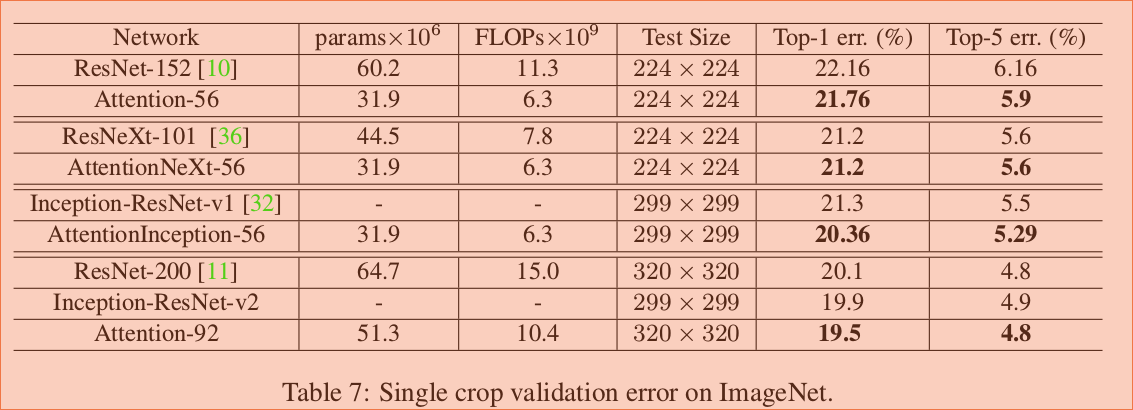

Result

Thinking

基本思路就是在分类的过程或者其他视觉网络中加入attention的信息,类似saliency map的感觉,在之后的网络中可以借鉴.

Others

还没有开源