机器学习初级算法梳理(一):线性回归

任务要求

1.基本概念:有监督、无监督、泛化能力、

过拟合欠拟合(方差和偏差以及各自解决办法)、交叉验证;

2.线性回归的原理;

3.线性回归损失函数、代价函数、目标函数;

4.优化方法(梯度下降法、牛顿法、拟牛顿法等);

5.线性回归的评估指标;

6.sklearn参数详解。

1.基本概念

(1)有监督与无监督

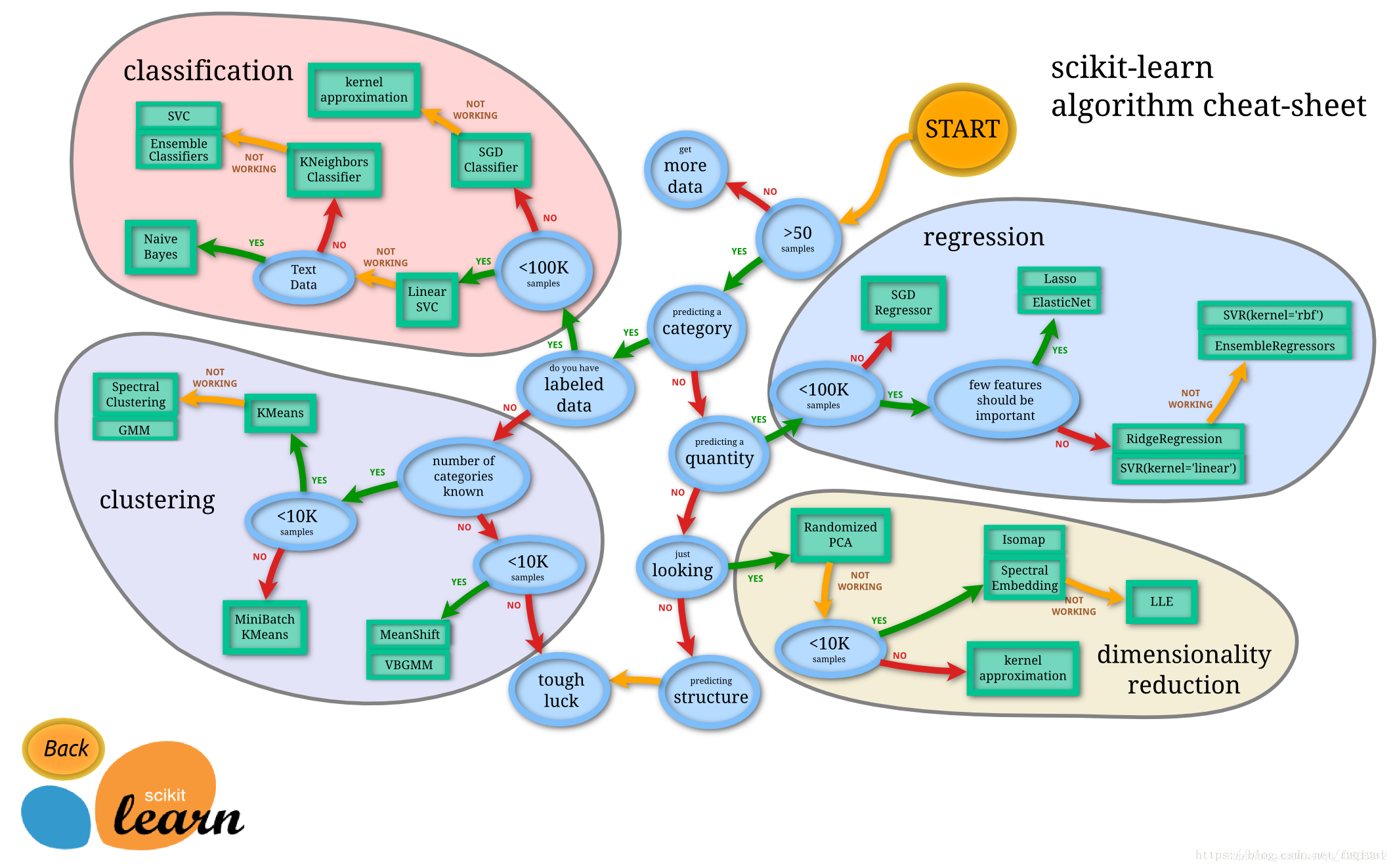

机器学习任务包括两类,有监督的和无监督的,有监督的主要包括分类与回归,非监督的主要包括聚类与频繁项集挖掘。

监督学习:给数据给标签,学习出一个模型进行预测与分析。

无监督学习:只给数据不给标签,学习出一个模型进行预测与分析。

半监督学习:给的部分数据带有标签而部分数据没带有标签,学习出一个模型进行预测和分析。

(2)泛化能力(Generalization Ability)是指学习到的模型对新鲜样本的适应能力、预测能力。

(3)过拟合欠拟合(方差和偏差以及各自解决方法)

过拟合:训练集效果非常好,测试集非常糟糕;把不该学的噪声特征都学到了。

解决方法:Early Stopping,数据集扩增(Data augmentation),正则化,(Regularization),dropout。

欠拟合:训练集和测试集效果都非常糟糕;没有很好学习应有特征。

解决方法:添加其他的特征项,添加多项式特征,减少正则化的参数。

偏差与方差:bias描述的是样本拟合输出的预测结果的期望和真实结果的差距,就是在样本上拟合的好不好,要想在bias上表现好,就得复杂化模型,增加模型的参数,但容易过拟合,variance是样本训练出来的模型在测试集的表现,要想low variance,需要简单化模型

(4)交叉验证(Cross Validation)常用于建模应用,在给定的建模样本中,拿出大部分样本进行建模型,留小部分样本用刚建立的模型进行预报,并求小部分样本的预报误差,记录他们的平方和。分为简单交叉验证,S折交叉验证,留一交叉验证。

2.线性回归(Linear Regression)

(1)原理:利用线性回归方程与真实值相差的最小平方函数对一个或多个自变量和因变量之间进行建模的一种回归分析。

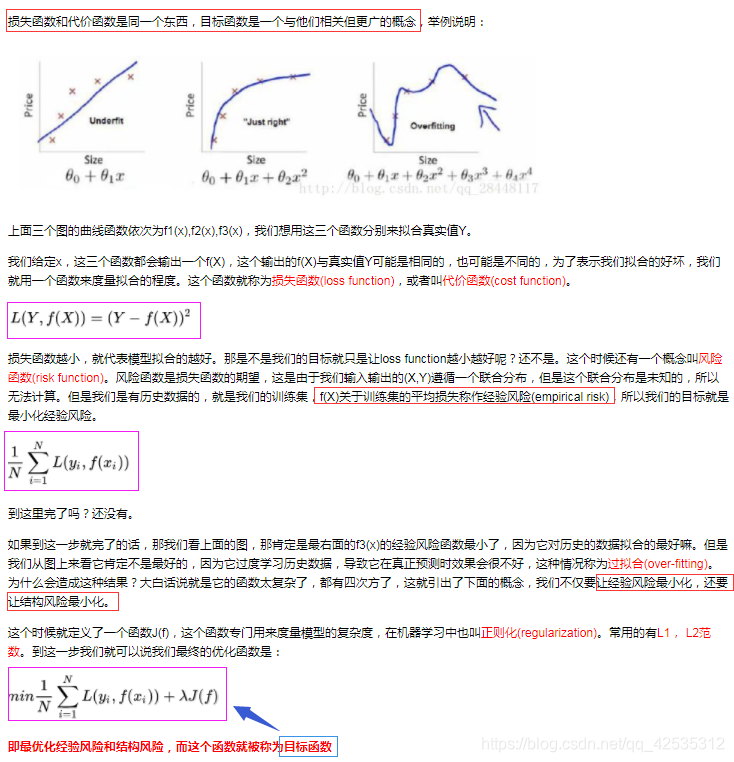

(2)损失函数、代价函数、目标函数

3.优化方法

梯度下降:用来求函数的最小值,利用梯度下降算法来求代价函数的最小值;

牛顿法:牛顿法是利用迭代点处的一阶导数(梯度)和二阶导数(Hessen矩阵)对目标函数进行二次函数近似,然后把二次模型的极小点作为新的迭代点,并不断重复这一过程,直到求出满足精度的近似极小值;

拟牛顿法:以较低的计算代价寻求海森矩阵的近似逆矩阵,可以显著降低计算的时间。

4.评估指标

| 指标 | 描述 |

|---|---|

| Mean Square Error (MSE, RMSE) | 平均方差 |

| Absolute Error (MAE, RAE) | 绝对误差 |

| R-Squared | R平方值 |

线性回归中常有MSE,对应欧几里得距离(欧式距离),基于均方误差最小化来模型求解的方法称为"最小二乘法",找到一条直线,使所有样本到直线上的欧式距离之和最小。

5.sklearn参数详解