版权声明:本文为博主原创文章,未经博主允许不得转载。 https://blog.csdn.net/jesmine_gu/article/details/83245907

在看统计学习方法证明泛化误差上界中提到使用Hoeffding不等式(霍夫丁不等式)

很陌生,占个坑理解一下。

关于该不等式的原地址:Hoeffding's inequality

Hoeffding不等式指的是某个事件的真实概率与在伯努利试验中观察到的频率之间的差异

考虑到伯努利实验,该实验是在同样的条件下重复地、相互独立地进行的一种随机试验,其特点是该随机试验只有两种可能结果:发生或者不发生。比较熟悉的一种就是0-1分布,也叫两点分布。

用H(n)表示抛n次硬币正面向上的概率

则正面向上的次数不超过k的概率为

当k=(p-ε)n时,霍夫丁上界将会按照指数级变化,得到霍夫丁不等式

当k=(p+ε)n时

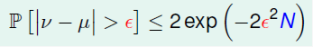

两式合并,得到

令

得到

在《统计机器学习》中的Hoeffding的公式好像有很多的版本。

证明实在没看懂,就依据例子简单的了解一下吧。

不少博客举到一个从小罐中里摸小球的例子,从一个装有绿色和黄色的罐子里随机地摸出小球,根据摸出小球的概率来估计整个罐子中绿色球和黄色球的所占的比例。

那么当抽出的样本数越多,最终预测出的绿球占整个罐子中小球的概率u会越趋近于实际罐子中绿色小球占整个罐子小球的概率v。

所以就有了霍夫丁不等式,在一个含有N个样本数(N足够大)的数据集中,在误差允许的范围内,u和v可以不断地靠近。左侧的概率随着N的增大而减少,所以,要减少预测和实际之间的误差,就要增大样本数量。

附一张参考博文2里的图,不做多的解释。

参考博文:

1、机器学习数学原理(8)——霍夫丁不等式 对原英文文章的翻译