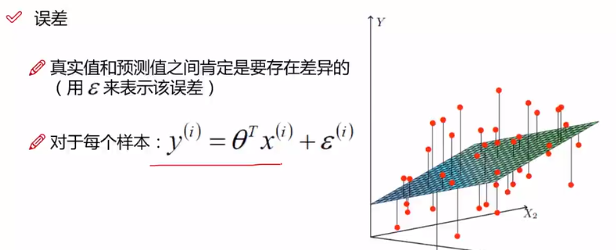

1.对于线性回归问题中的误差分析:

首先先说明一下,为了节省时间,以及一些比较难打的字符我真不知道怎么打..我就直接将视频中的截图放上来了..... 侵删

正态分布

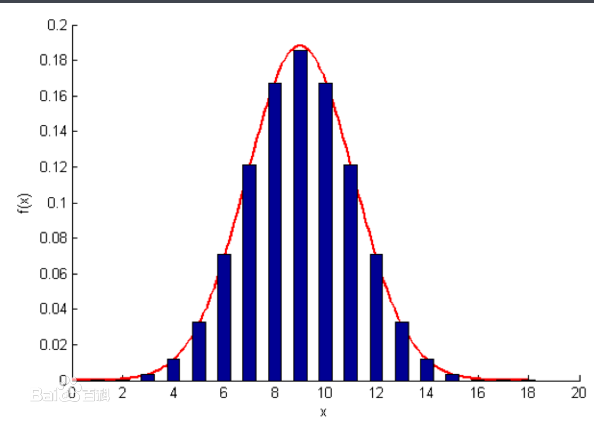

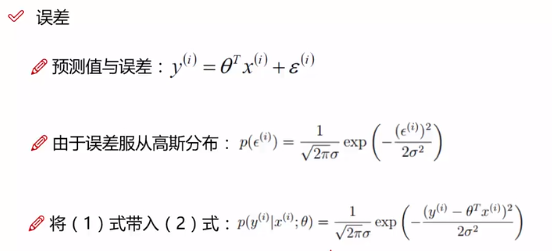

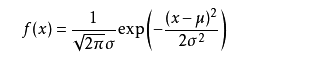

对于每个样本的误差都是独立的,是同一种分布,并且假设概率服从高斯分布(正态分布),高斯分布绝大多数时候浮动不会太大,比较贴近实际情况。

之前假设服从均值为0的正态分布,所以可以得到(2)式,而误差本身就表示是预测值和真实值之间的差值。所以将误差替换即将(1)式代入(2)式。

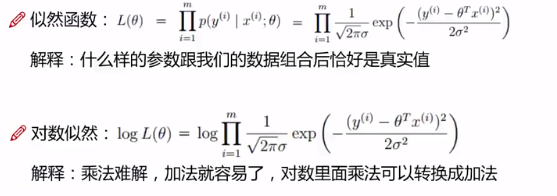

似然函数:在数理统计学中,似然函数是一种关于统计模型中的参数的函数 通俗点理解就是去训练参数,使其在给定输入的情况下输出是真实值当然最大努力去接近。

当然这只能说是现阶段我的理解,随着学习深入会有更深的理解吧。似然函数是将每个样本的P求解式连乘,显然运算量太大。很容易想到对数似然。log(a×b)=loga+logb

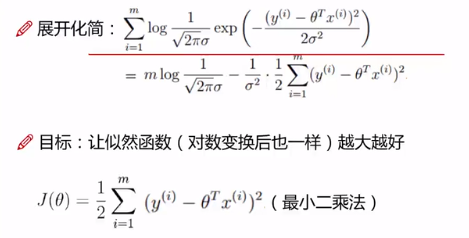

展开化简后容易得到上式。为了让似然函数值最大,极大似然化(不懂为甚么极大似然值需要最大,自己百度一下,我现在没理解不敢瞎说)。对于展开式的前半部分是一个定值了,只需要后面部分最小即可取到最大值。而后面一部分又是最小二乘法的计算。

对于最小二乘法化简为右图的形式。矩阵化。平方就是矩阵转置再乘以其本身。然后对θ进行求偏导。然后让偏导为0,得到此时的θ。至于为什么是极大值而不会是极小值,是有一个特性,不过现在尚且不知道,目前就知道在求解最小二乘法时偏导为0的地方为极大值尚可。

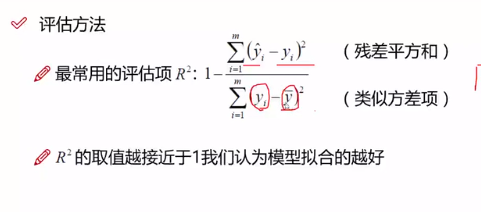

在评估时用R平方来评估,对训练好的参数。越接近1越好。在skitlearn中也有这个评估方式。

2.逻辑回归算法原理分析

逻辑回归是一种二分类算法(当然也可以处理多分类

在通常情况下是先用逻辑回归算法来进行处理,然后再根据逻辑回归达到的效果,在进行改进来决定是用什么算法。如果情况差不多优先使用逻辑回归

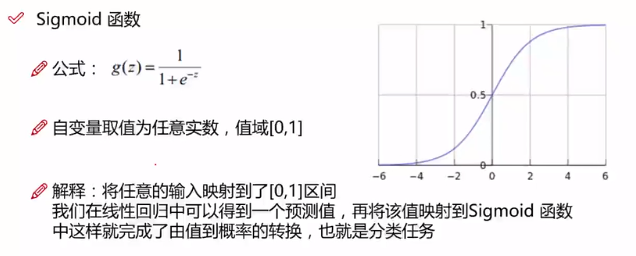

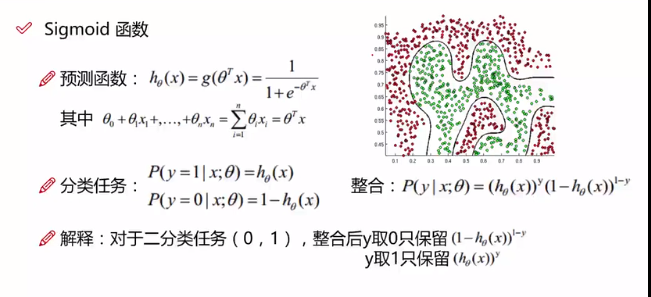

写的很清楚了,就是将输出转化成0-1的范围内的数,由值到概率的转换

对于给定θ和x的情况下求输出的概率。所以代入。然后因为是二分类问题。所以可以根据其特点整合成一个完整的表达式。

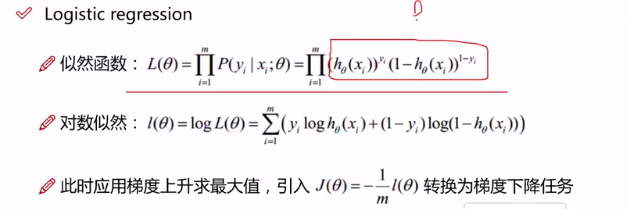

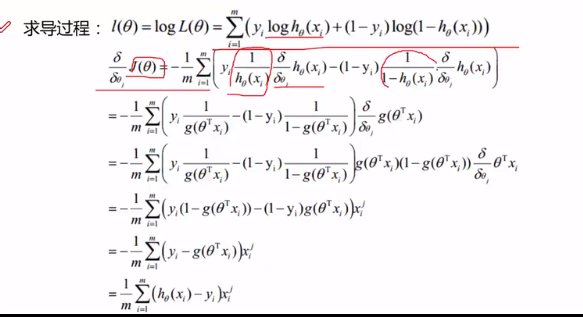

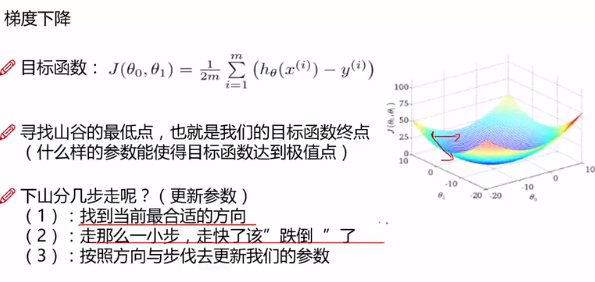

同样的使似然函数最大。转化为负数从而转化为梯度下降任务。也就是求使Jθ下降最快的θ,所以进行求导

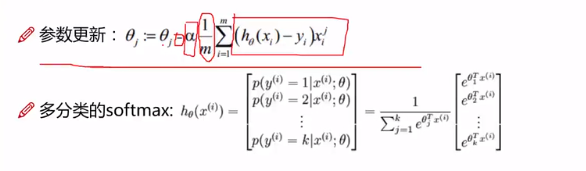

而且对于每个特征都要对其进行求导,知道了梯度下降的方向,然后每次改变θ,α是学习率

其实个人感觉不管是线性回归也好还是逻辑回归,最重要的就是构造其最终函数。至于其他的数学运算的都只是计算问题。其次,还有对似然函数的理解以及sigmoid函数的理解都很重要,是帮助我们建模构造最终函数的关键。