线性回归

线性回归是利用数理统计中回归分析,来确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法,运用十分广泛。其表达形式为y = w’x+e,e为误差服从均值为0的正态分布。

如果回归方程只包含一个因变量,则被成为一元线性回归分析(这个我们在中学阶段接触过),含两个以上因变量则被称为多元线性回归分析。

在学习过程中,为表示我们建立的模型的准确度,我们用损失函数(代价函数)来表示这个模型与实际情况的误差。我们可以利用这个函数确定参数取何值时这个函数最符合实际。

我们可以求损失函数的导数,根据导数选择函数下降速度最快的方向“前进”,不断重复这个过程来求得损失函数最小值。这个方法就是梯度下降法。

逻辑回归(logistic回归)

逻辑回归其实就是在用回归的方法做分类问题。我们需要通过数据判断出现某一结果的概率。于是我们在特征与预测值直接加了一层函数

其中,z就是上面的多元函数w’x。我们利用这个函数将函数值控制在0到1之间,反应出的也就是出现正例(1)的概率了。

神经网络

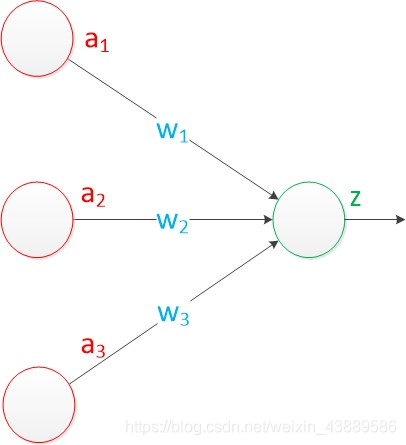

模仿神经元的结构(树突,细胞核,轴突),我们建立了单层神经网络,由多个输入,计算以及一个输出组成。我们通过输入的多个已知属性(特征)来预测一个未知属性(目标)。输入的数据(a)在传递过程中根据权值(w)进行求和再利用函数计算。通过学习不断更正权值得到更好的结果。

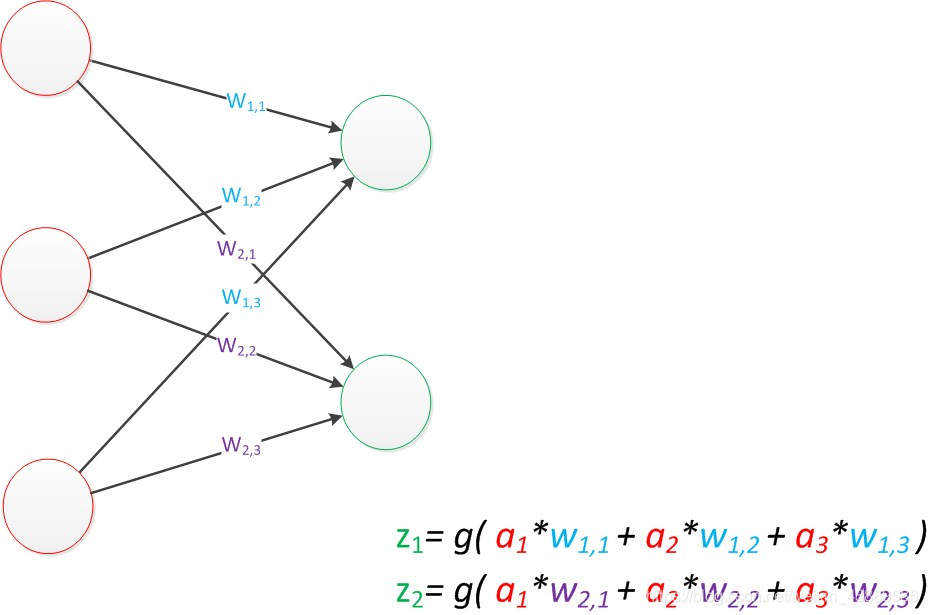

我们可以加入新的权值预测更多的目标。

其中,权值w的下标为(前一层神经元的序号,后一层神经元的序号)(序号顺序从上至下),我们发现,如果将权值(参数)与输入值(变量)写成两个矩阵,我们就可以用矩阵乘法轻易表达出这个式子。如z1=g(w*a),其中a=[a1,a2,a3]T,z=[z1,z2]T,w为一个2行3列的矩阵,存储权值。

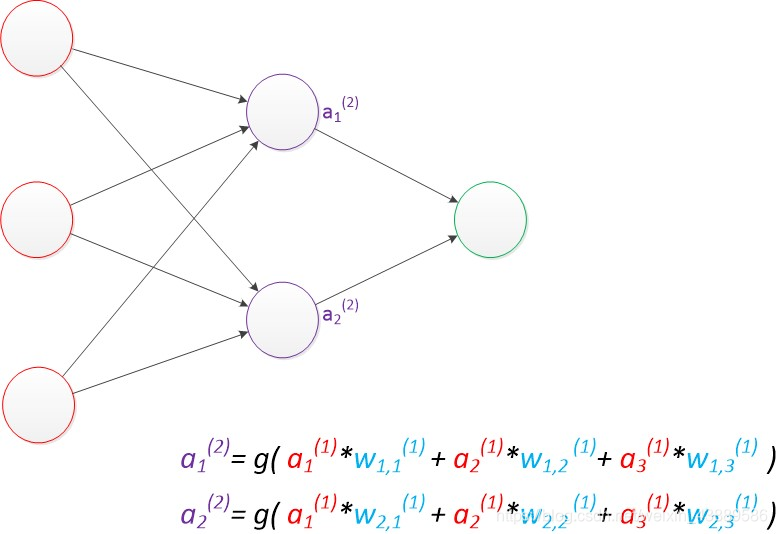

单层神经网络(感知机)的局限性太大,很难应用,于是我们在此基础上再加一个计算层。

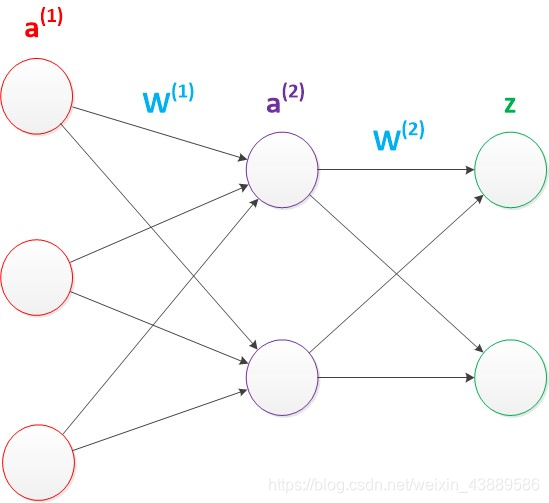

我们发现,即使两层神经网络,也可以使用矩阵乘法很简单的表示出来。

g(W(1) * a(1)) = a(2);

g(W(2) * a(2)) = z

两层神经网络可以无限逼近任意连续函数。

我们可以再继续增加计算层得到多层神经网络,多层神经网络的相关学习方法也就是我们经常听到的深度学习。