目录

2.1线性回归

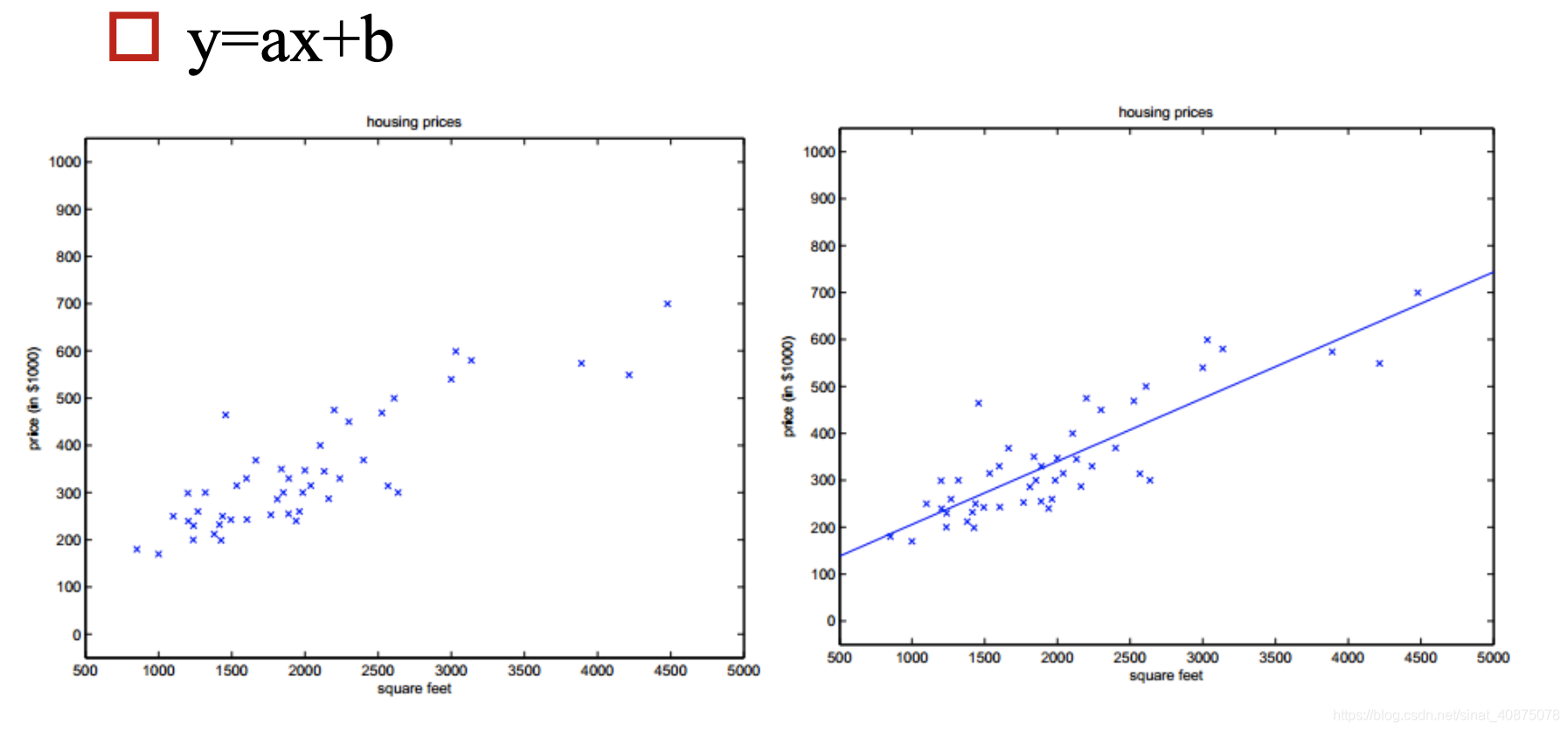

利用大量的样本D ,通过有监督的学习,学习到由x到y的映射f(x),利用该映射关系对未知的数据进行预估,因为y为连续值,所以是回归问题。

单变量情形:

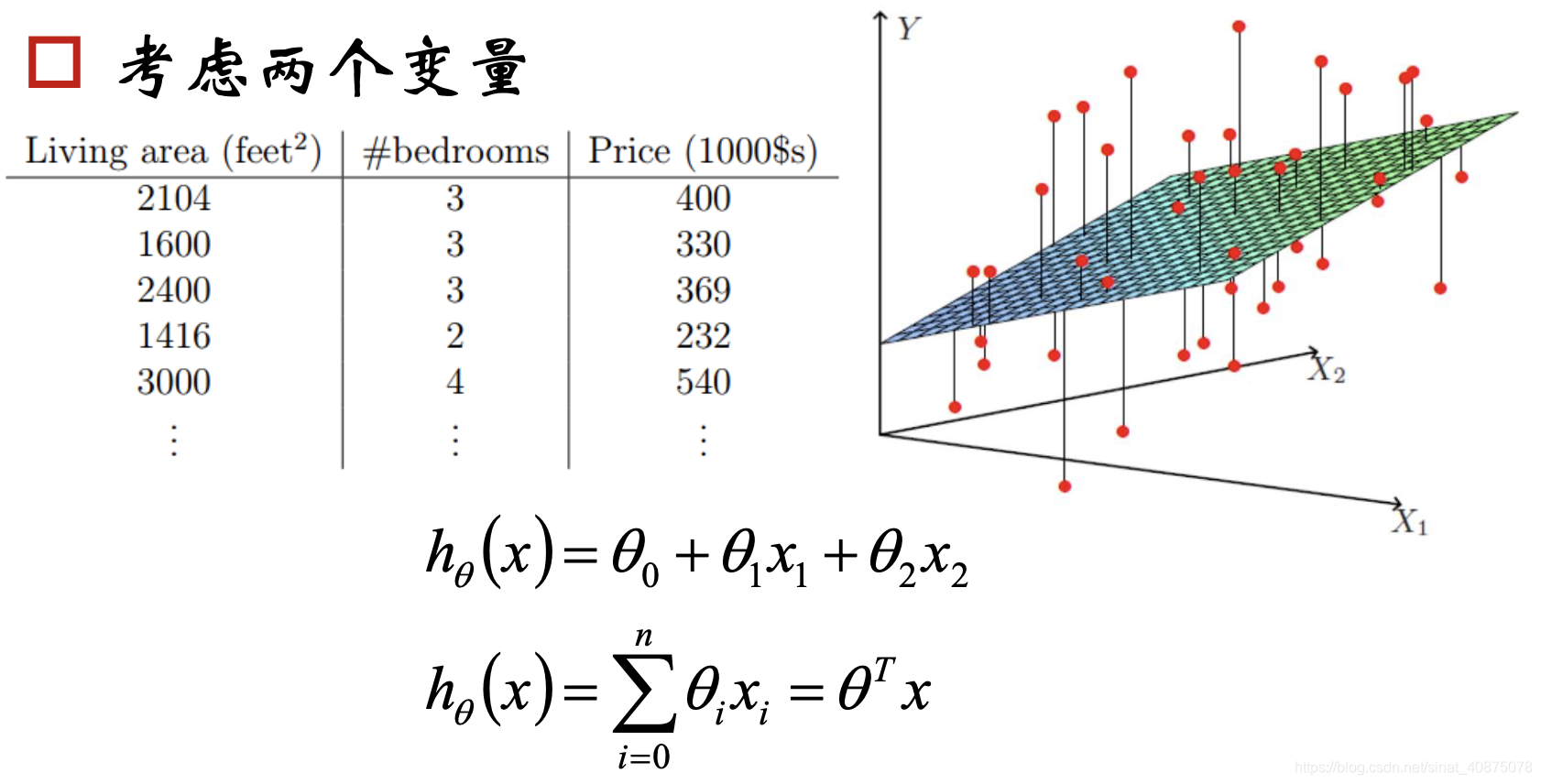

多变量情形:

2.1.1线性回归目标函数

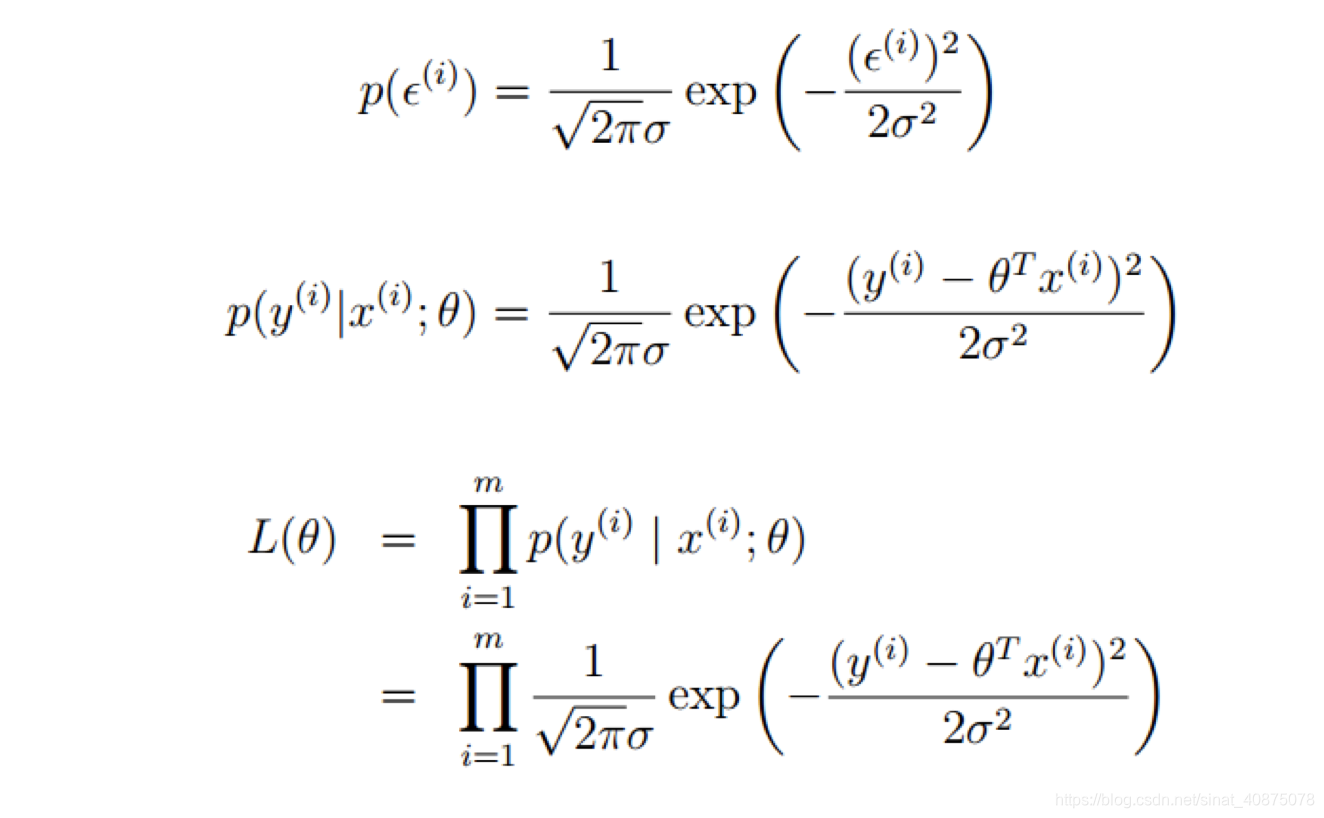

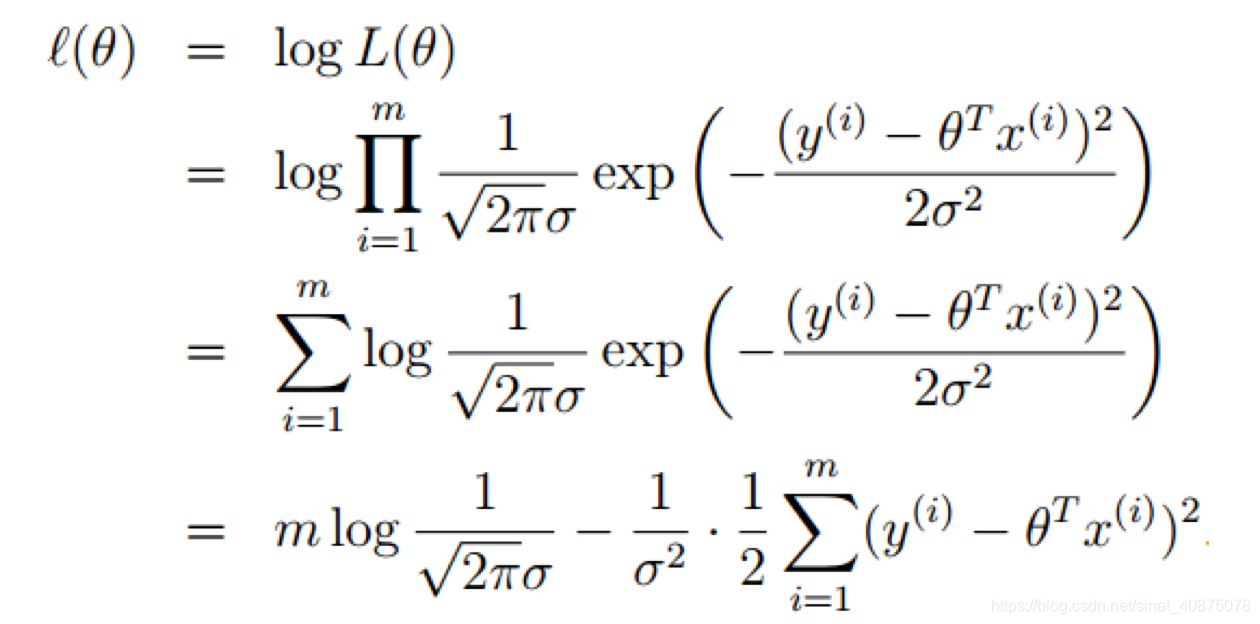

使用极大似然估计解释最小二乘:

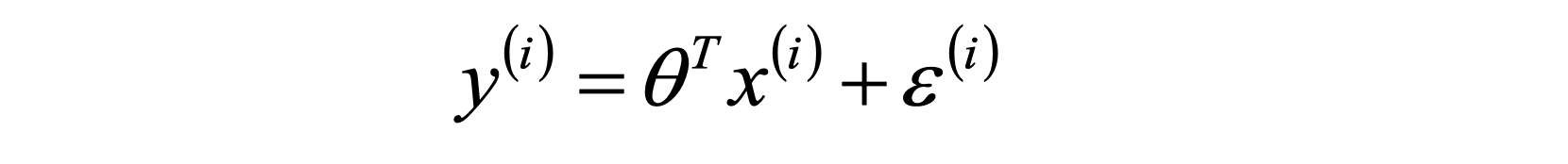

根据中心极限定理:误差ε(i)(1≤i≤m)独立同分布的,服从均值为0,方差为某定值σ2 的高斯分布。

所以有似然函数:

利用似然估计有:

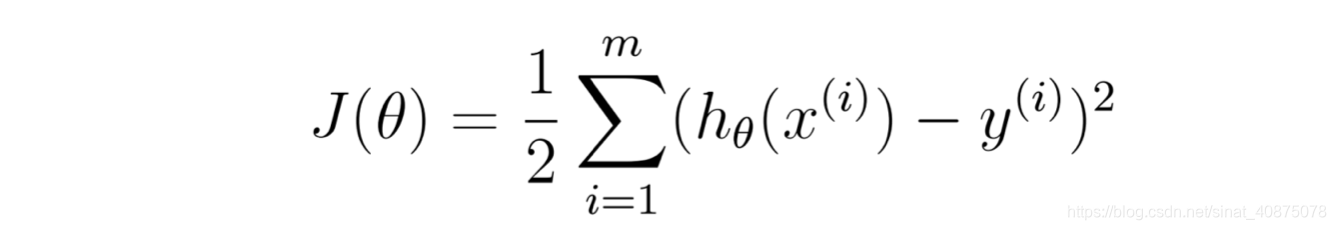

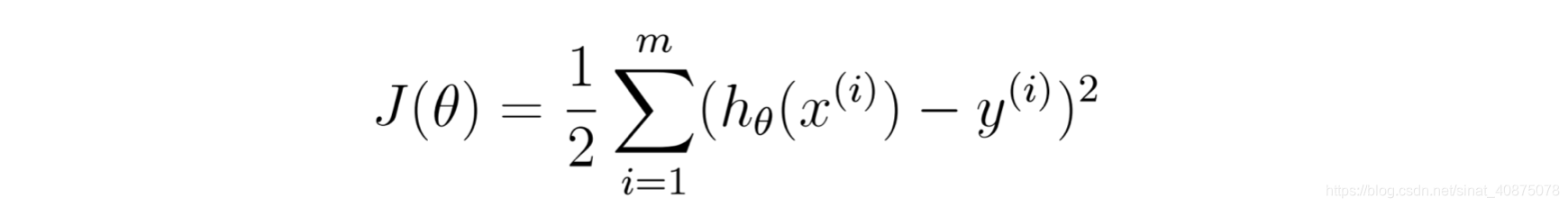

因此我们的目的是使得l(θ)最大似然,也即使

最小。因此我们的目标函数为J(θ)。而不同的参数有不同的偏差,所以要通过最小化目标函数,也就是最小化偏差来得到最好的参数。

2.1.2参数θ的求解

解析式求解:

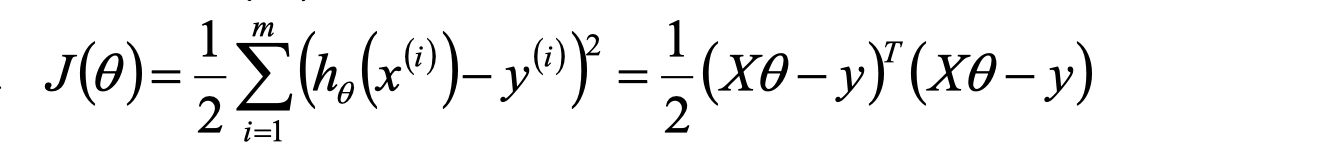

我们已经有目标函数

因此针对一个将M个N纬样本组成的矩阵X(其中X的每一行对应一个样本,共M行;X的每一列对应样本的一个纬度,共N纬),目标函数可变为

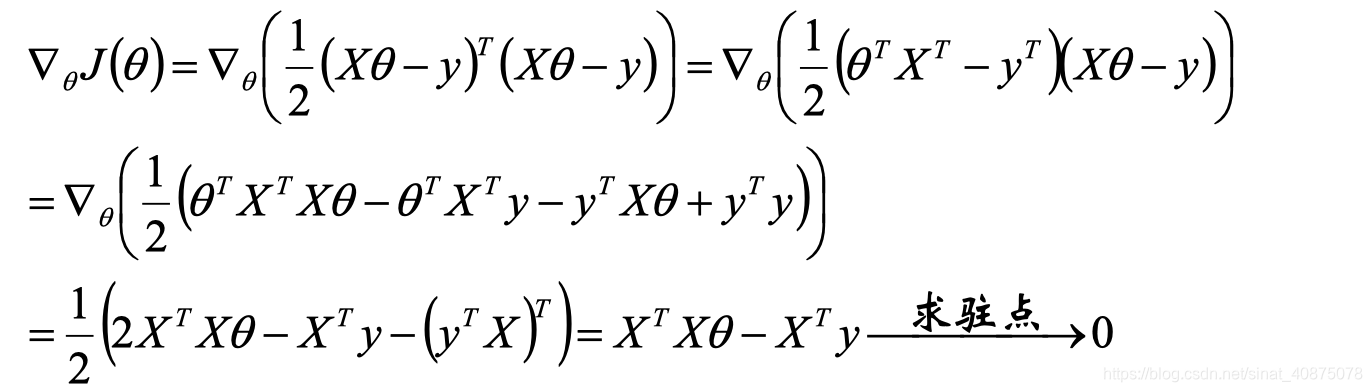

采用线性数学求导的方式求驻点:

所以有

若XTX不可逆或为了防止过拟合,可增加λ扰动:

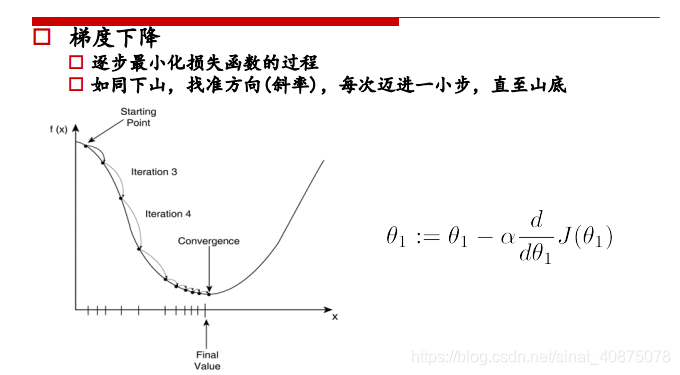

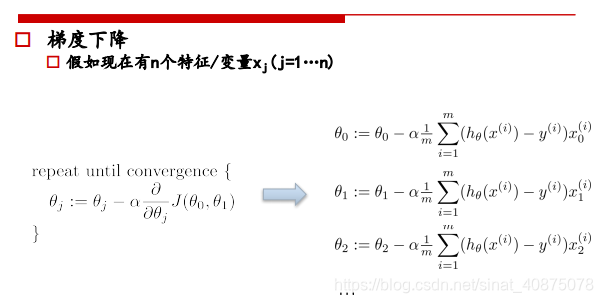

梯度下降

目标函数二次求导得到J(θ)=XTX>=0,所以目标是一个凸函数,我们的目标是达到最低点,也就是使得损失函数最小。因此可采用梯度下降的方法

参数更新示例:

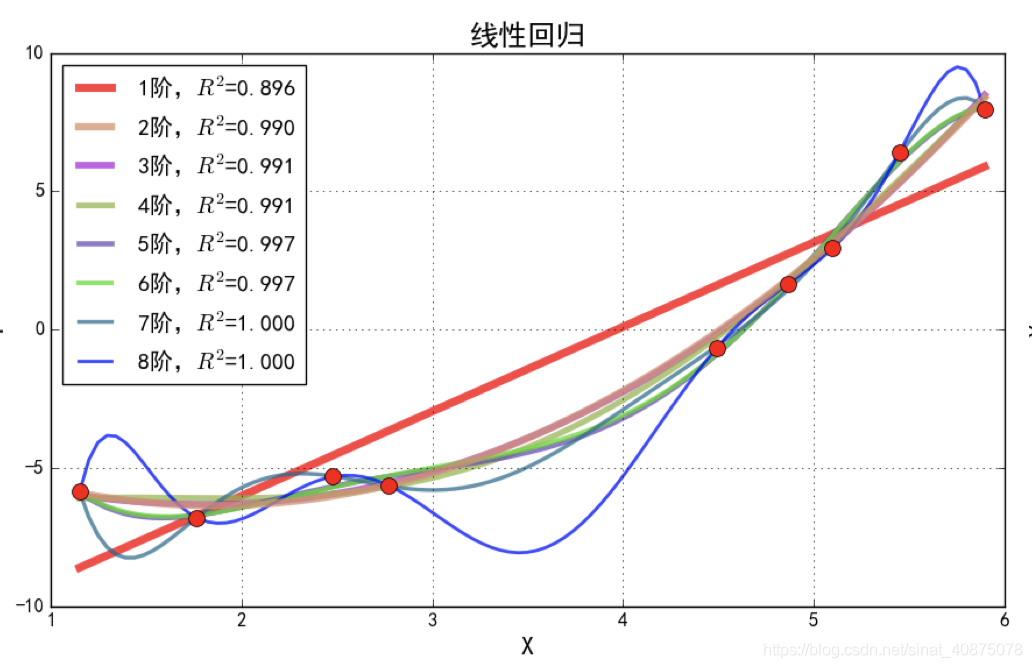

2.1.3 过拟合

过拟合的原因如上图所示:

如果我们有很多的特征或模型(高阶模型)很复杂,则假设函数曲线可以对训练样本拟合的非常好,学习能力太强了,但是丧失了一般性。同时训练样本中肯定存在噪声点,如果全都学习的话肯定会将噪声也学习进去。

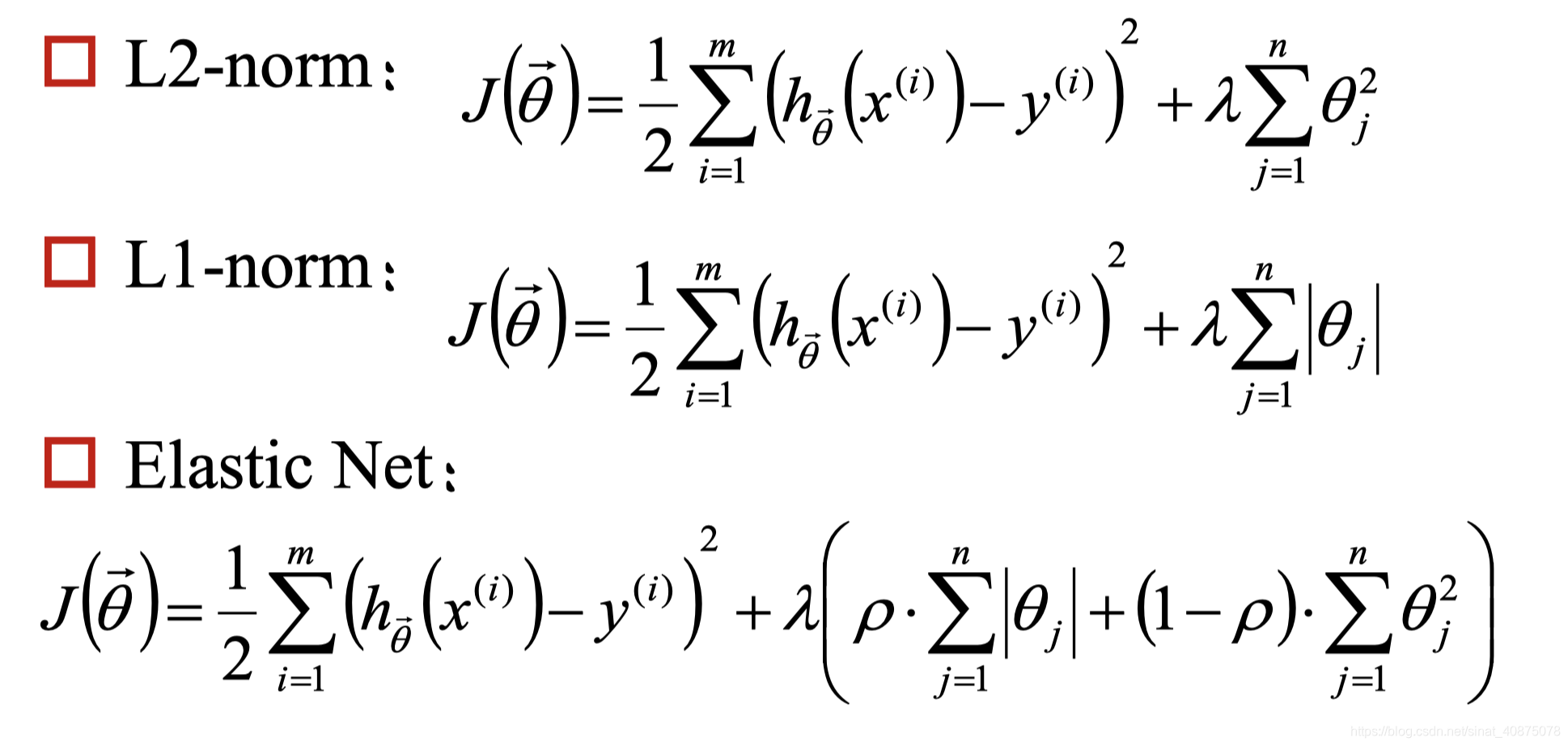

2.1.4 利用正则化解决过拟合问题

正则化的作用:

a、控制参数变化幅度,对变化大的参数惩罚

b、限制参数搜索空间

c、第二种正则化方式还可以做特征的选取

2.2逻辑回归

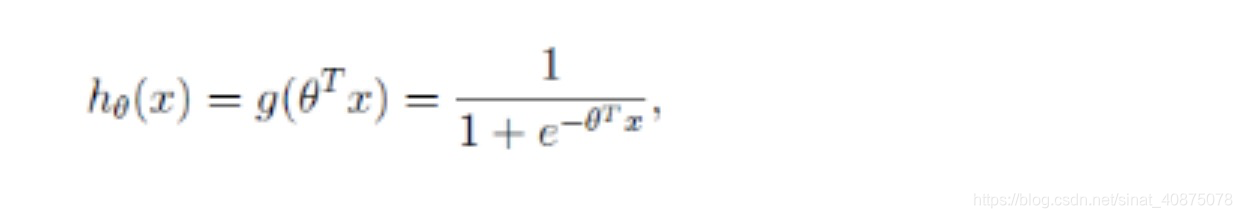

逻辑回归本质上是线性回归,只是在特征到结果的映射中加入了一层逻辑函数(激励函数)g(z),即先把特征线性求和,然后使用g(z)作为假设函数来预测。g(z)可以将连续的值映射到0和1之间。用于分类问题g(z)为sigmod函数

则

则

2.2.1逻辑回归的目标函数

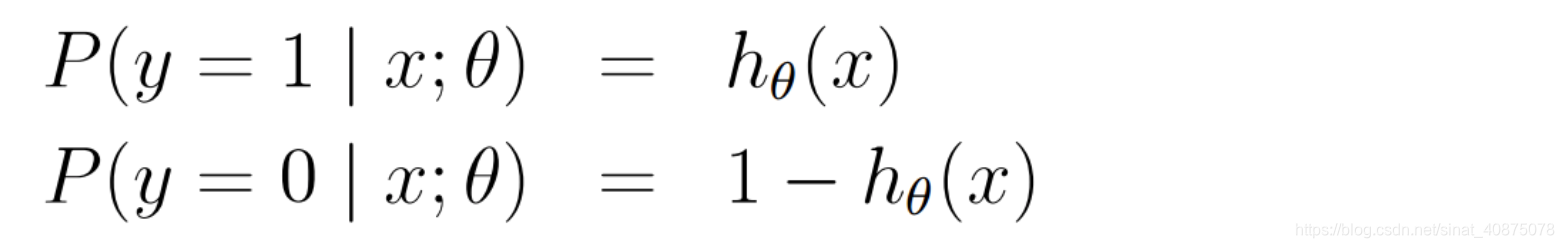

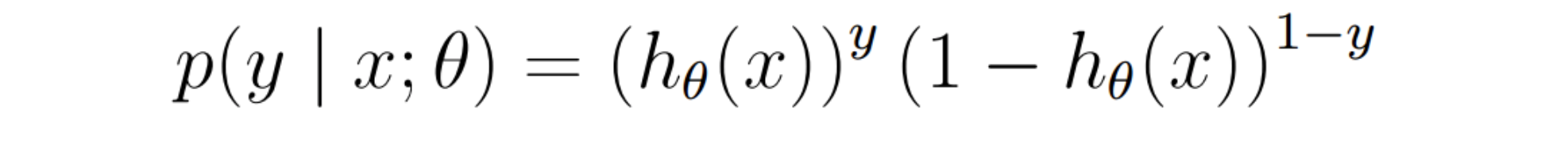

逻辑回归用来分类0/1问题,也就是预测结果属于0或1的二值分类问题。这里假设二值满足伯努利分布,即

也可写成如下形式

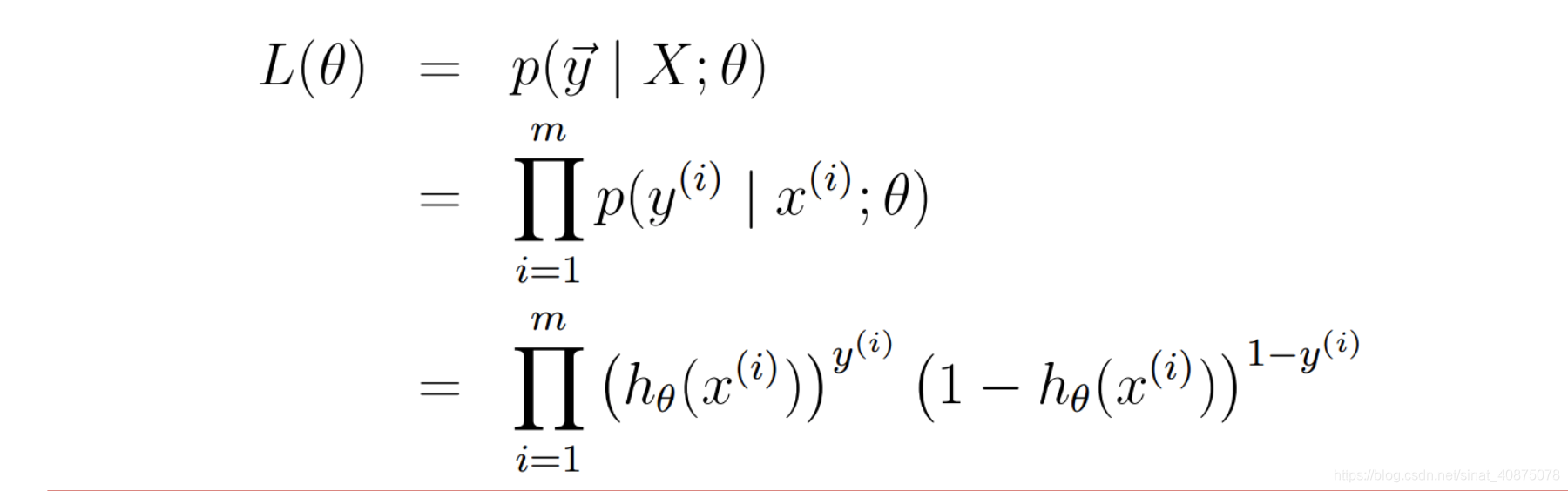

对于训练数据集,特征数据x={x1,x2,x3……,xm}和对应的分类标签y={y1,y2,y3,……,ym},假设m个样本是相互独立的,那么极大似然函数为:

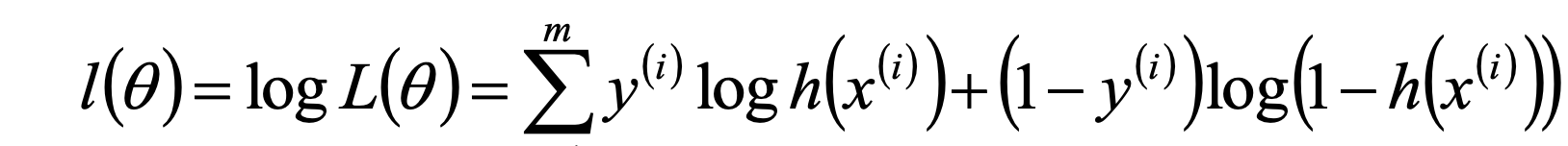

log似然为:

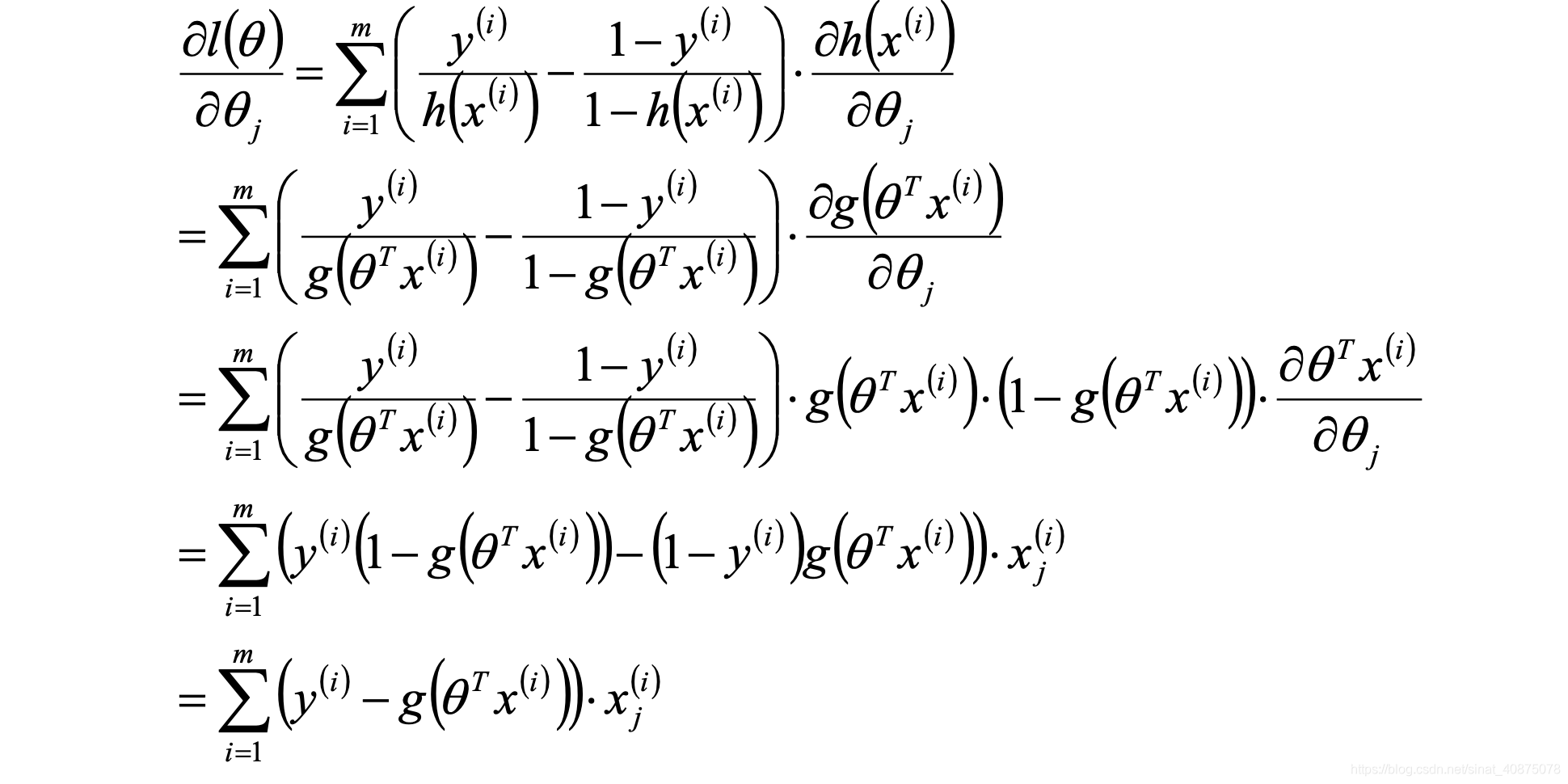

为了使其最大,与线性回归类似,使用求导

为了使其最大,与线性回归类似,使用求导

则Logistic参数学习规则为:

2.2.2 逻辑回归实现多分类

方式一:修改逻辑回归的损失函数,使用softmax函数构造模型解决多分类问题,softmax分类模型会有相同于类别数的输出,输出的值为对于样本属于各个类别的概率,最后对于样本进行预测的类型为概率值最高的那个类别。

方式二:根据每个类别都建立- -个二分类器,本类别的样本标签定义为0,其它分类样本标签定义为1,则有多少个类别就构造多少个逻辑回归分类器

2.3 线性回归和逻辑回归的区别:

线性回归用来做预测,LR用来做分类。线性回归是来拟合函数,LR是来预测函数。线性回归用最小二乘法来计算参数,LR用最大似然估计来计算参数。线性回归更容易受到异常值的影响,而LR对异常值有较好的稳定性。

2.4 LR和SVM的区别

a、LR是参数模型,SVM是非参数模型。

b、从目标函数来看,区别在于逻辑回归采用的是logistical loss,SVM采用的是hinge loss.这两个损失函数的目的都是增加对分类影响较大的数据点的权重,减少与分类关系较小的数据点的权重。

c、SVM的处理方法是只考虑support vectors,也就是和分类最相关的少数点,去学习分类器。而逻辑回归通过非线性映射,大大减小了离分类平面较远的点的权重,相对提升了与分类最相关的数据点的权重。

d、逻辑回归相对来说模型更简单,好理解,特别是大规模线性分类时比较方便。而SVM的理解和优化相对来说复杂一些, SVM转化为对偶问题后分类只需要计算与少数几个支持向量的距离,这个在进行复杂核函数计算时优势很明显,能够大大简化模型和计算。

e、logic 能做的svm能做,但可能在准确率.上有问题,svm能做的logic有的做不了。

参考文献

邹博机器学习

https://blog.csdn.net/jiaoyangwm/article/details/81139362

https://www.jianshu.com/p/821194a77d22