Learning to Answer Yes/No

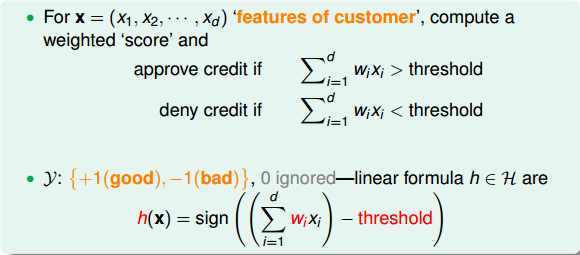

Perceptron Hypothesis Set(感知机)

银行是否给用户发信用卡的例子,我们把用户的个人信息作为特征向量x,令总共有d个特征,每个特征赋予不同的权重w,表示该特征对输出(是否发信用卡)的影响有多大。那所有特征的加权和的值与一个设定的阈值threshold进行比较:大于这个阈值,输出为+1,即发信用卡;小于这个阈值,输出为-1,即不发信用卡。感知机模型,就是当特征加权和与阈值的差大于或等于0,则输出h(x)=1;当特征加权和与阈值的差小于0,则输出h(x)=-1,而我们的目的就是计算出所有权值w和阈值threshold。

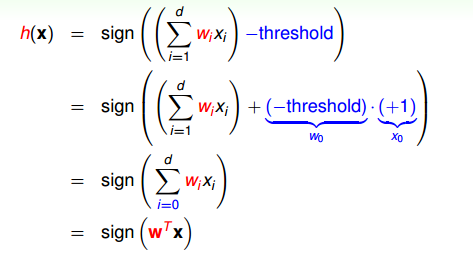

为了计算方便,通常我们将阈值threshold当做

,引入一个

=1的量与

相乘,这样就把threshold也转变成了权值

,简化了计算。h(x)的表达式做如下变换:

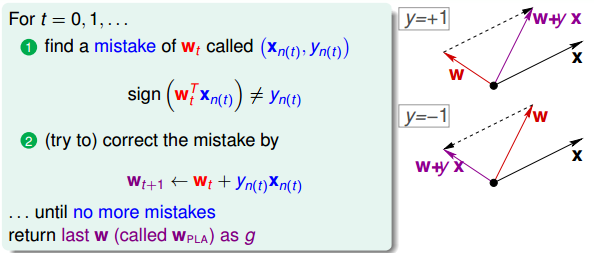

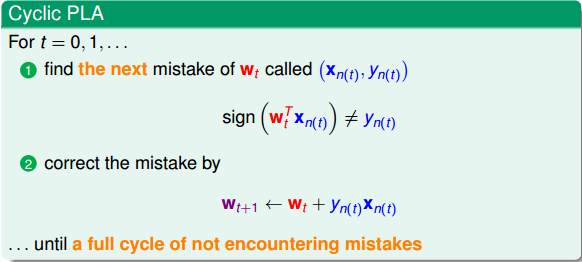

Perceptron Learning Algorithm(PLA)

PLA的思想就是首先在平面上随意取一条直线,看看哪些点分类错误。然后开始对第一个错误点就行修正,即变换直线的位置,使这个错误点变成分类正确的点。接着,再对第二个、第三个等所有的错误分类点就行直线纠正,直到所有的点都完全分类正确了,就得到了最好的直线。

下面介绍一下PLA是怎么做的。首先随机选择一条直线进行分类。然后找到第一个分类错误的点,如果这个点表示正类,被误分为负类,即 <0,那表示w和x夹角大于90度,其中w是直线的法向量。所以,x被误分在直线的下侧(相对于法向量,法向量的方向即为正类所在的一侧),修正的方法就是使w和x夹角小于90度。通常做法是w w+yx, y=1, 如图右上角所示,一次或多次更新后的w+yx与x夹角小于90度,能保证x位于直线的上侧,则对误分为负类的错误点完成了直线修正。

同理,如果是误分为正类的点,即 >0,那表示w和x夹角小于90度,其中w是直线的法向量。所以,x被误分在直线的上侧,修正的方法就是使w和x夹角大于90度。通常做法是w$\leftarrow $w+yx,y=-1,如图右下角所示,一次或多次更新后的w+yx与x夹角大于90度,能保证x位于直线的下侧,则对误分为正类的错误点也完成了直线修正。

按照这种思想,遇到个错误点就进行修正,不断迭代。

这种被称作Cyclic PLA。

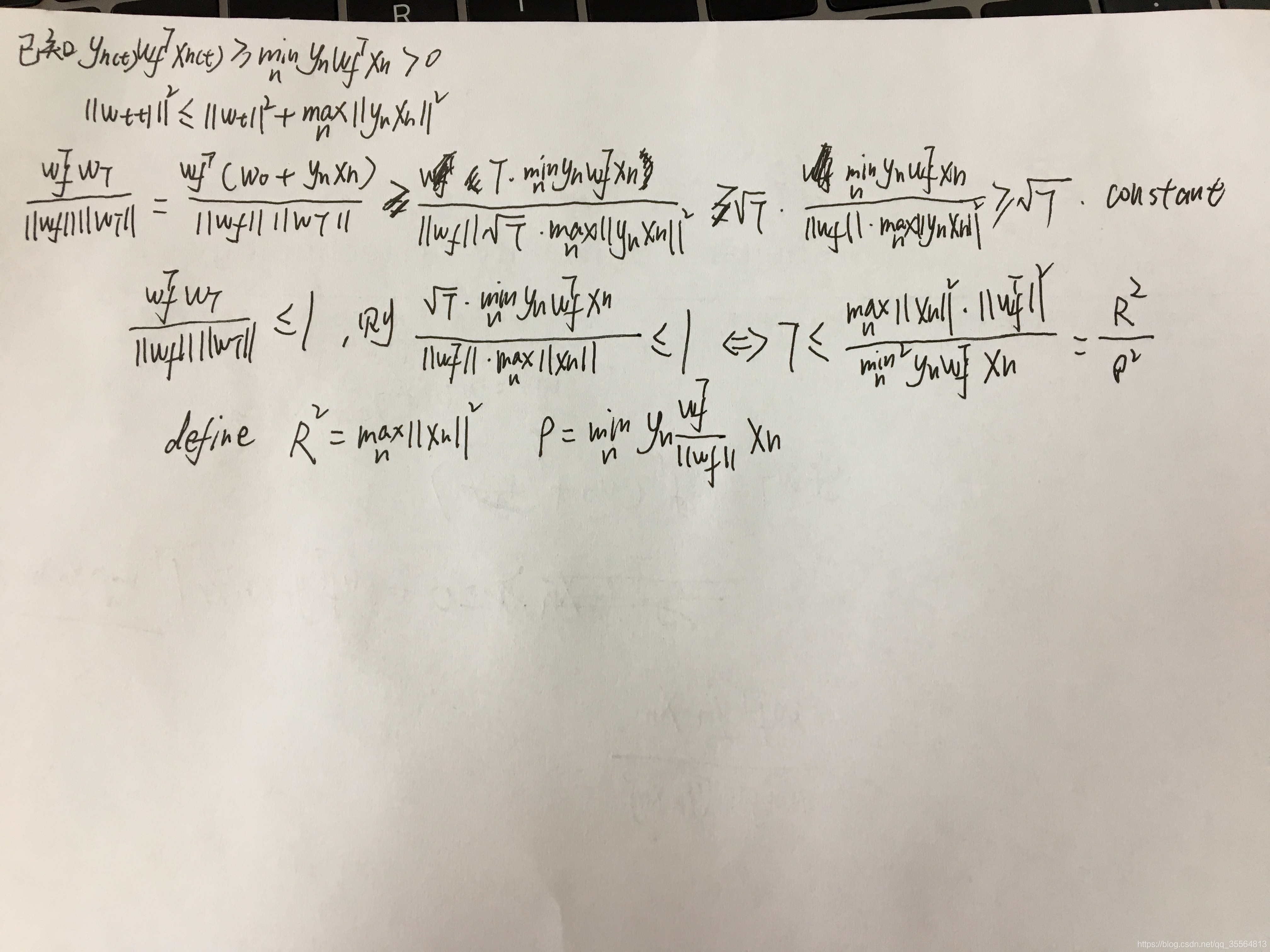

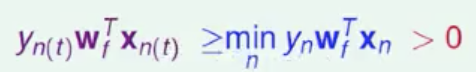

Guarantee of PLA

根据PLA的定义,当找到一条直线,能将所有平面上的点都分类正确,那么PLA就停止了。要达到这个终止条件,就必须保证D是线性可分(linear separable)。如果是非线性可分的,那么,PLA就不会停止。

如果是线性可分的的话,就一定存在一个完美的

使

=sign(

),那么一定满足以下条件:

PLA会对每次错误的点进行修正,更新权重

的值,如果

与

越来越接近,数学运算上就是内积越大,那表示

是在接近目标权重

,证明PLA是有学习效果的。所以,我们来计算

与

的内积:

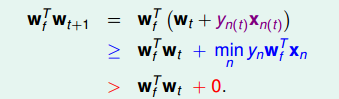

这么看貌似两个向量越来越来接近了,但是内积更大,可能是向量长度更大了,不一定是向量间角度更小。所以我们还需要证明 与 向量长度的关系:

wt只会在分类错误的情况下更新,最终得到的 相比 的增量值不超过max 。

假设初始权值 =0,那么经过T次错误修正后,有如下结论:

证明的步骤如下:

那么根据以上结论随着错误修正次数不断增加那么,上述等式左边部分的值应该也是不断增加的,因为等式右边是与T正相关的。但又因为等式左边是两个单位向量的内积,因此可以知道随着错误不断修正,上述两个向量应该是角度不断变小,直至趋近于1.又因为两个向量相乘是小于等于1的,所以可以得出T的次数也是有限的。

Non-Separable Data

所有上述的结论都是基于假设线性可分的,但是其实我们在使用PLA之前是不知道 ,那么如果不知道 其实我们是不知道它何时会停,如果我们知道了 那么其实我们也没有必要使用PLA。

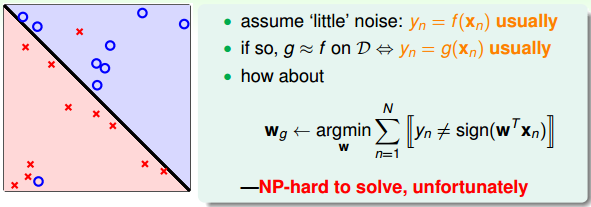

在非线性情况下,我们可以把条件放松,即不苛求每个点都分类正确,而是容忍有错误点,取错误点的个数最少时的权重w:

事实证明,上面的解是NP-hard问题,难以求解。然而,我们可以对在线性可分类型中表现很好的PLA做个修改,把它应用到非线性可分类型中,获得近似最好的g。

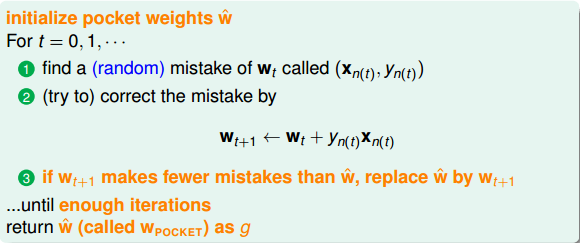

修改后的PLA称为Pocket Algorithm。它的算法流程与PLA基本类似,首先初始化权重 ,计算出在这条初始化的直线中,分类错误点的个数。然后对错误点进行修正,更新w,得到一条新的直线,在计算其对应的分类错误的点的个数,并与之前错误点个数比较,取个数较小的直线作为我们当前选择的分类直线。之后,再经过n次迭代,不断比较当前分类错误点个数与之前最少的错误点个数比较,选择最小的值保存。直到迭代次数完成后,选取个数最少的直线对应的w,即为我们最终想要得到的权重值。

一般来说Pocket Algorithm是要比PLA速度慢一些,因为这个PA还要进行计数也要记录w的同时还要考虑是否要取代该w。

总结

本节课主要介绍了线性感知机模型,以及解决这类感知机分类问题的简单算法:PLA。我们详细证明了对于线性可分问题,PLA可以停下来并实现完全正确分类。对于不是线性可分的问题,可以使用PLA的修正算法Pocket Algorithm来解决。