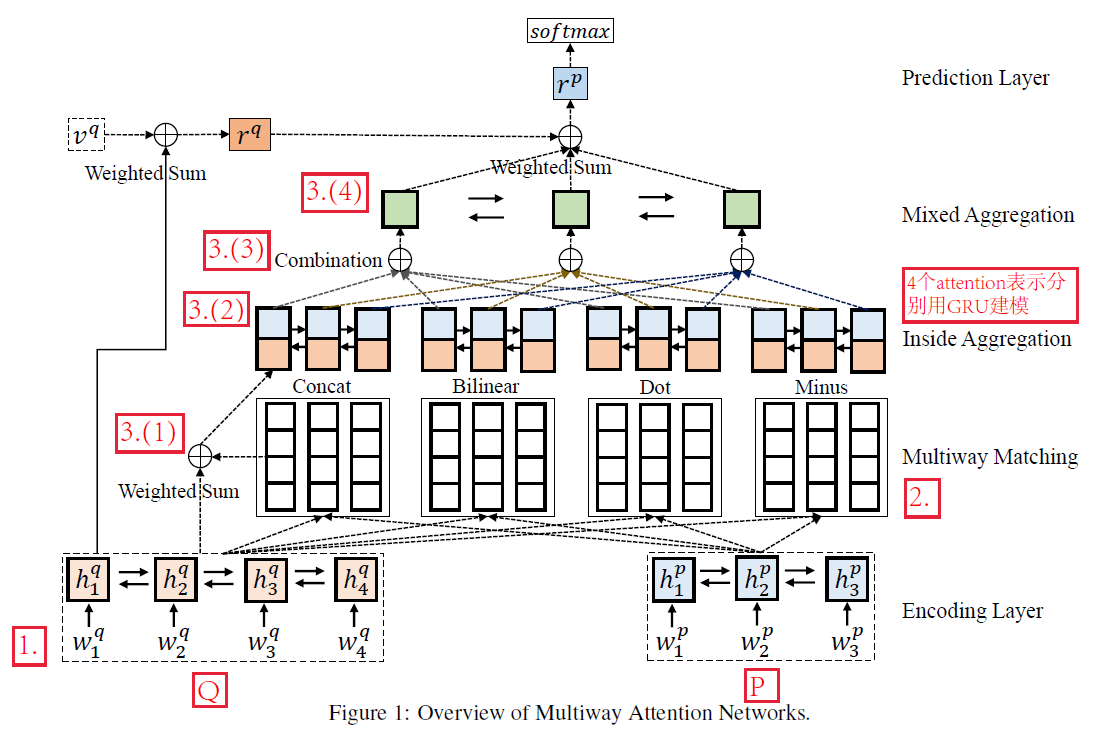

Multiway Attention Networks for Modeling Sentence Pairs

模型架构:

总体思想:

将query信息通过不同形式的attention加入到answer中,对answer进行query感知的建模,从而进行预测

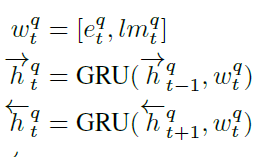

1.数据输入

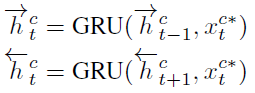

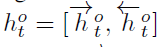

使用word embedding和language model表示的contextual embedding拼接表示,使用双向GRU对句子进行建模

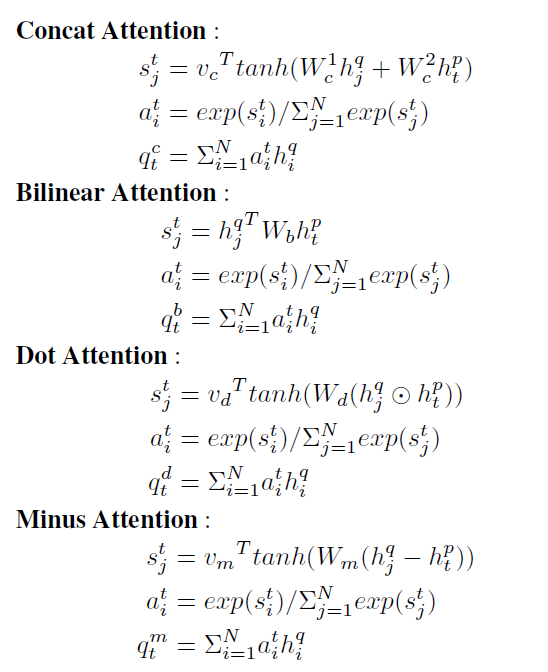

2.相似度计算

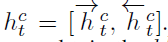

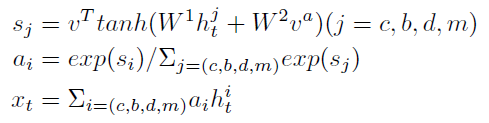

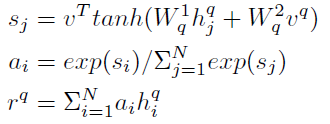

以上标c,b,d,m表示两个句子P和Q的双向GRU表示之间进行四种相似度计算,并且作为4种attention对于 Q 进行带权重的表示

3.聚合(Aggregation)

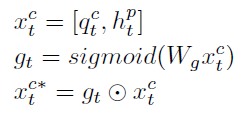

(1)拼接Q 的combination attention表示

与P 在 t 时刻的隐状态

(常规attention形式)

通过gate机制,进行信息筛选

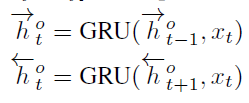

(2)而后使用GRU进行序列的再次表示

即对上面拼接后的向量,再一次用GRU进行表示,四个attention有四种这样的表示

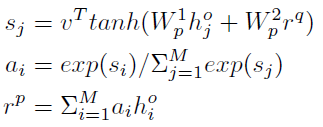

(3)再一次使用attention,进行四种attention带权重的组合,

为参数(这个有点不懂)

(4)整合后的表示,再一次使用GRU进行建模

4.预测层

(1)对 Q 进行一个注意力再表示,引入参数

(2)对 Q 的表示与 P 的表示进行attention

最后将

送入MLP