该文提出了一个基于注意力模型的递归循环神经网络模型(R2AM),解决在在无字典约束的条件下,对自然场景文字进行识别.提出的模型主要有以下几个优点:(1)采用了循环的CNN网络,可以更加有效和准确地提取图像特征;(2)在一个隐式的字符级别识别模型中嵌入一个RNN网络可以避免去使用N-元分析法;(3)采用软注意力机制可以允许模型选择性的利用特征,并且运行采用标准的BP算法进行端到端的训练。

该文设计的基于注意力机制的循环神经网络模型系统可以直接的处理图像然后输出单词字符串,极大地改善了【17】的工作。这里主要三个贡献:

(1)在同样规模的参数下,RNN因为是参数共享,因此相比CNN可以更加有效地进行特征提取。

(2 )RNNs)在上述递归CNN提取的图像特征之上,以执行字符级语言模型的隐式学习。RNN可以从训练数据中自动学习字符串中自然存在的字符的连续动态特性,而无需从字典中手动定义N-gram。

(3)一个基于注意力的序列建模机制,这个机制可以在读取字符序列时执行“软”确定性图像特征选择,并且可以通过标准的BP算法进行端对端的训练。

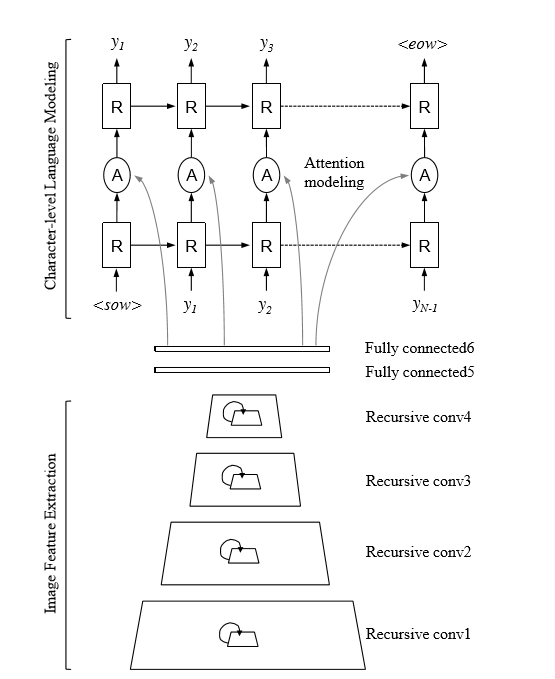

图1:使用注意力建模(R2AM)方法的递归循环网络:模型首先通过递归卷积图层传递输入图像以提取编码后的图像特征,然后使用隐式学习的字符级语言统计信息对循环神经网络进行解码以输出字符。 基于注意力的机制执行软特征选择以获得更好的图像特征使用。

全文主要分析了三点:循环CNN进行特征提取,采用RNN进行语言建模,采用了注意力机制

1 循环CNN进行特征提前:为了获得更好的上下文信息,可以增加卷积核大小,或者增加网络深度,但是这种方法会导致参数增加,计算复杂度变大,因此考虑采用循环CNN进行特征提取(类似RNN的权重共享),在控制参数规模的情况下,可以增加了传统CNNs的深度,同时也比CNNs产生更加紧凑的特征响应。

2 采用RNN进行语言建模,文中使用RNNs(recurrent neural networks)来对文本字符级统计进行建模,因为RNN在处理序列数据方面效果很好,例如机器翻译,语音识别,手写字识别等,这里作者认为识别图像中的字符可以基本上被认为是解决从像素强度到自然字符级矢量的顺序动态和学习映射的任务。

3 采用注意力机制模型:视觉注意力机制是人类视觉所特有的大脑信号处理机制。人类视觉通过快速扫描全局图像,获得需要重点关注的目标区域,也就是一般所说的注意力焦点,而后对这一区域投入更多注意力资源,以获取更多所需要关注目标的细节信息,而抑制其他无用信息。关于图像字符序列识别,有部分研究者采用CTC进行字符解码,这里作者采用注意力模型,因为注意力机制相当于给输入特征赋予不同的权重,因此每一个输入节点对应的输入并不是一样的,这样可以有选择性的处理输入特征更加符合人的视觉感知。

该文章提出了一个新的无词典照片OCR框架,该框架结合了用于图像编码的递归CNN,用于语言建模的RNN以及用于更好的图像特征使用的基于注意的机制。大量分析显示了每个提议组件的有效性,以相同的方法对约束和未受约束的场景进行了概括性,以及所提出的方法使用最新结果识别真实世界场景文本的实际能力。

【17】 M. Jaderberg, K. Simonyan, A. Vedaldi, and A. Zisserman. Deep structured output learning for unconstrained text recognition. In ICLR, 2015. 1, 2, 4, 6, 7, 8, 10