目录

原文链接:https://arxiv.org/pdf/2101.00816.pdf

标题翻译:基于方面的情感分析的联合训练Dual-MRC框架

原文链接:https://arxiv.org/pdf/2101.00816.pdf

摘要

基于方面的情感分析包括三个基本子任务:方面词提取、观点词提取和方面级情感分类。早期的工作只专注于单独解决这些子任务中的一个。最近的一些工作集中在解决两个子任务的组合,例如,提取方面项和情感极性,或者明智地提取方面项和意见项。最近,人们提出了三元提取任务,即从句子中提取三元组(方面项、观点项、情感极性)。然而,以往的方法无法在统一的端到端框架中解决所有子任务。在本文中,我们提出了一个完整的ABSA解决方案。我们构造了两个机器阅读理解(MRC)问题,并通过联合训练两个参数共享的BERT-MRC模型来解决所有子任务。我们在这些子任务上进行了实验,在几个基准数据集上的结果证明了我们提出的框架的有效性,它大大优于现有的最先进的方法。

引言

基于方面的情感分析(ABSA)是自然语言处理中的一个重要研究领域。考虑图1中的例子,在句子“The ambience was nice, but the service was not so great”方面术语(AT)是“ambience/service”,意见术语(OT)是“nice/not so great”。传统的情感分类有三个基本子任务:方面词提取、意见词提取和方面级情感分类。近年来的研究工作旨在将两个子任务相结合,并取得了很大的进展。例如,它们提取(AT, OT)对,或提取具有相应情感极性(SP)的AT。最近,一些旨在用统一的框架在ABSA中完成所有相关子任务的工作引起了人们越来越多的兴趣。

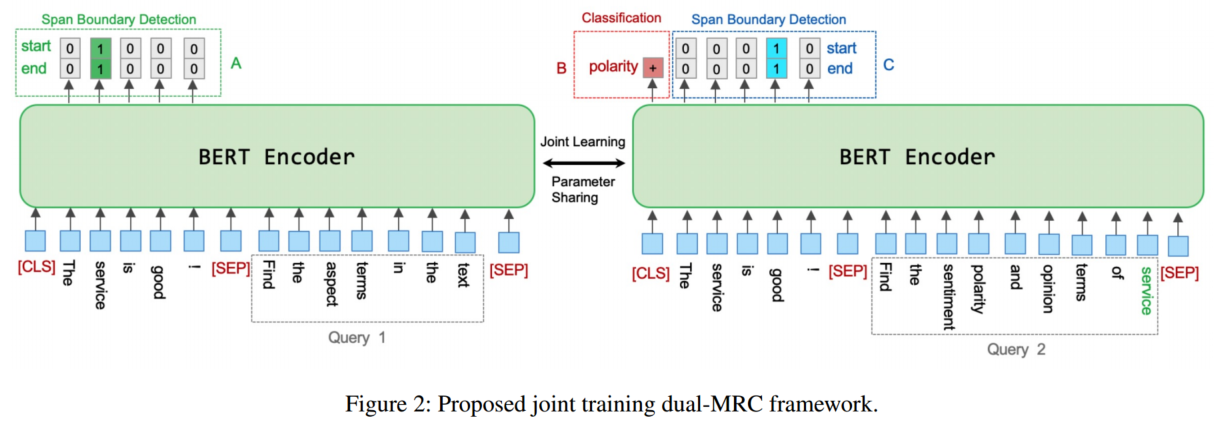

为方便起见,我们假设ABSA子任务的缩写如下,如图1所示:

![]()

我们主要关注三元提取任务(a,o,s),因为它是所有ABSA子任务中最难的。彭等人(2020)提出了提取(AT, OT, SP)三元组的统一框架。然而,由于它的框架有两个阶段,并且必须训练三个独立的模型,因此计算效率很低。

在本文中,我们提出了一个联合训练框架,在一个模型中处理所有ABSA子任务(如图1所示)。我们使用BERT (Devlin et al 2019)作为骨干网络,并使用基于跨度的模型来检测句子中AT/OT的开始/结束位置。基于跨度的方法在提取任务方面优于传统的基于序列标记的方法(Hu et al 2019)。

遵循其思想,采用了一种基于非最大抑制算法(NMS)的启发式多跨译码算法(Rosenfeld and Thurston 1971)。

我们将原来的三重抽取任务转化为两个机器阅读理解问题。如果使用预训练的BERT模型,则已知MRC方法是有效的。原因可能是BERT通常用下一句预测进行预训练,以捕获成对的句子关系。从理论上讲,三元提取任务可以分解为AE、AOE和SC子任务。因此,我们使用左侧MRC处理AE,使用右侧MRC处理AOE和SC。我们在本文中的主要贡献如下:

•我们展示了三重提取任务可以与三个目标联合训练。

•我们提出了一个dual-MRC框架,可以处理ABSA中的所有子任务(如表1所示)。

•我们在这些任务上进行实验,比较我们提出的框架。实验结果表明,该方法优于现有方法。

相关工作

基于方面的情感分析(ABSA)自(Hu and Liu 2004)首次提出以来,得到了广泛的研究。在本节中,我们根据相关的子任务介绍了关于ABSA的现有工作。

SC:近年来,人们提出了各种神经模型来完成这一任务。这些作品的核心思想是通过设计CNN等各种神经架构来捕捉一个方面与其上下文之间的复杂关系(Huang and Carley 2018; Li et al 2018a), RNN (Tang et al 2016;Zhang, Zhang, and Vo 2016; Ruder, Ghaffari,和Breslin 2016),基于注意力的网络(Ma等人2017;Du et al 2019;Wang et al 2016;Gu等2018;Yang等人2017),记忆网络(Tang, Qin, and Liu 2016;Chen et al 2017;Fan et al 2018)。Sun, Huang和Qiu(2019)将SC转换为BERT句子对分类任务,实现了该任务的最先进结果。

AE:AE作为句子的前置任务,旨在识别句子中的所有方面术语(Hu and Liu 2004;Pontiki等人2014),通常被视为序列标记问题(Li et al 2018b;Xu等2018;He et al 2017)。此外,(Ma et al 2019)和(Li et al 2020)将AE定义为sequence-to-sequence的学习任务,也取得了令人印象深刻的结果。

AESC:为了使AESC能够满足实际应用的需要,前人大量的工作都致力于同时解决AE和SC问题。简单地以pipeline的方式合并AE和SC将导致错误传播问题(Ma, Li, and Wang 2018)。一些工作(Li et al 2019a,b)尝试基于统一的标记方案,通过序列标记联合提取方面并预测相应的情感极性。然而,由于候选标签的组合性,这些方法是低效的(Lee等2016年),可能会遇到情绪不一致的问题。Zhou et al(2019)和Hu et al(2019)利用基于span的方法在span级别而不是token级别进行AE和SC,能够克服情感不一致的问题。值得注意的是,在这些作品中,意见术语的信息没有得到充分利用。

OE:意见项提取(OE)被广泛用作提高AE性能的辅助任务(Yu, Jiang, and Xia 2019;Wang et al 2017;Wang和Pan 2018), SC (He et al 2019)或两者(Chen和Qian 2020)。但是这些作品中所提取的ATs和OTs并不是成对的,因此不能提供某一方面相应极性的原因。

AOE:任务AOE (Fan et al 2019)已提出用于成对方面和意见项提取,其中方面项已提前给出。Fan等人(2019)为这项任务设计了一种方面融合的序列标记方法。Wu等人(2020)利用一种迁移学习方法,利用辅助数据集中的潜在意见知识来提高AOE的性能。

Pair:Zhao等人(2020)提出了Pair任务来从头提取方面-意见对,他们开发了一个基于跨度的多任务框架,该框架首先枚举所有候选跨度,然后构造两个分类器来识别跨度的类型(即方面或意见术语)以及跨度之间的关系。

Triple:Peng et al(2020)为ABSA定义了三重提取任务,旨在提取所有可能的方面术语及其相应的意见术语和情感极性。(Peng et al 2020)提出的方法是一个两阶段框架,第一阶段包含两个独立的模块,一个是AE和SC的统一序列标记模型,另一个是OE的图卷积神经网络(GCN)。在第二阶段,列举所有可能的方面-意见对,构造一个二元分类器来判断方面项和意见项是否匹配。我们的工作与(Peng et al2020)的主要区别是我们将所有子任务都视为一个问答问题,并基于单一模型提出了统一的框架。

提出的框架

三元提取联合训练

作者主要为了证明三元任务可以转换为三个子任务的联合训练

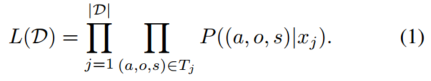

在本节中,我们将重点关注三元提取任务,其他子任务可以视为它的特殊情况。给定一个最大长度为n的句子xj。令Tj = {(a, o, s)}是给定的输入句子带注释的三元组的输出,其中s ∈ {Positive, Netural, Negative}, (a, o, s)指的是(aspect term, opinion term, sentiment polarity)。对于训练集D{(xj, Tj)}, 我们想要最大化概率:

定义,

![]()

考虑xj的对数似然,

最后一个方程成立,因为在给出句子xj和方面项a的情况下,意见项o和情感极性s是条件独立的。

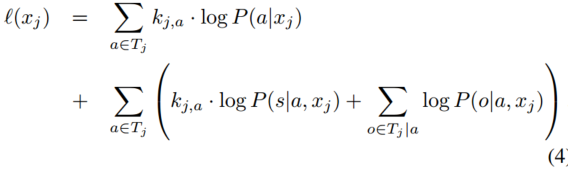

我们将上面的方程对xj∈D求和,并对两边归一化,然后我们得到下面形式的对数似然,

α, β, γ ∈ [0, 1]。第一项重复,以便与其他两项匹配。由(5)可知,三元提取任务Triple可以转化为AE、SC和AOE的联合训练。

Dual-MRC框架

现在我们要提出我们的联合训练dual-MRC框架。如图2所示,我们的模型由两部分组成。这两个部分都使用BERT (Devlin et al 2019)作为骨干模型来编码上下文信息。回想一下BERT是一个基于多层双向Transformer的语言表示模型。设n表示句子长度,d表示隐藏维数。假设所有标记的最后一层输出为用于提取,其中l/R表示左/右部分,s/e表示开始/结束令牌。假设BERT在[CLS]令牌处的输出是

,用于分类。

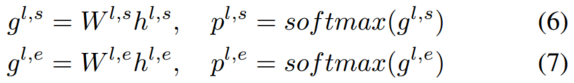

左边部分的目标是从给定的文本中提取所有at,即任务AE。正如我们前面讨论的,基于span的方法已被证明对提取任务是有效的。我们遵循(Hu et al 2019)中的思想,对于左侧部分,我们获得了开始/结束位置的对数和概率。

MRC数据集转换

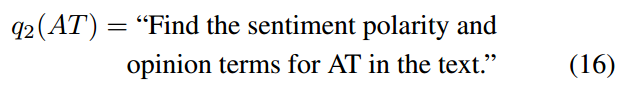

如图3所示,在将原始三重注释输入联合训练dual-MRC模型之前,必须对其进行转换。两个MRC都使用输入句子作为上下文。左边的MRC是用查询构造的。

![]()

然后左边的MRC的答案是从文本中得到所有的ATs。给定一个AT,右边MRC是由查询构造的。

右边MRC的输出是所有OT和相对于给定AT的情绪极性。一个重要的问题是,右侧MRC的数量等于AT的数量,因此,左侧MRC重复的次数是相同的。

推理过程

对于Triple,我们想指出训练过程和推理过程之间的一些区别。在训练过程中,已知所有AT的ground truth,可以根据这些AT构建正确的MRC。因此,训练过程是端到端的。然而,在推理过程中,AT是左MRC的输出。

因此,我们在一个pipeline中推断两个mrc,如算法1所示。

其他任务的推理过程类似。任务AE使用来自左侧MRC的span输出。AOE和SC使用来自右侧MRC的跨度和分类输出。AESC和Pair使用它们的组合。详情请参阅表1。

实验

数据集

原始数据集来自Semeval Challenges(Pontiki et al 2014, 2015, 2016),其中标记了AT和相应的情绪极性。我们在三个公共数据集上评估我们的框架。

第一个数据集来自(Wang et al 2017),其中意见术语的标签是注释的。所有数据集共享固定的训练/测试分割。第二个数据集来自(Fan et al 2019),其中标记(AT, OT)对。第三个数据集来自(Peng et al 2020),其中标记了(AT, OT, SP)三元组。对少部分ATs和OTs重叠的样本进行了校正。另外,从训练集中随机选择20%的数据作为验证集。有关数据集的详细统计,请参阅原始论文。

子任务和基线

在ABSA中有三条研究线,每条研究线都有不同的数据标注、ABSA子任务、基线和实验设置。为了公平地将我们提出的框架与以前的基线进行比较,我们应该为每条研究线明确地指定它们。

使用(Wang et al 2017)的数据集,对AE、OE、SC和AESC进行了以下基线评估:

SPAN-BERT(Hu et al 2019)是AESC的一种管道方法,将BERT作为骨干网络。AE使用跨度边界检测模块,然后使用基于SC跨度表示的极性分类器。

IMN-BERT(He等人,2019)是以BERT为骨干的IMN(He et al,2019)的扩展。IMN是一种涉及AE和SC联合训练的多任务学习方法。在IMN中引入了一种消息传递架构,以提高AESC的性能。

RACL-BERT(Chen和Qian 2020)是一种基于BERT编码器的堆叠多层网络,是AESC的最先进方法。RACL中使用关系传播机制来捕获子任务(即AE、OE、SC)之间的交互。

使用(Fan et al 2019)的数据集,对AOE的以下基线进行了评估:

IOG(Fan et al 2019)是第一个提出的解决AOE的模型,它采用六种不同的BLSTM来提取预先给出的方面的相应意见项。

LOTN(Wu et al 2020)是AOE的最新方法,它从外部情绪分类数据集中转移潜在的意见信息,以提高性能。

使用(Peng等人2020)的数据集,对AESC、Pair和Triple的以下基线进行了评估:

RINANTE(Dai和Song 2019)是一种利用句子中单词的依赖关系的AE和OE的弱监督协同提取方法。

CMLA (Wang et al. 2017) is a multilayer attention network for AE and OE, where each layer consists of a couple of attentions with tensor operators.

Li-unified-R(Peng et al 2020)是Li-unified(Li et al 2019a)的一种改良变体,最初是通过统一标签方案用于AESC的。Li-unified-R仅将原始OE模块用于意见术语提取。

Peng-two-stage(Peng et al 2020)是一个两阶段框架,具有ABSA中不同子任务的单独模型,是Triple的最先进方法。

模型设置

根据基线,我们使用BERT-Base-Uncased或BERT-Large Unbased作为我们提出的模型的骨干模型。有关BERT的模型详细信息,请参阅(Devlin等人,2019)。我们使用学习率为2e−5的Adam优化器,并在前10%的步骤中进行热身,以训练3个时期。批量大小为12,并且使用0:1的丢弃概率。超参数α; β; γ;方程14中最终联合训练损失的γ对结果不敏感,因此我们在实验中将其固定为1/3。启发式多跨度解码算法(Hu et al 2019)的logit阈值对结果非常敏感,并且在每个数据集上手动调整,其他超参数保持默认。所有实验都是在一个Tesla-V100 GPU上进行的。

评估指标

对于我们实验中的所有任务,我们使用精度(P)、召回率(R)和F1分数作为评估指标,因为如果预测项与黄金项完全匹配,那么它是正确的。

主要结果

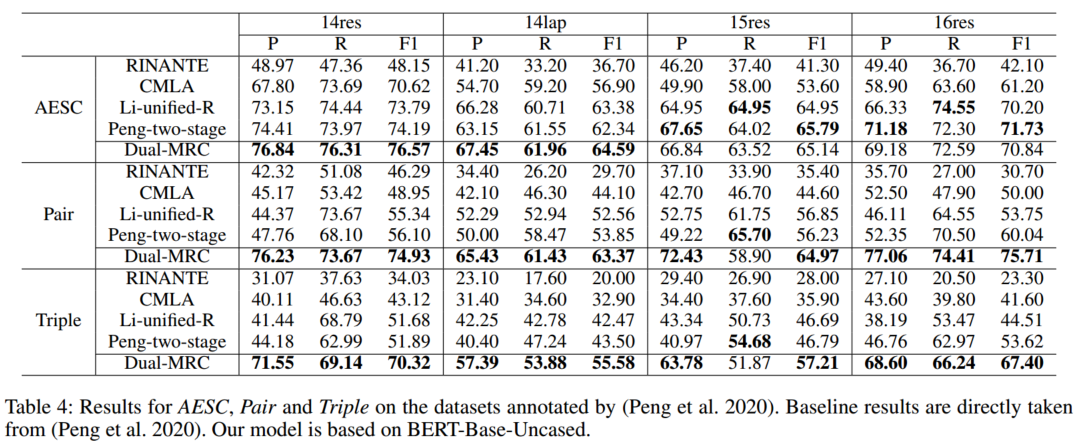

如前所述,有三条研究线,具有不同的数据集、ABSA子任务、基线和实验设置。对于每条研究线,我们保持相同的数据集和实验设置,并将我们提出的双MRC框架与基线进行比较,并在表2、表3和表4中给出我们的结果。

首先,我们在(Wang et al 2017)的数据集上比较了我们提出的AE、SC和AESC方法。OE不适用于我们提出的框架7。由于(AT,OT)的成对关系在该数据集中没有注释,因此我们仅使用模型的右侧部分进行分类。从训练集中随机选择20%的数据作为验证集。结果是随机初始化5次运行的平均分数,如表2所示。我们采用BERT Large Unbased作为我们的主干模型,因为基线也使用它。所有的基线都是基于BERT的,与之相比,我们的结果达到了第一或第二位。回想一下,我们的方法受到SPAN-BERT的启发,这是提取任务的一个强大基线。我们在AE中的结果接近SPAN-BERT。然而,在MRC的帮助下,我们在SC和AESC中取得了更好的结果。

其次,我们在(Fan et al 2019)的数据集上比较了我们提出的AOE方法,其中对成对(AT,OT)关系进行了注释。这个任务可以看作是我们提出的完整模型的一个微不足道的例子。结果如表3所示。BERT Base Unbased被用作我们的主干模型。

尽管16res的结果比LOTN低一点,但我们的大多数结果都显著优于之前的基线。这表明我们的模型在匹配AT和OT方面具有优势。特别是,我们的模型在lap14上的性能比基线要好得多。这可能是由于笔记本电脑(14lap)评论和餐厅评论(14res/15res/16res)之间的域差异。

第三,我们在来自(Peng et al 2020)的数据集上比较了我们提出的AESC、Pair和Triple方法。我们提出的框架的完整模型已经实现。结果如表4所示。BERT Base Unbased被用作我们的主干模型。我们的结果显著优于基线,尤其是在提取成对(AT,OT)关系的精度分数方面。请注意,Li unifiedR和Peng两个阶段都使用统一的标记模式。对于提取任务,基于跨度的方法在提取术语方面优于统一标记模式,这可能是因为确定开始/结束位置比确定每个标记的标签更容易。更准确地说,对于统一标记模式,每个令牌至少有7个可能的选择,例如{B-POS、B-NEU、B-NEG、I-POS、I-NEU、I-NEG、O},因此总共有个选择。对于基于跨度的方法,每个令牌至少有4个可能的选择,例如{IS-START、NOT-START、IS-END、NOT-END},然后总共有

个选择。我们提出的方法结合了MRC和基于跨度的提取,并且对Pair和Triple有了巨大的改进。

联合学习分析

我们对联合学习的有效性进行了一些分析。来自(Peng et al2020)如表6所示。总体而言,从实验结果来看,增加一个或两个学习目标对F-1分数没有太大影响。然而,联合学习更有效,它可以用一个单一的模型处理更多的任务。

对于AESC任务,我们比较了有或没有来自模型右侧部分的基于跨度的提取输出的结果。通过联合学习提取给定方面的意见项,方面级情感分类的结果得到了一点改进。这是有意义的,因为提取的OT对于识别给定AT的情绪极性是有用的。

对于任务对,我们比较了有或没有来自模型右侧部分的分类输出的结果。当添加情绪分类目标时,OT提取的F-1分数会略有下降。原因可能是情绪极性可能指向一句话中的多个OT,其中一些OT没有与给定的AT配对。

案例分析

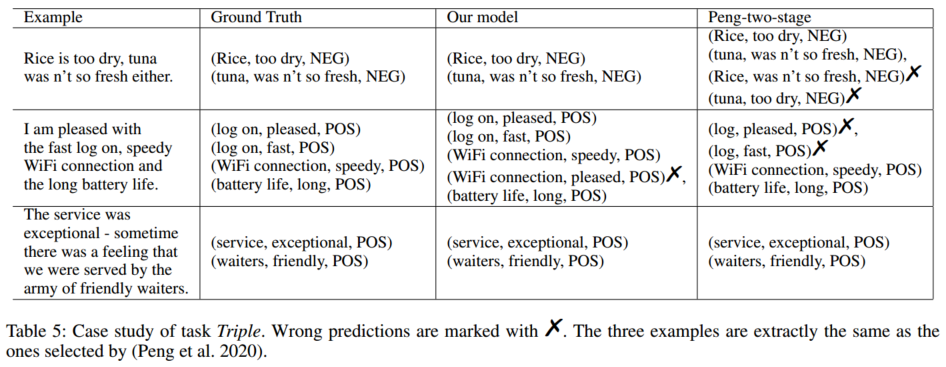

为了验证我们模型的有效性,我们基于基线中完全相同的三个例子(Peng et al 2020)比较了我们的方法,因为它的源代码不是公开的。结果如表5所示。

第一个例子表明,我们基于MRC的方法在匹配AT和OT方面表现更好。Peng的方法错误地匹配了“tuna”和“too dry”,而我们的方法将匹配问题转化为MRC问题。第二个例子表明,基于跨度的提取方法能够很好地检测实体的边界。我们的方法成功地检测到“log on”,而Peng的方法错误地检测到了“log”。此外,情绪分类结果表明,我们基于MRC的方法在SC方面也很好。

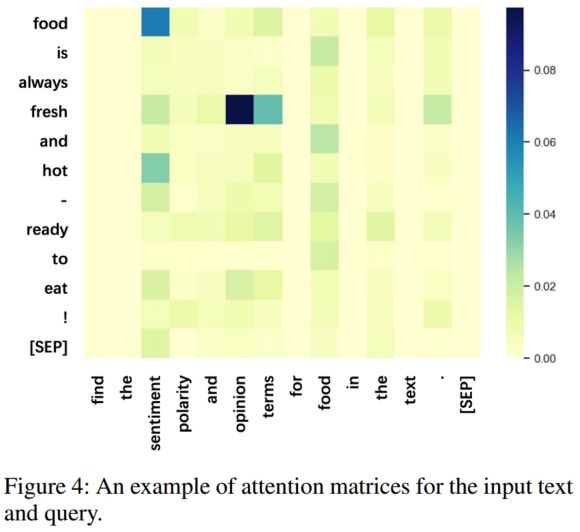

在图4中,我们在输入文本和查询之间绘制了来自微调模型的注意力矩阵。正如我们所看到的,“opinion term”与“fresh”的关注度得分很高,“sentiment”与“food/fresh/hot”的关注率得分很高。因此,查询可以通过自我关注来捕获任务的重要信息。

总结

在本文中,我们提出了一个联合训练双MRC框架来一次性处理基于方面的情绪分析(ABSA)的所有ABSA子任务,其中左MRC用于方面术语提取,右MRC用于面向方面的意见术语提取和情绪分类。将原始数据集转换并馈送到双MRC中以进行联合训练。对三条研究线进行了实验,并与不同的ABSA子任务和基线进行了比较。实验结果表明,我们提出的框架优于所有比较的基线。