【Re-ID】基于深度学习的Re-ID技术方法调研

参考学习资料

一、Re-ID方法分类

行人重识别(Person Re-identification)也称行人再识别,具体任务: 给定一个监控行人的图像, 检索跨设备下的该行人图像。

研究方法主要分为以下几个类别:

1、 基于表征学习的Re-ID方法

2、 基于度量学习的Re-ID方法

3、 基于局部特征的Re-ID方法

4、 基于视频序列的Re-ID方法

5、 基于GAN造图的Re-ID方法

1、表征学习(Representation learning)[1-4]:得到行人的特征表示(CNN / 属性),转化成 分类问题\ 验证问题

CNN可以根据任务需求自动提取出表征特征(Representation)

研究者把行人重识别问题看做分类(Classification/Identification)问题或者验证(Verification)问题:

(1)分类问题是指利用行人的ID或者属性等作为训练标签来训练模型;

(2)验证问题是指输入一对 (两张)行人图片,让网络来学习这两张图片是否属于同一个行人。

(1)论文[1]利用 Classification/Identification loss 和 verification loss 来训练网络,其网络示意图如下图所示。

网络输入为若干对行人图片,包括分类子网络(Classification Subnet)和验证子网络(Verification Subnet)。分类子网络对图片进行ID预测,根据预测的ID来计算分类误差损失。验证子网络融合两张图片的特征,判断这两张图片是否属于同一个行人,该子网络实质上等于一个二分类网络。经过足够数据的训练,再次输入一张测试图片,网络将自动提取出一个特征,这个特征用于行人重识别任务。

也有论文认为光靠行人的ID信息不足以学习出一个泛化能力足够强的模型。

行人属性标注: 在这些工作中,它们额外标注了行人图片的属性特征,例如性别、头发、衣着等属性。通过引入行人属性标签,模型不但要准确地预测出行人ID,还要预测出各项正确的行人属性,这大大增加了模型的泛化能力,多数论文也显示这种方法是有效的。

(2)下图是其中一个示例[2],从图中可以看出,网络输出的特征不仅用于预测行人的ID信息,还用于预测各项行人属性。通过结合ID损失和属性损失能够提高网络的泛化能力。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-vVsLD4dF-1684127926380)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514162938088.png)]](https://img-blog.csdnimg.cn/d3e1ebe69c954ec5ab2e2fe6e370913c.png)

如今依然有大量工作是基于表征学习,表征学习也成为了ReID领域的一个非常重要的baseline

优点:表征学习的方法比较鲁棒,训练比较稳定,结果也比较容易复现

缺点:容易在数据集的domain上过拟合(泛化差),并且当训练ID增加到一定程度的时候会显得比较乏力

2、 度量学习(Metric learning) : 度量相似度,使得相同行人图片的距离尽可能小、不同行人图片的距离尽可能大

- 对比损失(Contrastive loss)[5]

- 三元组损失(Triplet loss)[6-8]

- 四元组损失(Quadruplet loss)[9]

- 难样本采样三元组损失(Triplet hard loss with batch hard mining, TriHard loss)[10]

- 边界挖掘损失(Margin sample mining loss, MSML)[11]

首先,假如有两张输入图片I1和I2,通过网络的前馈我们可以得到它们归一化后的特征向量fI1和fI2,定义这两张图片特征向量的欧式距离为

d I 1 , I 2 = ∣ f I 1 − f I 2 ∣ d_{

{I_1},{I_2}}=\vert f_{I_1}-f_{I_2} \vert dI1,I2=∣fI1−fI2∣

(1) 对比损失(Contrastive loss)[5] : 相同行人的距离越来越小 + 不同行人的距离越来越大

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ec3FUfdL-1684127926380)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514170226087.png)]](https://img-blog.csdnimg.cn/eb6f4449510a423cbe5042cf0d807ab1.png)

对比损失用于训练孪生网络(Siamese network),其结构图如上图所示。孪生网络的输入为一对(两张)图片Ia和Ib。这两张图片可以为同一行人,也可以为不同行人。每一对训练图片都有一个标签y,其中y=1表示两张图片属于同一个行人(正样本对),反之y=0表示它们属于不同行人(负样本对)。之后,对比损失函数写作:

L c = y d I a , I b 2 + ( 1 − y ) ( α − d I a , I b ) + 2 L_c=yd^2_{

{

{I_a},{I_b}}}+(1-y)(\alpha-d_{

{

{I_a},{I_b}}})^2_+ Lc=ydIa,Ib2+(1−y)(α−dIa,Ib)+2

前者表示相同行人之间的距离,后者表示不同行人之间的距离。其中(Z)+表示Max(Z,0),α是根据实际需求设计的阈值参数。为了最小化损失函数,当网络输入一对正样本对,dIa,Ib会逐渐变小,即相同ID的行人图片会逐渐在特征空间形成聚类。反之,当网络输入一对负样本对时,dIa,Ib会逐渐变大会逐渐变大直到超过设定的α。通过最小化Lc最后可以使得正样本对之间的距离逐渐变小,负样本对之间的距离逐渐变大,从而满足行人重识别任务的需要。

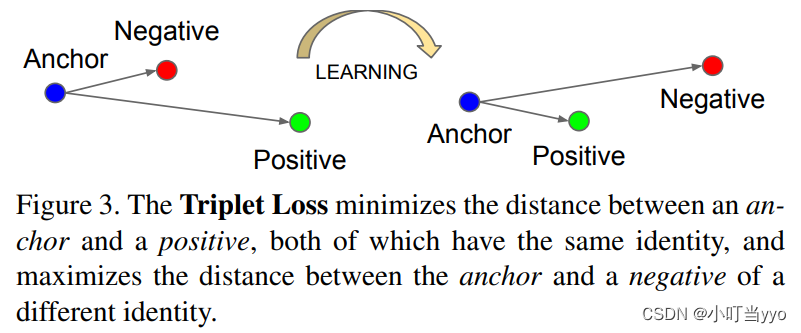

(2) 三元组损失(Triplet loss) :固定图片(Anchor) α,正样本图片(Positive)p 和 负样本图片(Negative)n:

三元组损失是一种被广泛应用的度量学习损失,之后的大量度量学习方法也是基于三元组损失演变而来。

三元组损失需要三张输入图片。和对比损失不同,一个输入的三元组(Triplet)包括一对正样本对和一对负样本对。

三张图片分别命名为固定图片(Anchor) α,正样本图片(Positive)p 和 负样本图片(Negative)n。

L t = ( d a , p − d a , n + α ) + L_t=(d_{a,p}-d_{a,n}+\alpha)_+ Lt=(da,p−da,n+α)+

其中(Z)+表示Max(Z,0),α是根据实际需求设计的阈值参数。

如下图所示,三元组可以拉近正样本对之间的距离,推开负样本对之间的距离,最后使得相同ID的行人图片在特征空间里形成聚类,达到行人重识别的目的。

论文[8]认为原版的Triplet loss只考虑正负样本对之间的相对距离,而并没有考虑正样本对之间的绝对距离,为此提出改进三元组损失(Improved triplet loss):

L i t = d a , p + ( d a , p − d a , n + α ) + L_it=d_{a,p}+(d_{a,p}-d_{a,n}+\alpha)_+ Lit=da,p+(da,p−da,n+α)+

公式添加da,p项,保证网络不仅能够在特征空间把正负样本推开,也能保证正样本对之间的距离很近。

(3) 四元组损失(Quadruplet loss): 增加了一个不同类别的负样本

四元组(Quadruplet)需要四张输入图片,和三元组不同的是多了一张负样本图片。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-8VgSE4cl-1684127926381)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514184315306.png)]](https://img-blog.csdnimg.cn/aa225e61c62d476384d25eeca17efdfb.png)

即四张图片为固定图片(Anchor)α ,正样本图片(Positive)p ,负样本图片1(Negative1)n1 和负样本图片2(Negative2)n2。其中n1 和 n2是两张不同行人ID的图片,其结构如上图所示。

四元组的损失为:

L q = ( d a , p − d a , n 1 + α ) + + ( d a , p − d n 1 , n 2 + β ) + L_q=(d_{a,p}-d_{a,n1}+\alpha)_++(d_{a,p}-d_{n1,n2}+\beta)_+ Lq=(da,p−da,n1+α)++(da,p−dn1,n2+β)+

该损失的第一项和triplet loss 相同,关注于正负样本对之间的相对距离,第二项是一个新的约束,考虑了正样本对与不同负样本对之间的相对距离(本质上强化了类间距离大于类内距离,而不管类间是正负类间还是负负类间)。通过这损失使得最小类间距离大于最大类内距离;由于第二项仅做为一个辅助项,因此它不应该主导训练过程,和第一项有着不等的重要性,作者采用了margin阈值来决定这两项的权重,具体为α>β。

注:gallery是候选行人库,probe是待查询输入,也叫查询图像(query)

(4) 难样本采样三元组损失(Triplet loss with batch hard mining, TriHard loss): 距离最远的正样本距离越来越小, 距离最近的负样本距离越来越大

传统的三元组随机从训练数据中抽样三张图片,这样的做法虽然比较简单,但是抽样出来的大部分都是简单易区分的样本对。如果大量训练的样本对都是简单的样本对,那么这是不利于网络学习到更好的表征。大量论文发现用更难的样本去训练网络能够提高网络的泛化能力,而采样难样本对的方法很多。

论文[10]提出了一种基于训练批量(Batch)的在线难样本采样方法——TriHard Loss。其核心思想是:对于每一个训练batch,随机挑选P个ID的行人,每个行人随机挑选K张不同的图片,即一个batch含有P x K张图片。之后对于batch中的每一张图片α ,我们可以挑选一个最难的正样本p和一个最难的负样本n和 α组成一个三元组。

首先我们定义和 α为相同ID的图片集为 A,剩下不同ID的图片图片集为B ,则TriHard损失表示为:

L t h = 1 P × K ∑ a ∈ b a t c h ( m a x p ∈ A d a , p − m i n n ∈ B d a , n + α ) + L_{th}=\frac{1}{P \times K}\sum_{a\in batch}(\mathop{max}\limits_{p\in A}d_{a,p}-\mathop{min}\limits_{n\in B}d_{a,n}+\alpha)_+ Lth=P×K1a∈batch∑(p∈Amaxda,p−n∈Bminda,n+α)+

α是根据实际需求设计的阈值参数。TriHard损失会计算α 和batch中的每一张图片在特征空间的欧式距离,然后选出与α 距离最远(最不像)的正样本 p 和距离最近(最像)的负样本 n 来计算三元组损失。通常TriHard损失效果比传统的三元组损失要好。

(5) 边界挖掘损失(Margin sample mining loss, MSML)

边界样本挖掘损失(MSML)是一种引入难样本采样思想的度量学习方法。三元组损失只考虑了正负样本对之间的相对距离。为了引入正负样本对之间的绝对距离,四元组损失加入额外的一张负样本组成了四元组。四元组损失定义为:

L q = ( d a , p − d a , n 1 + α ) + + ( d a , p − d n 1 , n 2 + β ) + L_q=(d_{a,p}-d_{a,n1}+\alpha)_++(d_{a,p}-d_{n1,n2}+\beta)_+ Lq=(da,p−da,n1+α)++(da,p−dn1,n2+β)+

假如我们忽视参数 α 和 β 的影响,我们可以用一种更加通用的形式表示四元组损失:

L q ′ = ( d a , p − d m , n + α ) + L_{q'}=(d_{a,p}-d_{m,n}+\alpha)_+ Lq′=(da,p−dm,n+α)+

其中m 和 n 是一对负样本对,m和a既可以是一对正样本对也可以是一对负样本对。之后把TriHard loss的难样本挖掘思想引入进来,便可以得到:

L m s m l = ( m a x a , p d a , p − m i n m , n d m , n + α ) + L_{msml}=(\mathop{max}\limits_{a,p}d_{a,p}-\mathop{min}\limits_{m,n}d_{m,n}+\alpha)_+ Lmsml=(a,pmaxda,p−m,nmindm,n+α)+

其中a,p,m,n均是batch中的图片,a,p 是batch中最不像的正样本对,m,n是batch 中最像的负样本对,a,m皆可以是正样本对也可以是负样本对。概括而言TriHard损失是针对batch中的每一张图片都挑选了一个三元组,而MSML损失只挑选出最难的一个正样本对和最难的一个负样本对计算损失。所以MSML是比TriHard更难的一种难样本采样。此外maxa,pda,p可以看作是正样本对距离的上界,minm,ndm,n可以看作是负样本对的下界。MSML是为了把正负样本对的边界给推开,因此命名为边界样本挖掘损失。

总的概括,MSML是同时兼顾相对距离和绝对距离并引入了难样本采样思想的度量学习方法。其演变思想如下图:

(个人理解 相对距离是Same Probe;绝对距离是Same or Different Probes)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-2bvAzvVl-1684127926382)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514195849772.png)]](https://img-blog.csdnimg.cn/783d1897969d4a2ca83afcdab2be0a9b.png)

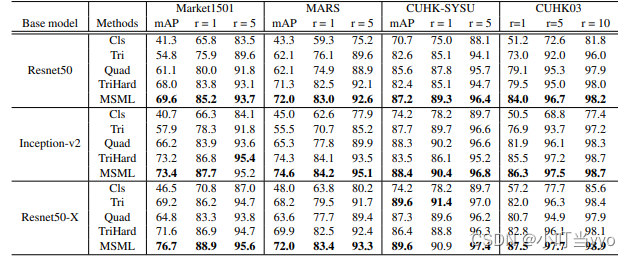

各种loss的性能对比

在论文[11]之中,对上面提到的主要损失函数在尽可能公平的实验的条件下进行性能对比,实验结果如下表所示。作为一个参考。

3、 基于局部特征的ReID方法

早期的ReID研究大家还主要关注点在全局的global feature上,就是用整图得到一个特征向量进行图像检索。但是后来大家逐渐发现全局特征遇到了瓶颈,于是开始渐渐研究起局部的local feature。常用的提取局部特征的思路主要有图像切块、利用骨架关键点定位以及姿态矫正等等。

1) 图片切块

图片切块是一种很常见的提取局部特征方式[12]。如下图所示,图片被垂直等分为若干份,因为垂直切割更符合我们对人体识别的直观感受,所以行人重识别领域很少用到水平切割。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-sHWY1kRE-1684127926382)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514200330128.png)]](https://img-blog.csdnimg.cn/bee1d1461e5649de8b94521836d1127e.png)

被分割好的若干块图像块(抽取的特征)按照顺序送到一个LSTM网络,最后的特征融合了所有图像块的局部特征。但是这种缺点在于对图像对齐的要求比较高,如果两幅图像没有上下对齐,那么很可能出现头和上身对比的现象,反而使得模型判断错误。

2) 骨架关键点定位

为了解决图像不对齐情况下手动图像切片失效的问题,一些论文利用一些先验知识先将行人进行对齐,这些先验知识主要是预训练的人体姿态(Pose)和骨架关键点(Skeleton) 模型。论文[13]先用姿态估计的模型估计出行人的关键点,然后用仿射变换使得相同的关键点对齐。

如下图所示,一个行人通常被分为14个关键点,这14个关键点把人体结果分为若干个区域。 为了提取不同尺度上的局部特征,作者设定了三个不同的PoseBox组合

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-L2sNpoG5-1684127926383)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514202350912.png)]](https://img-blog.csdnimg.cn/e3fefadd61e342c1836e3fb1c4b6a16c.png)

之后这三个PoseBox矫正后的图片和原始未矫正的图片一起送到网络里去提取特征,这个特征包含了全局信息和局部信息。

特别提出,这个仿射变换可以在进入网络之前的预处理中进行,也可以在输入到网络后进行。如果是后者的话需要需要对仿射变换做一个改进,因为传统的仿射变化是不可导的。为了使得网络可以训练,需要引入可导的近似放射变化,在本文中不赘述相关知识。

3)局部-全局融合

CVPR2017的工作Spindle Net[14]也利用了14个人体关键点来提取局部特征。和论文[12]不同的是,Spindle Net并没有用仿射变换来对齐局部图像区域,而是直接利用这些关键点来抠出感兴趣区域(Region of interest, ROI)。Spindle Net网络如下图所示,首先通过骨架关键点提取的网络提取14个人体关键点,之后利用这些关键点提取7个人体结构ROI。这7个ROI区域和原始图片进入同一个CNN网络提取特征。原始图片经过完整的CNN得到一个全局特征。之后这8个特征按照图示的方式在不同的尺度进行联结,最终得到一个融合全局特征和多个尺度局部特征的行人重识别特征。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-6FcASLW0-1684127926383)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514203224033.png)]](https://img-blog.csdnimg.cn/33b7b20ff07048bf85785ee78f6200c0.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-SdqViLIL-1684127926383)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514203448718.png)]](https://img-blog.csdnimg.cn/30ea5e482ac24ac3b12d9453da4a3236.png)

论文[15]提出了一种全局-局部对齐特征描述子(Global-Local-Alignment Descriptor, GLAD),来解决行人姿态变化的问题。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-hsHPtfJq-1684127926384)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514203851710.png)]](https://img-blog.csdnimg.cn/3e7f6c741c694ae59728d7717f830337.png)

与Spindle Net类似,GLAD利用提取的人体关键点把图片分为头部、上身和下身三个部分。之后将整图和三个局部图片一起输入到一个参数共享CNN网络中,最后提取的特征融合了全局和局部的特征。为了适应不同分辨率大小的图片输入,网络利用全局平均池化(Global average pooling, GAP)来提取各自的特征。和Spindle Net略微不同的是四个输入图片各自计算对应的损失,而不是融合为一个特征计算一个总的损失。

4)自动对齐局部特征

以上所有的局部特征对齐方法都需要一个额外的骨架关键点或者姿态估计的模型。而训练一个可以达到实用程度的模型需要收集足够多的训练数据,这个代价是非常大的。为了解决以上问题,AlignedReID[16]提出基于SP距离的自动对齐模型,在不需要额外信息的情况下来自动对齐局部特征。而采用的方法就是动态对齐算法,或者也叫最短路径距离。这个最短距离就是自动计算出的local distance。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-IycRrMft-1684127926384)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514204407157.png)]](https://img-blog.csdnimg.cn/03f96e9567314578ac1e6a9be910934c.png)

这个local distance可以和任何global distance的方法结合起来,论文[15]选择以TriHard loss作为baseline实验,最后整个网络的结构如下图所示

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-JiYWJHxv-1684127926384)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514204600082.png)]](https://img-blog.csdnimg.cn/15d2cbe51eb54e69832732287b4fb984.png)

4、 基于视频序列的ReID

目基于单帧图像的方法主要思想是利用CNN来提取图像的空间特征,而基于视频序列的方法主要思想是利用CNN 来提取空间特征(外观信息)的同时利用RNN来提取时序特征(帧与帧之间的运动信息)[17-24]。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-GoO46k9B-1684127926384)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514205648522.png)]](https://img-blog.csdnimg.cn/c602a7c37c994d4eb2bf17c8787e2b7c.png)

**上图是非常典型的思路,网络输入为图像序列。**每张图像都经过一个共享的CNN提取出图像空间内容特征,之后这些特征向量被输入到一个RNN网络去提取最终的特征。

最终的特征融合了单帧图像的外观特征和帧与帧之间的运动特征。

而这个特征用于代替前面单帧方法的图像特征来训练网络。

1)视频序列类的代表方法之一是累计运动背景网络(Accumulative motion context network, AMOC)[23]

AMOC 输入 的包括原始的图像序列和提取的光流序列 。通常提取光流信息需要用到传统的光流提取算法,但是这些算法计算耗时,并且无法与深度学习网络兼容。为了能够得到一个自动提取光流的网络,作者首先训练了一个运动信息网络(Motion network, Moti Nets)。这个运动网络输入为原始的图像序列,标签为传统方法提取的光流序列。如下图所示,原始的图像序列显示在第一排,提取的光流序列显示在第二排。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-smN428VV-1684127926385)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514210225806.png)]](https://img-blog.csdnimg.cn/9fefd6c543764403bef94c1238bafbd7.png)

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-ozt6DZbf-1684127926385)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514210042207.png)]](https://img-blog.csdnimg.cn/21d1c4de690649a9850285c671246496.png)

网络有三个光流预测的输出,分别为Pred1,Pred2,Pred3,这三个输出能够预测三个不同尺度的光流图。最后网络融合了三个尺度上的光流预测输出来得到最终光流图,预测的光流序列在第三排显示。通过最小化预测光流图和提取光流图的误差,网络能够提取出较准确的运动特征。

AMOC的核心思想在于网络除了要提取序列图像的特征,还要提取运动光流的运动特征,其网络结构图如下图所示。AMOC拥有空间信息网络(Spatial network, Spat Nets)和运动信息网络两个子网络。图像序列的每一帧图像都被输入到Spat Nets来提取图像的全局内容特征。而相邻的两帧将会送到Moti Nets来提取光流图特征。之后空间特征和光流特征融合后输入到一个RNN来提取时序特征。通过AMOC网络,每个图像序列都能被提取出一个融合了内容信息、运动信息的特征。网络采用了分类损失和对比损失来训练模型。融合了运动信息的序列图像特征能够提高行人重识别的准确度。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-72nSctcB-1684127926385)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514210550659.png)]](https://img-blog.csdnimg.cn/21b93e317beb47a38ba0804de8ced505.png)

1)论文[24](Region-based Quality Estimation Network, RQEN)从另外一个角度展示了多帧序列弥补单帧信息不足的作用

目前大部分video based ReID方法还是不管三七二十一的把序列信息输给网络,让网络去自己学有用的信息,并没有直观的去解释为什么多帧信息有用。而论文[24]则很明确地指出当单帧图像遇到遮挡等情况的时候,可以用多帧的其他信息来弥补,直接诱导网络去对图片进行一个质量判断,降低质量差的帧的重要度。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-B5mQC7Bx-1684127926386)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514210807419.png)]](https://img-blog.csdnimg.cn/35d721e3ab924126a60faa1bcbad8926.png)

如上图,文章认为在遮挡较严重的情况下,如果用一般的pooling会造成attention map变差,遮挡区域的特征会丢失很多。而利用论文的方法每帧进行一个质量判断,就可以着重考虑那些比较完整的几帧,使得attention map比较完整。而关键的实现就是利用一个pose estimation的网络,论文叫做landmark detector。 当landmark不完整的时候就证明存在遮挡,则图片质量就会变差。之后pose feature map和global feature map都同时输入到网络,让网络对每帧进行一个权重判断,给高质量帧打上高权重,然后对feature map进行一个线性叠加。思路比较简单但是还有道理的。

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-0OBgOICm-1684127926386)(C:\Users\Administrator\AppData\Roaming\Typora\typora-user-images\image-20230514211302973.png)]](https://img-blog.csdnimg.cn/dcf95831a9aa419d952b77c6bd422bef.png)

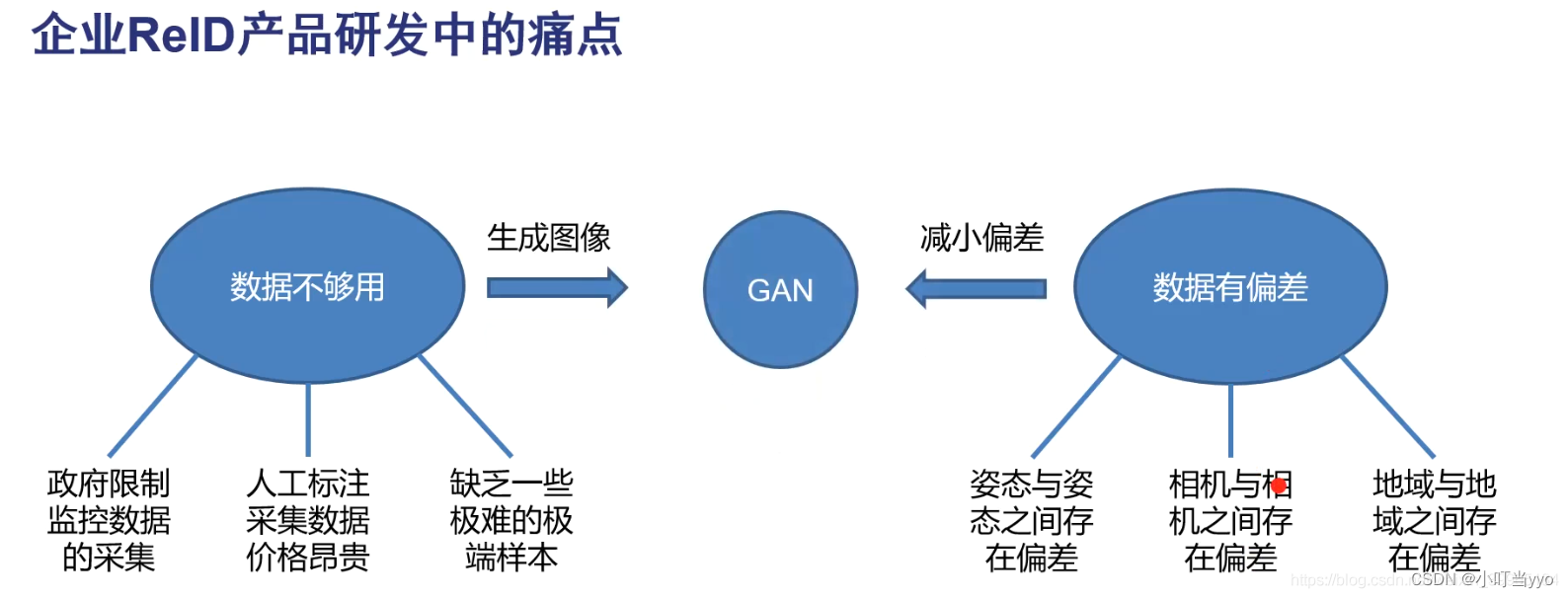

5、 基于GAN的ReID

ReID有一个非常大的问题就是数据获取困难,截止CVPR18 deadline截稿之前,最大的ReID数据集也就小几千个ID,几万张图片(序列假定只算一张)。因此在ICCV17 GAN做ReID挖了第一个坑之后,就有大量GAN的工作涌现,尤其是在CVPR18 deadline截稿之后arxiv出现了好几篇很好的paper。[25-28]

相当于生成了大量的高质量的样本量用于训练。具体这里不展开叙述了

总的来说,GAN都是为了从某个角度上解决ReID的困难(在某些困难的场景下样本量的不足导致难以训练work的网络,比如摄像头bias,数据集bias,姿态不同等),缺啥就让GAN来补啥,不得不说GAN还真是一个强大的东西。

参考文献

[1] Mengyue Geng, Yaowei Wang, Tao Xiang, Yonghong Tian. Deep transfer learning for person reidentification[J]. arXiv preprint arXiv:1611.05244, 2016.

[2] Yutian Lin, Liang Zheng, Zhedong Zheng, YuWu, Yi Yang. Improving person re-identification by attribute and identity learning[J]. arXiv preprint arXiv:1703.07220, 2017.

[3] Liang Zheng, Yi Yang, Alexander G Hauptmann. Person re-identification: Past, present and future[J]. arXiv preprint arXiv:1610.02984, 2016.

[4] Tetsu Matsukawa, Einoshin Suzuki. Person re-identification using cnn features learned from combination of attributes[C]//Pattern Recognition (ICPR), 2016 23rd International Conference on. IEEE, 2016:2428–2433.

[5] Rahul Rama Varior, Mrinal Haloi, Gang Wang. Gated siamese convolutional neural network architecture for human re-identification[C]//European Conference on Computer Vision. Springer, 2016:791-808.

[6] Florian Schroff, Dmitry Kalenichenko, James Philbin. Facenet: A unified embedding for face recognition and clustering[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2015:815-823.

[7] Hao Liu, Jiashi Feng, Meibin Qi, Jianguo Jiang, Shuicheng Yan. End-to-end comparative attention networks for person re-identification[J]. IEEE Transactions on Image Processing, 2017.

[8] De Cheng, Yihong Gong, Sanping Zhou, Jinjun Wang, Nanning Zheng. Person re-identification by multichannel parts-based cnn with improved triplet loss function[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016:1335-1344.

[9] Weihua Chen, Xiaotang Chen, Jianguo Zhang, Kaiqi Huang. Beyond triplet loss: a deep quadruplet network for person re-identification[J]. arXiv preprint arXiv:1704.01719, 2017.

[10] Alexander Hermans, Lucas Beyer, Bastian Leibe. In defense of the triplet loss for person reidentification[J]. arXiv preprint arXiv:1703.07737, 2017

[11] Xiao Q, Luo H, Zhang C. Margin Sample Mining Loss: A Deep Learning Based Method for Person Re-identification[J]. 2017.

[12] Rahul Rama Varior, Bing Shuai, Jiwen Lu, Dong Xu, Gang Wang. A siamese long short-term memory architecture for human re-identification[C]//European Conference on Computer Vision. Springer, 2016:135–153.

[13] Liang Zheng, Yujia Huang, Huchuan Lu, Yi Yang. Pose invariant embedding for deep person reidentification[J]. arXiv preprint arXiv:1701.07732, 2017.

[14] Haiyu Zhao, Maoqing Tian, Shuyang Sun, Jing Shao, Junjie Yan, Shuai Yi, Xiaogang Wang, Xiaoou Tang. Spindle net: Person re-identification with human body region guided feature decomposition and fusion[C]. CVPR, 2017.

[15] Longhui Wei, Shiliang Zhang, Hantao Yao, Wen Gao, Qi Tian. Glad: Global-local-alignment descriptor for pedestrian retrieval[J]. arXiv preprint arXiv:1709.04329, 2017.

[16] Zhang, X., Luo, H., Fan, X., Xiang, W., Sun, Y., Xiao, Q., … & Sun, J. (2017). AlignedReID: Surpassing Human-Level Performance in Person Re-Identification. arXiv preprint arXiv:1711.08184.

[17] Taiqing Wang, Shaogang Gong, Xiatian Zhu, Shengjin Wang. Person re-identification by discriminative selection in video ranking[J]. IEEE transactions on pattern analysis and machine intelligence, 2016.38(12):2501–2514.

[18] Dongyu Zhang, Wenxi Wu, Hui Cheng, Ruimao Zhang, Zhenjiang Dong, Zhaoquan Cai. Image-to-video person re-identification with temporally memorized similarity learning[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2017.

[19] Jinjie You, Ancong Wu, Xiang Li, Wei-Shi Zheng. Top-push video-based person reidentification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.2016:1345–1353.

[20] Xiaolong Ma, Xiatian Zhu, Shaogang Gong, Xudong Xie, Jianming Hu, Kin-Man Lam, Yisheng Zhong. Person re-identification by unsupervised video matching[J]. Pattern Recognition, 2017. 65:197–210.

[21] Niall McLaughlin, Jesus Martinez del Rincon, Paul Miller. Recurrent convolutional network for videobased person re-identification[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016:1325–1334.

[22] Rui Zhao, Wanli Oyang, Xiaogang Wang. Person re-identification by saliency learning[J]. IEEE transactions on pattern analysis and machine intelligence, 2017. 39(2):356–370.

[23] Hao Liu, Zequn Jie, Karlekar Jayashree, Meibin Qi, Jianguo Jiang, Shuicheng Yan, Jiashi Feng. Video based person re-identification with accumulative motion context[J]. arXiv preprint arXiv:1701.00193,2017.

[24] Song G, Leng B, Liu Y, et al. Region-based Quality Estimation Network for Large-scale Person Re-identification[J]. arXiv preprint arXiv:1711.08766, 2017.

[25] Zheng Z, Zheng L, Yang Y. Unlabeled samples generated by gan improve the person re-identification baseline in vitro[J]. arXiv preprint arXiv:1701.07717, 2017.

[26] Zhong Z, Zheng L, Zheng Z, et al. Camera Style Adaptation for Person Re-identification[J]. arXiv preprint arXiv:1711.10295, 2017.

[27] Wei L, Zhang S, Gao W, et al. Person Transfer GAN to Bridge Domain Gap for Person Re-Identification[J]. arXiv preprint arXiv:1711.08565, 2017.

preprint arXiv:1701.07717, 2017.

[26] Zhong Z, Zheng L, Zheng Z, et al. Camera Style Adaptation for Person Re-identification[J]. arXiv preprint arXiv:1711.10295, 2017.

[27] Wei L, Zhang S, Gao W, et al. Person Transfer GAN to Bridge Domain Gap for Person Re-Identification[J]. arXiv preprint arXiv:1711.08565, 2017.

[28] Qian X, Fu Y, Wang W, et al. Pose-Normalized Image Generation for Person Re-identification[J]. arXiv preprint arXiv:1712.02225, 2017.