论文标题

Deep High-Resolution Representation Learning for Human Pose Estimation

论文链接

https://arxiv.org/abs/1902.09212

论文代码

https://github.com/leoxiaobin/deep-high-resolution-net.pytorch

创新点

1、分辨率从高到低的结构设计(在此领域之前都是从低维特征中进行学习)

2、采用并行的、不同尺度的上下交互的特征融合模块

概要

作者对人体姿势估计问题感兴趣,重点是学习可靠的高分辨率表示

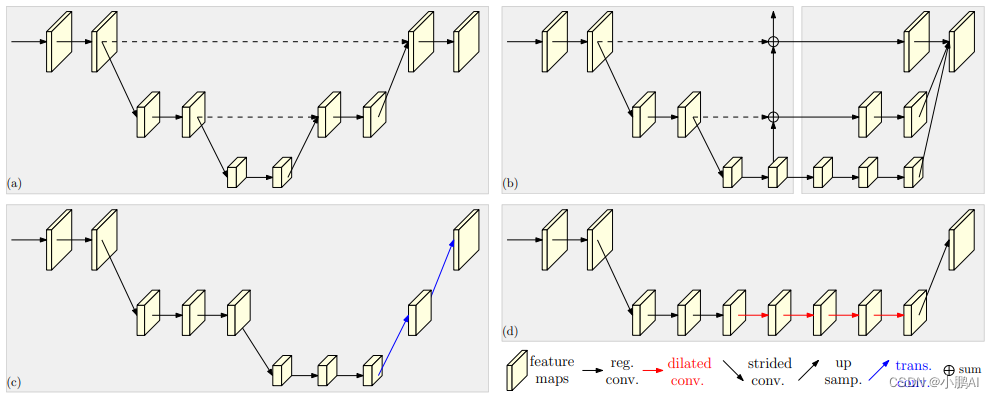

大多数现有方法从高到低分辨率网络产生的低分辨率表示中恢复高分辨率表示

相反,作者建议的网络在整个过程中保持高分辨率表示

我们从高分辨率子网作为第一阶段开始,逐步逐个添加高到低分辨率子网,形成更多的阶段,并并行连接多分辨率子网

进行重复的多尺度融合,以使每个高到低分辨率表示一次又一次地从其他并行表示接收信息,从而产生丰富的高分辨率表示

结果,预测的关键点热图可能更准确,并且在空间上更精确

通过优于两个基准数据集 (COCO keypoint检测数据集和MPII人类姿势数据集) 的姿势估计结果,从经验上证明了本文的网络的有效性

此外,还展示了作者的网络在PoseTrack数据集上的姿势跟踪方面的优势

方法

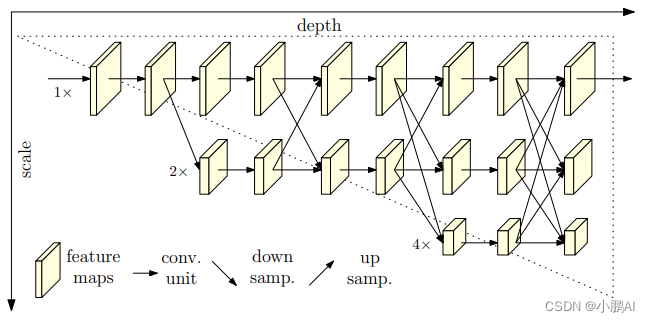

它由并行的高到低分辨率子网组成,具有跨多分辨率子网的重复信息交换 (多尺度融合)

水平和垂直方向分别对应于网络的深度和特征图的比例

网络从一个高分辨率子网开始

逐步添加高到低分辨率子网来形成更多阶段,并且并行连接多个分辨率子网,然后执行多尺度融合

实验

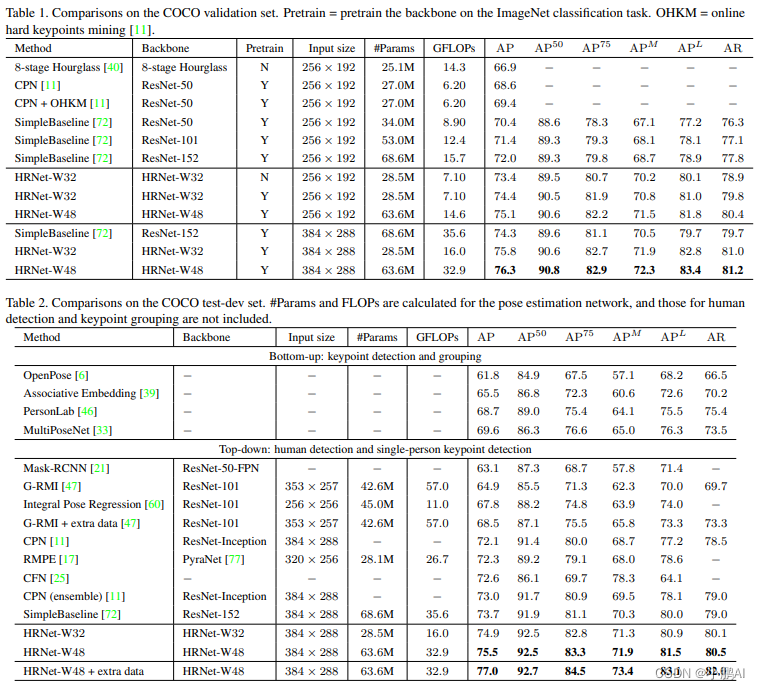

COCO 验证集与测试集的比较

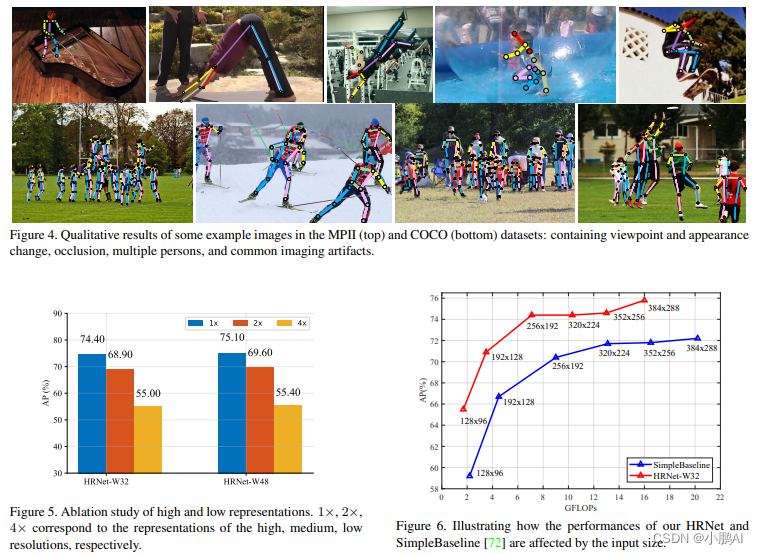

实验目标:MPII (顶部) 和COCO (底部) 数据集中的一些示例图像的定性结果: 包含视点和外观变化,遮挡,多个人和常见的成像伪影。

总结

人体姿态估计,从特征图的多通道中,采取不同的关键节点,然后使用神经网络,进行关键节点的检测

这里尝试使用多通道,类似Dropout、集成学习这种理念

从每个通道检测关键点,然后取平均

对于从高到低的分辨率的问题:

这是一篇 2019 年的文章,回头看,从高到低的分辨率的提取问题,U-Net++ 就做过

而且在语义分割领域中,得到了充分的证明,是没问题的,所以这个可能在当时确实是一种创新吧。